- •Раздел 1.Информация

- •1.1. Основные понятия и подходы

- •1.2. Формы существования информации.

- •1.3. Свойства информации

- •1.4. Показатели качества информации

- •1.5. Количество информации

- •Раздел 2. Системы счисления

- •2.1. Основные понятия

- •2.2. Перевод целых чисел в десятичную систему счисления

- •2.3. Перевод целых чисел в машинные системы счисления

- •2.4. Перевод дробных чисел из десятичной системы счисления в систему счисления с основанием q

- •2.5. Арифметические операции с целыми числами в машинных системах счисления

- •2.6. Представление числовой информации в вычислительной технике

- •Раздел 3. Элементы математической логики

- •3.1. Основные понятия математической логики

- •3.2. Логические операции над высказываниями

- •3.3. Формулы логики высказываний

- •3.4. Законы логики высказываний

- •3.5. Логические основы эвм

- •Раздел 4. Модель и моделирование

- •4.1. Модель

- •4.2. Формализация

- •4.3. Классификация моделей:

- •4.4. Моделирование

- •4.5. Компьютерное моделирование

- •Раздел 5. Основы алгоритмизации

- •5.1. Основные понятия

- •5.2. Линейные алгоритмические процессы

- •5.3. Разветвляющиеся алгоритмические процессы

- •5.4. Циклические алгоритмические процессы

- •Раздел 6. Программное обеспечение

- •Библиографический список

Раздел 1.Информация

1.1. Основные понятия и подходы

Термин ИНФОРМАЦИЯ возник от латинского слова INFORMATIO – РАЗЪЯСНЕНИЕ, ИЗЛОЖЕНИЕ. На сегодняшний день существует большое количество различных определений этого понятия. Связано это со, специфичностью и многообразием подходов к толкованию сущности этого понятия.

С философской точки зрения информация это отражение реального мира с помощью сведений (сообщений). Сообщение – это форма представления информации в виде речи, текста, изображения, цифровых данных, графиков, таблиц и т.п.

С юридической точки зрения – это сведения (сообщения) о лицах, предметах, фактах, явлениях и процессах независимо от формы их представления. (Федеральный закон статья вторая).

В теории информации различают три основных подхода к понятию информация – структурный, статистический и семантический.

Структурный подход рассматривает информацию как свойство материи, т.е. любое сообщение, будь то текст на бумаге или шум моря, несет в себе информацию о природе материи. Носителем информации является сообщение, состоящее из символов.

Согласно этой концепции информация всегда передается в материально-энергетической форме. Она не может существовать вне материи, а значит, она существовала и будет существовать вечно, ее можно накапливать, хранить, перерабатывать. В структурном подходе к информации различают три способа ее измерения: геометрический, комбинаторный и аддитивный.

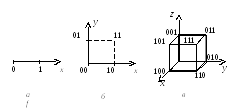

Геометрической мерой информации может являться, длина, площадь, объем (рис. 1.). Сообщение формируется координатами текущего состояния системы.

Рис. 1.

Комбинаторная мера информации использует количество возможных перестановок символов в сообщении. Количество информации равно количеству возможных сочетаний, перестановок и размещений элементов в сообщении.

Аддитивная мера (мера Хартли) – использует для подсчета количества информации двоичные единицы (бит, от англ. bit – binary digit). Этот принцип измерения информации основан на понятие глубины и длинны числа.

Глубина числа

![]() – это количество различных элементов,

которые могут быть использованы для

записи информации (основание системы

счисления).

– это количество различных элементов,

которые могут быть использованы для

записи информации (основание системы

счисления).

Длина числа

![]() – количество символов использованных

для записи числа (разрядность числа).

– количество символов использованных

для записи числа (разрядность числа).

При заданном

![]() и

и![]() можно посчитать, сколько всего чисел

можно записать, используя данный алфавит

и количество символов.

можно посчитать, сколько всего чисел

можно записать, используя данный алфавит

и количество символов.

![]() .

.

Для подсчета количества информации используют двоичный логарифм N.

![]() –формула Хартли.

–формула Хартли.

Согласно этой формуле один бит информации соответствует выбору одного из двух возможных состояний (N=2, т.е. q=2, n=1). В вычислительной технике в качестве таких состояний выступает наличие или отсутствие заряда в транзисторе.

Статистический подход является количественно-информационным и представляет информацию как меру неопределенности (энтропию) события, т.е. информация – это снятая неопределенность.

Данный метод называется статистическим, поскольку рассматривает события как возможные исходы некоторого опыта, причем все возможные исходы составляют полную группу событий. При этом каждый опыт несет в себе неопределенность (энтропию), снятием которой получается информация. Эта теория была предложена американским ученым Клодом Шенноном в 1948 г. Им же была предложена формула для подсчета среднего количества информации, получаемого одним опытом.

![]() –формула

Шеннона,

–формула

Шеннона,

где

![]() – количество возможных исходов опыта,

– количество возможных исходов опыта,

![]() – количество разнотипных исходов

(результаты которые существенно

разнятся),

– количество разнотипных исходов

(результаты которые существенно

разнятся),

![]() – количество повторений однотипных

исходов,

– количество повторений однотипных

исходов,

![]() – вероятность

– вероятность![]() -го

исхода.

-го

исхода.

Можно

получить и другую форму записи этой

формулы, если посчитать, что

![]() :

:

![]()

В случае равенства вероятностей событий формула Шеннона преобразуется в формулу Хартли.

![]()

Данный подход к измерению количества информации получил широкое применение в вычислительной технике. Именно на основе статистического представления информации кодируются все сообщения в ЭВМ.

Семантический1 подход рассматривает информацию как «полезное» знание, которое можно применить в процессе управления, ориентировки и активного действия. «Полезность» знания зависит от его логичности, целесообразности, содержательности и существенности.

Каждый из способов представления информации рассматривает разные ее аспекты и дополняет друг друга. На основе трех представлений можно сделать обобщенное определение информации: "Информация – сведения об объектах и явлениях окружающей среды, их параметрах, свойствах и состоянии, которые уменьшают имеющуюся о них степень неопределенности, неполноты знаний".

Помимо термина «информация» в информатике встречаются и другие понятия обозначающие знания.

Данные – это информация, представленная в форме, пригодной для ее передачи и обработки с помощью компьютера.

Команда – это элементарная инструкция, предписывающая компьютеру выполнить ту или иную операцию.

Сообщение – совокупность данных, представляющая смысл для пользователя как целое. С помощью сообщения передается информация.

Сигнал – (от лат. signum – знак) – результат взаимодействия элементов объективного мира; регистрируется качественным или количественным изменением этих элементов. С помощью сигналов можно передавать данные