- •Оглавление

- •Аналитические технологии

- •Формализация нейронных сетей

- •Принцип обучения искусственных нейронных сетей

- •Концепция обучения нейронной сети, предложенная Хэбом

- •Сбор данных для нейронной сети

- •Прикладные возможности нейронных сетей

- •Переобучение и обобщение

- •Персептрон

- •Алгоритм обратного распространения ошибки

- •Сигмоидальный нейрон

- •Нейрон типа «адалайн»

- •Инстар и оутстар Гроссберга

- •Нейрон типа wta (Winner Takes All)

- •08.10.2011 Модель нейрона Хэбба

- •Стохастическая модель нейрона

- •Стохастические алгоритмы обучения

- •Настройка числа нейронов в скрытых слоях многослойных сетей в процессе обучения

- •Алгоритмы сокращения

- •Конструктивные алгоритмы

- •Упрощенные алгоритмы расщепления

- •Радиальная базисная сеть

- •Вероятностные нейронные сети

- •Линейные нейронные сети

- •Обучение

- •Сети с самоорганизацией на основе конкуренции

- •12.11.2011 Модели ассоциативной памяти. Сети Хопфилда

- •Когнитивные карты

- •19.11.2011 Генетические алгоритмы Естественный отбор и генетическое наследование

- •Модель эволюции в природе, реализованная программно

- •Символьная модель простого генетического алгоритма

- •Работа простого генетического алгоритма

- •26.11.2011 Шима (Schema)

- •Применение аналитических технологий

- •03.12.2011

- •Бизнес-приложения

- •Программные реализации аналитических технологий

- •Список литературы

Стохастическая модель нейрона

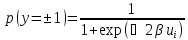

В отличие от детерминированных моделей в стохастической модели выходное состояние нейрона зависит не только от взвешенной суммы входных сигналов, но и от некоторой случайной переменной, значение которой выбирается при каждой реализации из интервала (0, 1).

В

стохастической модели нейрона выходной

сигнал

принимают значения

принимают значения с вероятностью:

с вероятностью:

Алгоритм обучения стохастической модели нейрона состоит из следующих этапов:

Расчет взвешенной суммы

для

каждого нейрона сети:

для

каждого нейрона сети:

Расчет вероятности того, что

принимает значение

принимает значение в

соответствии с формулой;

в

соответствии с формулой;Генерация значения следующей переменной

и формирование выходного сигнала

и формирование выходного сигнала :

:Если

,

то

,

то

Если

,

то

,

то ;

;

Определенный таким образом процесс осуществляется на случайно выбранной группе нейронов вследствие чего их состояние модифицируется в соответствии с предложенными правилами;

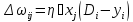

После фиксации состояния нейрона их коэффициенты модифицируются по применяемому правилу уточнения весов;

Например:

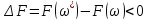

Доказано, что такой способ подбора весов приводит в результате к минимизации целевой функции:

Стохастические алгоритмы обучения

Рисунок 24 Целевая функция

А

– локальный минимум, B

– глобальный минимум.

Причиной использования стохастических алгоритмов обучения нейронных сетей является их способность находить глобальный минимум целевой функции. Суть стохастического подхода в изменении весовых коэффициентов сети случайным образом и сохранении тех изменений, которые ведут к уменьшению заданной целевой функции.

Основным вопросом при построении стохастического алгоритмов является рациональное изменение величины приращений таким образом, чтобы алгоритм мог выбираться из ловушек, образующих локальным минимумом.

В начале обучения нейронных сетей использованием стохастических алгоритмов производится большие случайные коррекции, которые затем постепенно уменьшаются. Для исключения зависания алгоритма в локальных минимумах должны сохраняться не только все изменения синоптической карты, которые ведут к уменьшению целевой функции, но иногда и те, которые ведут к её увеличению. Такое обучения позволяет сети стабилизироваться в точке глобального минимума.

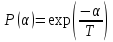

Процесс обучения нейрона будем сравнивать с физическими процессами, происходящими при обжиге металлов. В расплавленно металле атому находятся в беспорядочном движении. При понижении температуры атому стремятся к состоянию энергетического минимума. В процессе обжига энергетическое состояние металла описывается распределением Больцмана.

В соответствии с данной формулой, при высокой температура вероятность всех энергетических состояний одинакова. По мере снижения температуры вероятность высоких энергетических состояний уменьшается по сравнению с нижними.

Введем некоторую искусственную температуру T. Уменьшая её в процессе обучения, будем сохранять состояния сети, связь с уменьшением целевой функции, в соответствии с распределением Больцмана. По мере обучения сети шаги в сторону увеличения целевой функции будем делать всё реже и реже. Одновременно с этим по некоторому правилу будем уменьшать величины случайного шага. В качестве такого приема будем использоваться распределение Гаусса.

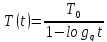

В соответствии с таким законом распределения, при увеличении искусственной температуры вероятность выполнения больших шагов увеличиваются, при уменьшении – уменьшается. К важным факторам влияющим на сходимость алгоритма к глобальному минимуму, отнесём скорость уменьшения температуры. Уменьшая её слишком быстро, мы рискуем не достичь глобальный минимум. Охлаждение сети должно быть пропорционально логарифму времени, т.е. температура должна изменяться по следующему закону:

(*)

(*)

Нейронная сеть, основанная на принципах стохастического обучения, названной машиной Больцмана и функционирующая соответственно следующему алгоритму:

Начальная инициализация синоптической карты сети случайным образом. При этом задать t=1 и задать высокую

;

;Оптимизация входного слоя сети, вычисление её реакции и значения целевой функции;

Вычисление искусственной температуры (*);

Генерирование случайных приращений весов, по закону Гаусса и вычисление скорректированной синоптической карты;

Активизация от входного слоя сети, вычисление его реакции и нового значения целевой функции

;

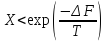

;Если

,

то сохранить изменения синоптической

карты;

,

то сохранить изменения синоптической

карты;Если

,

то генерируем случайные

,

то генерируем случайные ,

если

,

если ,

то сохраняем изменение синоптической

карты, иначе необходимо отменить

изменения;

,

то сохраняем изменение синоптической

карты, иначе необходимо отменить

изменения;

Повторение предыдущих шагов до тех пор, пока значение целевой функции не станет меньше некоторого предела при достаточно низкой исходной температуре;

Для сокращения времени обучения сети введем понятие исключительная теплоёмкость сети. В процессе обжига металлов наблюдается резкие изменения уровня энергии, сопровождающиеся скачкообразным изменением теплоёмкости – свойства, характерного изменения температуры в зависимости от энергии.

В нейросетях происходят аналогичные изменения. При критических температурах небольшое её изменение приводит к резкому изменению целевой функции, т.е. исключительная теплоемкость резко падает. При таких температурах скорость её изменения должна замедляться, чтобы гарантировать не сходимость к глобальному минимуму. В остальном диапазоне Т может быть выбрана высокая скорость изменения температуры, что приводит к сокращению времени обучения.

22.10.2011