Т3 Логика решения задач

.pdfым НЭ посредством соединений, называют функцией активации НЭ. Функциональную зависимость y j N j x j

y j НЭ от вектора x j значений входных сигналов НЭ, связанных с j -ым

НЭ посредством соединений, называют функцией преобразования НЭ. Исходные входные сигналы на рис. 3.5.4 представлены зачерненными входными элементами.

В динамических моделях функционирования НС все величины y j , x jk , w jk , a jk , a j – являются функциями, зависящими от дискретного

или непрерывного фактора времени t. В этом случае функция выхода может также зависеть от значений активации aj и выходного значения y j в

моменты времени t .

В процессе функционирования НС нейроэлементы могут изменять свое состояние синхронно или асинхронно:

-при синхронном функционировании нейроэлементы изменяют свое состояние активации одновременно;

-при асинхронном функционировании нейроэлементы могут изменять свое состояние не одновременно, причем только один нейроэлемент может изменить свое состояние активации в одно время.

410. Функции активации нейроэлементов

1. Правила суммирования активаций

В большинстве случаев предполагается, что величина активации НЭ может быть вычислена как результат простого арифметического суммирования величин активации каждого соединения, то есть преобразование S имеет вид

a j a jk θ j , k

где индекс k пробегает все входные соединения НЭ, θ j – величина так

называемого смещения или порога.

Функция активации с таким правилом суммирования принимает вид

a j x j D x jk ; wjk θ j k

где x j – вектор входных сигналов НЭ, связанных с j-м НЭ посредством взвешенных соединений, а D – дендритная функция активации.

2. Линейная функция активации

В простейшем случае величина активации j-го НЭ вычисляется как взвешенная сумма значений выходных сигналов от других НЭ и значения смещения:

274

a j wji xi θ j , i

где i – индексы НЭ, от которых посредством синаптических связей с весами w ji соответственно, поступают информационные сигналы к j-му

НЭ. Если w ji 0 , то входной сигнал от i-го НЭ является возбуждающим; если w ji 0 – тормозящим. НЭ с линейным правилом распространения

сигналов называются -элементами. Исторически это самое первое и самое распространенное правило.

3. Полилинейная и полиномиальная функции активации

-правило соответствует предположению о том, что каждый i-ый НЭ, от которого в j-ый НЭ поступает информационный сигнал, вносит линейный и независимый вклад в величину активации a j . Это бывает в

случае простых синаптических35 связей. Однако вклад нейроэлементов, участвующих в образовании более сложных связей (пресинаптические соединения, синаптические кластеры, несинаптические соединения в пучках аксонов и дендритов), уже не может быть независимым.

В простейшем случае предполагают, что каждый нейроэлемент при неизменной активности остальных нейроэлементов, участвующих в образовании синаптических связей, вносит независимый линейный вклад в величину активации. Такому предположению соответствует полилинейное правило, известное как правило распространения сигналов для - П - элементов:

П xi θ j i Iik

или

П xi d jki θ j , i Iik

где индекс k пробегает синаптические соединения, индексы i Iik –

различны и пробегают НЭ, участвующие в текущем k-м соединении. Таким образом - П -элементы описываются полилинейными отображениями. Если предположить, что некоторые входы - П -элемента могут повторяться, то он будет описываться уже полиномиальным отображением, а правило распространения будет называться

полиномиальным правилом.

420. Функции выхода

1. Нелокализованные функции выхода

35 Греч. σύναψις - соединение (здесь в биологическом смысле связей нейронов).

275

Первые ИНС, предложенные еще в 40годах Мак-Каллоком и Питсом в 1956 году, и основанные на логических НЭ порогового типа, использовали в качестве функции выхода функцию Хевисайда:

1, |

если x 0, |

θ x |

если x 0. |

0, |

Использование такой функции было связано с попытками представить человеческий мозг в виде компьютера. Главными достоинствами логических НЭ являются высокая скорость вычислений и относительная простора реализации некоторых функций. В ряде случаев

вместо функции θ x используется функция

1, если |

x 1, |

|

|

||

|

0 x |

1, |

|

||

x x, если |

|

||||

|

|

|

|

|

|

0, если x 0. |

|

|

|||

Позднее в качестве функции выхода стали использовать |

|||||

сигмоидальные функции: |

|

|

|

|

|

x; s |

|

1 |

. |

|

|

|

|

|

|||

1 e x/s |

|

|

|||

Константа s пределяет величину наклона сигмоидальной функции в |

|||||

окололинейной области. Функция x; s |

|

принимает значения в |

|||

интервале (0, 1), поэтому в ряде случаев она заменяется функциями |

|||||||||||||

arctg(x; s) и th x; s , принимающими значениями в интервале (-1, 1): |

|||||||||||||

|

th x; s |

1 e x/ s |

. |

|

|||||||||

|

|

|

|

|

|

|

|||||||

|

|

|

1 e x/ s |

||||||||||

Для увеличения скорости вычислений могут быть использованы |

|||||||||||||

другие функции, например: |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

s1 x; s |

|

|

|

|

x |

, |

|

|

||||

|

|

|

|

|

|

|

|

||||||

|

|

|

x |

|

s |

|

|

||||||

|

|

|

|

|

|||||||||

|

|

|

|

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

||||||||

s |

x; s |

1 s2 x2 1 |

. |

||||||||||

|

|||||||||||||

2 |

|

|

|

|

|

|

sx |

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|||

2. Локализованные функции выхода

В ряде случаев в адаптивных системах, играющих роль классификаторов, более предпочтительными на роль выхода оказывались локализованные функции. Наиболее простыми с вычислительной точки зрения являются следующие функции:

g2 |

x; t, s |

|

|

|

1 |

|

|

|

, |

|

|

|

|

|

|

|

|||

|

|

|

x t |

|

2 |

/ s2 |

|||

|

1 |

|

|

|

|||||

|

276 |

|

|

|

|

|

|

||

g4 |

x; t, s |

|

|

|

1 |

|

|

|

. |

|

|

|

|

|

|

|

|||

|

|

|

x t |

|

4 |

/ s2 |

|||

|

1 |

|

|

|

|||||

3. Радиальные функции

Радиальные функции в качестве функций выхода использовались во многих моделях ИНС, например, в теории аппроксимации и в распознавании образов (под именем - потенциальные функции). Существует несколько типов локализованных радиальных функций. Среди них –гауссовы функции вида

h1 x; t, b e

x t

x t

2 /b ,

2 /b ,

а также радиальная координатная, мультиквадратичные и тонколистные сплайнфункции:

h2 x; t

x t

x t

2 ;

2 ;

h3 x; t, b b2

x t

x t

2 a , a 0; h4 x; t, b b2

2 a , a 0; h4 x; t, b b2

x t

x t

2 b , 0 b 1;

2 b , 0 b 1;

h5 x; t, b b

x t

x t

2 ln b

2 ln b

x t

x t

.

.

_____________________

В роли функций выхода F могут использоваться также следующие функции:

1, |

если x 0, |

threshold x |

если x 0; |

0, |

sigmoidal x; w |

1 |

; |

|

||

1 e wx |

1, если x 1, ramp x x, если 0< x <1,

0, если x < 0;1, если x 0,

sign 0, если x 0,

1, если x 0;

th x; w |

1 e wx |

и др. |

|

||

1 e wx |

|

|

430. Топология нейронных сетей

В зависимости от топологии соединений нейроэлементов нейронные сети подразделяются на две основные категории.

277

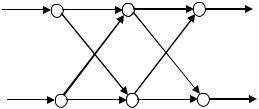

1. Нейронные сети прямого распространения

Структура соединений нейроэлементов в таких НС такова, что в ней нет обратных связей, то есть выходной сигнал нейроэлемента не может в последующем возвратиться ему на вход.

2. Рекуррентные нейронные сети

Для сетей подобного вида выходные сигналы нейроэлемента могут в последующем возвратиться ему на вход, то есть в НС имеются обратные связи (или циклы).

Существуют разнообразные архитектуры нейронных сетей, среди которых можно назвать элементарный персептрон Ф. Розенблатта, нейросети Хопфилда, нейросети Хемминга, порогово-полиномиальные нейросети и др.

440. Метод обратного распространения ошибки

Одним из наиболее эффективных методов обучения НС для управления является метод обратного распространения ошибки. В задачах управления можно использовать как on-line, так и off-line-обучение.

В первом случае при управлении объектом с помощью традиционных регуляторов (или просто с помощью некоторых тестовых сигналов) в определенные моменты времени с датчиков считываются пары «вход-выход» (управление → вектор состояний, его производная) и с помощью алгоритма обратного распространения ошибки производится настройка весов НС. В результате НС обучается представлению обратной зависимости (то есть вектор состояний, его производная → управление). При этом на вход НС подаются вектор состояний ОУ и его производная, и на выходе НС появляется сигнал, соответствующий управлению. Разность между выходом НС и реальным значением управления является ошибкой. Далее производится настройка весов НС в направлении градиента целевой функции, представляющей собой функционал минимума ошибки. При этом часто используют правило модификации весов Уидроу-Хоффа, основанное на методе наименьших квадратов. Этот алгоритм эквивалентен градиентному спуску и сходится к единственному минимуму. Процедура повторяется до достижения требуемой точности.

При off-line-обучении с помощью существующего регулятора или специальных тестов предварительно создается обучающая выборка, и НС обучается на ней.

450. Алгоритм обратного распространения ошибки

Рассмотрим схему алгоритма обратного распространения ошибки для случая многослойной сети (рис.3.5.5)

278

.

xi 1 ..

|

. |

. |

|

|

. |

. |

yk |

|

. |

. |

|

|

|

||

i |

j |

k |

|

Рис. 3.5.5. Фрагмент многослойной НС

Здесь yk - выходы нейронной сети, xi 1 - входы нейронных элементов i -

го слоя; j , k - индексы промежуточного скрытого слоя и выходного слоя нейронных элементов.

Ошибку нейронной сети будем представлять в виде

Eвых2 0,5 ( yok yk )2 , |

(7.1) |

k |

|

где yok - требуемый выходной сигнал сети; yk |

- наблюдаемый выходной |

сигнал. |

|

Будем предполагать, что комбинированный вход в нейронный элемент сети осуществляется на основе обычного суммирования

|

ak wkj x j , |

(7.2) |

|

j |

|

где wkj |

- весовые коэффициенты передачи сигналов из |

j -ых НЭ в k -ые |

НЭ; x j |

- выходные сигналы j -ых НЭ. |

|

Для настройки НС необходимо оценивать производную ошибки сети по вариациям настраиваемых весов. С этой целью вычисление ошибки сети будем осуществлять по формуле сложного дифференцирования

|

E2 |

E2 |

y |

k |

|

a |

||||||

|

|

вых |

|

вых |

|

|

|

|

k |

. |

||

|

|

|

|

|

|

|

|

|

|

|||

|

|

wkj |

yk |

ak wkj |

||||||||

Из (7.1) следует |

|

|

|

|

|

|

|

|

||||

|

|

E2 |

|

|

|

|

|

|

|

|

||

|

|

вых |

( y |

y |

k |

) . |

|

|||||

|

|

|

|

|||||||||

|

|

yk |

ok |

|

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|||

Положим выходные функции НЭ в общем виде

yk fk (ak ) .

Отсюда

yk fk (ak ) .xk

Из (7.2) следует

279

(7.3)

(7.4)

(7.5)

(7.6)

|

|

|

ak |

|

x |

j |

. |

|

|

|

|

(7.7) |

|||

|

|

|

wkj |

|

|

|

|

||||||||

|

|

|

|

|

|

|

|

|

|

||||||

|

|

|

|

|

|

|

|

|

|

|

|

||||

Обозначим |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

E2 |

|

y |

k |

|

|

|||||

k |

|

|

|

|

вых |

|

|

|

|

. |

(7.8) |

||||

|

|

|

|

|

|

|

|

|

|

||||||

|

|

|

|

yk |

|

ak |

|

|

|

||||||

|

|

|

|

|

|

|

|

|

|||||||

Из (7.4), (7.6) следует |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

k fk (ak )( yok yk ) . |

(7.9) |

||||||||||||||

В итоге частная производная по настраиваемым весам будет иметь |

|||||||||||||||

вид |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

E2 |

|

|

|

x |

|

. |

(7.10) |

|||||||

|

|

|

|

вых |

k |

j |

|||||||||

|

|

wkj |

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|||||

Для настройки весов воспользуемся градиентным методом. В этом случае формула коррекции весов будет иметь вид

wkj k x j . |

(7.11) |

Формула коррекции весов (7.11) используется для выходных НЭ сети. Для скрытых элементов сети данная формула не применима, так как для них не определена величина ошибки сети. В методе обратного распространения ошибки для скрытых элементов сети используется

специальная формула для оценки величины |

сети: |

j f j (a j ) k wkj . |

(7.12) |

k |

|

Смысл формулы (7.12) состоит в том, что |

оценка j для j -го НЭ |

принимается взвешенной сумме оценок k для следующего за ним k -го слоя НЭ. При этом вес каждой оценки k принимается пропорциональным весу сигнальной связи wkj . На это основе ошибка выходного слоя, как бы

"отображается" на предшествующий скрытый слой. В этом и состоит суть метода обратного распространения ошибки.

В итоге формула коррекции весов для скрытых слоев будет иметь

вид |

|

w ji j xi . |

(7.11) |

Вцелом процедура коррекции весов носит итерационный характер, распространяясь по слоям от выхода нейронной сети к ее входу.

Взаключение необходимо отметить, что в общем случае постановки задач идентификации реальных объектов на основе использования нейронных сетей могут быть некорректными. Это возникает, например, в случае, если необходимая информация для устойчивого решения задачи отсутствует в обучающей выборке данных. В этих случаях необходимо производить регуляризацию обучающей выборки данных с целью

280

достижения устойчивого корректного решения задачи. С этой целью осуществляется пополнение обучающей выборки дополнительными данными о характеристиках исследуемого объекта из различных источников: ранее проведенных экспериментальных и теоретических исследований, практики эксплуатации, физических законов и иных источников достоверной информации.

___________________________________________

460. Нейронные сети в задачах идентификации и управления

Рассмотрим использование НС для идентификации моделей динамики и представления законов управления.

470. Алгоритмы обучения НС, как уже указывалось, можно разделить на две главные группы: правила обучения без супервизора и правила обучения с супервизором. В задачах идентификации и управления обычно используются только алгоритмы обучения с супервизором. Алгоритмы самообучения, то есть обучения без супервизора, предназначены для кластеризации данных по сходству их признаков.

Задачи идентификации при неполной информации об объекте управления сводятся к оцениванию неизвестных параметров и функций. С другой стороны, задача обучения НС также сводится к оцениванию неизвестных синаптических параметров НС в некотором нейросетевом базисе. Например, обучение распознаванию образов и аппроксимации функций заключается в настройке значений синаптических параметров НС по набору обучающих примеров, называемых обучающей выборкой. Поскольку многослойные НС показывают хорошие результаты в задачах классификации и аппроксимации неизвестных функций, то является естественным их применение для решения прикладных задач оптимального и адаптивного управления. Обзор основных подходов к использованию НС в задачах управления можно найти в литературе36. Ниже приводится краткое описание некоторых из этих подходов.

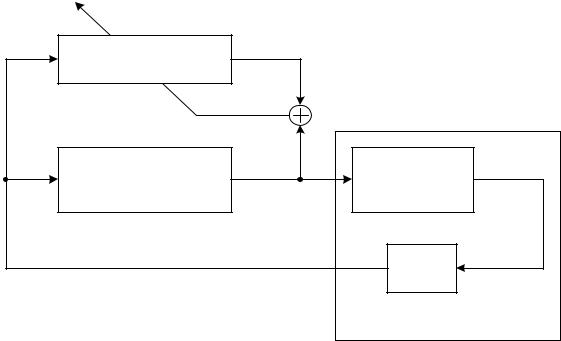

480. Нейросетевое управление с супервизором

При обучении с супервизором (например, копировании существующего регулятора) НС обучается имитировать («копировать») некоторый закон управления. Этот закон управления известен человекуоператору или управляющему устройству и обеспечивает требуемое качество управления. Цель обучения НС в этом случае заключается в

36 Уоссерман, Ф. Нейрокомпьютерная техника / Ф. Уоссерман. – М.: Мир, 1992.

Aleksander, I. An Introduction to Neural Computing / I. Aleksander, H. Morton. – London: Chapman & Hall, 1990.

Hecht-Nielsen, R. Neurocomputing / R. Hecht-Nielsen. – Redwood City, CA: AddisonWesley Pub, Co., 1990.

281

нейросетевой аппроксимации этого «супервизорного» закона управления в соответствии со схемой, изображенной на рис. 3.5.6

Нейроуправление с супервизором может быть использовано в следующих случаях. Во-первых, когда существующее управляющее устройство может оказаться непрактичным или неприменимым в опасных для жизни человека условиях. Во-вторых, НС способна формировать эффективное управление на основании более простого нейросетевого представления о динамике объекта управления по сравнению с существующим устройством управления.

xk |

Нейронная сеть |

Vk vk |

|

|

|

|

|

||

|

|

|

- |

|

|

|

|

+ |

|

xk |

Человек-оператор или |

uk |

xk+1 |

|

управляющее |

||||

|

|

F(xk , uk) |

||

|

устройство |

|

|

|

|

|

|

ζ -1 |

|

|

|

|

Объект управления |

Рис. 3.5.6. Нейроуправление с супервизором

В качестве недостатка описанного нейроуправления с супервизором отмечается, то, что после обучения НС представляет собой лишь «копию» существующего устройства управления и при изменении параметров объекта управления или среды может потребоваться полное переобучение сети.

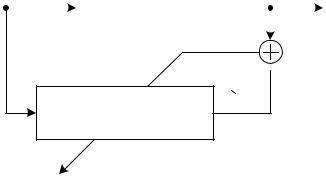

490. Нейросетевая идентификация объекта управления

Информация для обучения НС для идентификации (аппроксимации) модели динамики объекта управления (ОУ) получается путем наблюдения сигналов «вход-выход» (рис. 3.5.7.). Вход НС подвергается тому же самому управляющему воздействию uk что и ОУ, при этом yk ОУ (или

его вектор состояния xk ) является желаемым выходным сигналом для НС.

282

uk |

Ф(uk , yk) |

yk+1 |

||

|

|

+ |

|

|

|

|

|

|

|

|

|

|

|

|

-

-

yk+1

Нейронная сеть

Рис. 3.5.7. Идентификация объектов управления

Для идентификации непрерывных динамических ОУ необходимо подавать на входы НС вектор переменных состояния x и его производную, так как выход ОУ зависит не только от сигнала управления u, но и от состояния ОУ.

В литературе указывается, что для простых (то есть линейных и слабо нелинейных) ОУ классические методы идентификации часто сходятся быстрее и более точно, чем использовавшиеся нейросетевые методы. Однако с помощью НС можно идентифицировать существенно нелинейные ОУ, имея весьма малые знания о классе, структуре и параметрам ОУ. В этом случае классические алгоритмы идентификации могут не давать удовлетворительных результатов.

500. Схемы обучения управлению с использованием обратной модели динамики объекта

Методы идентификации на базе НС могут быть использованы для нейросетевой аппроксимации обратной модели динамики ОУ. Известны два вида подключения НС к ОУ при обучении.

В схеме непрямого (косвенного) обучения (рис. 3.5.8) желаемый выход ОУ dk подается на вход НС, выход uk который подается на ОУ.

При этом выход ОУ yk 1 используется как вход другой копии НС – ее дубликата. Разность uk и выхода второй НС vk используется для корректировки весов связей НС и ее копии.

283