Задание 1. Определить среднее количество информации, содержащееся в сообщении, используемом три символа S1, S2, S3, при известных вероятностях появления символов p(S1)=0.05, p(S2)=0.15, p(S3)=0.8 при независимом появлении символов и при зависимости между соседними символами (таблица 1). Оценить избыточность сообщения в обоих случаях.

Таблица 1

|

P(Si/Sj) |

S1 |

S2 |

S3 |

|

S1 |

0 |

0,4 |

0.6 |

|

S2 |

0.7 |

0.1 |

0.2 |

|

S3 |

0,5 |

0 |

0.5 |

Решение.

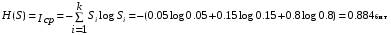

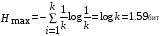

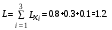

Энтропия и среднее количество информации в сообщении при независимом появлении символов:

Максимальная энтропия( при равных вероятностях появления каждого символа):

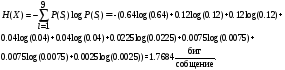

Энтропия и среднее количество информации в сообщении при зависимости между соседними символами:

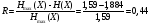

Избыточность из-за неравноверояности появления символов

.

.

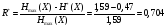

Избыточность с учетом статистических связей

Задание

2.

По линии связи передаются непрерывные

амплитудно-модулированные сигналы

распределенные по нормальному закону

с математическим ожиданием

распределенные по нормальному закону

с математическим ожиданием

и дисперсией

и дисперсией

Определить энтропию

Определить энтропию

сигнала,если погрешность его измерения

равна

сигнала,если погрешность его измерения

равна

Решение.

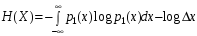

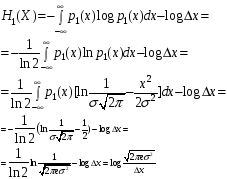

Формула для энтропии H(X) непрерывных сообщений:

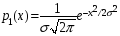

По условию плотность вероятности сигнала x(t)

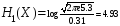

Подставляя числовые значения, получаем:

Задание 3. Непрерывный канал связи с пропускной способностью 60 бит/с предназначен для передачи квантованного сигнала с полосой частот 80 Гц. Определить число различных уровней измеряемого сигнала и погрешность измерений.

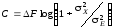

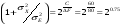

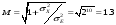

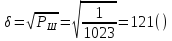

Решение. Пропускная способность канала с непрерывным временем:

Если

,

тогда

,

тогда

Число уровней, которое может быть различимо без ошибок:

Задание 4. Алфавит сообщения состоит из 3 символов, появляющихся независимо друг от друга (вероятности появлении символов взять из третей задачи). Составить код Шеннона – Фэно при кодировании по одной и блоками по две и по три буквы. Сравнить эффективности полученных кодов (вычислить их энтропию и среднюю длину кодового слова).

Решение.

Код Шеннона-Фано для однобуквенных сообщений.

|

Si |

P(S) |

Разбиение сообщений на подгруппы |

Код |

i |

Lxi |

|

|

S3 |

0.8 |

1 |

|

1 |

1 |

0.8 |

|

S2 |

0.15 |

0 |

1 |

01 |

2 |

0.3 |

|

S1 |

0.05 |

0 |

0 |

10 |

2 |

0.1 |

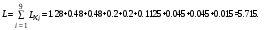

Энтропия однобуквенных сообщений:

Средняя длина кодового слова:

Код Шеннона-Фано для двухбуквенных сообщений.

|

Si |

P(S) |

Разбиение сообщений на подгруппы |

Код |

i |

Lxi |

|||||||

|

S3 S3 |

0.6400 |

1 |

|

|

|

|

1 |

2 |

1.2800 |

|||

|

S3 S2 |

0.1200 |

0 |

1 |

1 |

|

|

011 |

4 |

0.4800 |

|||

|

S2 S3 |

0.1200 |

0 |

1 |

0 |

|

|

010 |

4 |

0.4800 |

|||

|

S3 S1 |

0.0400 |

0 |

0 |

1 |

1 |

|

0011 |

5 |

0.2000 |

|||

|

S1 S3 |

0.0400 |

0 |

0 |

1 |

0 |

|

0010 |

5 |

0.2000 |

|||

|

S2 S2 |

0.0225 |

0 |

0 |

0 |

1 |

|

0001 |

5 |

0.1125 |

|||

|

S2 S1 |

0.0075 |

0 |

0 |

0 |

0 |

1 |

000011 |

6 |

0.0450 |

|||

|

S1 S2 |

0.0075 |

0 |

0 |

0 |

0 |

1 |

000010 |

6 |

0.0450 |

|||

|

S1 S1 |

0.0025 |

0 |

0 |

0 |

0 |

0 |

00000 |

6 |

0.0150 |

|||

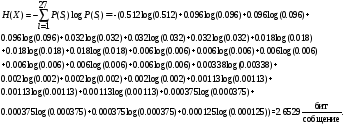

Энтропия двухбуквенных сообщений:

Средняя длина кодового слова:

Код Шеннона-Фано для трехбуквенных сообщений.

|

Si |

P(S) |

Разбиение сообщений на подгруппы |

Код |

i |

Lxi |

||||||||||||

|

S3 S3 S3 |

0.5120 |

1 |

|

|

|

|

|

|

|

|

|

1 |

2 |

1.0240 |

|||

|

S3 S3 S2 |

0.0960 |

0 |

1 |

1 |

1 |

|

|

|

|

|

|

0111 |

5 |

0.4800 |

|||

|

S3 S2 S3 |

0.0960 |

0 |

1 |

1 |

0 |

|

|

|

|

|

|

0110 |

5 |

0.4800 |

|||

|

S2 S3 S3 |

0.0960 |

0 |

1 |

0 |

|

|

|

|

|

|

|

010 |

4 |

0.3840 |

|||

|

S3 S3 S1 |

0.0320 |

0 |

0 |

1 |

1 |

1 |

|

|

|

|

|

00111 |

6 |

0.1920 |

|||

|

S3 S1 S3 |

0.0320 |

0 |

0 |

1 |

1 |

0 |

|

|

|

|

|

00110 |

6 |

0.1920 |

|||

|

S1 S3 S3 |

0.0320 |

0 |

0 |

1 |

0 |

1 |

|

|

|

|

|

00101 |

6 |

0.1920 |

|||

|

S3 S2 S2 |

0.0180 |

0 |

0 |

1 |

0 |

0 |

|

|

|

|

|

00100 |

6 |

0.1080 |

|||

|

S2 S3 S2 |

0.0180 |

0 |

0 |

0 |

1 |

1 |

1 |

|

|

|

|

000111 |

7 |

0.1260 |

|||

|

S2 S2 S3 |

0.0180 |

0 |

0 |

0 |

1 |

1 |

0 |

|

|

|

|

000110 |

7 |

0.1260 |

|||

|

S3 S2 S1 |

0.0060 |

0 |

0 |

0 |

1 |

0 |

1 |

|

|

|

|

000101 |

7 |

0.0420 |

|||

|

S3 S1 S2 |

0.0060 |

0 |

0 |

0 |

1 |

0 |

0 |

|

|

|

|

000100 |

7 |

0.0420 |

|||

|

S2 S3 S1 |

0.0060 |

0 |

0 |

0 |

0 |

1 |

1 |

1 |

|

|

|

0000111 |

8 |

0.0480 |

|||

|

S2 S1 S3 |

0.0060 |

0 |

0 |

0 |

0 |

1 |

1 |

0 |

|

|

|

0000110 |

8 |

0.0480 |

|||

|

S1 S3 S2 |

0.0060 |

0 |

0 |

0 |

0 |

1 |

0 |

1 |

|

|

|

0000101 |

8 |

0.0480 |

|||

|

S1 S2 S3 |

0.0060 |

0 |

0 |

0 |

0 |

1 |

0 |

0 |

|

|

|

0000100 |

8 |

0.0480 |

|||

|

S2 S2 S2 |

0.0034 |

0 |

0 |

0 |

0 |

0 |

1 |

1 |

1 |

|

|

00000111 |

9 |

0.0304 |

|||

|

S3 S1 S1 |

0.0020 |

0 |

0 |

0 |

0 |

0 |

1 |

1 |

0 |

|

|

00000110 |

9 |

0.0180 |

|||

|

S1 S3 S1 |

0.0020 |

0 |

0 |

0 |

0 |

0 |

1 |

0 |

|

|

|

0000010 |

8 |

0.0160 |

|||

|

S1 S1 S3 |

0.0020 |

0 |

0 |

0 |

0 |

0 |

0 |

1 |

1 |

1 |

|

000000111 |

10 |

0.0200 |

|||

|

S2 S2 S1 |

0.0011 |

0 |

0 |

0 |

0 |

0 |

0 |

1 |

1 |

0 |

|

000000110 |

10 |

0.0113 |

|||

|

S2 S1 S2 |

0.0011 |

0 |

0 |

0 |

0 |

0 |

0 |

1 |

0 |

|

|

00000010 |

9 |

0.0102 |

|||

|

S1 S2 S2 |

0.0011 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

1 |

1 |

|

000000011 |

10 |

0.0113 |

|||

|

S2 S1 S1 |

0.0004 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

1 |

0 |

|

000000010 |

10 |

0.0038 |

|||

|

S1 S2 S1 |

0.0004 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

1 |

1 |

0000000011 |

10 |

0.0038 |

|||

|

S1 S1 S2 |

0.0004 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

1 |

0 |

0000000010 |

10 |

0.0038 |

|||

|

S1 S1 S1 |

0.0001 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

0 |

|

000000000 |

10 |

0.0013 |

|||

Энтропия трёх буквенных сообщений:

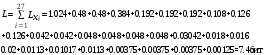

Средняя длина кодового слова:

Кодирование блоками более выгодно, чем кодировать отдельные буквы.

Задание 5. Декодировать полученное сообщение 1110101, если известно, что использовался код Хэмминга (4, 7).