Лабораторная работа 3 / ИНС3

.docСанкт-Петербургский

государственный электротехнический университет

“ЛЭТИ”

______________________________________________________________________

кафедра МОЭВМ

Отчет

по лабораторной работе №3

Проектирование и исследование ИНС для классификации нелинейно разделимых образов

Выполнил: студент гр. 3341 Рыжок М.С.

Проверил: доцент Лисс А.А.

Санкт-Петербург, 2007

Лабораторная работа №3.

Проектирование и исследование ИНС для классификации нелинейно разделимых образов

Часть 1. Многослойный персептрон и Радиальная базисная функция

Цель работы:

Научиться проектировать архитектуры и подбирать параметры обучения для Многослойного персептрона и Радиальной базисной функции для классификации образов, не разделимых линейно.

Задания:

1. Требуется спроектировать различные архитектуры сетей для разделения образов на 4 класса. Для этого:

-

сформировать представительный набор данных для обучения сети. Классифицируемые данные – точки на координатной плоскости, определяющие 4 различных области или класса (см. рисунок).

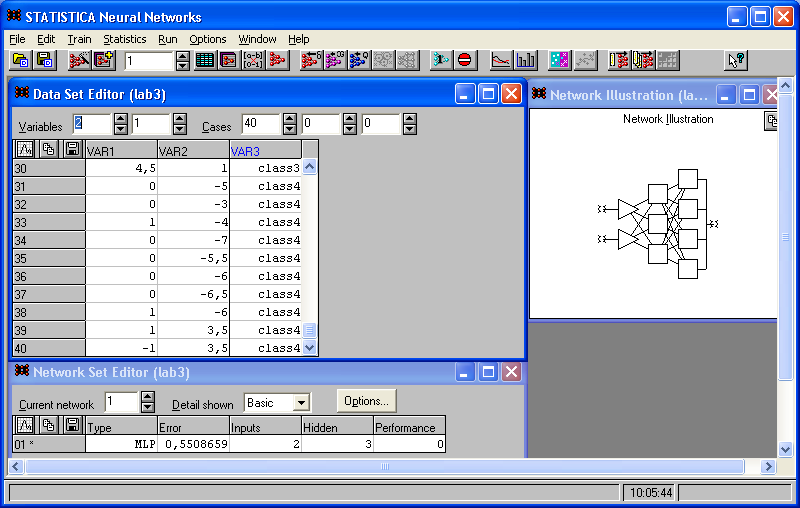

2. Спроектировать и обучить с помощью SNN многослойный персептрон, решающий задачу классификации сформированного набора данных.

Исследовать способность сети к обобщению (к классификации образов, не принадлежащих обучающей выборке).

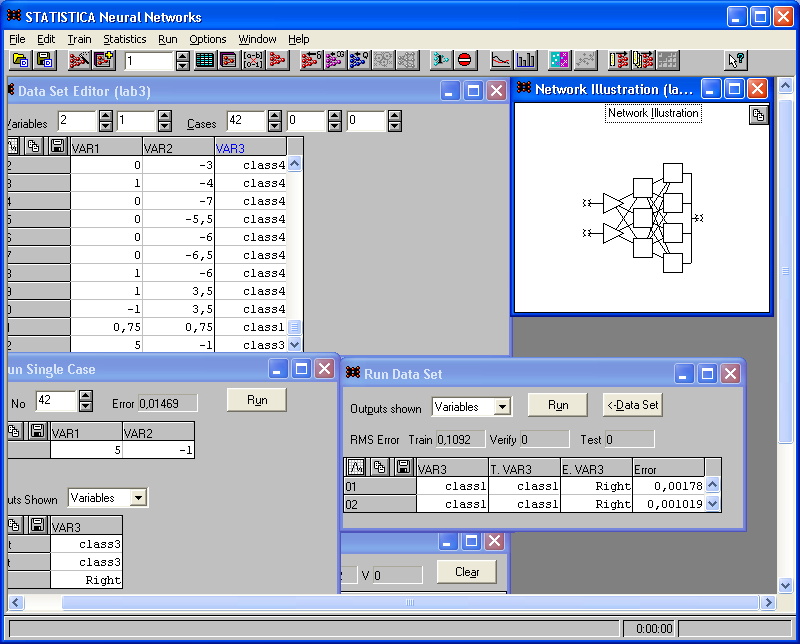

3. Спроектировать и обучить с помощью SNN сеть РБФ, решающую ту же задачу.

Также исследовать способность сети к обобщению.

4. Сравнить качество функционирования и обучения для двух сетей.

Выполнение задания

Обучающая выборка

Обучение сети

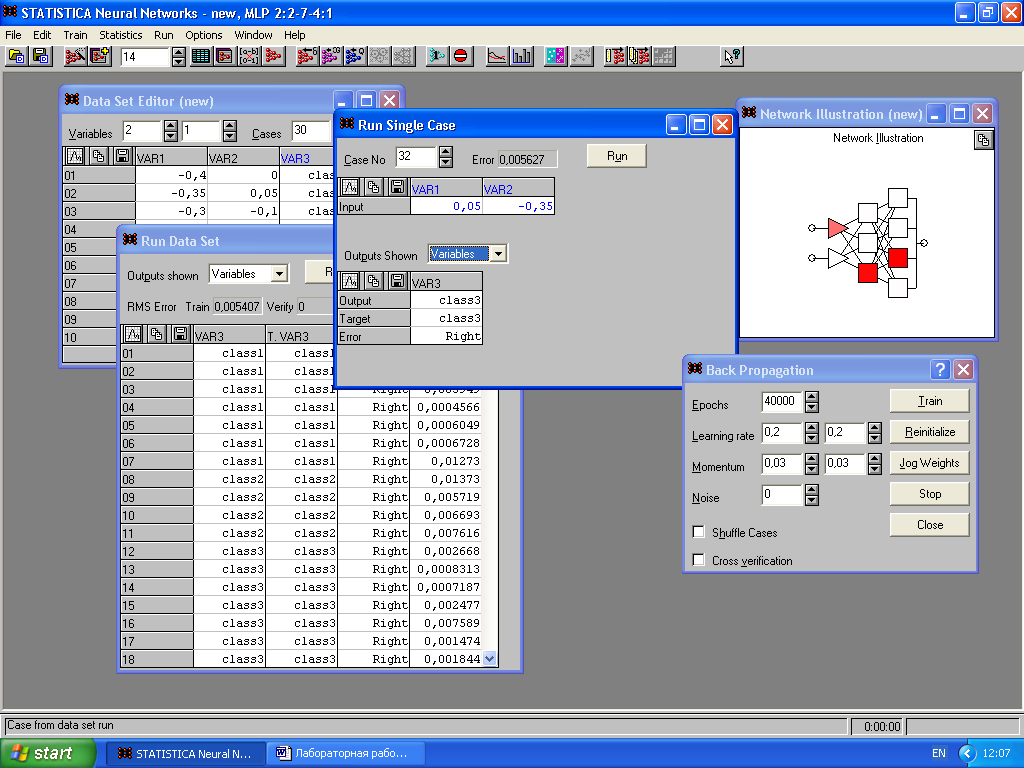

Добавим к данным новые точки, принадлежащие различным классам.

Проверьте реакцию сети на эти данные:

Ввиду проведенного опыта можно заметить, что сеть способна к обобщению (к классификации образов, не принадлежащих обучающей выборке). Она отнесла добавленные координаты в те классы, которым они пренадлежат.

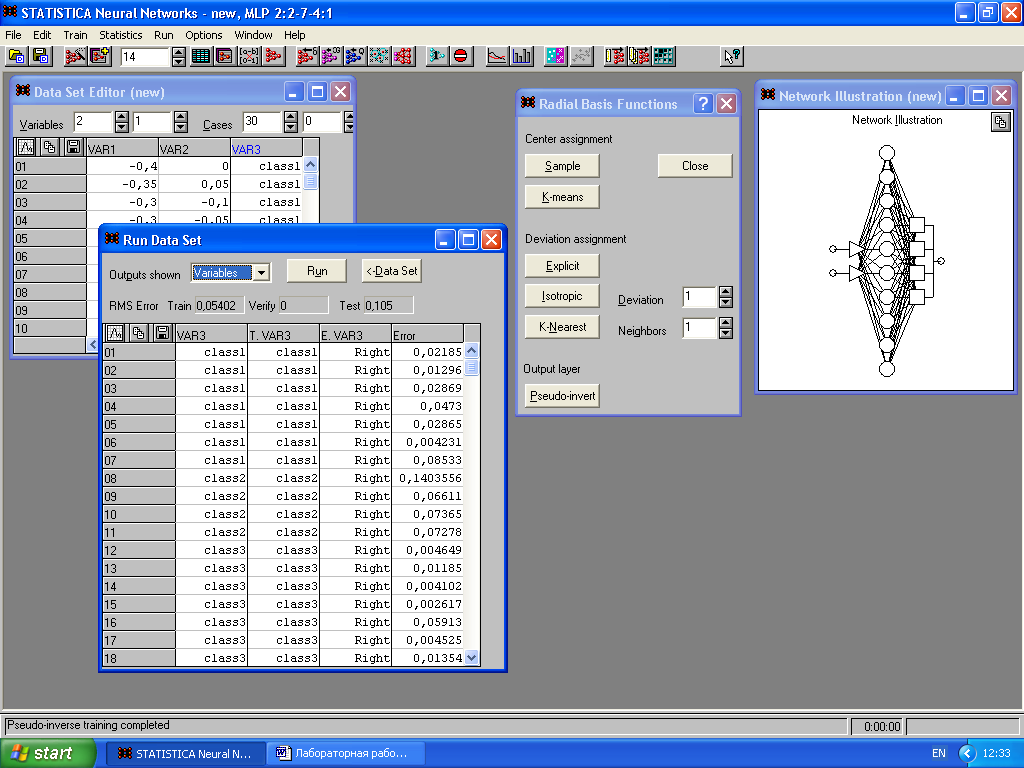

Метод обучения – радиальная базисная функция

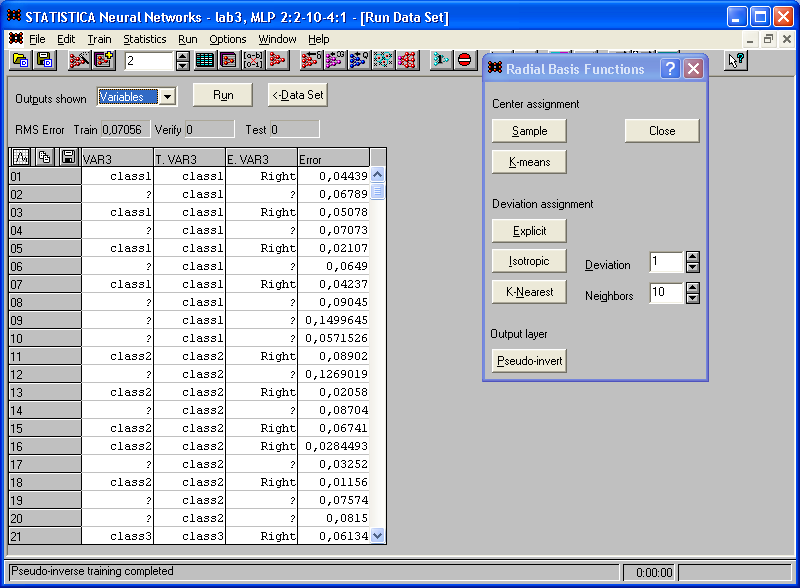

случайная выборка Sample:

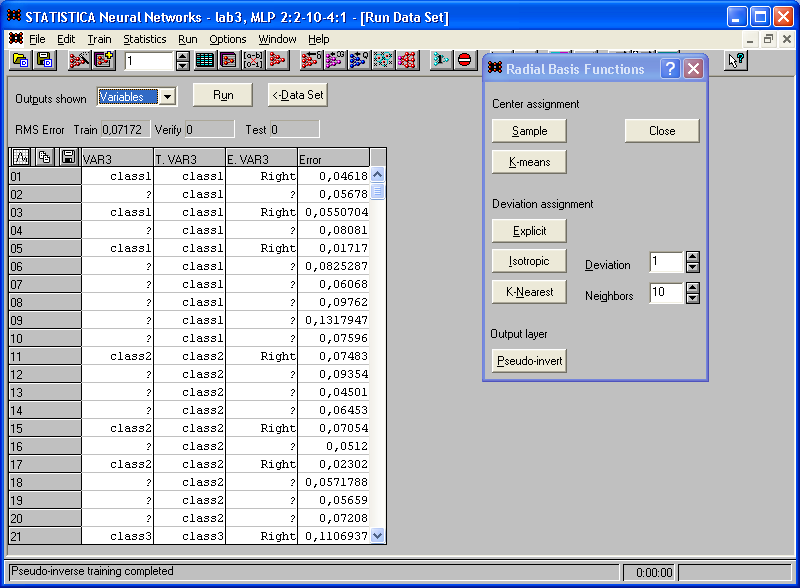

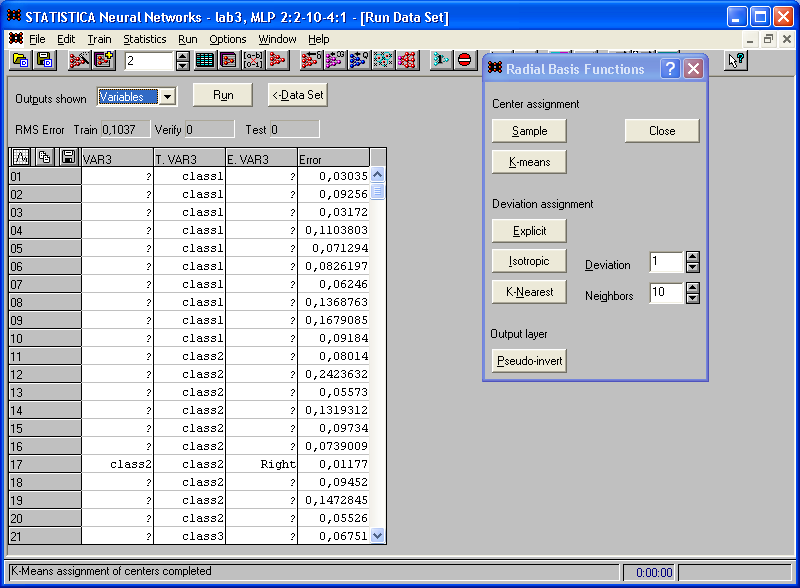

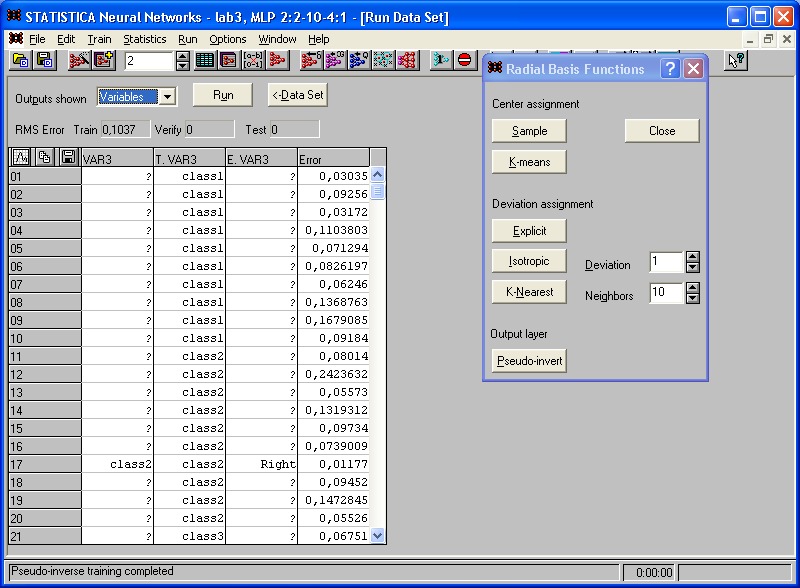

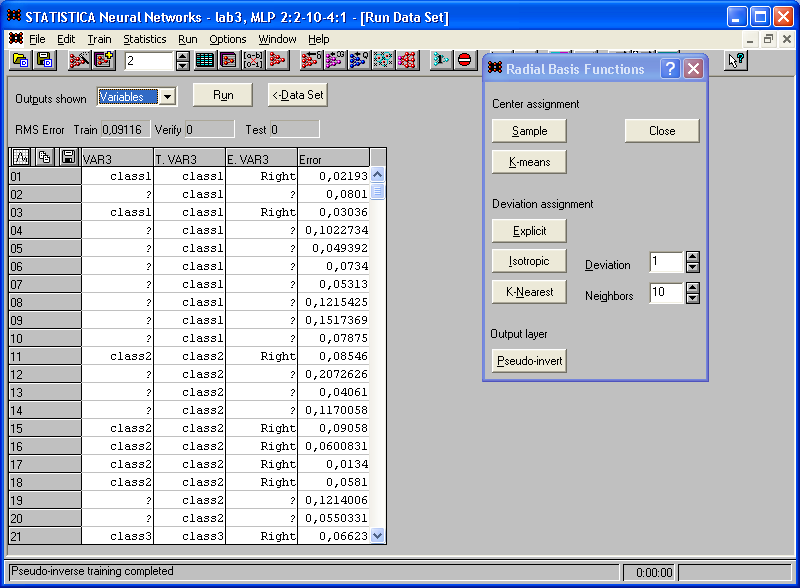

метод К-средних K-means:

отклонение Explicit:

отклонение Isotropic:

отклонение K-Nearest:

Вывод:

Выбор центров:

1) В кач-ве центров скрытых элементов берутся несколько случайно выбранных точек обучающего множества.

Недостаток: если число скрытых элементов невелико, такое представление – неудовлетворительно

2) Осуществляется выбор множества точек, являющихся центрами кластеров обучающих данных.

Выбор отклонений:

2) Отклонения берутся одинаковыми для всех скрытых элементов. При Значение определяется с помощью: d=1/22. Значение d задается в поле Deviation.

3) При выборе изотропного алгоритма отклонения вычисляются по правилу k/d2, где d – расстояние между двумя наиболее удаленными центрами, а k – число центров (т.е. радиальных элементов). Затем это значение умножается на значение в поле Deviation, которое в этом случае лучше выбирать равным 1.

4) Алгоритм задания отклонений по К ближайшим соседям использует для этого среднеквадратичное расстояние от каждого элемента до ближайших к нему элементов. Т.е. отклонение для каждого элемента вычисляется отдельно и зависит от того, насколько густо расположены данные в его окрестности. Вычисленное расстояние умножается на коэффициент в поле deviation. Это сделано для более точной настройки алгоритма. Число соседей задается в поле Neighbors.

Вывод:

1. Научились проектировать архитектуры и подбирать параметры обучения для Многослойного персептрона и Радиальной базисной функции для классификации образов, не разделимых линейно.

2. В процессе обучения весовые коэффициенты сети преобразования данных настраиваются так, чтобы она могла воспроизводить выходные данные, содержащиеся в предъявляемых ей обучающих парах. В результате процесса обучения сеть запоминает все обучающие данные, т.е. правильно реагирует на тесты, совпадающие с ними. Однако кроме способности помнить данные обучающей выборки сеть должна обладать способностью к обобщению.

Обобщение – способность сети корректно осуществлять преобразование вход/выход как для примеров из обучающего множества, так и для, не использованных при обучении. Значит это способность ИНС к нелинейной интерполяции входных данных.

Можно выделить два необходимых условия для существования способности сети к обобщению:

1) гладкость нелинейного преобразования, выполняемого сетью, т.е. небольшим приращением выходных. Это условие не всегда соблюдается, особенно если обучающие данные получены в ходе реальных экспериментов и содержат помехи;

2) набор обучающих данных должен быть достаточно представительным. т.е. с одной стороны,, время его обработки не должно быть слишком большим, а с другой – он должен полностью учитывать все особенности решаемой задачи преобразования данных.

3. Многослойные нейронные сети являются наиболее известными и применяемыми среди сетей прямого распространения. Доказана возможность их использования при решении задач преобразования данных, т.е. задач классификации, обработки изображений, при разработке систем идентификации и управления, в системах обработки сигналов и т.д. Главное достоинство – многослойная нейронная сеть, обученная с помощью этого алгоритма, способна решать задачи классификации линейно неразделимых образов. Однако алгоритм имеет некоторые ограничения, главное из которых – длительный процесс обучения, обусловленный рядом причин. Это и неправильный выбор шага при обучении градиентными методами (скорости обучения), и неудачно спроектированная архитектура сети, и возможность попадения сети в локальный минимум, которая присуща всем градиентным методам.

4. Важнейшей характеристикой сетей преобразования данных, т.е. сетей, которые могут после обучения реализовать заданное соответствие, является способность к обобщению. Для того, чтобы сеть обладала способностью к обобщению, в результате обучения не должно возникнуть ни переобучения, ни недообучения. Большое значение имеет подготовка набора обучающих данных. Их не должно быть слишком много, чтобы избежать переобучения и минимизировать время обучения, но набор данных должен быть представительным, чтобы сеть могла производить интерполяцию.

5. Сеть РБФ, как и семейство персептронов, используется для решения широкого класса задач преобразования данных, в частности, это задачи классификации образов, представленных векторами в многомерном пространстве признаков.

Главное преимущество и отличие РБФ перед персептронами – она может решать задачи классификации образов с нелинейной резделяющей поверхностью.

РБФ обучается и функционирует с гораздо большей скоростью, чем многослойные сети, т.к. РБФ достаточно только одного скрытого слоя и одного выходного элемента, а сети с обратным распространением ошибки требуется многослойная структура скрытых слоёв.