ЭЕМ процессорлары

.docxЭЕМ процессорлары.

Процессор – ЭЕМ құрылғысы, ақпаратты берілген алгоритмге сәйкес түрлендіруге арналған. Кез келген цифрлық құрылғы екі блоктан тұрады: операциондық және басқару.

Біз үлкен ЭЕМ-ді нзмесе дербес компьютерді алсақ та, олар

бір-біріне үқсас принципте жұмыс істейтін мынадай құрамнан

тұрады:

1. орталық процессор;

2. енгізу құрылғысы;

3. есте сақтау құрылғысы;

4. шығару құрылғысы.

Орталық процессор барлық, есептеу және информация

өңдірістерін орындайды. Бір интегралдық схемадан тұратын

процессор микропроцессор деп аталады. Күрделі машиналарда

процессор бір-бірімен өзара байланысты бірнеше интегралдық

схемалар жиынынан тұрады.

Енгізу қүрылғысы информацияны компьютерге енгізу

қызметін атқарады.

Есте сақтау құрылғысы программаларды, мәліметтерді

және жұмыс нәтижелерін компыбтер жадына сақтауға арналғаа

Шығару құрылгысы компьютердің жүмыс нәтижесін

адамдарға жеткізу үшін қолданылады.

Микропроцессор бір кристалда дайындалған (үлкен) интегралдық темелар – БИС, олар әртүрлі типтегі ЭЕМ жасауға керекті элемент болып табылады. Оны әртүрлі логикалық функцияны орындайтын етіп программалауға болады, сондықтан программаны өзгерту арқылы микропроцессорды арифметикалық құрылғы немесе енгізу-шығару жұмыстарын басқарушы ролінде қолдануға болады. Микропроцессерге жедел және тұрақты жад, енгізу-шығару құрылғыларын қосуға болады.

IBM тәрізді компьютерлерде INTEL фирмасының және басқа да фирмалардың бір-біріне үйлесімді микропроцессорлары пайдаланылады.

Микропроцессорлардың бір-бірінен өзгешелігі олардың типтерінде (модельдерінде), яғни оның қарапайым амалдарды орындайтын жұмыс жылдамдығының көрсеткіші – мегагерц - МГц бірлігімен берілген тактылық (қадамдық) жиілігінде жатыр. Бұған дейін кең тараған модельдерге Intel-8088 (~5 МГц), 80286 (~20 МГц), 80386SX (~25 МГц), 80386DX (~40 МГц), 80486 (100 МГц-ке дейін), Pentuim (75 МГц-тен жоғары), Pentuim-Pro (~300 МГц-тен жоғары), PentuimІІ, PentuimІІІ (800 МГц-ке дейін), және PentuimІV (1000 МГц-тен жоғары) жатады, бұл тізім олардың жұмыс өнімділігі мен соған сәйкес боғасының өсуі бойынша реттеліп келтірілген. Кейде конструкциялық ерекшеліктеріне қарай бір модеоьге кіретін прцессорлардың жиіліктері әртүрлі бола береді – жиілігі артқан сайын оның жұмыс жылдамдығы да өсе түседі.

Intel 8088, 80286, 80386 тәрізді бұрын шыққан микропроцессорладың аралас сандар мен амалдарды жылдам орындайтын арнаулы командалары жоқ, сондықтан олар жұмыс өнімділіктерін арттыратын қосымша математикалық сопроцессорлармен (Turbo режимы) жабдықталады.

Компьютерлер алып жүруге ыңғайлы вариантта да жасалады (Laptop немесе Note book). Мұндай ЭЕМ-дерде жүйелік блок, монитор және пернелік бір қорапта жасалған: жүйелік блок пернелік астында, ал монитор пернеліктің қақпағы түрінде жасалған.

Процессор ЭВМ

Процессор – это блок ЭВМ, предназначенный для автоматического считывания команд программы, их расшифровки и выполнения. Будучи центральным устройством ЭВМ, процессор во многом определяет её возможности и производительность.

В компьютерах третьего поколения процессор изготавливался из отдельных деталей и микросхем невысокого уровня интеграции. Прогресс в области микроэлектроники привел к тому, процессор удалось разместить внутри одного кристалла. Таким образом, он стал отдельной самостоятельной микросхемой и получил название – микропроцессор.

Размещение процессора в одной микросхеме создало предпосылки для существенного увеличения скорости работы процессора и повышения его надежности. Уменьшение размеров привело к ухудшению условий теплоотдачи, что потребовало для охлаждения современных процессоров использования металлических радиаторов с большой площадью поверхности и вентиляторов («кулеров»).

Энтропия анықтамасы, энтропияның негізгі қасиеттері

Ақпарат теориясында берілетін не сақталатын хабарлар көзі бар деп ұйғарылады. Бұл хабарлардың шығуы мен қабылдануы кездейсоқ сипатта болғанымен, оның шығу ықтималдығы белгілі деп қарастырылады. Мұндай хабарлардың “анықталмау” дәрежесін сипаттау үшін Ақпарат теориясына энтропия деп аталатын ұғым ендіріледі. Энтропия — қандай да бір тәжірибенің (сынақтың) әр түрлі нәтижемен аяқталатын анықталмағандық өлшемі.

Хабарламаны алу нәтижесінде ақпаратты алудың міндетті шарты қандай хабарлама берілетіндігі анықталмаған болып табылады.Бұл жағдайда хабарламаны беру нәтижесіндегі, ақпарат саны неғұрлым көп болса соғұрлым анықталмағандық та көп болады. Ақпаратты алу механизімін қарастырайық:

БЕРГЕНГЕ ДЕЙІНГІ АНЫҚТАЛМАҒАНДЫҚ

БЕРГЕННЕН КЕЙІНГІ АҚПАРАТ

Сонымен, Шеннон бойынша анықталмағандық–ол энтропия. Н міндеті.

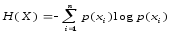

H(xi) = log 1/p(xi). (4)

.

(5)

.

(5)

Энтропия және ақпарат теңдеуі ұқсайды, бірақ мәні әр-түрлі. Энтропия-априорлық сипаттама (бергенге дейін), ақпарат-апостериорлық сипаттама (бергеннен кейін).

Берілгендерді беруді жоғалтусыз қарастырсақ, онда мынаны аламыз

ЭНТРОПИЯ АҚПАРАТ

БЕРГЕНГЕ ДЕЙІН h(x) 0

БЕРГЕННЕН КЕЙІН 0 I(X)=H(X)

Ақпаратты кодттау сапасы энтропиямен анықталады:

h(x)max – кодттаудың ең жақсы әдісі;

h(x)min – кодттаудың ең нашар әдісі.

Ақпарат екі әдәспен кодтталады:

h1(x) = 5 бит/символ;h2(x) = 2 бит/символ.

Кодттаудың бірінші әдәсә жақсы.

Оптималды кодттау әр элементтің ұлғаюына бағытталуы тиіс.

Энтропияның негізгі қасиеттері

Қандай жағдайларда энтропия ең үлкен және ең кіші шаманы қабылдайтынын қарасиырайық.

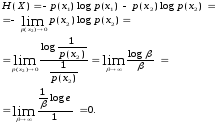

Екілік хабарламаны беру Х пайда болу ықтималдылығы p (x1) және p (x2) екі элементтен тұрады делік x1, x2.

p (x1) =1, p (x2) =0 болған кездегі жағдайды қарастырацһйық.

Мұнда =1/p(x2) белгіленуі енгізілген, ал анықталмағандық Лапиталия ережесімен ашылды. Энтропия минималды және 0 тең, егер, элементтердің біреуі 1 тең ықтималдылығы пайда болатын болса.

p (x1) = p (x2) = 0,5 жағдайды қарастырайық.

Энтропия максималды және 1 тең.

Екілік символ үшін Hmax = 1бит/дв.символ.

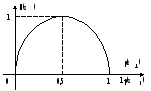

Алынған нәтиже n-элементтерінен шығатын x1, x2,..., xn-1, xn Х хабарламасында талдап қорытындыланылады.

hmin(X) =0 кезіндеp(xi) = 1, p(xj) = 0, i j.

p(x1)= p(x2)= .... =p(xn-1)= p(xn) кезінде.

Ізінше, оптималды кодттау үшін элементтердің пайда болу ықтималдылығын теңестіру қажет.

Ақпаратты өлшеу. Ақпаратты қалай өлшеуге болады? Біз жиі журналдан мақаланы оқып немесе жаңалықтарды көріп өзімізді ешбір ақпарат алмағандай сезінеміз, немесе керісінше, қысқа хабарлама біз үшін маңызды ақпарат көзі болады. Мұнымен бір уақытта басқа біреу үшін дәл осы мақала өте маңызды болып, ал хабарламаның еш пайдасы тимеуі мүмкін. Хабарламалар жаңа, түсінікті, уақтылы және пайдалы болған кезде олар ақпараттық, яғнимаңызды түрге ие болады. Алайда біреу үшін түсінікті нәрсе екіншісіне түсініксіз болады.Ақпаратты анықтау мен өлшеудің проблемасы осында.

Ақпарат түсінігін анықтаудың амалдарының көптігіне қарамастан ақпаратты өлшеу тұрғысынан бізді олардың ішінен екеуі: ақпараттың математикалық теориясына қатысты қолданылатын К. Шеннон анықтамасы(құрамдық амал)жәнекомпьютерді қолданумен байланысты болатын информатика салаларында қолданылатын А. Н. Колмогоров анықтамасы(алфавиттік амал).

Информатикада ақпаратты өлшеудің әр түрлі амалдары қолданылады:

Ақпаратты өлшеудің құрамдық амалы.Хабарлама– ақпаратты жіберу процесінде қабылдауышқа келіп түсетін ақпараттық ағын. Хабарлама адам үшін ақпарат көзіне оның құрамындағы деректер ол үшін жаңа және түсінікті болған жағдайда айналады. Ақпарат–адамның білімі? Хабарлама ақпаратты болуы тиіс. Егер хабарлама ақпаратты болмаса, онда адамның ойынша ақпараттың саны = 0. (Мысалы: жоғары оқу орындарына арналған жоғарғы математика оқылығында білім бар, алайда ол1-сынып оқушысынақол жетімсіз)

Ақпаратты өлшеудің алфавиттік амалыақпарат санын хабарлама құрамымен байланыстырмайды.Алфавиттік амал–ақпаратты өлшеудің объективтік амалы. Ол ақпаратпен жұмыс істеудің техникалық құралдарын қолданған кезде қолайлы, себебі хабарламның құрамына байланысты емес. Ақпарат саны мәтін көлемі мен алфавит қуатына байланысты. max қуатқа шектелген алфавит жоқ, алайда 256 символ қуатты жеткілікті алфавит бар. Бұл алфавит компьютерде мәтіндерді көрсету үшін қолданылады. 256=28 болғандықтан мәтіндегі 1символ ақпараттың 8 битіне тең.

Ақпаратты өлшеудің ықтималдылық амалы. Барлық оқиғалар әр түрлі ықтималдылықпен пайда болады, алайда қандай да бір оқиғаның орын алу барысында алынған оқиғалар ықтималдығы арасындағы тәуелділікті 1948 жылы Шеннон ұсынған формула көмегімен көрсетуге болады.

АҚПАРАТ КӨЛЕМІН АНЫҚТАУ.Хартли және Шеннон формулалары.

Клод Шеннон, американ ғалымы, ақпаратты біздің біліміміздің бірдеңе туралы білместігіміздің түсуі ретінде қарастырады. Американ инженері Р. Хартли 1928 жылы ақпаратты алу процесін N тең ықтималды хабарламалардан тұратын алдын ала берілген шекті көпшеден бір хабарламаны таңдау деп қарастырды, ал таңдалған хабарламадағы ақпарат I көлемін N екілік логарифмі ретінде анықтаған.

Хартли формуласы:

I = log2N

Мысалы, бірден жүзге дейінгі сандар жиынтығынан бір санды табу керек. Хартли формуласы бойынша осы үшін ақпараттың қандай көлемі қажет екенін анықтауға болады: I=log2100>6,644. Яғни, дұрыс табылған сан туралы ақпаратта шамамен 6,644 ақпарат бірлігі бар.

Енді «ғимарат есігінен бірінші болып әйел шығады» және «ғимарат есігінен бірінші болып ер адам шығады» деген хабарламалардың тең ықтималды болуын не болмауын анықтайық. Бірден бұл сұраққа жауап беруге болмайды. Әңгіме қандай ғимарат екендігіне байланысты. Егер бұл метро станциясы болса, онда есіктен не әйел, не ер адам шығуы тең ықтималды, ал егер әскери казарма туралы әңгіме болса, онда ер адамның шығу ықтималдығы жоғары.

Осындай есептерді шығару үшін американ ғалымы Клод Шеннон 1948жылы ақпарат көлемін анықтайтын басқа формула ұсынды.

Шеннон формуласы:

I=-(p1log2p1 + p2log2p2 + ... + pNlog2pN),

мұндағыpi – i-ші хабарлама N хабарламалар жиынтығынан белгіленгендігі ықтималдығын білдіреді.

Егер p1, ..., pN ықтималдықтары тең болса, онда олардың әрқайсысы 1/N тең, және Шеннон формуласы Хартли формуласына ауысады.

АҚПАРАТТЫ ӨЛШЕУ БІРЛІКТЕРІ.

Ақпарат бірлігі ретінде Клод Шеннон бір биталуды ұсынды (ағыл. bit – binary digit – екілік сан).

Ақпарт теориясында бит — екі тең ықтималды хабарламаларды айыру үшін қажетті ақпарат көлемі.

Есептегіш техникада бит деп мәліметтер мен командаларды машинаішілік сипаттауға қолданылатын «0» мен «1» белгілерінің біреуін сақтауға қажетті компьютер жадысының ең кіші порциясын айтады.

Компьютер жеке биттермен жұмыс істемейді, ол сегіз бит жиынтығын алады. Сегіз ретті биттер байтты құрайды. Бір байтта (256 = 28) 256 мүмкін символдың ішінен бір символдың мәнін кодтауға болады. Байт машина жадысында сақталып, бүтін сан түрінде оқылып, өңделеді. Бит пен байтпен қатар ақпарат көлемін өлшеу үшін келесі бірліктер қолданылады:

1 Килобайт (Кбайт, Кб) = 1024 немесе 210 байт;

1 Мегабайт (Мбайт, Мб) = 220 байт, немесе 1024 Кбайт;

1 Гигабайт (Гбайт, Гб) = немесе 230 байт, немесе 1024 Мбайт;

1 Терабайт (Тбайт, Тб) = 240байт немесе 1024 Гбайт.

1 Петабайт (Пбайт, Пб) = 250 байт немесе 1024 Тбайт.

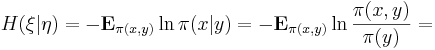

Условная энтропия

Поделиться…

В теории информации, условная энтропия (у|энтропия) определяет количество остающейся энтропии (то есть, остающейся неопределенности) случайной величины ξ после того, как распределение второй случайной величины η становится известным. Она называется «энтропия ξ при условии η», и обозначается H(ξ | η). Как и другие энтропии, у|энтропия измеряется вбитах (двоичные единицы), натах (натуральные единицы), или банах (хартлиевские единицы).

Для

заданных дискретных случайных

величин η на ![]() и ξ на

и ξ на ![]() ,

у|энтропия ξ при

условии η определяется

как:

,

у|энтропия ξ при

условии η определяется

как:

Здесь

обозначено: ![]() .

.

Из этого определения и теоремы Байеса следуют соотношения у|аддитивности энтропии (иногда называемые цепным правилом для у|энтропии):

H(ξ,η) = H(ξ) + H(η | ξ) = H(ξ | η) + H(η),

которые верны, потому что

![]()

Интуитивно, объединенная система содержит H(ξ,η) битов информации. Иначе говоря, требуется H(ξ,η) битов информации, чтобы восстановить точное состояние системы. Когда мы узнаем распределение η, мы извлекаем H(η) битов информации, и в системе остается H(ξ | η) битов информации, нами неопределенной. H(ξ | η) = 0, если и только если значение ξ полностью определяется значением η. Наоборот, H(ξ | η) = H(ξ), если и только если ξ и η - независимые случайные величины.

В квантовой теории информации, у|энтропия обобщена до квантовой у|энтропии.

На этом шаге мы рассмотрим понятие условной энтропии.

Найдем

энтропию сложного опыта ![]()

![]()

![]() в

том случае, если опыты не являются

независимыми, т.е. если на исход

в

том случае, если опыты не являются

независимыми, т.е. если на исход ![]() оказывает

влияние результат опыта

оказывает

влияние результат опыта ![]() .

Например, если в ящике всего два

разноцветных шара и

.

Например, если в ящике всего два

разноцветных шара и ![]() состоит

в извлечении первого, а

состоит

в извлечении первого, а ![]() –

второго из них, то

–

второго из них, то ![]() полностью

снимает неопределенность сложного

опыта

полностью

снимает неопределенность сложного

опыта ![]()

![]()

![]() ,

т.е. оказывается H(

,

т.е. оказывается H(![]()

![]()

![]() )

= H(

)

= H(![]() ),

а не сумме энтропии, как следует из (1.5).

),

а не сумме энтропии, как следует из (1.5).

Связь

между ![]() на

на ![]()

![]() могут

оказывать влияние на исходы из

могут

оказывать влияние на исходы из ![]() ,

т.е. некоторые пары событий Ai

,

т.е. некоторые пары событий Ai![]() Bj не

являются независимыми. Но тогда в (1.6)

p (Ai

Bj не

являются независимыми. Но тогда в (1.6)

p (Ai![]() Bj) следует

заменять не произведением вероятностей,

а, согласно:

Bj) следует

заменять не произведением вероятностей,

а, согласно:

![]()

– вероятность наступления исхода Bj при условии, что в первом опыте имел место исход Ai. Тогда:

![]()

При подстановке в (1.6) получаем:

В первом слагаемом индекс j имеется только у B; изменив порядок суммирования, получим члены вида:

![]()

Однако,

![]()

поскольку

![]()

образует

достоверное событие (какой-либо из

исходов опыта при

условии, что в опыте ![]() реализовался

исход Ai –

будем называть ее условной

энтропией.

Если ввести данное понятие и использовать

его обозначение, то второе слагаемое

будет иметь вид:

реализовался

исход Ai –

будем называть ее условной

энтропией.

Если ввести данное понятие и использовать

его обозначение, то второе слагаемое

будет иметь вид:

![]() (1.9)

(1.9)

где ![]() есть

средняя условная энтропия опыта

есть

средняя условная энтропия опыта ![]() при

условии выполнении опыта

при

условии выполнении опыта ![]() .

Окончательно получаем для энтропии

сложного опыта:

.

Окончательно получаем для энтропии

сложного опыта:

![]() (1.10)

(1.10)

Полученное

выражение представляет собой общее

правило нахождения энтропии сложного

опыта. Совершенно очевидно, что

выражение (1.5) является

частным случаем (1.10) при условии

независимости опытов ![]() и

и ![]() .

.

Относительно условной энтропии можно высказать следующие утверждения:

Условная

энтропия является величиной

неотрицательной. ![]() = 0

только в том случае, если любой

исход

= 0

только в том случае, если любой

исход ![]() полностью

определяет исход

полностью

определяет исход ![]() (как

в примере с двумя шарами), т.е.

(как

в примере с двумя шарами), т.е.

![]()

В

этом случае H ( ![]()

![]()

![]() ) = H

(

) = H

( ![]() ).

).

Если

опыты ![]() и

и ![]() независимы,

то

независимы,

то ![]() ,

причем это оказывается наибольшим

значением условной энтропии. Другими

словами, опыт

,

причем это оказывается наибольшим

значением условной энтропии. Другими

словами, опыт ![]() не

может повысить неопределенность опыта

не

может повысить неопределенность опыта ![]() ;

он может либо не оказать никакого влияния

(если опыты независимы), либо понизить

энтропию

;

он может либо не оказать никакого влияния

(если опыты независимы), либо понизить

энтропию ![]() .

.

Приведенные утверждения можно объединить одним неравенством:

![]() (1.11)

т.е. условная энтропия не превосходит

безусловную.

(1.11)

т.е. условная энтропия не превосходит

безусловную.

Из соотношений (1.10) и (1.11) следует, что

![]() (1.12)

(1.12)

причем

равенство реализуется только в том

случае, если опыты ![]() и

и ![]() независимы.

независимы.

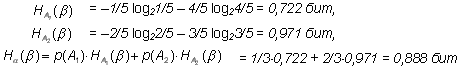

Пример 1. В ящике имеются 2 белых шара и 4 черных. Из ящика извлекают последовательно два шара без возврата. Найти энтропию, связанную с первым и вторым извлечениями, а также энтропию обоих извлечений.

Будем

считать опытом ![]() извлечение

первого шара. Он имеет два исхода: A1 –

вынут белый шар; его вероятностьp(A1)

= 2/6 = 1/3;

исход A2 –

вынут черный шар; его вероятность p(A2)=1

– p(A1)

= 2/3.

Эти данные позволяют с помощью (1.4) сразу

найти H(

извлечение

первого шара. Он имеет два исхода: A1 –

вынут белый шар; его вероятностьp(A1)

= 2/6 = 1/3;

исход A2 –

вынут черный шар; его вероятность p(A2)=1

– p(A1)

= 2/3.

Эти данные позволяют с помощью (1.4) сразу

найти H(![]() ):

):

H(![]() )=

– p(A1)log2 p(A1)

– p(A2)log2 p(A2)

= –1/3 log21/3

– 2/3 log22/3

= 0,918 бит

)=

– p(A1)log2 p(A1)

– p(A2)log2 p(A2)

= –1/3 log21/3

– 2/3 log22/3

= 0,918 бит

Опыт ![]() –

извлечение второго шара также имеет

два исхода: B1 –

вынут белый шар; B2 –

вынут черный шар, однако их вероятности

будут зависеть от того, каким был исход

опыта

–

извлечение второго шара также имеет

два исхода: B1 –

вынут белый шар; B2 –

вынут черный шар, однако их вероятности

будут зависеть от того, каким был исход

опыта ![]() .

В частности:

.

В частности:

![]()

Следовательно, энтропия, связанная со вторым опытом, является условной и, согласно (1.8) и (1.9), равна:

Наконец,

из (1.10): H(![]()

![]()

![]() )

= 0,918 + 0,888 = 1,806 бит.

)

= 0,918 + 0,888 = 1,806 бит.

Пример 2. Имеется три тела с одинаковыми внешними размерами, но с разными массами x1, x2 и x3. Необходимо определить энтропию, связанную с нахождением наиболее тяжелого из них, если сравнивать веса тел можно только попарно.

Последовательность действий достаточно очевидна: сравниваем вес двух любых тел, определяем из них более тяжелое, затем с ним сравниваем вес третьего тела и выбираем наибольший из них. Поскольку внешне тела неразличимы, выбор номеров тел при взвешивании будет случаен, однако общий результат от этого выбора не зависит. Пусть опыт состоит в сравнении веса двух тел, например, 1-го и 2-го. Этот опыт, очевидно, может иметь два исхода:A1 – x1 > x2; его вероятность p(A1) = 1/2; исход A2 – x1 < x2; также его вероятность p(A2)=1/2.

H(![]() )

= –1/2 log21/2

– 1/2 log21/2

= 1 бит

)

= –1/2 log21/2

– 1/2 log21/2

= 1 бит

Опыт ![]() –

сравнение весов тела, выбранного в

опыте

–

сравнение весов тела, выбранного в

опыте ![]() ,

и 3-го – имеет четыре исхода: B1 –

x1>

x3,

B2 –

x1<

x3,

B3 –

x2>

x3,

B4 –

x2<

x3;

вероятности исходов зависят от

реализовавшегося исхода

,

и 3-го – имеет четыре исхода: B1 –

x1>

x3,

B2 –

x1<

x3,

B3 –

x2>

x3,

B4 –

x2<

x3;

вероятности исходов зависят от

реализовавшегося исхода ![]() –

для удобства представим их в виде

таблицы:

–

для удобства представим их в виде

таблицы:

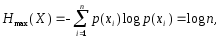

|

B1 |

B2 |

B3 |

B4 |

|

|

1/2 |

1/2 |

0 |

0 |

A1 |

|

0 |

0 |

1/2 |

1/2 |

A2 |

Вновь, воспользовавшись формулами (1.8) и (1.9), находим:

Следовательно, энтропия сложного опыта, т.е. всей процедуры испытаний:

![]()

На следующем шаге мы рассмотрим связь энтропии и информации.

Фигураның ауданы мен периметрін есептеутін виртуал функциялары барFigureабстракт класын құру керек.Өздерінің ауданы мен периметрін есептеутін функциялары бар Rectangle (тіктөртбұрыш) және Circle (шеңбер) туынды кластарын құру керек.

#include <stdio.h> #include <string> #include <cmath> #include <iostream> using namespace std; const double PI = 3.1415926535897932384626433832795;

class Figure { public: virtual double area() = 0; virtual double perimeter() = 0; virtual string to_string() = 0; }; ////////////////////////////// class Rectangle : public Figure { double a; double b; public: Rectangle(double _a, double _b): a(_a), b(_b) {} ~Rectangle() {} double area() { return a*b; } double perimeter() { return a + a + b + b; } string to_string() { char str[128]; sprintf(str, "Figure: Rectangle (a=%.2f, b=%.2f)", a, b); return string(str); } }; ///////////////////////////////////// class Circle : public Figure { double r; public: Circle(double _r): r(_r){} ~Circle() {} double area() { return PI*r*r; } double perimeter() { return 2*r*PI; } string to_string() { char str[128]; sprintf(str, "Figure: Circle (r=%.2f)",r); return string(str); } }; ///////////////////////////////////// int main() { Figure *f; Rectangle *r = new Rectangle(4.0, 2.34); f = r; cout << f->to_string() << endl; cout << "Area: " << f->area() << endl; cout << "Perimeter: " << f->perimeter() << endl <<endl; delete r;

Circle *c = new Circle(6.78); f = c; cout << f->to_string() << endl; cout << "Area: " << f->area() << endl; cout << "Perimeter: " << f->perimeter() << endl << endl; delete c; system("pause"); return 0; }