- •Ответы на зачет по из (Питолин)

- •1. Классы задач, решаемые искусственными нейронными сетями

- •2. Биологический нейрон как прототип искусственного нейрона

- •3. Математическая модель искусственного нейрона

- •4. Функция активации. Сигмоидальная функция активации.

- •5. Основные этапы нейросетевого анализа

- •6. Топологии инс

- •7. Многослойные сети. Классификация многослойных инс

- •8. Классификация инс по различным признакам.

- •9 Математическая постановка нейросетевого анализа данных

- •10 Оценка количества нейронов в скрытых слоях инс. Теорема о полотне.

- •11. Общая схема процесса обучения инс.

- •15. Алгоритм обратного распространения ошибки. Общее описание.

- •16. Математическое описание алгоритма обратного распространения ошибки для однослойной сети.

- •17. Математическое описание алгоритма обратного распространения ошибки для двухслойной сети.

- •18. Особенности функционирования алгоритма обратного распространения ошибки.

- •19. Геометрическая интерпретация алгоритма обратного распространения ошибки.

- •20. Переобучение и обобщение.

- •21. Обучение без учителя. Алгоритм Хебба.

- •22. Обучение без учителя. Алгоритм обучения Кохонена.

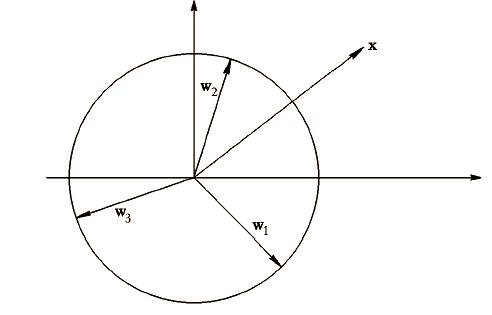

- •23. Геометрическая интерпретация алгоритма обучения Кохонена.

- •24. Персептроны

- •25. Проблема «исключающее или» и пути ее решения

- •26. Инс встречного распространения. Функционирование сети.

- •27. Инс встречного распространения. Обучение сети.

- •28. Инс Хопфилда.

- •29. Инс Хемминга.

- •30. Классификация и сравнительный анализ пакетов прикладных программ нейросетевого моделирования

- •31. Общие принципы построения нейрокомпьютеров

- •32. Элементная база нейровычислений

23. Геометрическая интерпретация алгоритма обучения Кохонена.

При использовании градиентного подхода это приводит к следующей математической формулировке

![]()

где, — константа, определяющая скорость обучения.

Найдем производную в правой части последнего выражения:

![]()

![]()

При этом

![]()

Коррекции весов у других нейронов не производится.

24. Персептроны

Элемент умножает каждый вход xi на вес wi и суммирует взвешенные входы. Если эта сумма больше заданного порогового значения, выход равен единице, в противном случае - нулю. Эти системы (и множество им подобных) получили название персептронов. Они состоят из одного слоя искусственных нейронов, соединенных с помощью весовых коэффициентов с множеством входов.

25. Проблема «исключающее или» и пути ее решения

Например, однослойный персептрон, состоящий из одного нейрона с двумя входами, не может реализовать логическую функцию ИСКЛЮЧАЮЩЕЕ ИЛИ, т.е. не способен разделить плоскость (двумерное гиперпространство) на две полуплоскости так, чтобы осуществить классификацию входных сигналов по классам А и В (табл. 1.2).

. Функция ИСКЛЮЧАЮЩЕЕ ИЛИ

х |

0 |

1 |

у |

|

|

0 |

А |

В |

1 |

В |

А |

Уравнение сети для этого случая

![]()

является уравнением прямой (одномерной гиперплоскости), которая ни при каких условиях не может разделить плоскость так, чтобы точки из множества входных сигналов, принадлежащие разным классам, оказались по разные стороны от прямой (рис. 1.17). Невозможность реализации однослойным персептроном этой функции получила название проблемы ИСКЛЮЧАЮЩЕГО ИЛИ.

Рис. 1.17. Линейная неразделимость функции ИСКЛЮЧАЮЩЕЕ ИЛИ

Отметим, что функции, которые не реализуются однослойным персептроном, называются линейно неразделимыми. Решение задач, подпадающих под это ограничение, заключается в применении двух- и более слойных сетей или сетей с нелинейными синапсами, однако и тогда существует вероятность, что корректное разделение некоторых входных сигналов на классы невозможно.

Обучение персептрона сводится к формированию весов связей между первым и вторым слоями в соответствии со следующим алгоритмом.

Шаг 1. Проинициализировать элементы весовой матрицы (обычно небольшими случайными значениями).

Шаг 2. Подать на входы один из входных векторов, которые сеть должна научиться различать, и вычислить ее выход.

Шаг 3. Если выход правильный, перейти на шаг 4.

Иначе - вычислить разницу между идеальным d и полученным Y значениями выхода:

![]()

Модифицировать веса в соответствии с формулой

![]()

где t и (t +1) - номера соответственно текущей и следующей итераций; - коэффициент скорости обучения, 0 < < 1; i - номер входа; j — номер нейрона в слое.

Если d >Y, то весовые коэффициенты будут увеличены и, тем самым, уменьшат ошибку. В противном случае они будут уменьшены, и Y тоже уменьшится, приближаясь к d.

Шаг 4. Цикл с шага 2, пока сеть не перестанет ошибаться.

На втором шаге на разных итерациях поочередно в случайном порядке предъявляются все возможные входные векторы.

Сходимость рассмотренной процедуры устанавливается теоремами, утверждающими, что для любой классификации обучающей последовательности можно подобрать такой набор (из бесконечного набора) элементарных нейронов, в котором будет осуществлено разделение обучающей последовательности при помощи линейного решающего правила, и что, если относительно задуманной классификации можно найти набор элементов, в котором существует решение, то в рамках этого набора оно будет достигнуто в конечный промежуток времени.