- •1. Определение информации. Семиотика и ее составные части. Фазы обращения информации.

- •2. Структура системы связи. Основные задачи каждого блока системы связи.

- •3. Измерение информации. Дискретный источник информации. Мера информации по Хартли и ее свойство

- •4. Измерение информации по Шеннону.

- •5. Свойства информации по Шеннону.

- •6. Энтропия нескольких источников информации.

- •7. Энтропия непрерывного источника. Относительная энтропия.

- •8. Избыточность источника сообщений.

- •9. Взаимосвязь между энтропией и числом сообщений.

- •10. Пропускная способность двоичного канала.

- •11. Согласование характеристик сигнала и канала.

- •Амплитудная модуляция

- •12. Пропускная способность непрерывного канала с помехами.

- •13. Классификация методов преобразования непрерывной информации в дискретную форму.

- •14. Теорема дискретизации Котельникова в.А. И ее особенности.

- •Свойства ряда Котельникова:

- •15. Корреляционный критерий дискретизации.

- •16. Адаптивные методы дискретизации.

- •Нулевая степень воспроизводящей функции

- •Первая степень приближающего многочлена

- •17. Квантование по уровню. Шум квантования.

- •О терминах

- •Основные принципы построения цап с резистивными цепочками Первый вариант

- •19. Ацп поразрядного взвешивания. Ацп поразрядного уравновешивания на конденсаторах

- •Первый шаг

- •Быстродействие

- •20. Устройство выборки - хранения. Принцип действия и схемы увх

- •21. Распределение мощности в спектре периодического сигнала.

- •22. Спектр периодической последовательности прямоугольных импульсов. Пример.

- •23. Спектр одиночного прямоугольного импульса. Пример.

- •24.Теорема Парсеваля о распределении энергии в спектре непериодического сигнала.

- •25. Взаимосвязь между длительностью импульса и шириной его спектра.

- •26. Спектральная плотность мощности случайного процесса.

- •27. Цели кодирования. Эффективное кодирование. Методы эффективного

- •Цели изучения темы «Эффективное кодирование».

- •Задачи эффективного кодирования.

- •28. Техническая реализация кодирующего и декодирующего устройств эффективного кода.

- •29. Теорема Шеннона о пропускной способности канала без помех и

- •30. Теорема Шеннона о пропускной способности канала при наличии помех. Классификация помехоустойчивых кодов.

- •31. Общие принципы использования избыточности в блоковых кодах.

- •32. Групповой код. Математическое введение. Определение количества

- •33. Таблицы опознавателей и проверочные уравнения для различных кодов (7;4); (7;3); (8;2); (9;3).

- •34. Техническая реализация группового кода и его матричная запись.

- •35. Циклический код. Математическое введение. Выбор образующего многочлена по требуемой корректирующей способности кода.

- •36.Методы построения циклического кода.

- •6.4.1. Методом умножения

- •6.4.2. Методом деления

- •6.4.3. По методу группового кода

- •37. Техническая реализация кодирующих устройств циклического кода по методу умножения (примеры).

- •38. Техническая реализация кодирующих устройств циклического кода по методу деления (примеры).

- •39. Техническая реализация кодирующих устройств циклического кода по методу группового кода (примеры).

- •40. Техническая реализация декодирующих устройств циклического кода, исправляющих одиночную ошибку. Пример.

- •41. Техническая реализация декодирующих устройств циклического кода, исправляющего 2-ые смежные ошибки. Пример.

- •42. Рекуррентный код. Кодирующее и декодирующее устройства. Пример.

- •43.Итеративные коды. Код с повторениями.

- •Модифицированный код с повторением

5. Свойства информации по Шеннону.

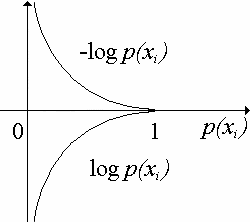

1. Энтропия дискретного источника всегда положительна. Это определяется способом ее подсчета.

,

,

где 0 ≤ p(xi) ≤ 1 – положительное число;

0 ≤ [–log p(xi)] ≤ ∞ – положительное число;

0 ≤ –p(xi)log p(xi) ≤ 0.531 – положительное число;

H(x) – сумма положительных чисел.

Рис. 2.2

Энтропия равна нулю только в том случае, когда вероятность появления одной из букв источника равна 1, а всех остальных – нулю.

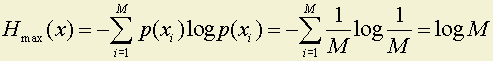

2. Можно доказать, что максимум энтропии достигается при равных вероятностях появления букв алфавита, то есть

.

.

Покажем это на примере источника из двух букв.

Таблица 2.5

|

Буквы |

x1 |

x2 |

|

Вероятности их появления |

p |

q = 1 – p |

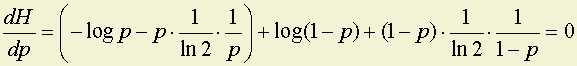

H(x) = –plog p – qlog q = –plog p – (1 – p)log(1 – p),

где H(x), будет максимально, когда H '(x), то есть

,

,

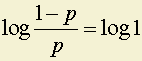

откуда следует,

что –log p

+ log(1 – p)

= 0;

иp

= 0.5 = q.

иp

= 0.5 = q.

Максимум H(x) равен в данном случае 1 или Hmax(x) = log M.

3. Если в системе событие xk состоит из двух событий x'k и x"k с вероятностями q1 и q2 (q1 + q2 = pk), то общая энтропия системы будет равна сумме энтропий исходной системы и энтропии разветвленной части с весом pk и условными вероятностями ветвления q1 ⁄pk и q2 ⁄pk , то есть H{x1; x2; ... xk-1; x'k; x"k} = H{x1; x2; ... xk-1; xk} + pkH(x'k; x"k).

Покажем это на примере.

Пусть имеется система с двумя состояниями.

Таблица 2.6

|

xi |

x1 |

x2 |

|

p(xi) |

0.5 |

0.5 |

H(x1; x2) = (–0.5log 0.5) · 2 = 1 бит.

Пусть состояние x2 разбилось на два.

Таблица 2.7

|

xi |

x'2 |

x"2 |

|

p(xi) |

0.4 |

0.1 |

бита.

бита.

Энтропию новой системы можно подсчитать двумя способами:

1.

Таблица 2.8

|

xi |

x1 |

x'2 |

x"2 |

|

p(xi) |

0.5 |

0.4 |

0.1 |

Hсист = –0.5log 0.5 – 0.4log 0.4 – 0.1log 0.1 = 0.5 + 0.529 + 0.332 = 1.361 бита.

2. Hсист = H(x1; x2) + p(x2) · H(x'1; x"2) = 1 + 0.5 · 0.722 = 1.361 бита.

Как видим, ответ получился один и тот же, но при втором способе расчета не нужно пересчитывать всю систему, а только к старой энтропии добавить энтропию разветвления.

Рассмотрим примеры на расчет энтропии по Шеннону и сравним ее с информацией по Хартли.

Пример 1

Какое количество информации (по Шеннону) получено, если стало известно точно на какое поле шахматной доски, какого цвета и какая фигура поставлена?

Черный король на поле h7.

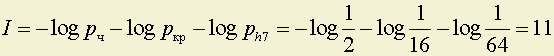

Воспользуемся формулой: I = –log pчкрh7, где

pчкph7 – вероятность оказаться черному королю на поле h7. Эта вероятность получается от одновременного наступления трех событий: выбрали черные фигуры ( pч=1⁄2 ), короля ( pкр=1⁄16 ) и поле h7 ( ph7=1⁄64 ).

Так как события независимые, то pчкрh7 = pч · pкр · ph7 и, следовательно,

бит.

бит.

Аналогично рассуждая можно подсчитать количество информации для любой фигуры, учитывая, что вероятность выбора пешки – 1\2; слона, ладьи и коня –1\8; а ферзя и короля –1\16.

Подсчитайте самостоятельно количество информации для разных фигур и среднее количество информации на одну фигуру.

Ответ должен получиться – 2,125[бит].