Содержательный подход к измерению информации

Другое название содержательного подхода – вероятностный. Вероятность - степень возможности появления какого-либо определенного события в тех или иных условиях. Два события называются равновероятными (или равновозможными), если нет никаких объективных причин считать, что одно из них может наступить чаще, чем другое.

Американский инженер Р. Хартли в 1928 г. процесс получения информации рассматривал как выбор одного сообщения из конечного наперёд заданного множества из N равновероятных сообщений, а количество информации I, содержащееся в выбранном сообщении, определял как двоичный логарифм N.

Рассмотрим в качестве примера опыт, связанный с бросанием правильной игральной кости, имеющей N граней. Результаты данного опыта могут быть следующие: выпадение грани с одним из следующих знаков: 1, 2, . . . N.

Введем в рассмотрение численную величину, измеряющую неопределенность — энтропию (обозначим ее H). Согласно развитой теории, в случае равновероятного выпадания каждой из граней величины N и H связаны между собой формулой Хартли H = log2N.

Важным при введении какой-либо величины является вопрос о том, что принимать за единицу ее измерения. Очевидно, H будет равно единице при N = 2. Иначе говоря, в качестве единицы принимается количество информации, связанное с проведением опыта, состоящего в получении одного из двух равновероятных исходов (примером такого опыта может служить бросание монеты при котором возможны два исхода: «орел», «решка»). Такая единица количества информации и является «битом».

Приведем примеры равновероятных сообщений: при бросании монеты: "выпала решка", "выпал орел"; на странице книги: "количество букв чётное", "количество букв нечётное".

Определим теперь, являются ли равновероятными сообщения "первой выйдет из дверей здания женщина" и "первым выйдет из дверей здания мужчина". Однозначно ответить на этот вопрос нельзя. Все зависит от того, о каком именно здании идет речь. Если это, например, станция метро, то вероятность выйти из дверей первым одинакова для мужчины и женщины, а если это военная казарма, то для мужчины эта вероятность значительно выше, чем для женщины.

Для задач такого рода американский учёный Клод Шеннон предложил в 1948 г. другую формулу определения количества информации, учитывающую возможную неодинаковую вероятность сообщений в наборе.

Формула Шеннона:

I= — (p1log2p1+p2log2p2+ . . . + pNlog2pN),

где pi — вероятность того, что именно i-е сообщение выделено в наборе из N сообщений.

Вероятность события А определяется формулой:

P(A) = m/n,

где m - число элементарных исходов, благоприятствующих А;

n - число всех возможных элементарных исходов испытания.

Легко заметить, что если вероятности p1, ..., pNравны, то каждая из них равна 1 / N, и формула Шеннона превращается в формулу Хартли.

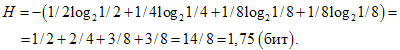

Рассмотрим следующий пример. Пусть при бросании несимметричной четырехгранной пирамидки вероятности выпадения граней будут следующими: p1=1/2, p2=1/4, p3=1/8, p4=1/8, тогда количество информации, получаемое после броска, можно рассчитать по формуле:

Для симметричной четырехгранной пирамидки количество информации будет: H=log24=2(бит).

Заметим, что для симметричной пирамидки количество информации оказалось больше, чем для несимметричной пирамидки. Максимальное значение количества информации достигается для равновероятных событий.

Примеры

Вероятностный подход

1. Какое количество информации несет в себе сообщение о том, что нужная вам программа находится на одной из восьми дискет?

Дано:

N=8 – количество дискет (число событий)

Решение:

N= 2I

8 = 2I

Ответ:3 бита

2. Какое количество информации получит второй игрок при игре в крестики-нолики на поле 8х8 после первого хода первого игрока, играющего крестиками?

Дано:

N=64 – количество полей

Решение:

N= 2I

64 = 2I

Ответ:6 бит

3. Сообщение о том, что ваш друг живет на десятом этаже несет в себе 4 бита информации. Сколько этажей в доме?

Дано:

i=4 бита

Решение:

N= 2I

N= 24

Ответ: 16

4. В коробке 5 синих и 15 красных шариков. Какое количество информации несет сообщение, что из коробки достали синий шарик?

Дано:

N1=5,N2=15

Решение:

N=N1+N2

N=15+5=20 всего шариков

K=5 – синих (его достали)

N/K=20/5=4

2i=4

i=2 бита

Ответ:2 бита.

5. Какое количество информации о цвете вынутого шарика будет получено, если в непрозрачном пакете хранятся: 10 белых, 20 красных, 30 синих и 40 зеленых шариков?

Дано:

K=10+20+30+40=100 – общее количество шариков

N1=10;N2=20;N3=30;N4=40;

Решение:

Pбел. = 10/100 = 0,1

Pкрасн. = 20/100 = 0,2

Pсин. = 30/100 = 0,3

Pзел.= 40/100 = 0,4

I = — ( p1log2 p1 + p2 log2 p2 + . . . + pN log2 pN);

I = – (0,1∙log20,1 + 0,2∙log20,2 + 0,3∙log20,3 + 0,4∙log20,4) ≈ 1,85 бита

Ответ:1,85 бита

6. Студенты группы изучают один из трех языков: английский, немецкий или французский. Причем 12 студентов не учат английский. Сообщение, что случайно выбранный студент Петров изучает английский, несет log23 бит информации, а что Иванов изучает французский – 1 бит. Сколько студентов изучают немецкий язык?

Дано:

Y– учат французский

X– учат английский, 12 не учат английский. Всего 12+Xстудентов

N=12+X

K1=X

i1=log23 бит

i2=1 бит

Решение:

(12+X)/X=2log23

12+X=3X

X=6

N=12+6=18

K2=Y

18/Y=21

Y=9

18-X-Y=18-6-9=3 студента изучают немецкий.

Ответ: 3