Понятие энтропии. Основные свойства.

![]() Та

неопределённость, которая имеет место

на приёмном конце до того, как какое

либо сообщение получено. Среднее

количество информации, необходимое

для однозначного определения любого

сообщения заданного множества.

Та

неопределённость, которая имеет место

на приёмном конце до того, как какое

либо сообщение получено. Среднее

количество информации, необходимое

для однозначного определения любого

сообщения заданного множества.

10 свойств:

-

Энтропия – неотрицательная непрерывная величина. H(X)

0,

0

0,

0 1

1

Бесконечно малое приращение аргумента даёт непрерывность.

-

Симметрична относительно своих аргументов

, n=|X|

, n=|X| -

H(X)=0, если Pk=1, Pj=0, k

j,

j=

j,

j=  .

Следует из того, что

.

Следует из того, что  =0.

=0. -

Энтропия достигает максимального значения, когда на множестве X имеют место равновероятные распределения P1=P2=…=Pn=

.

.

![]() ,

,

![]()

Метод неопределённых множителей Лагранжа (поиск условного экстремума заменяем поиском безусловного с помощью расширения пространства аргумента за счет введения множителя)

![]()

![]()

![]()

![]() а.

Все вероятности равны.

а.

Все вероятности равны.

![]()

![]() ,

,

![]()

Если множество X рассматривать как алфавит кодировки, то:

-

Среднее число информации на 1 символ максимально, когда все символы используются равновозможно.

-

- информационная пропускная способность

алфавита – максимальное количество

информации которое приходится на 1

символ

- информационная пропускная способность

алфавита – максимальное количество

информации которое приходится на 1

символ

|X|=33 – кириллица, ![]()

|X|=2, ![]()

Коэффициент избыточности

![]()

Если все символы равновероятны, то ![]()

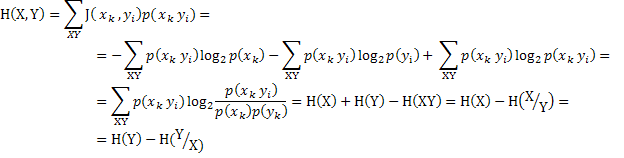

Взаимная энтропия H(X,Y)

- среднее количество информации, которое

необходимо для определения событий

![]() ,

взятых со своими вероятностями

,

взятых со своими вероятностями

Условная энтропия

![]()

![]()

-

«=» когда статистически независимы.

«=» когда статистически независимы.

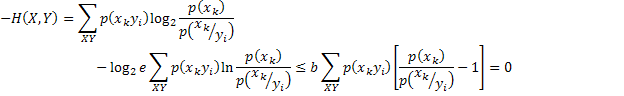

Доказательство

![]()

Статистическая независимости символов алфавита кодировки не превышает среднего количества информации, приходящейся на 1 символ алфавитной кодировки.

-

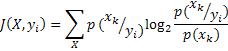

Условное среднее значение взаимной информации

-

Среднее количество информации о

Среднее количество информации о  ,

полученное по каналу, неотрицательно.

,

полученное по каналу, неотрицательно. -

Средняя информация, содержащаяся

символе

Средняя информация, содержащаяся

символе  относительно переданных, неотрицательна.

относительно переданных, неотрицательна. -

Взаимная энтропия неотрицательна, док – свойство 6.

Взаимная энтропия – это мера количества информации, которая передана через системы или канал без ошибок.

Условная ![]() - информация, потерянная при помехах

(ненадёжность передачи)

- информация, потерянная при помехах

(ненадёжность передачи)

система

![]()

![]()

Энтропия источника – та информация, которая поступает на вход

![]() (1)

(1)

![]() (2)

(2)