- •Методические указания

- •Вероятностные модели в задачах теории информации

- •1.1. Случайные события. Вероятность

- •1.2. Дискретная и непрерывная случайные величины

- •1.3. Задачи

- •1.4. Контрольные вопросы

- •2. Информационная мера шеннона.

- •2.1. Количество информации и избыточность.

- •2.2. Энтропия непрерывных сообщений

- •2.3. Задачи

- •2.4. Контрольные вопросы

- •3. Условная энтропия и взаимная информация

- •3.1. Дисктретные системы передачи информации.

- •3.2. Непрерывные системы передачи информации.

- •3.3. Задачи

- •3.4. Контрольные вопросы

- •Список использованных источников

- •Значение функции

- •654600 «Информатика и вычислительная техника» и направления подготовки бакалавров 552800 «Информатика и вычислительная техника».

- •450000, Уфа-центр, к. Маркса, 12

3. Условная энтропия и взаимная информация

3.1. Дисктретные системы передачи информации.

Условной

энтропией величины

![]() при наблюдении величины

при наблюдении величины![]() называется

называется![]()

Справедливы соотношения:

![]()

![]()

Взаимной

информацией величин

![]() и

и![]() называется

называется![]()

Справедливы следующие соотношения:

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

Если

![]() и

и![]() независимы,

то

независимы,

то![]() =0.

=0.

При расчетах условной энтропии и взаимной информации удобно пользоваться следующими соотношениями теории вероятностей:

1)

теорема умножения вероятностей

![]() ;

;

2)

формула полной вероятности

![]()

![]()

![]()

3)

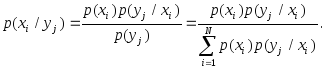

формула Байеса

Рассмотрим пример.

Пример 1. Дана матрица

,

,

![]()

![]() .

.

Определить:

![]()

![]()

![]()

![]()

![]()

![]()

Решение.

По формуле полной вероятности имеем:

![]()

![]()

![]()

![]()

![]()

![]()

Следовательно,

![]()

![]()

По теореме умножения

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

![]()

Следовательно,

![]()

Аналогично

![]()

![]()

![]()

3.2. Непрерывные системы передачи информации.

Пусть

![]() - реализации непрерывного сообщения на

входе какого-либо блока схемы связи,

- реализации непрерывного сообщения на

входе какого-либо блока схемы связи,![]() - реализация выходного сообщения

(сигнала),

- реализация выходного сообщения

(сигнала),![]() - одномерная плотность вероятности

ансамбля входных сообщений,

- одномерная плотность вероятности

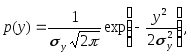

ансамбля входных сообщений,![]() - одномерная плотность вероятности

ансамбля выходных сообщений,

- одномерная плотность вероятности

ансамбля выходных сообщений,![]() - совместная плотность вероятности,

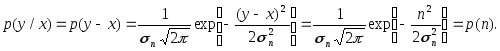

- совместная плотность вероятности,![]() - условная плотность вероятности

- условная плотность вероятности![]()

при

известном

![]() Тогда для количества информации

Тогда для количества информации![]() справедливы следующие соотношения:

справедливы следующие соотношения:

![]()

![]()

![]()

![]() ,

,

![]()

![]()

![]()

Здесь

![]() - взаимная информация между каким-либо

значением

- взаимная информация между каким-либо

значением![]() входного

и значением

входного

и значением![]() выходного

сообщений,

выходного

сообщений,![]()

![]() - средние значения условной информации,

- средние значения условной информации,![]() - полная средняя взаимная информация.

- полная средняя взаимная информация.

Условная энтропия определяется по формуле:

![]()

![]()

Когда

![]() и

и![]() статистически связаны между собой, то

статистически связаны между собой, то

![]()

При

независимых

![]() и

и![]()

![]()

Полная средняя взаимная информация определяется формулой:

![]()

Рассмотрим пример.

Пример

1. На вход

приемного устройства воздействует

колебание

![]() где сигнал

где сигнал![]() и помеха

и помеха![]() - независимые гауссовские случайные

процессы с нулевыми математическими

ожиданиями и дисперсиями, равными

соответственно

- независимые гауссовские случайные

процессы с нулевыми математическими

ожиданиями и дисперсиями, равными

соответственно![]() и

и![]()

Определить:

1) количество взаимной информации

![]() которое содержится в каком-либо значении

принятого колебания

которое содержится в каком-либо значении

принятого колебания![]() о значении сигнала

о значении сигнала![]() 2) полную среднюю взаимную информацию

2) полную среднюю взаимную информацию![]()

Решение.

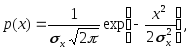

По условию

задачи

![]() представляет собой сумму независимых

колебаний

представляет собой сумму независимых

колебаний![]() и

и![]() которые имеют нормальные плотности

вероятности. Поэтому

которые имеют нормальные плотности

вероятности. Поэтому

![]()

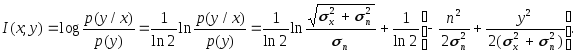

1. Количество информации определяется по формуле:

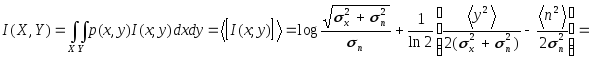

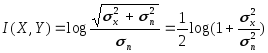

2. Полная средняя взаимная информация:

где

![]() - знак усреднения по множеству.

- знак усреднения по множеству.

Таким образом,

дв.

ед.

дв.

ед.

3.3. Задачи

3.3.1.

Сигнал

![]() подается на вход канала с вероятностью

подается на вход канала с вероятностью![]() и отсутствует с вероятностью

и отсутствует с вероятностью![]() Поступивший сигнал воспроизводится на

выходе с вероятностью

Поступивший сигнал воспроизводится на

выходе с вероятностью![]() и теряется с вероятностью

и теряется с вероятностью![]() Найти энтропию выхода, энтропию входа,

взаимную информацию входа и выхода

Найти энтропию выхода, энтропию входа,

взаимную информацию входа и выхода![]() ;

;

3.3.2.

Используя исходные данные задачи 1.3.6.,

определить энтропию входа

![]() условную энтропию

условную энтропию![]() и

и![]() взаимную информацию

взаимную информацию![]()

3.3.3. Для двоичного симметричного канала со стиранием заданы:

![]() - вероятность правильной передачи

каждого символа;

- вероятность правильной передачи

каждого символа;

![]() - вероятность передачи единицы на входе;

- вероятность передачи единицы на входе;

![]() - вероятность стирания каждого символа.

- вероятность стирания каждого символа.

Используя

исходные данные

![]()

![]() определить

определить

![]()

![]()

3.4. Контрольные вопросы

3.4.1. Дать определение условной энтропии.

3.4.2. Сформулировать закон аддитивности энтропии в общем случае.

3.4.3. Что является единицей измерения энтропии?

3.4.4. Какие формулы используются для расчета условной энтропии?

3.4.5. Какие формулы используются для расчета взаимной информации?

3.4.6. Как определяется полная средняя взаимная информация?

3.4.7. Как определяется условная энтропия в непрерывной системе передачи информации?