- •Введение

- •Формальный нейрон. Типология нейронов. Задача, решаемая нейроном, геометрическая интерпретация.

- •Формальный нейрон.

- •Типология нейронов.

- •Геометрическая интерпретация задачи нейрона.

- •Нейронная сеть. Слой, типология слоёв. Типология нейронных сетей. Основные классы задач, решаемых нейронными сетями.

- •задачи

- •Задача обучения нейронной сети, отличие от задачи обучения нейрона. Проблемы. Примеры алгоритмов и методов обучения.

- •Градиентные методы.

- •Математическое обоснование метода обратного распространения ошибки. Алгоритм обратного распространения ошибки.

- •Вывод формулы для расчёта адаптивного коэффициента обучения в алгоритме обратного распространения ошибки.

- •Вывод формулы для расчёта адаптивного шага обучения для нерекуррентной линейной нейронной сети.

- •Алгоритм послойного обучения. Назначение и отличие от алгоритма обратного распространения ошибки.

- •Алгоритм многократного распространения ошибки. Назначение и отличие от алгоритма обратного распространения ошибки.

- •Задача предсказания числовых последовательностей с помощью нейронных сетей. Особенности устройства нейронных сетей для предсказания числовых последовательностей.

- •Реккурентные нейронные сети. Контекстный нейрон. Обучение. Сеть Элмана. Сеть Джордана.

- •Рециркуляционные нейронные сети. Линейная рециркуляционная сеть. Задача, решаемая линейной рециркуляционной сетью (метод главных компонент).

- •Алгоритмы обучения и функционирования линейной рециркуляционной сети.

- •Релаксационные нейронные сети. Синхронная сеть Хопфилда. Непрерывное и дискретное состояние. Структура, обучение, энергия, функционирование.

- •Сеть Хэмминга. Назначение, обучение и функционирование.

- •Линейная ассоциативная память и ассоциативная память на основе сети Хопфилда. Функционирование, отличие.

- •Двунаправленная ассоциативная память. Назначение, структура, обучение и функционирование.

- •Двунаправленная ассоциативная память. Метод обучения двунаправленной ассоциативной памяти с модифицированной структурой.

- •Сеть адаптивного резонанса. Назначение, структура, обучение и функционирование.

- •СТРУКТУРА APT

- •Функционирование сети APT в процессе классификации

- •ФУНКЦИОНИРОВАНИЕ APT

- •ПРИМЕР ОБУЧЕНИЯ СЕТИ APT

- •ЗАКЛЮЧЕНИЕ

- •Устройство и структура нейронных сетей для решения задач классификации и кластеризации. Правила обучения: WTA и CWTA.

- •Структура когнитрона, неокогнитрона и свёрточных нейронных сетей, отличия. Назначение когнитрона, неокогнитрона и свёрточных нейронных сетей.

- •Обучение

- •НЕОКОГНИТРОН

- •Обобщение

- •Вычисления

- •Обучение

- •Псевдооптическая нейронная сеть. Интерферирующий нейрон, устройство. Назначение, структура и функционирование сети.

- •Машина Больцмана, назначение. Устройство и функционирование.

- •Предетекторы и детекторы. Поле (карта) детекторов. Детекторы новизны и тождества. Схема активного анализа на основе нейроподобных элементов.

- •Аппаратная реализация нейронных сетей. Процедура проектирования систолических массивов (процессоров), на основе структуры сети.

- •Систолические процессоры для двухслойной нейронной сети (первый слой – рецепторы). Эффективность. Предпочтение по эффективности.

- •Систолический массив с разнонаправленными связями. Сравнение по эффективности с процессорами с однонаправленными связями.

- •Матричный систолический процессор. Сравнение по эффективности.

- •Систолические массивы для многослойных нейронных сетей. Структура систолического массива, объединяющего различные систолические процессоры. Эффективность.

- •Систолические массивы для многослойных нейронных сетей. Структура систолического массива, объединяющего идентичные систолические процессоры. Эффективность.

- •Систолические процессоры для реализации релаксационных нейронных сетей (сети Хопфилда).

- •Методы обеспечения отказоустойчивости. Скользящее резервирование.

- •Методы обеспечения отказоустойчивости. Секционированное резервирование. Схема для неоднородного потока входных данных.

- •Нечёткие нейронные сети. Структура, функционирование, обучение.

- •Литература.

7.Если k > 0 , то переходим на шаг 3

Алгоритм многократного распространения ошибки. Назначение и отличие от алгоритма обратного распространения ошибки.

Алгоритм многократного распространения ошибки в некоторых случаях повышает вероятность попадания в глобальный минимум.

Дано: Em , Q

1.Случайная инициализация синаптических связей

2.h = Q

3.k = p

4.ωij[k ] (t +1) =ωij[k ] (t) −α(t) γ j[k ] (t) Fp′(S j[k ] (t)) yi[k−1] (t)

Tj[k ] (t +1) =Tj[k ] (t) +α(t) γ j[k ] (t) Fp′(S j[k ] (t))

5.k = k −1

6.Если k > 0 , то перейти к пункту 4

7.h = h −1

8.Если h > 0, то перейти к пункту 3

|

1 |

Q |

np |

2 |

9. E = |

∑∑( y j(k ) (t) −d j(k ) (t)) |

|

||

2 |

|

|||

|

h=1 |

j=1 |

|

|

10. Если E > Em , то перейти к пункту 2

Задача предсказания числовых последовательностей с помощью нейронных сетей. Особенности устройства нейронных сетей для предсказания числовых последовательностей.

Пусть есть числовая последовательность x1, x2, …, xn. Задача предсказания числовых последовательностей состоит в нахождении элемента xn+1, такого что

xn+1 = g(x1, x2 ,...xn ) . Если последовательность содержит значения функции, значение которой надо предсказать, то эти значения должны быть взяты с

одинаковым |

шагом |

xi = f (z +ih) . |

Для |

обучения |

из |

элементов |

последовательности составляется выборка. Чтобы её сформировать выбирается так называемое «окно». Величина выбираемого размера окна зависит, как от сложности предсказываемой последовательности, так и от числа образов, которые хотят получить для обучения. Слишком маленький размер окна может не дать возможности сети решить задачу, слишком большой – замедлить получение верного решения или привести к неверному. Если выбрать значение окна равным r, то можно получить max(0,n-r+1) образов в обучающей выборке.

Вслучае если задача решается линейной нейронной сетью, то задача сводится

крешению системы линейных алгебраических уравнений. В этом случае значения переменных, полученные в результате решения, могут использоваться в качестве значений весовых и пороговых коэффициентов сети. Чтобы решение было однозначным система должна иметь число уравнений не менее, чем число

переменных. Из этих соображений следует выбирать размер «окна». Если сеть не является линейной, также могут быть выявлены ограничения на размер «окна». Некоторые последовательности могут быть предсказаны только рекуррентными нейронными сетями.

Одной из трудностей, которая может возникнуть при решении задачи предсказания числовых последовательностей является ограниченная область значений функции активации, которая не позволяет получить значения для всех элементов последовательности. Путём преодоления этой трудности является поиск отображения последовательности на эту область, либо подбор соответствующей функции активации.

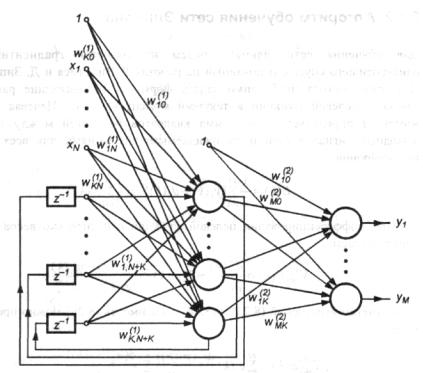

Реккурентные нейронные сети. Контекстный нейрон. Обучение. Сеть Элмана. Сеть Джордана.

Рекуррентные сети представляют собой развитие однонаправленных сетей персептронного типа за счет добавления в них соответствующих обратных связей. Обратная связь может исходить либо из выходного, либо из скрытого слоя нейронов. В каждом контуре такой связи присутствует элемент единичной задержки, передающий значение на так называемый контекстный нейрон, благодаря которому поток сигналов может считаться однонаправленным (выходной сигнал предыдущего временного цикла рассматривается как априори заданный, который просто увеличивает размерность входного вектора x сети, добавляя контекстные нейроны). Представленная подобным образом рекуррентная сеть с учетом способа формирования выходного сигнала функционирует как однонаправленная персептронная сеть. Тем не менее алгоритм обучения такой сети, адаптирующий значения синаптических весов, является более сложным вследствие зависимости сигналов в момент времени t от их значений в предыдущие моменты и соответственно ввиду более громоздкой формулы для расчета вектора градиента.

Отсутствие обратной связи гарантирует безусловную устойчивость сетей. Они не могут войти в режим, когда выход беспрерывно блуждает от состояния к состоянию и не пригоден к использованию. Но это весьма желательное свойство достигается не бесплатно, сети без обратных связей обладают более ограниченными возможностями по сравнению с сетями с обратными связями.

Так как сети с обратными связями имеют пути, передающие сигналы от выходов к входам, то отклик таких сетей является динамическим, т. е. после приложения нового входа вычисляется выход и, передаваясь по сети обратной связи, модифицирует вход. Затем выход повторно вычисляется, и процесс повторяется снова и снова. Для устойчивой сети последовательные итерации приводят к все меньшим изменениям выхода, пока в конце концов выход не становится постоянным. Для многих сетей процесс никогда не заканчивается, такие сети называют неустойчивыми. Неустойчивые сети обладают интересными свойствами и изучались в качестве примера хаотических систем. Сконцентрируем внимание на устойчивых сетях, т. е. на тех, которые в конце концов дают постоянный выход.

Классы сетей с обратной связью:

•релаксационные нейронные сети;

•сеть Джордана;

•сеть Элмана.

Сеть Джордана (RMLP)

Один из простейших способов построения рекуррентной сети на базе однонаправленной нейронной сети состоит во введении в персептронную сеть обратной связи. Таковой является сеть Джордана. Ее обобщенная структура представлена на рис. 11:

Рис. 11. Структура сети RMLP.

Это динамическая сеть, характеризующаяся запаздыванием входных и выходных сигналов, объединяемых во входной вектор сети. Рассуждения будут касаться только одного входного узла x(k) и одного выходного нейрона, а также одного скрытого слоя. Такая система реализует отображение:

y(k +1) = f (x(k), x(k −1),..., x(k −(N −1)), y(k −1), y(k − 2),..., y(k − P))

(51)

где N-1 - количество задержек входного сигнала, а P – количество задержек выходного сигнала. Обозначим K количество нейронов в скрытом слое. В этом случае сеть RMLP можно характеризовать тройкой чисел (N, P, K). Подаваемый на вход сети вектор x имеет вид: x(k) = [1, x(k), x(k-1), ..., x(k-(N-1)), y(к-Р), у(к-Р+1),

..., у(к-1)]T. Допустим, что все нейроны имеют сигмоидальную функцию активации. Обозначим ui взвешенную сумму сигналов i-го нейрона скрытого слоя, a g – взвешенную сумму сигналов выходного нейрона. При введенных обозначениях выходные сигналы конкретных нейронов описываются зависимостями:

ui = ∑Nj=+0P wij[1] xj |

(52) |

vi = f (ui ) |

(53) |

g = ∑iK=0 wi[2] f (ui ) |

(54) |

y = f (g) |

(55) |

Сеть Элмана

Рекуррентная сеть Элмана характеризуется частичной рекуррентностью в форме обратной связи между скрытым и входным слоем, реализуемой с помощью единичных элементов запаздывания z-1. Обобщенная структура этой сети представлена на рис. 12. Каждый скрытый нейрон имеет свой аналог в контекстном слое, образующем совместно с внешними входами сети входной слой. Выходной слой состоит из нейронов однонаправленно связанных только с нейронами скрытого слоя, подобно сети RMLP. Обозначим внутренний вектор возбуждения сети x (в его состав входит также единичный сигнал поляризации), состояния скрытых нейронов – v RK, а выходные сигналы сети – y RM. При таких обозначениях входной вектор сети в момент t имеет форму

x(k) =[x0 (k), x1 (k),..., xN (k),v1(k −1),v2 (k −1),...,vK (k −1)] |

(56) |

Рис. 12. Структура сети Элмана.

Веса синаптических связей первого (скрытого) слоя сети обозначим wij(1) , а второго (выходного) слоя – wij(2) . Если взвешенную сумму i-го нейрона скрытого

слоя обозначить ui, а его выходной сигнал - vi, то

ui (k) = ∑Nj=+0K wij[1] xj (k) |

(57) |

vi (k) = f1 (ui (k)) |

(58) |