- •Список скорочень Українські

- •Міжнародні

- •Sms (англ. Short Message Service) — служба коротких повідомлень

- •1.1. Автоматизація технологічних процесів: загальні положення, поняття, визначення, терміни, категорії

- •Питання та завдання для самоконтролю.

- •1.2. Знання, інформація і їх роль в системах управління

- •Категорія знання. Загальний підхід

- •Подання знань, інформація і процес прийняття рішень

- •Питання та завдання для самоконтролю.

- •1.3. Система: основні поняття, властивості, узагальнені класифікації

- •Класифікація систем

- •Питання та завдання для самоконтролю.

- •1.4. Синергетика як напрям прикладного системного аналізу

- •Передісторія виникнення синергетики

- •Синергетичні моделі

- •Синергетичні закономірності.

- •Значення синергетики для науки і світогляду.

- •Питання та завдання для самоконтролю.

- •1.5. Системний аналіз об’єктів управління технологічними процесами

- •Застосування методології системного аналізу до створення складних систем управління.

- •Системний підхід до створення автоматизованих технологічних комплексів (атк).

- •Структурний аналіз систем управління складними технологічними об’єктами

- •Інформаційна модель об’єктів управління технологічними процесами

- •Математична модель.

- •Питання та завдання для самоконтролю.

- •2.1. Історичні відомості і напрямки розвитку систем автоматизації

- •Питання та завдання для самоконтролю.

- •2.2. Автоматизація: поняття, визначення, терміни

- •Питання та завдання для самоконтролю.

- •2.3. Основні елементи та засоби автоматики, їх класифікація

- •Питання та завдання для самоконтролю

- •2.3.1. Датчики

- •Питання та завдання для самоконтролю

- •2.3.2. Підсилювачі

- •Питання та завдання для самоконтролю

- •2.3.3. Виконавчі елементи та пристрої

- •Виконавчі двигуни

- •Двигуни постійного струму

- •Питання та завдання для самоконтролю

- •2.3.4. Реле

- •Питання та завдання для самоконтролю

- •2.3.5. Обчислювальні та погоджувальні елементи

- •Цап (Цифро-аналогові перетворювачі)

- •Питання та завдання для самоконтролю

- •2.3.6. Логічні елементи

- •Логічні функції та елементи.

- •Логічних елементів ні, або, і.

- •Питання та завдання для самоконтролю.

- •2.4. Основні принципи управління: загальний підхід

- •Принцип мети

- •Принцип правової захищеності управлінського рішення

- •Принцип оптимізації управління

- •Норма керованості

- •Принцип відповідності

- •Принцип автоматичного заміщення відсутнього

- •Принцип першого керівника

- •Принцип одноразового введення інформації

- •Принцип підвищення кваліфікації

- •Методи мистецтва управління

- •Метод Сократа

- •Метод трьох раундів

- •Метод Штірліца

- •Метод «Жаба в сметані»

- •Питання та завдання для самоконтролю.

- •2.5. Загальні відомості про системи автоматичного управління

- •Питання та завдання для самоконтролю.

- •2.6. Класифікація систем автоматичного управління

- •Питання та завдання для самоконтролю.

- •2.7. Загальні відомості про системи телемеханіки та апаратні засоби

- •Лінії зв’язку

- •Перетворення сигналу

- •Безперервні методи модуляції

- •Цифрові методи модуляції

- •Питання та завдання для самоконтролю.

- •2.8. Функція контролю в складних системах атп

- •Автоматичне нагромадження й обробка інформації про надійність обчислювального комплексу

- •Питання та завдання для самоконтролю.

- •2.9. Джерела і показники техніко-економічної ефективності

- •Питання та завдання для самоконтролю.

- •2.10. Аналіз типових схемотехнічних рішень автоматизації окремих технологічних процесів в комунальному господарстві.

- •Типу «шэт»

- •Завдання

- •Типу «шэт»

- •3.1. Технологія: основні поняття і визначення

- •Питання та завдання для самоконтролю.

- •3.2. Теплоенергетичні установки (котельні)

- •Опис технологічного процесу

- •Питання та завдання для самоконтролю.

- •3.3. Вентиляційні установки

- •3.3.1. Типи систем вентиляції

- •Природна і штучна система вентиляції

- •Приточна і витяжна система вентиляції

- •Місцева і загально обмінна система вентиляці.

- •Складальна і моноблочна система вентиляції

- •Питання та завдання для самоконтролю.

- •3.4. Водопостачання та водовідведення

- •3.4.1. Основні функції автоматичних пристроїв насосної станції

- •3.4.2. Опис технологічної схеми водозабірної споруди річкового міського водопроводу

- •3.4.3 Технологія і автоматизація систем водовідведення

- •Питання та завдання для самоконтролю.

- •3.5 Система «Розумний будинок» («Інтелектуальний будинок»)

- •3.5.1. Опис систем «Розумний будинок»

- •3.5.2. Класифікація функцій систем керування «Інтелектуальним будинком»

- •3.5.2.1. Система керування електроживленням і освітленням Керування освітленням

- •Керування енергозбереженням

- •Керування рівнями освітлення у всіх кімнатах

- •Імітація присутності хазяїв (охоронна функція)

- •«Світло, що стежить»

- •Керування шторами і жалюзі з електроприводом

- •3.5.2.2. Система аудіо-відеотехніки «Мультирум»

- •Система прийому ефірного та супутникового телебачення

- •Прийом/передача цифрових потоків даних (Internet)

- •Керування відображенням з відеокамер

- •Система домашнього кінотеатру

- •Керування всіма пристроями домашнього кінотеатру

- •Автоматичне керування екраном і шторами затемнення

- •3.5.2.3. Система управління «Інтелектуальним будинком»

- •Керування всіма системами через Інтернет

- •Керування усіма системами з будь-якого комп'ютера в будинку

- •3.5.3. Система охорони будинку

- •3.5.4. Система відеоспостереженя

- •3.5.5. Система автоматизації життєзабезпечення будинку Система вентиляції і кондиціонування повітря

- •Система опалення (в т.Ч. «Тепла підлога»)

- •Керування опаленням в залежності від пори року і доби

- •Система холодного і гарячого водопостачання

- •3.5.6. Система метеорологічного контролю

- •Система обслуговування території

- •3.5.7. Функції зв’язку

- •Керування функціями «Розумного будинку» тоновими сигналами

- •«Sim-Sim» контроль

- •Керування доступом з будь-якого комунікаційного пристрою

- •Використання безконтактних карт

- •Бездротове управління

- •Керування із сенсорної панелі

- •Питання та завдання для самоконтролю.

- •3.6. Муніципальний транспорт

- •3.6.1. Розробка розкладу руху на міських маршрутах

- •Питання та завдання для самоконтролю.

- •3.6.2. Планування роботи водіїв і кондукторів

- •Питання та завдання для самоконтролю.

- •3.6.3. Складання наряду водіїв на роботу

- •Питання та завдання для самоконтролю.

- •3.6.4. Диспетчерський облік

- •3.6.4.1. Внутрішньо-паркова диспетчеризація

- •Питання та завдання для самоконтролю.

- •3.6.4.2. Лінійна диспетчеризація

- •Питання та завдання для самоконтролю.

- •3.6.4.3. Автоматичні системи диспетчерського управління (асду) транспортом

- •Питання та завдання для самоконтролю.

- •3.6.5. Моніторинг транспортних одиниць

- •Питання та завдання для самоконтролю.

- •3.6.6. Загальні відомості про gps (Global Positioning System)

- •Питання та завдання для самоконтролю.

- •3.6.7. Збір інформації про місцезнаходження транспортних засобів

- •Питання та завдання для самоконтролю.

- •3.7. Пожежна та охорона сигналізації

- •Питання та завдання для самоконтролю.

- •3.7.1. Загальні принципи побудови систем пожежної безпеки

- •Питання та завдання для самоконтролю.

- •3.7.2. Загальні принципи побудови систем охоронної безпеки

- •Питання та завдання для самоконтролю.

- •Структура системи автоматичної пожежної сигналізації

- •Питання та завдання для самоконтролю.

- •Глосарій

- •Список використаних літературних джерел

Подання знань, інформація і процес прийняття рішень

Подивимось більш детально на властивості і характеристики знань в проекції на їх функції в процесі прийняття рішень. Але, перш за все, дамо деякі необхідні означення.

Дані – синтаксичні сигнали (символьного, образного, жестового, сенсомоторного, звукового, електричного, магнітного, електромагнітного типу), що актуалізуються (тобто, можуть бути одержані, передані, перетворені, зібрані, оброблені, зареєстровані) за допомогою деякого джерела і розглядаються безвідносно до їхнього семантичного значення.

Інформація – це деяка послідовність даних з врахуванням їхньої семантичної сутності. Інформація завжди має носій.

Актуалізація інформації – процедури активізації інформації (збір, обробка, передача, отримання, перетворення, реєстрація) за допомогою певних засобів і технологій. Актуалізація інформації завжди пов’язана зі зміною носія інформації і системних ресурсів.

Повідомлення – форма актуалізації інформації, яка є змістом цього повідомлення (наприклад, SMS-повідомлення, телеграма, лист тощо).

Подання знань є процес, кінцева мета якого – це подання семантичного значення інформації у вигляді певним чином організованих інформативних повідомлень: фраз усної мови, речень письмової мови, сторінок книги, понять довідника, об’єктів географічної мапи, елементів і образів картини і т.п. Для цього необхідно користуватися певною конструктивною системою правил для подання і сприйняття інформації. Така система правил називається формалізмом подання знань.

Є також знання, що не можуть бути формалізованими – це ті, що отримують з застосуванням неформалізуємих правил: евристик, інтуїції, здорового глузду, а, також, прийняття рішень на їх основі.

Виходячи з вищезазначеного, можна заключити наступне.

1. Знання - це більш високий ступінь організацій інформації, ніж просто інформація.

2. В системі підтримки прийняття рішень, експертних системах процес управління визначається знаннями, бо майже не залежить від будови системи.

3. Процеси подання знань можуть мати процедурну частину - програми. Але використання цих програм управляється знаннями, зокрема зв'язування параметрів та запуск програм можуть відбуватися автоматично в середині системі, що використовує знання без відома того, хто включив процес подання знань.

4. Знання поділяються на окремі фрагменти: опис об’єктів, ситуацій, процесів. Такі фрагменти звуться фреймами. Фрейми можуть бути пов'язані між собою родовидовими відношеннями, можуть бути вузлами елементних мереж.

5. В процесі роботи із знаннями важливий прагматичний бік. Знання завжди використовуються для конкретних цілей, для чогось, зокрема для вирішення найрізноманітніших проблем, навіть із складною структурою.

Однією з важливих форм (методів) формалізації знань є їх подання за класом (класифікація знань). Класифікація знань – це виділення деякого критерію (сукупності критеріїв) розподілу і групування знань таким чином, що в одну групу попадають лише ті знання , які задовольняють цьому критерію (сукупності критеріїв).

До появи нових ІТ, у зв'язку із труднощами формалізації підходу до актуалізації знань, більшість компаній не могли ефективно керувати цими активами. З появою нових інформаційних технологій з’явилася можливість керувати знаннями. Це особливо важливо для тих підприємств, що оперують високим рівнем знань, необхідних для наукоємного виробництва, і вартість продукції яких значно вища за вартість сировини, що використовується для її виробництва.

В предметних галузях знання можна умовно класифікувати наступним

чином.

Фактографічне або предметне - знання, що складається із набору кількісних та якісних характеристик об’єктів і явищ.

Процедурне або алгоритмічне – знання методів, способів, певних процедур, що призводять до конкретного результату.

Концептуальне або понятійне - знання, що складається із сукупності основних понять і термінів, що використовується в якійсь певній сфері діяльності, їх властивостей, взаємозв’язків та взаємозалежностей.

Конструктивне – знання структурної будови певної системи (класу систем), підсистем системи і взаємодій між їхніми елементами.

Метазнання – знання про порядок і правила застосування знань.

Відома і така класифікація знань:

Розуміння, що набуваються фактичним досвідом.

Стан (діапазон) освіченості про будь-що, тобто володіння потрібною

інформацією в необхідному об’ємі.

Акт розуміння: ясне відчуття істини.

Щось зрозуміле, що тримається в розумі.

Є ще багато афористичних визначень, що таке є знання. Наприклад, у Френсіса Бекона: «Знання – сила». В рекламі: «Знання - цінна інформація, володіння світом».

Підсумовуючи вищезазначене, можна констатувати, що знання - це та важлива інформація, що залишається нащадкам, коли все зайве забуто.

Категорія «знання» має певні особливості. Наприклад, працівник сфери знань повністю володіє своїми «засобами виробництва»: інтелектом, пам'яттю, знаннями, ініціативою, особистим досвідом, які в явному вигляді приховані від інших. Це є не що інше як інтелектуальний капітал. В зв'язку з цим виникає проблема у власників підприємств: як, яким чином добувати приховані знання та перетворювати їх в явні, зафіксовані та нанесені на ті чи інші носії ще під час ефективної роботи працівника знань в трудовому колективі, коли він ще є учасником спільної корпоративної справи, результатом якої є знання. Бо певні складності виникають на етапі, коли робітник звільняється і забирає з собою свої знання.

Треба звернути увагу ще на одну особливість знань. Обмін знаннями не призводить до втрат, а, навпаки, збагачує. В наш час інформаційного суспільства інформація набуває матеріального змісту, особливо в умовах конкуренції. Для бізнесу знання – це рушійна сила, свого роду активи для отримання конкурентних переваг, і їхнім джерелом є систематичне придбання, синтез, обмін та використання інформації, ідей, досвіду.

Інформація – одне з основних, ключових понять в усіх галузях сучасної діяльності людини. В той же час це поняття погано формалізуєме внаслідок його узагальненості, об’ємності і розпливчатості. Поняття інформації потребує конкретизації в різних сферах застосування. Дані, що використовуються для прийняття управляючих рішень в реальному часі (тобто в момент їх формування, отримання) безпосередньо стають інформацією. Ті ж дані, які накопичуються для подальшого їх використання (можливо з обробкою), можна класифікувати, як потенційну інформацію.

Взагалі, даних буває набагато більше, ніж потрібно інформації для прийняття рішень (є багато зайвих даних, тому що інформація, яка в них мається, не використовуються для прийняття рішень, тому їх можна вважати зайвими, і потрібна попередня обробка даних).

Інформація (в системі, про систему) по відношенню до навколишнього середовища буває трьох типів: вхідна, вихідна, внутрішня. По відношенню до цілей системи інформація буває оперативною, тактичною та стратегічною. По відношенню до кінцевого результату інформація буває початкова, проміжна і результуюча. Інформацію також класифікують:

• за стадією використання (первинна, вторинна і т.д.);

• за повнотою (надлишкова, достатня, недостатня);

• за відношенням до управління системою (керуюча, така, що радить, перетворююча);

• за відношенням до її змінності при актуалізації (постійна, змінна, змішана).

Можлива класифікація інформації і за іншими ознаками.

Отримувані дані служать базою для прийняття рішень. На практиці при управлінні виробничим процесом ці дані занадто об'ємні та різноманітні, і в первинному вигляді мало придатні для прийняття рішень. Оперативність управління досягається, шляхом відбору і обробки даних для конкретної ситуації, що є необхідною та достатньою умовою для прийняття рішень в конкретній ситуації.

Розглядаючи критерії оцінки інформації, слід визначити поняття «кількість» і «якість». Дослідженням методів передачі, прийому і зберігання інформації займається теорія інформації, інструментами якої служать теорія випадкових процесів, теорія кодування, математична статистика, теорія ймовірностей. Увага до проблеми передачі і кількісної оцінки інформації була привернута фундаментальними роботами американських вчених Р.Хартлі, Н.Вінера і К.Шеннона, що поклали початок теорії інформації. Значний внесок до теорії інформації зробили вчені з СРСР, - А.М.Колмогоров, О.О.Харкевич, В.О.Котельников, - роботи яких добре відомі фахівцям у всьому світі.

Найважливішим етапом в теорії інформації була кількісна оцінка інформації і її зв’язок з поняттям ентропії.

Кількість інформації – це числова величина, яка адекватно характеризує інформацію, що актуалізується, за різноманіттям, складністю, структурованістю (впорядкованістю), визначеністю вибору станів системи, що відображається інформацією.

Оскільки інформація усуває певну невизначеність, тобто незнання, то й опис будь-якої події або об'єкту формально можна розглядати як вказівку на те, в якому з можливих станів знаходиться описуваний об'єкт. Тоді протікання подій в часі є не що інше, як зміна станів, вибраних з деякою вірогідністю з числа всіх можливих. Чим вище рівень невизначеності вибору, тим більший об'єм інформації потрібний, і результат вибору має значний ступінь несподіванки. От чому в теорії інформації кількість інформації є мірою зняття невизначеності однієї випадкової величини в результаті спостереження за іншою.

Вище було зазначено, що інформація в різних предметних областях, в різних проблемах може розумітися і інтерпретуватися по-різному. Внаслідок цього є різні підходи до виміру інформації і різні способи введення міри кількості інформації. Наприклад, в інформатиці, як правило, виміру піддається інформація, представлена дискретним сигналом. При цьому розрізняють наступні підходи.

Cтруктурний: вимірюєтся кількість інформації простим підрахунком інформаційних елементів, складових повідомлення. Застосовується для оцінки можливостей пристроїв, що запам'ятовують інформацію, об'ємів передаваних повідомлень, інструментів кодування без врахування статистичних характеристик їх експлуатації.

Статистичний: враховує вірогідність появи повідомлень. За більш інформативне вважається те повідомлення, яке менш ймовірно, тобто найменше очікувалося. Застосовується при оцінці значущості отримуваної інформації.

Семантичний: враховує доцільність і корисність інформації. Застосовується при оцінці ефективності отримуваної інформації і її відповідності реальності.

В рамках структурного підходу до виміру інформації можливі три міри інформації: геометрична, комбінаторна і адитивна. Міра є характеристикою кількісного вимірювання інформації.

Математичне поняття міри є узагальненням понять довжини відрізка, площі плоскої фігури, об’єму тіла для множин більш загальної природи.

Геометрична міра визначає максимально можливу кількість інформації в заданих об'ємах. Міра може бути використана для визначення інформаційної ємкості пам'яті комп'ютера;

Комбінаторна міра оцінює можливість представлення інформації за допомогою різних комбінацій інформаційних елементів в заданому об'ємі. Комбінаторна міра може використовуватися для оцінки інформаційних можливостей деякої системи кодування;

Адитивність

міри означає, що міра

![]() суми

суми

![]() кінцевої або рахункової системи попарно

непересічних множин

кінцевої або рахункової системи попарно

непересічних множин

![]() дорівнює сумі їхніх мір:

дорівнює сумі їхніх мір:

![]()

Адитивна міра була запропонована в 1928 році американським вченим-електронщиком Ральфом Хартлі (1888-1970рр.) в його роботі «Передача інформації», де він вперше зробив спробу зміряти кількість інформації. Ним було запропоновано один з варіантів адитивної міри інформації, який отримав другу назву – міра Хартлі. Р.Хартлі був піонером в галузі теорії інформації. Він вперше ввів спеціальне позначення для кількості інформації – I і запропонував логарифмічну залежність між кількістю інформації і потужністю початкового алфавіту:

I =d× loga N,

де I – кількість інформації, що міститься в повідомленні;

d – довжина повідомлення;

а - основа системи числення, в якій зазначена довжина d;

N – потужність (кількість символів) початкового алфавіту.

Алфавіт – це кінцева множина різних знаків, символів, для яких визначена операція конкатенації (приписування, приєднання символа до символу або ланцюжка символів) і які використовуються для подання інформації в деякій мові. За допомогою операції конкатенації по певним правилам з'єднання символів можна отримувати слова (ланцюжки знаків) і словосполуки (ланцюжки слів) над цим алфавітом.

Алфавітний підхід до виміру інформації є об’єктивним, оскільки він не пов’язує кількість інформації зі змістом повідомлення. Кількість інформації в при такому підході залежить лише від потужності алфавіту і об’єму тексту повідомлення.

Хартлі

стверджував, що коли в деякій множині

елементів (алфавіті) {xi},

![]() необхідно

виділити довільний елемент xi

,

то для цього необхідно отримати не менш

ніж logan

одиниць

інформації,

де n

-

число

можливих рівноймовірних результатів.

В цьому випадку величина logan

є мірою нашого незнання про систему

{xi},

.

необхідно

виділити довільний елемент xi

,

то для цього необхідно отримати не менш

ніж logan

одиниць

інформації,

де n

-

число

можливих рівноймовірних результатів.

В цьому випадку величина logan

є мірою нашого незнання про систему

{xi},

.

Щоб отримати вираз для міри кількості інформації за Хартлі, необхідно кожний символ алфавіту закодувати в якій-небудь системі числення з основою a кодами певної довжини m. Число таких кодів довжини m визначається методами комбінаторики і дорівнює числу розміщень з a елементів по m, що становить am. Довжину m необхідно вибрати таким чином, щоб число всіх можливих розміщень з a елементів по m було б не менше ніж потужність алфавіту N, тобто щоб виконувалась нерівність:

am ≥ N.

Найменше число mi , яке перетворює цю нерівність в рівність, є мірою різноманіття множини N і визначає кількість інформації, яку несе один символ алфавіту в тексті повідомлення. Цю величину mi називають інформаційною вагою символу алфавіту і визначають з рівняння

![]() .

.

Логарифмуючи ліву і праву частину цього рівняння, знаходимо:

![]() .

.

Цим виразом і визначається міра кількості інформації mi за Хартлі.

Якщо ми маємо повідомлення, що складається з d символів алфавіту (довжина повідомлення), то кількість інформації в такому повідомленні є добутком mi × d (формула Хартлі для кількості інформації І ).

При початковому алфавіті, що складається з двох символів {0,1}, його потужність N = 2, і для довжини повідомлення з одного символа (d = 1) в двійковій системі числення (основа логарифма a = 2), маємо

I = 1×log22 = 1.

Ця формула дає аналітичне визначення біту - одиниці виміру інформації в двійковій системі числення: це кількість інформації, яка міститься в двійковій цифрі (біт походить від англ. BInary digiT - bit).

Формулу Хартлі для кількості інформації можна пояснити і таким чином: для зняття невизначеності в ситуації з двох рівноімовірних подій необхідний один біт інформації; при невизначеності, що складається з чотирьох подій, достатньо два біти інформації, щоб визначити шуканий факт. Це міркування можна продовжити: 3 біта інформації знімають невизначеність з 8 рівноімовірних подій, 4 біта — з 16 рівноімовірних подій і так далі. Таким чином, якщо повідомлення вказує на один з п рівноімовірних варіантів, то воно несе кількість інформації, рівне log2 n.

Отже, при будь-якій невизначеності звуження області вибору вдвічі дає одну одиницю інформації.

Алфавітний підхід справедливий і для визначення кількості інформації про систему (в системі) довільної природи, якщо вважати кожен з можливих станів системи певним символом алфавіту, а всю множину станів системи – потужністю алфавіту.

Якщо вимірювання кількості інформації ведеться в експоненціальній системі числення з основою а = е (е ≈ 2,7182818284590…), то одиниця кількості інформації в такій системі називається «ніт»; якщо вимірювання виконано в десятковій системі з основою а = 10, то одиниця кількості інформації в такій системі числення називається «діт». Одиниця «ніт» зазвичай використовується для виміру неперервних величин.

Інший

американський вчений Клод Шеннон

(1916-2001рр.) в 1948 році, використовуючи

методологію Р. Хартлі, звернув увагу на

те, що при передачі словесних повідомлень

частота використання різних букв

алфавіту не однакова: деякі букви

використовуються дуже часто, інші -

рідко. Існує і певна кореляція в буквених

послідовностях, коли за появою однієї

з букв з великою вірогідністю слідує

конкретна інша. К. Шеннон запропонував

зв’язати кількість інформації, що несе

в собі деяке повідомлення, з ймовірністю

отримання цього повідомлення. Ввівши

імовірнісні значення pi

(![]() )

появи

і-го

символу алфавіту, потужність якого

дорівнює n,

Шеннон отримав нові вирази для визначення

середньої інформаційної ваги Іср

символу такого алфавіту:

)

появи

і-го

символу алфавіту, потужність якого

дорівнює n,

Шеннон отримав нові вирази для визначення

середньої інформаційної ваги Іср

символу такого алфавіту:

![]() ,

,

а кількість інформації І, що міститься в повідомленні з одного і-го символу алфавіту, що має ймовірність рi, визначається за формулою

I = - loga pi .

Якщо частота використання будь-якої букви алфавіту рівноімовірна, тобто

рi = 1/n, ,

то з формули Шеннона можна отримати (як окремий випадок) формулу Хартлі:

Іср = logan .

В статистичній фізиці добре відомий вираз, що зв’язує ентропію H (що є мірою хаосу) системи з ймовірністю реалізації даного макроскопічного стану системи з певним (дискретним) статистичним розподілом ймовірностей pi внутрішніх станів:

![]() ,

,

де k = 1.38 • 10–23 (Дж/К) – це, так звана, константа Больцмана.

Порівнюючи вирази для Іср (за Шенноном) і H, ми бачимо, що величину Іср можна розуміти як ентропію із-за браку інформації в системі (про систему). Дійсно, складаючи між собою ліві і праві частини виразів для Іср і H і проводячи прості перетворення, отримаємо основне функціональне співвідношення між ентропією і середньою інформаційною вагою станів системи (тобто інформацією):

Іср = H(logae)/k.

Тому кількість інформації Іср за Шенноном ще називають інформаційною ентропією. Величина інформаційної ентропії в двійковій системі числення вказує середнє число двійкових знаків (бітів), необхідних для розрізнення (запису) можливих значень випадкової величини.

Інформаційна ентропія Н(А) є мірою невизначеності випадкового об’єкту А з скінченою множиною можливих станів А1, …, Аn з відповідними ймовірностями p1, …, pn :

H(A)

= H({pi})

=

![]() .

.

Кожний з можливих станів Аi об’єкту А можна розглядати як букву алфавіту {Ai}, , який являє собою множину цих станів, а число станів n – як потужність цього алфавіту. Певну послідовність довжиною d з букв над алфавітом {Ai}, можна вважати конкретним словом. Кількість можливих слів довжини d є, очевидно, кількістю можливих розміщень з n елементів по d і дорівнює nd. Конкретне слово С довжини d можна вважати реалізацією однієї з nd можливих подій. Послідовність {С} конкретних слів можна вважати інформаційним повідомленням. Знаючи ймовірності букв і умовні ймовірності появи наступного символу в слові, якщо відомий попередній (у випадку їхньої залежності), можна розрахувати ймовірність Р(С) для кожного слова С і послідовності слів {С}. Тоді ентропія множини {С} – тобто інформаційного повідомлення, - за визначенням, дорівнює:

![]() ,

,

де а – основа системи числення, в якій зазначена інформаційна вага букв алфавіту.

Ентропійний підхід принципово змінив поняття інформації. Під інформацією тепер почали розуміти не будь-які повідомлення, що передаються в системі зв'язку, а лише ті, які зменшують невизначеність у одержувача інформації. І чим більше зменшується ця невизначеність, тобто чим більше знижується ентропія повідомлення, тим вище інформативність повідомлення, що поступило. Ентропія - це той мінімум інформації, який необхідно отримати, щоб ліквідовувати невизначеність алфавіту, використовуваного джерелом інформації.

З формули Шеннона випливають важливі висновки.

1. Інформаційна ентропія H({pi})=0 ( ) в тому і тільки в тому випадку, коли яке-небудь одне з p1, …, pn дорівнює одиниці (тоді інші, звісно, дорівнюють нулю). Це відповідає випадку, коли відсутня всяка невизначеність.

2. Коли жодне з pi ≠1, то H({pi})>0, .

3. H({pi})

(

)

досягає найбільшого значення при p1=p2=

…= pn=![]() ,

тобто у випадку максимальної невизначеності

(перевіряється варіацією функціоналу

H({pi})

по

pi

при

умові

,

тобто у випадку максимальної невизначеності

(перевіряється варіацією функціоналу

H({pi})

по

pi

при

умові

![]() ,

що дає

,

що дає

![]() ).

).

4. Кількість інформації про деякий об’єкт є мірою знятої невизначеності цього об’єкту, числове значення якої дорівнює різниці значень апріорної (тобто, відомої до проведення досліду) і апостеріорної (відомої після проведення досліду) інформаційних ентропій цього об’єкту.

5. Збільшення кількості інформації про систему свідчить про зменшення ентропії (збільшенні порядку) системи, тоді як зменшення інформативності свідчить про збільшення ентропії (збільшенні безладу) системи.

Позитивна сторона формул Хартлі і Шеннона – їхня абстрагованість від змісту інформації. Крім того, на відміну від формули Хартлі, формула Шеннона враховує різність станів, що робить її придатною для практичних обчислень.

Як

було зазначено вище, під повідомленням

зазвичай мають на увазі інформацію, що

виражена в певній формі і підлягає

актуалізації. Повідомлення

—

це форма представлення інформації. Є

різниця між кількістю інформації,

представленої в двійкових цифрах, що

зберігається або передається, і кількістю

інформації, що міститься в даному

повідомленні. З погляду теорії інформації,

невизначеність, що знімається в результаті

передачі однієї сторінки тексту приблизно

з 2000 знаків, може складати всього декілька

бітів, тоді як ця ж сторінка при кодуванні

букв 8-елементними кодовими комбінаціями

міститиме

![]() біт, хоча це не є кількість інформації,

що є в даному тексті.

біт, хоча це не є кількість інформації,

що є в даному тексті.

Немає необхідності для детального розгляду різноманітних напрямів класифікації інформації, що пропонуються. Виділимо тільки ті ознаки інформації, які істотно впливають на ефективність управлінських рішень: своєчасність, повнота, визначеність, достовірність. Наявність цих якостей обумовлює, як правило, і ефективність АСУ ТП в цілому.

Своєчасність отримання необхідної інформації — головна вимога для ухвалення ефективних управлінських рішень. Затримка в надходженні інформації до конкретного користувача приводить до втрати основної її властивості — цінності. Більш того, несвоєчасно отримана інформація може виявитися не тільки даремною, але і шкідливою.

Важливою якістю інформації є її повнота, яка обумовлюється характеристиками технологічного процесу реєстрації, збору і передачі даних. Технологією може бути передбачена реєстрація і передача всіх первинних даних про стан об'єкту управління або тільки деяку сукупність даних, необхідних на певний момент часу. Точність інформації характеризує можливість відображення стану об'єкту управління без спотворення його значень і залежить як від технічних засобів реєстрації даних, так і від методів їх збору і підготовки. Проте не всі дані, перетворені в інформацію, в рівній мірі впливають на ефективність рішень, що приймаються.

АСУ ТП повинна мати такий об'єм даних, перетворення яких забезпечить користувача мінімумом об'єктивно необхідної інформації для ухвалення ефективних управлінських рішень.

Об'єм інформації, необхідний користувачеві для вироблення і ухвалення управлінських рішень, обумовлюється, зокрема, наступними параметрами:

складністю управлінського рішення або відповідних завдань управління;

термінами реалізації конкретного рішення або завдання;

формою і видом кінцевого результату ухвалення управлінського рішення або завдання.

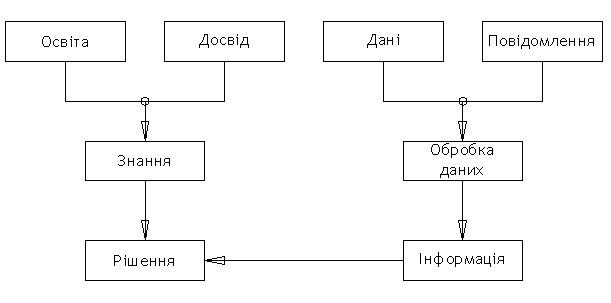

Підсумовуючи викладене ми приходимо до відомої схеми функцій даних та знань в процесі прийняття рішень (рис. 5).

Оператор (суб’єкт) приймає рішення в складній системі, спираючись на свої знання та отриману інформацію. Тому виникає проблема узгодженості людського фактора в складних системах.

Головною задачею сучасної освіти є допомога в формуванні світогляду під кутом зору орієнтації в інформаційному просторі. Для набуття знань навіть з конкретної дисципліни потрібен критерій, стрижень. Системний підхід дозволяє не тільки систематизувати знання, але й визначити напрямки їх подальшого застосування.

Рис. 5. Схема функцій даних та знань в процесі прийняття рішень