- •4. Основные сведения о нейронных сетях

- •4.1. Введение

- •Каждый нейрон, входящий в нейронную сеть и представленный на рис. 1 в виде кружка, участвует в преобразовании входных сигналов, так что выходной сигнал зависит от алгоритма работы всех нейронов.

- •4.2. Модель нервной клетки (нейрона)

- •Лекция 24

- •4.3. Математическая модель нейрона

- •4.4. Многослойная нейронная сеть

- •4.5. Обучение нейронной сети

- •Лекция 25

- •4.6. Обратное распространение ошибки

- •Лекция 26

- •Если q – й нейрон расположен в k–ом скрытом слое (рис. 8), то согласно (17а) при замене r на q , 2 на k, 1 на k-1 и I на r,

- •4.7. Аппроксимация функций (моделирование) с помощью нейронных сетей (персептронов)

- •Нейронная сеть с радиальными базисными функциями

- •Cтруктура нейронной сети с радиально базисными функциями (рбф сети)

- •Методы обучения рбф сети

- •Лекция 27

- •Моделирование (идентификация) нелинейных динамических процессов (объектов)

- •3. Применение нейронных сетей (нс) для управления

- •3.1. Нейросетевые адаптивные системы управления

- •3.1.1. Нейросетевая технология адаптивной линеаризации обратной связью

- •3.1.2. Нейросетевое прямое и косвенное адаптивное управление на основе желаемой (эталонной) модели

- •Лекция 28

- •5. Синтез нейронных нечетких сетей

- •5.1. Введение

- •Адаптивные нейронные нечеткие системы инференции (anfis)

- •Структура anfis

- •Алгоритм обучения anfis

- •Генетические алгоритмы

- •Лекция 29

- •Генетические нечеткие системы (Извлечение нечетких знаний с помощью генетических алгоритмов)

- •Проектирование нечетких систем

- •Классификация генетических нечетких систем

- •4.6. Обратное распространение ошибки

Методы обучения рбф сети

Несколько методов могут быть предложены для настройки параметров РБФ сети, когда она используется для аппроксимации функций. Эти методы могут быть распределены на четыре группы:

Центры базисных функций устанавливаются равномерно в пространстве входов.

Центры выбираются с помощью набора обучающих данных.

Центры выбираются с помощью алгоритмов кластеризации.

Центры рассматриваются как параметры в процедуре оптимизации.

При использовании первой технологии центры ci располагают равномерно в области входов, так что центры образуют решетчатую структуру. Веса wi настраиваются после того, как выбрано местоположение центров. Центры неявно фигурируют как свободные параметры при минимизации функции стоимости. Этот метод приводит к очень большому числу параметров (к параметризации), особенно тогда, когда имеет место большое число входов.

Центры могут быть выбраны непосредственно из примеров множества обучающих данных. Этот выбор может быть сделан совершенно случайно, но лучше использовать ортогональный метод наименьших квадратов. Основная идея этого метода выбирать центры итеративно один за другим из множества обучающих данных так, чтобы в результате минимизировать квадратичную функцию стоимости.

В третьем методе центры базисных функций находят путем кластеризации векторов обучающих данных. Используют как методы жесткой, так и нечеткой кластеризации. Расположение центров зависит от распределения векторов данных в пространстве входов. Веса wi настраиваются после того, как выбрано местоположение центров. Этот метод прост, но не гарантирует в общем случае оптимального решения, т.к. расположение центров базируется на данных входа, а не на минимизации функции стоимости.

Все параметры РБФ-сети могут быть определены также путем минимизации функции стоимости E . При этом часто используется градиентный метод наискорейшего спуска. Рассмотрим этот метод.

Учитывая, что

![]() ,

,

(здесь

![]() есть

координаты центра

есть

координаты центра

![]() i-й

базисной функции) находим

i-й

базисной функции) находим

Для

сети с одним выходным сигналом и линейным

выходным слоем (n=1)

y=f

Для

сети с одним выходным сигналом и линейным

выходным слоем (n=1)

y=f

имеем

.

.

Обновление центров

Генетические алгоритмы также могут быть применены как методы оценки параметров.

Лекция 27

Моделирование (идентификация) нелинейных динамических процессов (объектов)

Способность нейронных сетей осуществлять нелинейное преобразование сигналов может быть использовано для моделирования нелинейных динамических объектов. В этом случае модель находится путем обучения нейронной сети, т.е. путем настройки весов так, чтобы минимизировать ошибку моделирования.

Использование нейронных сетей для моделирования поясним на примере дискретного динамического нелинейного объекта с одним входом и одним выходом. Предположим, что на вход такого объекта поступает управляющая последовательность u[iT] , а на выходе с помощью датчика измеряется управляемая последовательность y[iT]. Пусть известно, что дискретная модель объекта является моделью второго порядка. Заметим, что выбор порядка модели относится к проблемам идентификации нелинейных систем, но не является предметом данного курса лекций. Тогда общее описание нейронной динамической модели с тремя входными и одним выходным сигналом можно выразить в форме

![]() .

(30)

.

(30)

В

этом уравнении

![]() обозначает реакцию

нелинейного объекта в момент t=(i

обозначает реакцию

нелинейного объекта в момент t=(i![]() 1)T,

а

1)T,

а

![]() - реакцию нейронной

динамической модели этого объекта в

тот же момент времени t=(i

+1)T

на один и тот же сигнал u[iT].

Для сравнения линейный аналог этой

нейронной модели описывается как

- реакцию нейронной

динамической модели этого объекта в

тот же момент времени t=(i

+1)T

на один и тот же сигнал u[iT].

Для сравнения линейный аналог этой

нейронной модели описывается как

![]() (31)

(31)

с параметрами a1, a2, b1 , подлежащими оценке, и называется авторегрессионной моделью (ARX-моделью). Разностный сигнал

e[(i+1)T]=

![]() -

-![]()

управляет процессом настройки весов нейронной модели.

Проблема

идентификации объекта сводится к

построению такой его параметрической

нейронной модели, чтобы реакции объекта

y[i]

и модели

![]() на

один и тот же управляющий сигнал u[i]

совпадали

в пределах допустимой ошибки

на

один и тот же управляющий сигнал u[i]

совпадали

в пределах допустимой ошибки

![]() ,

т.е.

,

т.е.

|

![]() -

|

-

|

![]() .

.

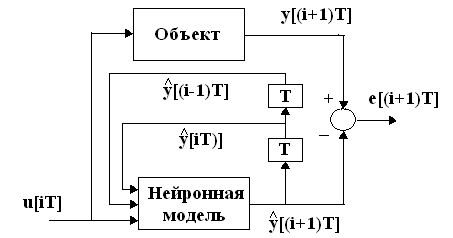

В случае применения для моделирования объектов нейронная сеть обычно подключается параллельно объекту и использует для предсказания выхода объекта смещенные в сторону запаздывания выходные последовательности объекта так, как это показано на рис. 9.

Рис. 9

При таком подключении реакция сети зависит от входа u[(iT)] , а также от сигналов u1[iT] =y[iT] и u2[iT]= y[(i-1)T], представляющих собой две прошедшие через линии задержки T реакции желаемого сигнала, составляющих ожидаемый выходной вектор сети. В этой ситуации нейронная сеть выполняет функции классической многослойной статической сети.

Найденная нейронная модель тестируется с помощью свободного запуска («free run») (рис. 11).

Рис. 11

Термин

свободный запуск используется, чтобы

подчеркнуть контраст с так называемым

предсказанием на один период дискретизации

(«one-step-

ahead

prediction»)

(рис.10). При свободном запуске оценки

выходов объекта

![]() и

и

![]() используются

как входы нейронной сети вместо измеренных

значений. Таким путем модель может быть

использована, чтобы моделировать объект

независимо от измеренных значений

выхода. Если модель используется для

предсказания на несколько периодов

дискретизации (на некоторый горизонт),

как это необходимо при управлении с

предсказанием, свободный запуск

представляет собой более дискриминационный

тест и более удобен для тестирования

модели, чем модель тестирования,

опирающаяся на предсказание на один

период дискретизации.

используются

как входы нейронной сети вместо измеренных

значений. Таким путем модель может быть

использована, чтобы моделировать объект

независимо от измеренных значений

выхода. Если модель используется для

предсказания на несколько периодов

дискретизации (на некоторый горизонт),

как это необходимо при управлении с

предсказанием, свободный запуск

представляет собой более дискриминационный

тест и более удобен для тестирования

модели, чем модель тестирования,

опирающаяся на предсказание на один

период дискретизации.

В общем случае для объектов высокого порядка в качестве входов нейронной модели используют, кроме настоящих значений входа u[iT] и выхода y[iT], p прошлых значений входа u[(i-1)T], u[(i-2)T],…, u[(i-p)T], и q прошлых значений выхода y[(i-1)T], y[(i-2)T],…, y[(i-q)T], так что общее описание нейронной динамической модели можно представить в виде

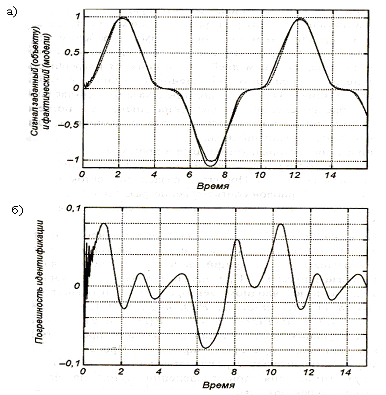

Для примера рассмотрим моделирование нелинейного динамического объекта Винера, состоящего из последовательно включенных линейного фильтра Баттерворта шестого порядка и нелинейного статического элемента в форме полиномиальной функции x3 . В нейронной модели этого объекта использовалась сеть с одним скрытым слоем из 25 нейронов. Входной слой состоял из 24 узлов, а входной вектор включал кроме настоящих значений входа и выхода, 11 прошлых значений входа и 11 прошлых значений выхода. После подбора значений весов с помощью обучения тестировалась способность сети к обобщению, для чего на ее вход подавался синусоидальный сигнал. На рис. 10 показаны графики изменения сигнала, полученного на выходе нелинейного объекта (пунктирная линия), и сигнала, имеющего место на выходе нейронной сети (непрерывная линия).

Рис. 10