- •1. Определение понятий «информация», «дискретное сообщение». Единица измерения количества информации. Количество информации, содержащейся в дискретном сообщении ( дс ).

- •2. Структурная схема спдс. Понятие о дискретном канале ( дк ), канале передачи данных, тракте передачи данных, цепях стыка и протоколах пдс.

- •3. Принцип работы устройств синхронизации по элементам с непосредственным воздействием на генератор.

- •4. Принцип работы устройств синхронизации по элементам без непосредственного воздействия на генератор.

- •5. Сущность безмаркерного способа групповой синхронизации.

- •6. Сущность маркерного способа цикловой синхронизации.

- •7. Расчет параметров устройств синхронизации.

- •8. Периферийные устройства пэвм ( сканеры, принтеры: струнные, лазерные). Классификация. Краткая характеристика. Принцип работы.

- •9.Структурная схема многофункционального терминала. Назначение основных его составляющих.

- •10. Интерфейс rs-232. Управление потоком передаваемых данных.

- •11. Единая система документальной электросвязи. Интеграция услуг документальной электросвязи. Назначение и основные принципы построения служб обработки сообщений.

- •12. Современные модемы. Классификация. Функции модемов. Рекомендации мкктт.

- •13. Избыточность сигналов дискретной информации. Понятие об объеме сигнала и способах повышения верности приема.

- •14. Принцип помехоустойчивого кодирования. Классификация кодов.

- •15. Особенности и принцип построения кода Хэмминга. Обнаружение и исправление ошибок кодом Хэмминга. Синдром линейного кода.

- •16. Техническая реализация кодирующих и декодирующих устройств линейного кода.

- •17. Циклические коды. Особенности и принцип построения кодовой комбинации циклического кода. Обнаружение и исправление ошибок при циклическом кодировании. Синдром циклического кода и его свойства.

- •18. Структурная схема и алгоритм работы системы с решающей обратной связью и ожиданием решающего сигнала ( роСож).

- •19. Структурная схема и алгоритм работы системы с рос с непрерывной передачей информации ( роСнп ) и блокировкой.

- •20. Структурная схема и алгоритм работы системы с информационной обратной связью (иос ).

- •21. Принцип факсимильной передачи сообщений. Структурная схема факсимильной связи. Основные достоинства и недостатки факсимильного способа передачи сообщений.

- •22.Анализирующие и синтезирующие устройства, используемые в факсимильных аппаратах. Конструктивные особенности.

- •23. Принципы построения современной цифровой факсимильной аппаратуры. Структурная схема. 39. Структурная схема факсимильного аппарата и назначение всех ее элементов.

- •24. Основные методы сжатия изображений апк, кдс и код Хаффмена.

- •25. Эталонная модель взаимодействия открытых систем.

- •26. Локальные сети: общие понятия, стандарты, методы доступа к среде передачи.

- •27. Базовые технологии локальных сетей.

- •28. Глобальные сети : общая структура и функции глобальных сетей.

- •29. Повторители, назначение.

- •30. Мосты, типы мостов.

- •31. Коммутаторы, типы коммутаторов, способы снижения трафика с использованием коммутатора, способы передачи информации, принцип передачи с помощью мостов.

- •32. Маршрутизаторы, структура маршрутизатора, принцип формирования маршрутной таблицы, порядок выбора маршрута.

- •1. Уровень интерфейсов.

- •2. Уровень сетевого протокола.

- •3. Уровень протоколов маршрутизации.

- •33. Концентраторы и их основные функции.

- •1. Отключение портов.

- •2. Поддержка резервных связей.

- •3. Защита от несанкционированного доступа.

- •34. Шлюзы, принцип работы.

- •35. Классификация сетей передачи данных.

- •36. Телематические службы документальной электросвязи.

- •37. Протоколы передачи файлов используемые в модемах.

- •38. Протоколы коррекции и сжатия данных, используемые в модемах.

- •40. Процедура взаимодействия двух компьютеров.

- •41. Обмен данными между компьютером и периферийным устройством.

- •42. Накопители информации. Накопители на гибких магнитных дисках, конструктивные особенности. Накопители на жестких магнитных дисках, конструктивные особенности, характеристики, формат записи.

- •43. Классификация принтеров. Конструктивные особенности принтера ( струйного , лазерного ). Краткая характеристика.

- •44. Сканеры – классификация, принцип работы черно-белого и цветного сканеров.

- •45. Скремблирование и дескремблирование в модемах.

- •46. Интеллектуальные возможности модема.

- •Задачи.

1. Определение понятий «информация», «дискретное сообщение». Единица измерения количества информации. Количество информации, содержащейся в дискретном сообщении ( дс ).

Бит – единичный элемент кодовой комбинации с основанием кода, равным двум. Является единицей измерения количества информации I(a). (1 бит – это количество информации, которое переносит один символ источника дискретных сообщений в том случае, когда алфавит источника включает два независимых символа).

Бит/с – единица скорости передачи информации по каналу R, представленной в виде последовательности двоичных символов. Обычно под этим подразумевается, что все передаваемые биты имеют одинаковую длительность и период повторения. Максимально возможное значение скорости передачи по каналу при заданных условиях называется пропускной способностью канала C.

Бод – единица измерения числа переданных двоичных информационных и служебных символов в единицу времени. Так, если по некоторому асинхронному каналу в среднем передаётся один асинхронный символ в секунду в формате 8N1 (8 информационных двоичных символов, один стартовый, один стоповый, символ контроля паритета отсутствует, - всего 10 двоичных символов), то можно утверждать, что скорость передачи информации в этом канале равна в среднем 8 бит/с или 10 Бод.

Информация –это совокупность сведений об объекте или явлении, которые увеличивают знания потребителя об этом объекте или явлении.

Ценность информации зависит от того, насколько она нова, важна и сложна. Чем меньше вероятность получения конкретного сообщения, тем больше информации содержится в данном сообщении, поэтому вероятность, это мера неожиданности в получении информации или ее количественная характеристика, т.е. количественная мера информации не связана с конкретным сообщением, а отображает лишь степень неожиданности принимаемого сообщения в данных конкретных условиях.

Вероятные события содержат мало новой информации. Отсюда следует:

- количество информации в нескольких независимых сообщениях равно сумме количества информации в каждом из них.

- количество

информации о достоверном сообщении,

выданном источником сообщения (заранее

ожидаемом ) с вероятностью![]() должно быть равно

нулю, т.к. оно не увеличивает наших знаний

и заранее известно получателю.

должно быть равно

нулю, т.к. оно не увеличивает наших знаний

и заранее известно получателю.

Количество

информации, приходящейся на один символ,

определяется через логарифмическую

меру:![]()

Где![]() -вероятность

появления символа.

-вероятность

появления символа.

Основные свойства количества информации:

Аддитивность – количество информации, содержащейся в нескольких независимых сообщениях, равно сумме количества информации в каждом из них.

Количество информации величина не отрицательная.

Количество информации приходящейся на один единичный элемент, если появление единичных элементов неравномерно:

![]() [бит/ед. эл]

[бит/ед. эл]

Если кодовая комбинация состоит из n разрядов, то используется свойство аддитивности:

![]() [ бит/код. комб.]

[ бит/код. комб.]

Дискретный ( цифровой ) сигнал – это сигнал, имеющий конечное число значений (0 или 1).

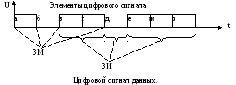

Элемент цифрового сигнала – это его часть, отличающаяся от остальных частей значением одного из своих представляющих параметров ( амплитуда).

Значащая позиция – это расстояние между значащими моментами .

Значащий момент ( ЗМ ) – это точка изменения значащей позиции.

Интервал времени между двумя соседними ЗМ сигнала называется значащим интервалом ( ЗИ ). Минимальный интервал времени, которому равны ЗИ времени сигнала, называется единичным интервалом ( например а-б и т.д.).

Элемент сигнала, имеющий длительность, равную единичному интервалу времени, называется единичным элементом.

Дискретное сообщение – информация, представленная в дискретном виде.

Энтропия Н (А) – это среднее количество информации, приходящееся на одно сообщение или на его элементы. Это мера неопределенности в поведении источника сообщения.

Энтропия равна «0», если с вероятностью «1» источником выдается всегда одно и тоже сообщение. В этом случае неопределенность в поведении источника отсутствует. Энтропия максимальна если символы источника появляются независимо и с одинаковой вероятностью.

![]() ;

Бит/с.

;

Бит/с.

Производительность – это среднее количество информации, выдаваемой источником в единицу времени.

![]()

где: Т – среднее время, отводимое на передачу одного символа.

Пропускная способность – это количество слов, передаваемых или принимаемых за 1 час. Или это максимально возможное значение скорости передачи информации по каналу при заданных условиях.

![]() ;

бит/сек.

;

бит/сек.

РОШ–вероятность возникновения ошибки.

Если в канале нет ошибок, то пропускная способность определяется исходя из скорости модуляции.

Достоверность – определяет степень соответствия принятых знаков по отношению к переданным.

![]() отсюда определяется

коэффициент ошибки:

отсюда определяется

коэффициент ошибки:

![]()

Вероятность ошибки есть величина обратная достоверности.

Надежность – это способность аппаратуры выполнять свои функции в течении определенного промежутка времени. Она оценивается следующими показателями:

- Время наработки на отказ(Tn) –интервал времени между двумя соседними отказами.

- Время восстановления ( Тв ) –время необходимое для устранения неисправности.

- Коэффициент готовности( Кг ).

![]()