- •Введение

- •1. Основные понятия. Количественная мера информации

- •Понятие информации

- •1.2. Количественная мера информации для равновозможных событий

- •1.3. Количественная мера информации для разновозможных событий (сообщений). Энтропия источника дискретных (цифровых) сообщений

- •1.4. Свойства энтропии источника дискретных сообщений

- •1.5. Энтропия источника совместных сообщений

- •1.6. Определение количества информации источника дискретных сообщений при неполной достоверности результатов опыта

- •1.7. Некоторые свойства количественной меры информации источника дискретных сообщений при неполной достоверности результатов опыта

- •1.9. Избыточность источника сообщений

- •1.10 Энтропия источника при наличии коррелятивных связей между двумя соседними символами

- •Контрольные вопросы

- •2. Информационные характеристики непрерывных (аналоговых) источников информации

- •2.1. Понятие о непрерывных (аналоговых) источниках информации

- •2.2. Энтропия непрерывного источника информации. Количество информации в одном замере непрерывной случайной величины

- •2.3. Примеры вычисления энтропии непрерывных источников информации

- •2.4. Количество информации, содержащееся в одном замере непрерывной случайной величины при неполной достоверности результатов измерения

- •Контрольные вопросы

- •3. Понятие о пропускной способности каналов и скорости передачи информации

- •3.1. Пропускная способность дискретного (цифрового) канала

- •3.2. Пропускная способность непрерывных (аналоговых) каналов

- •3.3. Определение пропускной способности непрерывного канала

- •3.4 Основные теоремы Шеннона

- •3.5 Энтропия источника при наличии коррелятивных связей между двумя соседними символами

- •4 Помехоустойчивое кодирование

- •Коды с обнаружением и исправлением ошибок. Код хемминга

- •Исправляющая способность кода хемминга

- •Контрольные вопросы

- •Библиографический список

- •Лабораторная работа №4 код хемминга

- •1.1. Понятие информации ...................................................................... 1

- •Контрольная работа № 1

- •Контрольная работа № 2

2.3. Примеры вычисления энтропии непрерывных источников информации

2.3.1. Вычислить приведенную и полную энтропии источника с равномерным законом распределения непрерывной случайной величины.

Для такого источника

(2.6)

(2.6)

Приведенную энтропию находим по формуле (2.4) с учетом (2.6):

,

,

откуда

![]() .

.

По формуле (2.5) находим полную энтропию

![]() . (2.7)

. (2.7)

Количественная

мера информации (2.7) согласуется с нашими

интуитивными представлениями. С

уменьшением

![]() ,

т.е. с повышением разрешающей способности

измерительных приборов, количество

получаемой в результате измерений

информации будет возрастать. При

,

т.е. с повышением разрешающей способности

измерительных приборов, количество

получаемой в результате измерений

информации будет возрастать. При

![]() ,

в при

,

в при

![]() ,

это соответствует случаю, когда измерения

не проводятся.

,

это соответствует случаю, когда измерения

не проводятся.

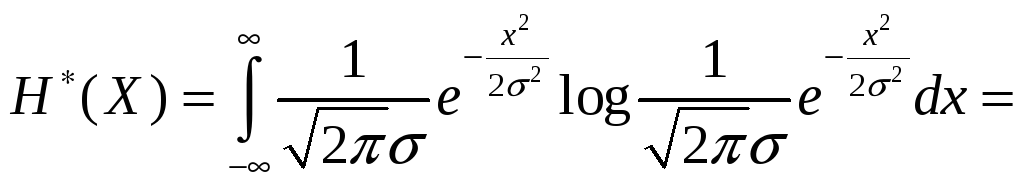

2.3.2. Вычислить приведенную и полную энтропии источника с нормальным законом распределения непрерывной случайной величины.

Для этого источника примем

, (2.8)

, (2.8)

где

![]() – дисперсия источника, которая в данном

примере находится как

– дисперсия источника, которая в данном

примере находится как

![]() . (2.9)

. (2.9)

Приведенную энтропию для этого примера находим по формуле (2.4) как

. (2.10)

. (2.10)

Вычисление этого интеграла дает

![]() . (2.11)

. (2.11)

Полную энтропию находим по формулам (2.5) и (2.11):

.

.

В

приведенных примерах вычислялись

энтропии известных функций распределения.

Можно решать и задачи обратного характера,

например, найти функцию распределения

![]() ,

обеспечивающую максимальную энтропию

источника при некоторых заданных

ограничениях. Если таким ограничением

является диапазон изменения непрерывной

случайной величины источника, то

наибольшее значение энтропии дает

равномерное распределение. Если

ограниченной величиной является

дисперсия процесса при его неограниченном

диапазоне изменения, то наибольшее

значение энтропии достигается при

нормальном распределении.

,

обеспечивающую максимальную энтропию

источника при некоторых заданных

ограничениях. Если таким ограничением

является диапазон изменения непрерывной

случайной величины источника, то

наибольшее значение энтропии дает

равномерное распределение. Если

ограниченной величиной является

дисперсия процесса при его неограниченном

диапазоне изменения, то наибольшее

значение энтропии достигается при

нормальном распределении.

2.4. Количество информации, содержащееся в одном замере непрерывной случайной величины при неполной достоверности результатов измерения

Если бы измерение было абсолютно точным, т.е. не содержало погрешностей, то количество получаемой при этом информации, как уже отмечалось, должно было быть бесконечно большим.

В

действительности, однако, измерение

любой величины может быть выполнено

лишь с некоторой степенью точности.

Наличие погрешностей приводит к тому,

что количество информации, содержащееся

в результате измерений

![]() ,

об измеряемой величине

,

об измеряемой величине

![]() становится конечным. Это позволяет

распространить соотношения, определяющие

становится конечным. Это позволяет

распространить соотношения, определяющие

![]() для дискретных источников информации,

на непрерывные источники.

для дискретных источников информации,

на непрерывные источники.

Для

перехода от дискретных источников к

непрерывным, как это уже делалось в

разделе 2.2, непрерывные величины

![]() и

и

![]() в первом приближении заменяем дискретными.

Тогда выражение (1.21) примет вид

в первом приближении заменяем дискретными.

Тогда выражение (1.21) примет вид

![]() . (2.12)

. (2.12)

В

дроби, стоящей под знаком логарифма,

умножим числитель и знаменатель на

![]() ,

тогда из (2.12) получим

,

тогда из (2.12) получим

![]() . (2.13)

. (2.13)

Переходя

к пределу

![]() и

и

![]() ,

из (2.13) получаем

,

из (2.13) получаем

![]() . (2.14)

. (2.14)

Соотношение

(2.14) дает ответ на вопрос о количестве

информации, содержащейся в непрерывной

случайной величине

![]() ,

о непрерывной величине

,

о непрерывной величине

![]() .

.

Отметим некоторые свойства количественной меры информации (2.14).

2.4.1.

![]() .

Это следует из аналогии с дискретным

источником информации.

.

Это следует из аналогии с дискретным

источником информации.

2.4.2.

![]() ,

причем

,

причем

![]() ,

если

,

если

![]() и

и

![]() – статистически

независимые случайные величины.

– статистически

независимые случайные величины.

2.4.3.

Значение

![]() не зависит от способа отсчета величин

не зависит от способа отсчета величин

![]() и

и

![]() .

Если учесть, что

.

Если учесть, что

![]() ,

то выражение (2.14) может быть преобразовано

к виду

,

то выражение (2.14) может быть преобразовано

к виду

![]() , (2.15)

, (2.15)

где

![]() ,

,

![]() , (2.16)

, (2.16)

и может быть названо приведенной условной энтропией.

3_05/10/2018