- •Лекция №1

- •ИСТОРИЯ.

- •Лекция 2

- •1.1 ПРЕДМЕТНАЯ ОБЛАСТЬ

- •1.2 ЗАДАЧА

- •Лекция 3

- •Решение задач

- •Лекция 4

- •РЕШЕНИЕ ЗАДАЧ.

- •2.1 Метод пространства состояний.

- •Лекция 5.

- •РЕШЕНИЕ ЗАДАЧ.

- •МЕТОД ПРОСТРАНСТВА СОСТОЯНИЙ.

- •Переборы с эвристиками.

- •Типовые стратегии оценки.

- •Лекция 6

- •РЕШЕНИЕ ЗАДАЧ В ФОРМАЛЬНЫХ ТЕОРИЯХ

- •ФОРМАЛЬНЫЕ ТЕОРИИ

- •ЕСЛИ <УСЛОВИЕ> ТО БУДЕТ <ТО, ТО>

- •Лекция 7

- •ЛОГИКА ПРЕДИКАТОВ

- •Лекция 9

- •ЭКСПЕРТНЫЕ СИСТЕМЫ

- •Лекция 12

- •Лекция 13

- •РАСПОЗНОВАНИЕ ОБРАЗОВ.

- •БАЙЕСОВСКАЯ ЗАДАЧА

- •ИНТЕРРАГОТИВНАЯ ЛОГИКА.

Рисунок, заимствованный из книги Попова Э. В. Показаны те роли которые есть, если конкретные лица участвуют в работе и показаны разные трассы, которые активизируются вольно или невольно при решение задач, формировании баз знаний. Если это происходит в рамках, какой-то оболочки ЭС, все есть и интерфейсное, есть интерпретатор, только база знаний пустая. И блок приобретения знаний еще не работает. И вот в режиме наполнения оболочки конкретными знаниями можно использовать интерпретатор. В частности здесь отражено, что кроме знаний всегда нужно возвращать к их толкованиям, т.е. переходить к их метазнаниям – знания о представление знаний в базе знаний. Если вы знаете эти метаформы, тогда вы будете их эффективно наполнять. Если вы знаете все типы продукции, которые есть в базе знаний, то хорошо.

РАСПОЗНОВАНИЕ ОБРАЗОВ.

Распознавание образов – это одна из предметных областей, которая очень активно исследуется в рамках искусственного интеллекта. В ходе исследований было получено очень много интересных результатов. Тематика эта встала как отдельная раньше, чем искусственный интеллект. Распознавать образы пробовали давно и с разными целями. Распознавание образов – это специфическое направление связанное с радиосигналами, с передачей кодов по радиосвязи. Но это задача связи, и как-то к искусственному интеллекту мало относится. Но опыт там громадный, причем опыт вероятностного оценивания, различного вероятностного описания, прогнозирования и всего остального.

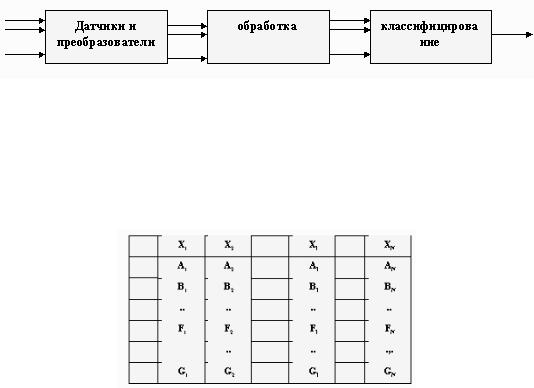

Распознавание образов – это специфический вид задач и принятия решений, там от реальности никак не удается уйти и первый слой, откуда поступает информация – это слой первичных датчиков. В разных задачах свои датчики (сенсорные датчики). Т.е. все начинается с контакта с окружающей средой, контакт с окружающей средой всегда в конкретной области, в конкретных точках или плоскостях.

В этих точках из -за контакта происходит передача явления на выход датчиков и происходит своего рода селекция сигналов. Каждый датчик на конкретный раздражитель реагирует и в конкретную форму этот раздражитель переводит. Т.е. появляется фронт точек и из этих точек сигналы пошли, разной физической модальности (ток, давление, магнитные). Вот, пусть, у вас сеть волокон, кабель и по этому кабелю передается информационный вектор.

С датчиков информация в дискретной форме снимается и передается по каналам и идет вот этот поток. Но этот поток не сплошной, датчики селекцию провели вполне конкретную и определенную в диапазонах того, что вам нужно и что вы решили распознавать.

Первая задача связана с тем, чтобы найти интегралы, кроме интегралов еще надо избавиться от помех. Т.е. стоят преобразователи, слой за слоем. Идет съем на уровне первичных датчиков многоканальной информации, потом это передается по линиям связи, преобразуется, что бы потом с этой информацией можно было работать. Съем происходил из реальности связанной друг с другом информации, вернее тех явлений которые датчики возбуждали.

Дальше начинается обработка. Обработка для того, что бы учесть связность информации. Возможно, в результате обработки у вас из десяти каналов образуется один канал. Если в результате обработки вектор уменьшился, он все равно передается дальше вектором. И с позиции распознавания вы ни когда не избежите работы, которую называют классифицированием.

Вспомним. Мы брали глагол, ставили его за скобки, а в скобки предметные единицы. Т.е., от чего он зависит, для того что бы образовалась версия. Так вот в распознавании образов принципиальное место занимает классифицирование. Мы составляем такой предикат:

.

.

Обучающее множество. Если ребенок ничего не видел, то у него когда происходит первый контакт. Так вот демонстрации с называние – называются обучающим множеством. Если выделяю какой-то класс, то значит буду его n раз распознавать. Создавать какие-то условия и создавать условия, что бы предъявлять этот класс другим. Обучающее

множество может быть конечным. Вот я тысячу раз показал и считаю, что больше показывать не надо, потому что я уже научил. Если я таким образом поступаю, значит выборка фиксированная. Т.е. она определенное число экземпляров распознавания образов берет за основу, а на их базе строит правила распознавания и потом уже включает эти правила в работу. Обучающее множество или выборка, может быть фиксированная, но она может быть и переменной. Вот я n аз предъявил, выработал правила распознавания, потом предъявляю n+1 раз и смотрю, правило у меня подходит или его надо чуточку изменить, что бы оно и этот случай учитывало. Если у меня такое обучающее множество, то выборка у меня переменная. И смысл перемен заключаются в том, что для каждого нового экземпляра пытаться улучшить правило распознавания. Обучающее множество – это сечения по всему вектору, того что было по всему вектору. В то же время это констатация факта, того что я вектора n раз зафиксировал и по ним построил распознающее правило или сделал переменную выборку. Но учтите, я не все из чего состоит вектор рассказал. Позиция 2 это форма которой представляется каждый экземпляр выборки. Возьмем экземпляр, член выборки, как я его опишу, это позиция описания. А описать я могу по-разному. Самое простое описание – это перечень признаков. Хорошо бы дать перечень связанный и в котором формулы присутствуют. Задача по позиции описания открытая.

Как представлена форма информации или форма тех раздражителей, которые используются для того что бы решить задачу классифицирования

– это вопрос специфический и свой. Есть вероятностные подходы, когда с точки зрения вероятности вектора на него еще и вероятности накладывают. Есть алгебраические модели, есть алгоритмические, есть в форме грамматик различных. Позиция «описание» в предикате «классифицировать» очень важна.

Правило распознавание всегда специфическое. Как распознавать буквы которые мы пишем на конверте (индекс) – одна версия правил, как я рукописные буду распознавать другие правила.

На слайде изображено:

У нас три признака, по ним начинаем регистрировать разные вещи и мои результаты регистрации попадают в одну из этих областей (рисунок). Раз они туда попадают по каким-то объективным законам, значит это

группы. Раз группы, значит я могу эти группы специфицировать. Могу задать неравенствами, один признак находиться в интервале таком-то, второй в таком-то, а третий в таком-то – то это первый класс. А если находятся в таких-то интервалах, то это класс №2. Так редко бывает, но бывает, что нам удается представать задачу в декартовом пространстве признаков. Раз они сгруппировались значит есть объективные обоснования для этого. Самая простая версия описания задач, когда мы набором признаков даем, самая простая версия классифицирования, когда нм удается по этим набором признаков в системе координат определить области. И для каждого нового экземпляра, который я наблюдаю, решить какому классу он принадлежит.

Пусть эти классы у нам специфицированы. Заданы интервалы, куда должны попадать элементы вектором, что бы я мог сказать «да, это элементы такого-то класса». Берем точку, которая ближе к К2 но за пределами обрасти. Мы должны принять решение, к какому классу принадлежит этот элемент. Если я буду n+1 экземпляр рассматривать, то я должен буду отнести его к классу К2. Для этого у меня основание – он находиться ближе всего к центру К2. «Ближе к центру» - это правило классифицирования, когда я по любому новому экземпляру делаю заключение, используя какие-то проверки. Проверка – ближе к центру – тому и принадлежит – это правило.

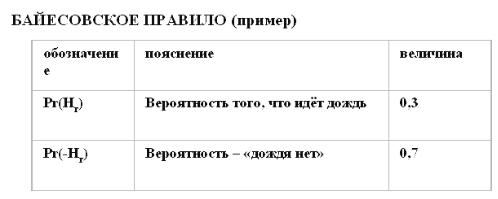

Переходим к другому правилу: «Байесовское правило». Этому правилу лет 300, применяют его очень часто. Рассмотрим его на примере. Но прежде вспомним некоторые элементы теории вероятности.

СОБЫТИЯ И ИХ

Pr(A) - вероятность появления события А

Pr(A,B) - вероятность совместного появления событий

A и B

Pr(B|A) - вероятность B при условии, что произошло А

Pr(A,B)= Pr(A)* Pr(B|A) = Pr(B)* Pr(A|B)

Нас интересуют связанные события, когда условия между ними «еслито». На рисунке, для двух связанных событий. А потом привязка этих событий к байесовской задаче.

БАЙЕСОВСКАЯ ЗАДАЧА

Гипотезы {Hi} - Pr(Hi Hj) = 0, Σ Pr(Hi) = 1

Эксперименты {Ek}, причём известна Pr(Ek|Hi)

Pr(Ek|Hi) ≥ 0 , Pr(Ek, Ek|Hi) = 0 Σ Pr(Ei| Hi) = 1 Pr(Ei) = Σ Pr (Ei| Hi) * Pr( Hi) -

Смысл: проводился группа экспериментов, и вы измеряли наборы этих признаков каким-то образом. На основе этих признаков вы формулировали гипотезы, свое понимание того что происходит. Т.е. были эксперименты и были выводы обобщающие, на основе этих экспериментов. Т.е. построение предсказаний на основе экспериментов, которые проводились.

Байесовское оценивание применяется в различных предметных областях.

Разберем байсовское оценивание, разберем на конкретном примере. Этот пример из книжки по искусственному интеллекту Ханта.

Есть некоторая местность, там человек любопытный, он в окно смотрит, и старается гипотезу выдвинуть идет на улице дождь или не идет. А если дождь мелкий, стекла у него туманные, он не видит. Он хочет определить идет дождь или нет, а перед этим он подготовился. Он очень долго записывал разные факты в разные таблицы. Он регистрировал как часто шел дождь, он это записывал какими-то вероятностями Его интересовали следующие вещи: он всегда точно знал идет на улице дождь или нет, но о н наблюдал события происходившие. Их три вида. Первый – это на улице идут люди с зонтиками, люди есть – зонтиков нет, людей нет. А фактов два, или дождь идет при этих трех, наблюдаемых событиях, или нет. 1000 раз он смотрел в окно. 300 раз дождь шел, 700 раз не шел. Кроме того он смотрел есть ли на улице люди, и есть ли у них зонтики или нет. Эти условные вероятности, идет дождь, есть зонтики или нет, иди есть зонтики или людей нет, он все вот так сложил и у него получилось: когда идет дождь в 40% случаях люди с зонтиками шли, в 20% шли без зонтиков, в 40% людей вообще не было на улице. Но как факт он эти две таблички собрал. А теперь он полистал книжки по логике, и прочитал он простую вещь, что для двух событий, а у него два события, что он гипотезу какую-то выдвигает, всегда можно выразить вероятность их совместного происхождения. Она может быть вычислена через вероятность одного из них и условную вероятность другого или наоборот. Но его-то интересует вот в этой формуле конкретная вещь, Его интересует вот смотрите. Я беру и рассматриваю только где я скобки провел, значит меня интересует гипотеза, если я что-то наблюдаю в окно. Вот гипотеза идет дождь или нет, если я наблюдаю, что там никого нет. Или есть люди и все с зонтами

или без зонтов. Здесь получается вполне конкретная формула и я ее могу представить в следующем виде, используя все те напоминания о знаниях по информации, которые были в предшествующих слайдах. Гипотезу о том идет на улице дождь или нет, в зависимости от того, что я реально наблюдаю через свое окно, всегда можно вычислить вот по такой формуле. Это теория вероятности дает, а Байс сказал, что эту вероятность можно использовать для того, чтобы делать предположение, какая гипотеза наиболее верна. Вообще-то здесь начинаются натяжки. Эта формула верна, для тех событий, которые уже произошли, для 1000 случаев, которые были. Если я провожу 1001-й эксперимент, то у меня все характеристики начинают меняться. Оно свою единичку куда-то дало и всю картину в таблице нарушило. Но я не хочу, чтобы у меня нарушались те законы в таблице, я говорю: я считаю, что 1001-й эксперимент ничего нового в распределение вероятностей не дает. Это первая натяжка. И если она не дает, то я могу очень просто использовать оценку гипотезы. Я подсчитаю, какая из вероятностей больше, и та вероятность гипотезы ,которая является больше, то я ее должен и принять. Вот что сказал Байес. Мы рассмотрели ситуацию что так разумно рассуждать и так разумно оценивать, как будто я ничего слишком сильно не нарушил, проведя 1001-й эксперимент. Я говорю, что скорее всего незначительно нарушаться вероятности. И так поступить я могу. Т.о. по событиям, которые я выбрал для анализа и выдвижения гипотез, я могу судить и оценивать вероятность самих гипотез. Чем больше вероятность, тем больше оснований считать, что именно та гипотеза более правомерна. Рассуждения вероятностны и правдоподобны. Вот что сказал Байес. И вот чего применяют все триста лет и ни кто не хочет от этого отказываться. Если мы от наших зонтиков и людей уйдем на общий случай, то мы получим следующую формулу, вот и все. Т.е. эта общая формула, которая используется в байесовском оценивании. Самое важное в байесовском оценивании, чтобы были некоторые события, вектор событий, я значение этого вектора знал, и чтобы по конкретному значению этого вектора мог рассчитать условную вероятность подтверждения гипотезы. Потом значение вероятностей я использую для принятия решения или для выбора. Здесь мы должны классы различать, то что мы должны учитывать, здесь приведено. Вот поясню я сначала действие. В терминах примера, действия заключались в том, что я принимал ту или иную гипотезу, идет дождь или нет. Но ведь по этой гипотезе я не в потолок смотрел. Я выходил на улицу и не брал с собой зонтика, потому что по моей гипотезе там дождя нет, а костюм у меня дорогой. Я шел, мочил его, ткань от влаги меняется. Т.е. за гипотезами всегда стоит там череда событий. Например, я опять промахнулся, считая что на улице идет дождь, брал с собой зонтик. Таскал его с собой и в любом месте мог оставить его. И в этом плане за любым прогнозом, за любой гипотезой лежат действия. Они начинаются уже с выбора гипотезы, а вообще-то могут потери последовать от того, что вы неправильно спрогнозировали. Потери – это

дополнительные составляющие задачи байесовского оценивания. Т.е. зонтик я потерял или костюм угробил, потери в денежном выражении разные. Но в любом случае я считать должен. Значит есть для каждого действия, по состоянию, потеря. Если начать формализацию самой задачи проводить, то я получу линейны формулы, которые выражают, с точки зрения потерь, все мои прогнозы и принятые решения. С точки зрения потерь критерий выбора усложняется. Просто одних вероятностей мало. Что нужно учитывать для задачи с двумя уравнениями – здесь приведено. Есть определенная версия расчетов, которые нужно произвести, и по результатам расчетов, отдавать предпочтение какой-то гипотезы с учетом потерь. Здесь приведена задача, которая с учетом потерь.

Здесь не вероятностная интерпретация, а другая, здесь задача, которая в системе координат признаков, для упрощения на плоскости. Она приведена для того, чтобы мы снова сосредоточились на правиле распознавания. Правила распознавания вот записаны. А теперь переходим к другой ветке, вот здесь смотрим, как же можно классифицировать новые экземпляры. Я отделил эти области друг от друга прямыми линиями, провел я их для демонстрации. Хотя при решении конкретных задач по распознаванию образов, если вы хотите правила на основе этого способа формулировать, то размещать эти линии надо в соответствии с определенными соотношениями, т.е. есть методика разделения линиями классы друг от друга. Если я разделил их, то меня интересует всегда новый экземпляр. Если новый экземпляр пришел со своими характеристиками, то я всегда могу определить в каком из секторов, а их у меня три, находиться конкретная точка. Я должен сравнивать больше координата, выше, чем линия или ниже. Вот она выше двух линий, значит она принадлежит этому классу. Т.е. я всегда могу подставить координаты в уравнение линии, чтобы убедиться, выше находиться точка или нет. Если я такие расчеты проведу, то по отношениям я всегда могу сформулировать правила, по которым очередной экземпляр будет отнесен к той или иной области.

Есть такие задачи, в которых смотрят расстояние до границы. На слайде названы основные задачи, которые приходиться решать, если вы работаете с конкретной системой распознавания образов. Первое – определить полный перечень признаков, это своего рода генерация отличительных черт одного от другого. В этот момент вы еще далеко и от правил и от классифицирования. Вы еще даже датчики не включали в работу. Есть задач, там есть объекты, которые придется распознавать и из любых источников информацию об этих объектах перерабатываете. Цель такая: какие есть признаки у этого объекта, и у другого объекта и т.д. Например, для первого объекта 100 признаков, для второго 60, для третьего 120 и т.д. Пока вас интересует информативная сторона дела. Дальше вы начинаете думать о том, что в тех наборах признаков есть какие-то грубые группы или нет. Такая группировка дает первый шаг в распознавании образов, она дает первую версию набора классов. Уже у

вас какая-то ценная информация есть и априорную классификацию вы уже можете исследовать, для того, чтобы оценить, стоит ли на ее базе строить систему распознавания или нет. Может быть вы из этого набора классов выберете фиксированный набор признаков. Когда вы остановились на каких-то группах, можно словарик признаков завести, которые будут действовать в этой группе. И на основе этих признаков вы изменили версию классификации. Она зависит от набора признаков. В этой ветке есть задача, которую на уровне признаков формулирую вот таким образом: определить информативный набор признаков. Т.е. выбрать те признаки, которые вы будите использовать для распознавания. Если у вас уже решен вопрос с признаками, значит и с датчиками, то можно переходить к выбору алгоритмов распознавания. Надо сравнивать свою задачу с теми классическими, которые есть в множестве книжек. И от туда вы и выйдите на алгоритмы распознавания. В байсовском оценивании один алгоритм распознавания, в других другой. Когда вы выбрали алгоритм, у вас начинается техника вычислений и обработки данных. Придется столкнуться с задачей качества распознавания, там где диффузия и многое другое мешает, эффективность и оценивание.

Лекция 15

Мы рассмотрели основные проблемы, связанные с тем что приходиться с реальностью иметь дело. Раз с реальностью, значит шумы, как-то от шумов избавляться надо, различные версии преобразований, накоплений, усреднений информационных характеристик. Разные подходы в распознавании образов, в декартовом пространстве, в байесовском.

Техника уже нам позволяет по результатам контакта с окружающей средой рисовать. Если, например, телеглазом смотрите, то по тому, что он смотрит, сканирует, он восстанавливает плоскую картину. А раз плоскую картинку восстанавливает, то при этом многое отбрасывается, обобщается. Уже появляются области очерченные каким-то образом, между ними отношения вполне определенные. Здесь уже можно переходить к описанию. Самая первая версия перехода к описанию – это переход к предикатному описанию.

Здесь приведен такой пример, нарисована рожица, пусть ее отсканировал робот. Нас интересует версия описания на языке предикатов 1-го порядка этой рожицы. В первую очередь надо разобраться с теми единицами, которые там есть. Единицы будут предметными, или классами. Отношения и свойства находятся наружи. Можно и глубже детализировать. Простейшая детализация здесь показана. С точки зрения геометрии, есть прямоугольник, окружность, отрезок и глаза – точки. Если мы хотим все описать, то начинаются разметки различного рода с учетом отношений. Возникает вопрос, как все это назвать. Если голова – то не совсем, череп – не череп. Лицо подходит. Лицо состоит из черт лица, головы, и черты лица находятся внутри головы. Голова – это окружность. Отмечено как черты друг от друга расположены. Здесь в принципе мы должны переходить на графику, на саму процедуру рисования. Нос – надо нарисовать прямоугольник и там надо распознать этот прямоугольник, который нарисован, если это было снято сканированием. Тут приходиться думать над этими отношениями. Сразу бы у вас описать не получилось эту голову. Такого рода распознавание было вшито в робота Шейки.

Еще один пример как использовать формальные грамматики распознавания образов. Здесь задан алфавит, он из четырех стрелок: влево, вправо, вверх, вниз. Мы можем легко оформить углы, с учетом обхода по часовой стрелке.