Shpory_v_pdfe

.pdf

4.Мера количества извлекаемой информации на выходе дискретного канала. Собственная информация.

5.Свойства собственной информации.

1)Неотрицательность:  .

.  при

при  , т.е. предопределенный факт никакой информации не несет.

, т.е. предопределенный факт никакой информации не несет.

2)Монотонность:  , если

, если  .

.

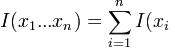

3)Аддитивность: для независимых  справедливо

справедливо

.

.

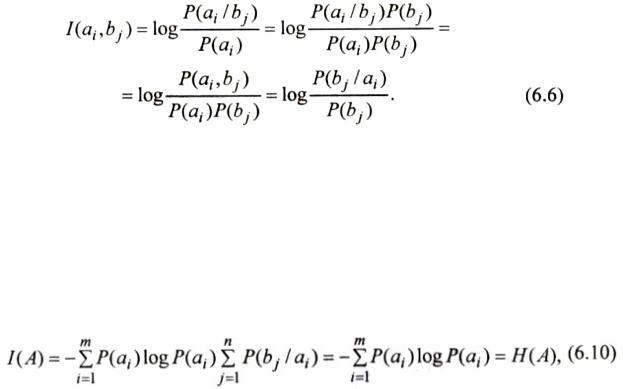

6. Взаимная информация. Средняя взаимная информация.

Из (6.6) следует, что информация, доставляемая символом bj о символе аj, равна информации доставляемой символом аj о символе bj. Поэтому I(aj,bj) называется взаимной информацией.

На практике представляет интерес средняя взаимная информация, равная количеству информации о множестве передаваемых символов, которая в среднем содержится во множестве принимаемых символов.

7. Энтропия

Обратимся к формуле (6.10). Она определяет среднее количество информации, которое может быть на выходе источника дискретных сообщений. Формула идентична выражению для энтропии системы в статистической механике. Поэтому величину 1(A) называют энтропией дискретного источника и обозначают Н(А).

Выражение 1(А/В), входящее в формулу (6.8), определяет среднее количество информации о символах на входе канала, полученное при приеме всевозможных символов на его выходе. Величину 1(А/В) называют средней, условной энтропией и обозначают Н(А/В). Ее также называют ненадежностью дискретного канала связи

где Н(В/а.) - частная, условная энтропия, которая характеризует информативность сообщения на выходе канала после того, как стал известным передаваемый символ а..

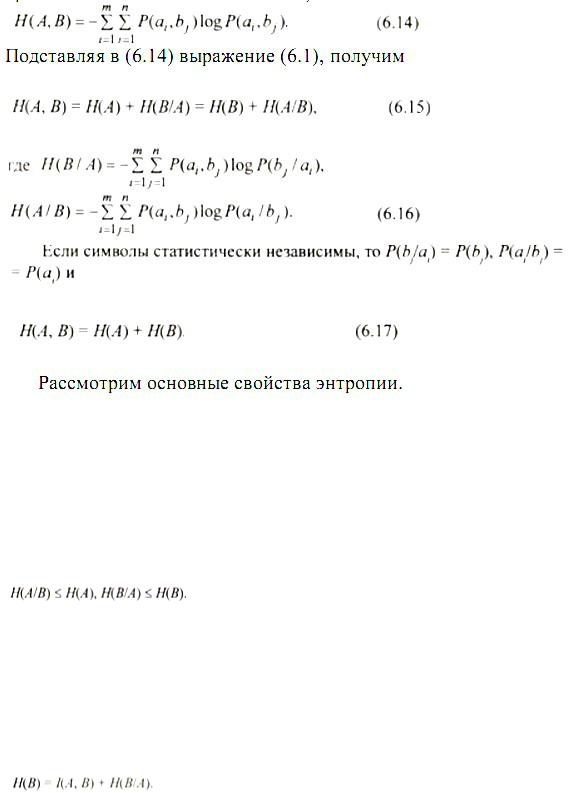

Рассмотрим символы на выходах двух дискретных источников сообщений. Пусть между этими символами имеется статистическая связь, определяемая совместной вероятностью Р(а., Ь). По аналогии с (6.10) определим энтропию множества совместных событий, заключающихся в одновременном появлении символов а., Ь :

1.Энтропия величина вещественная, ограниченная и неотрицательная. Это следует из (6.10).

2.Энтропия равна нулю, если значение символа (сообщения) известно заранее. В

этом случае вероятность одного из символов равна единице, а вероятности остальных символов равны нулю.

3.Энтропия максимальна, если все состояния дискретного источника равновероятны.

4.Условные энтропии

Равенство наблюдается тогда, когда символы а., Ь. статистически независимы. В этом случае P(bja.) = P(b), Р(а/Ь.) = Р(а) для всех индексов i, j.

5.Условная энтропия Н(А/В) = 0, если между символами а., Ь. наблюдается однозначная связь.

6.Энтропия (6.15) двух зависимых источников равна сумме безусловной и условной энтропий.

7.Энтропия двух (6.17) и более независимых источников равна сумме энтропий этих источников.

энтропия на выходе канала связи

Следовательно, при передаче информации по каналу связи с помехами среднее количество информации на выходе канала определяется суммой средней взаимной информации и условной энтропии. Эта добавочная энтропия обусловлена только помехами. При отсутствии пoмех Н(В/А) = 0, Н{В) = 1(А, В). Кроме того, ЩА/В) = 0 и 1(А, В) = Н(А).

Поэтому в этом случае среднее количество информации на выходе канала равно среднему количеству информации на выходе источника дискретных сообщений.

8.Производительность источника дискретных сообщений. Скорость передачи информации.

9. Пропускная способность дискретного канала связи.

Максимальное количество передаваемой информации в единицу времени определяет пропускную способность дискретного канала связи.

При этом из всего множества дискретных источников пропускную способность определяет только такой источник, распределение вероятностей Р(А) которого обеспечивает максимальное значение передаваемой информации.

Пропускная способность

Максимум скорости передачи согласно (6.34) достигается изменением вероятностей состояния источников, т. е. их перебором до тех пор, пока не будет найден источник, распределение вероятностей которого обеспечит этот максимум.

Пропускная способность канала выражается в битах в секунду [бит/с]. Она зависит от энтропии дискретного источника, т. е. от свойств передаваемого сообщения.

Пропускная способность зависит также от условных энтропии Н{А/В), Н(В/А), которые определяются характеристиками дискретного канала связи.

Пропускная способность всегда больше скорости передачи информации по каналу связи.

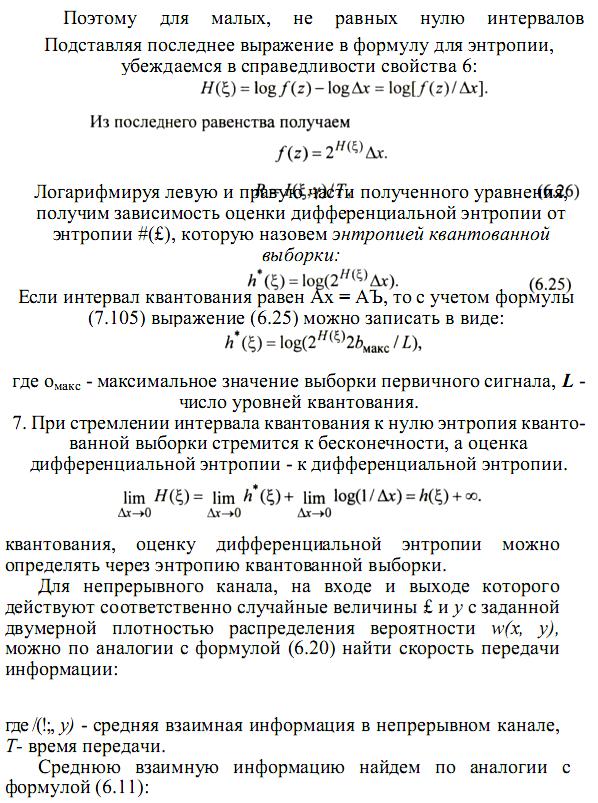

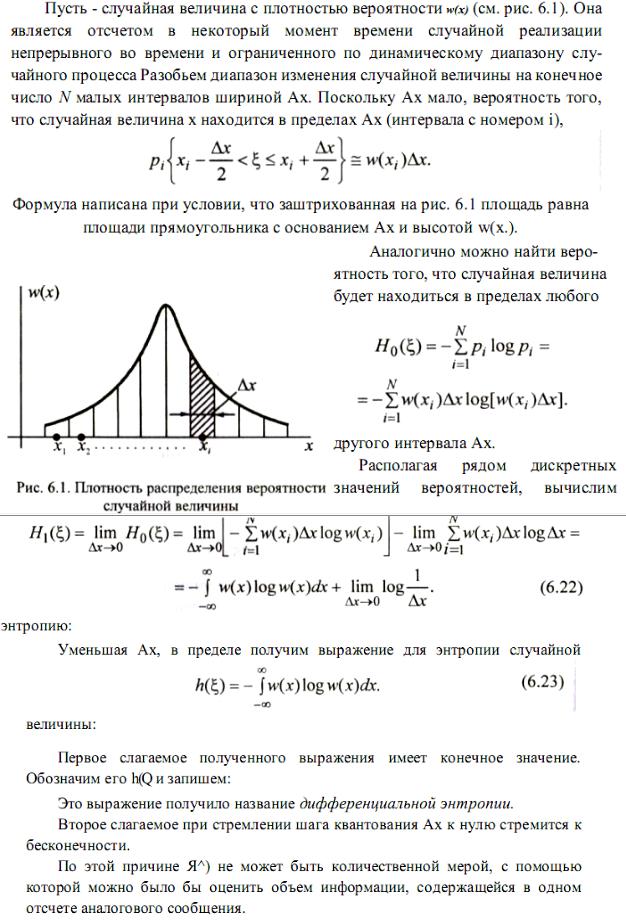

12.Дифференциальная энтропия. Вывод формулы для дифференциальной энтропии. Размерность дифференциальной энтропии.

13.Свойства дифференциальной энтропии.