- •Оглавление

- •Аналитические технологии

- •Формализация нейронных сетей

- •Принцип обучения искусственных нейронных сетей

- •Концепция обучения нейронной сети, предложенная Хэбом

- •Сбор данных для нейронной сети

- •Прикладные возможности нейронных сетей

- •Переобучение и обобщение

- •Персептрон

- •Алгоритм обратного распространения ошибки

- •Сигмоидальный нейрон

- •Нейрон типа «адалайн»

- •Инстар и оутстар Гроссберга

- •Нейрон типа wta (Winner Takes All)

- •08.10.2011 Модель нейрона Хэбба

- •Стохастическая модель нейрона

- •Стохастические алгоритмы обучения

- •Настройка числа нейронов в скрытых слоях многослойных сетей в процессе обучения

- •Алгоритмы сокращения

- •Конструктивные алгоритмы

- •Упрощенные алгоритмы расщепления

- •Радиальная базисная сеть

- •Вероятностные нейронные сети

- •Линейные нейронные сети

- •Обучение

- •Сети с самоорганизацией на основе конкуренции

- •12.11.2011 Модели ассоциативной памяти. Сети Хопфилда

- •Когнитивные карты

- •19.11.2011 Генетические алгоритмы Естественный отбор и генетическое наследование

- •Модель эволюции в природе, реализованная программно

- •Символьная модель простого генетического алгоритма

- •Работа простого генетического алгоритма

- •26.11.2011 Шима (Schema)

- •Применение аналитических технологий

- •03.12.2011

- •Бизнес-приложения

- •Программные реализации аналитических технологий

- •Список литературы

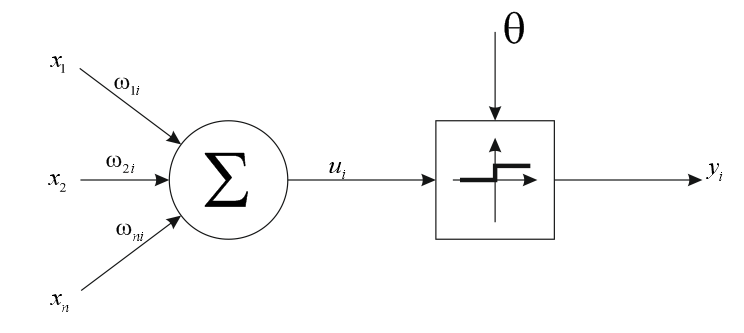

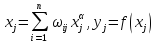

Персептрон

Рисунок 11 Схема персептрона

Простой персептрон – обычная модель МакКоллока-Питса с соответствующей стратегией обучения. Нелинейная функция активации персептрона представляет собой дискретную функцию ступенчатого типа, где выходной сигнал принимает значения 0 либо 1.

Обучение

персептрона требует наличие учителя и

состоит в таком подборе весов, чтобы

выходной сигнал

был наиболее близок к целевому значения

был наиболее близок к целевому значения .

.

Обучение персептрона осуществляется по следующему алгоритму:

При первоначальных наборах значений весов

(случайных)

на вход подаётся обучающий векторx

и рассчитывается значение выходного

сигнала

(случайных)

на вход подаётся обучающий векторx

и рассчитывается значение выходного

сигнала

;

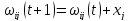

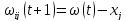

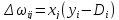

;По результатам сравнения

с заданным значением

с заданным значением уточняется значения весов. Если

уточняется значения весов. Если =0,

а

=0,

а ,

, ;

;Если

,

а

,

а ,

то

,

то ,

, - общий случай корректирующего значения;

- общий случай корректирующего значения;

Персептрон – линейно разделяющая функция.

Персептрон с одним

слоем нейронов способен представлять

ограниченный класс линейно разделимых

образов. Рассмотрим пример применения

персептрона для решения задач дихотомии.

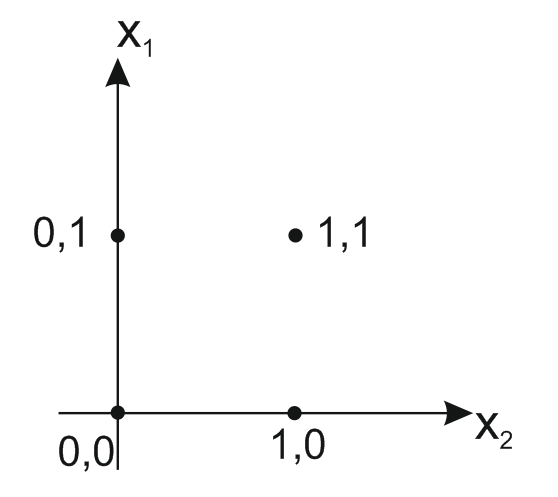

Предположим, что входные сигналы

принимают

двоичные значения (0 или 1). В этом случае

производство входных признаков состоит

из 4-х возможных комбинация.

принимают

двоичные значения (0 или 1). В этом случае

производство входных признаков состоит

из 4-х возможных комбинация.

|

|

|

|

0 |

0 |

|

0 |

1 |

|

1 |

0 |

|

1 |

1 |

Рисунок 12 Возможные комбинации

И может быть

представлена на плоскости. В зависимости

от конкретных значений весов

и

и ,

а так же от значения порога

,

а так же от значения порога уравнение

уравнение будет

определять прямую на плоскости,

разбивающую плоскость признаков на две

части, соответствующие двум классам

выходных образов.

будет

определять прямую на плоскости,

разбивающую плоскость признаков на две

части, соответствующие двум классам

выходных образов.

Отсюда следует, что возможности персептрона ограничены классом линейно разделимых образов. Так, персептрон не может реализовать функцию исключающего или, т.к. (0,0) и (1,1) не могут находиться по одну сторону прямой.

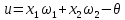

Многослойный

персептрон:

Рисунок 13 Схема многослойного персептрона

24.09.2011

Алгоритм обратного распространения ошибки

Начальные значения весов всей нейронов всех слоев полагаются случайными величинами;

На вход подается вх. образ

.

На выходе формируются

.

На выходе формируются .

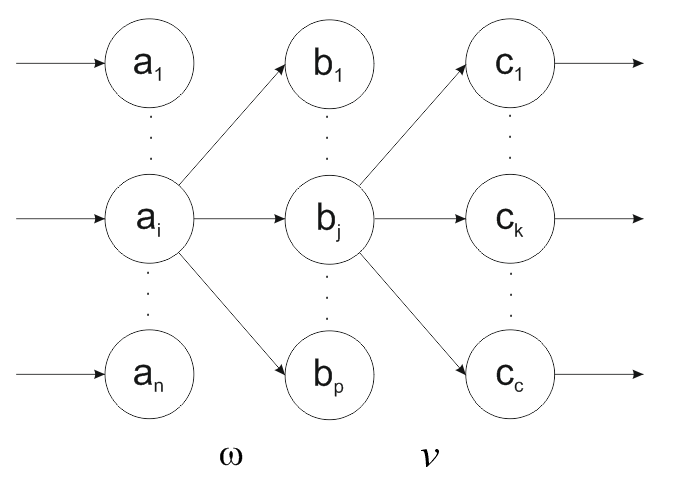

Нейроны последовательно от слоя к слою

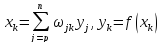

функционируют по следующим формулам:

.

Нейроны последовательно от слоя к слою

функционируют по следующим формулам:

- выходной сигнал

скрытого слоя

- выходной сигнал

скрытого слоя

- выходной сигнал,

- выходной сигнал,

- сигмоидальная функция.

- сигмоидальная функция.

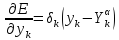

- функция ошибки;

- функция ошибки;

Градиентный метод оптимизации состоит в итерационном уточнении аргумента согласно формуле:

Функция ошибки Е

в явном виде не содержит зависимости

от

.

Поэтому воспользуемся формулой неявного

дифференцирования сложной функции:

.

Поэтому воспользуемся формулой неявного

дифференцирования сложной функции:

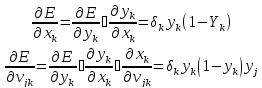

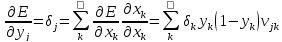

Выполняется подстройка весов открытого слоя:

При

вычислении

был

применен принцип обратного распространения

ошибки, т.е. частные производные берутся

только по переменным последующего слоя.

По полученным формулами модифицируется

веса нейронов скрытого слоя. Если скрытых

слоев несколько, то процедура обратного

распространения последовательно

применяется для каждого из них, начиная

со слоя, предшествующего выходному до

слоя, стоящего за входным.

был

применен принцип обратного распространения

ошибки, т.е. частные производные берутся

только по переменным последующего слоя.

По полученным формулами модифицируется

веса нейронов скрытого слоя. Если скрытых

слоев несколько, то процедура обратного

распространения последовательно

применяется для каждого из них, начиная

со слоя, предшествующего выходному до

слоя, стоящего за входным.

Шаги 1-3 повторяются для всех обучающих векторов. Общение завершается по достижении малой полной ошибки или максимально допустимого числа итераций.

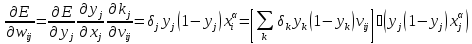

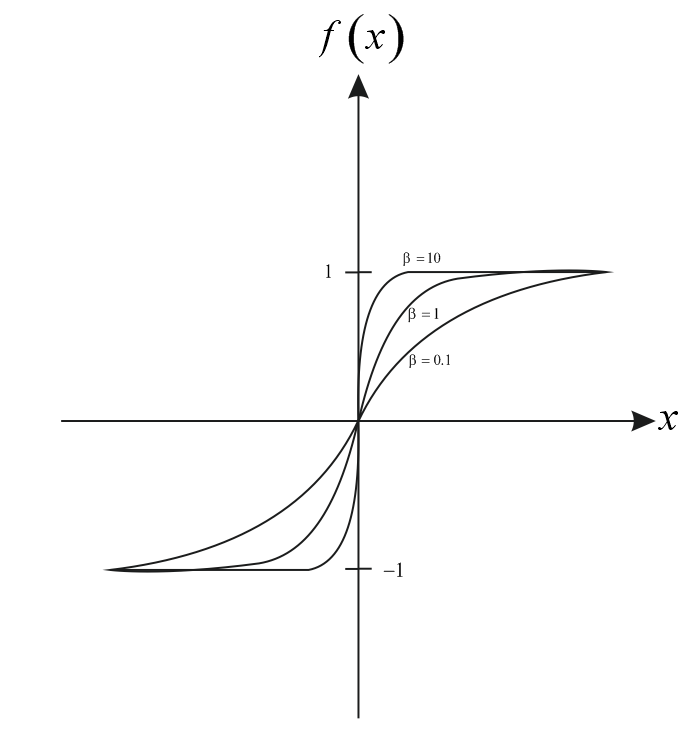

Сигмоидальный нейрон

Рисунок 14 Сигмоидальный нейрон

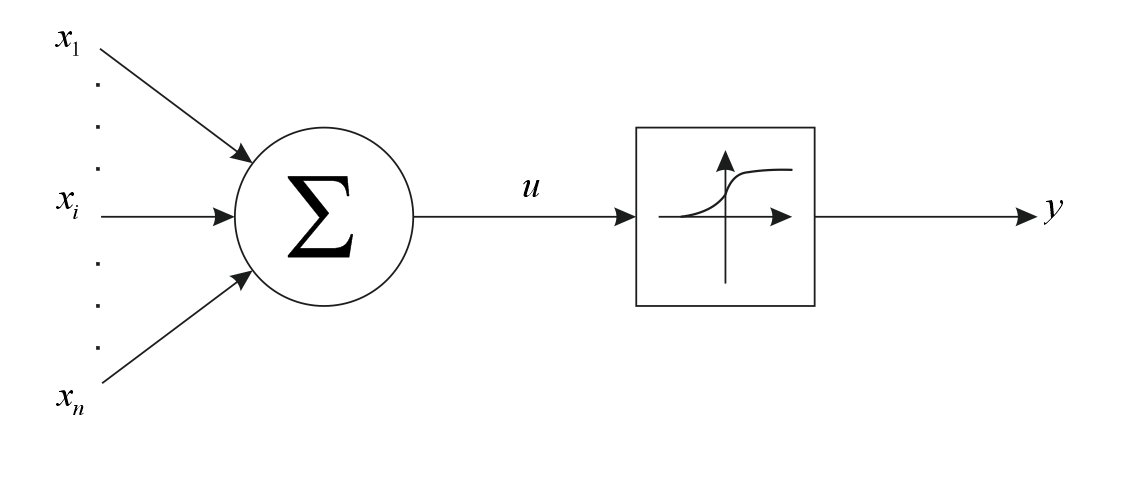

Нейрон сигмоидального типа имеет структуру, подобную модели МаКаллека-Питса с той разницей, что функция активации может быть выражена сигмоидальной, униполярной и биполярной функциями.

- унимодальная

функция

- унимодальная

функция

- биполярная функция

- биполярная функция

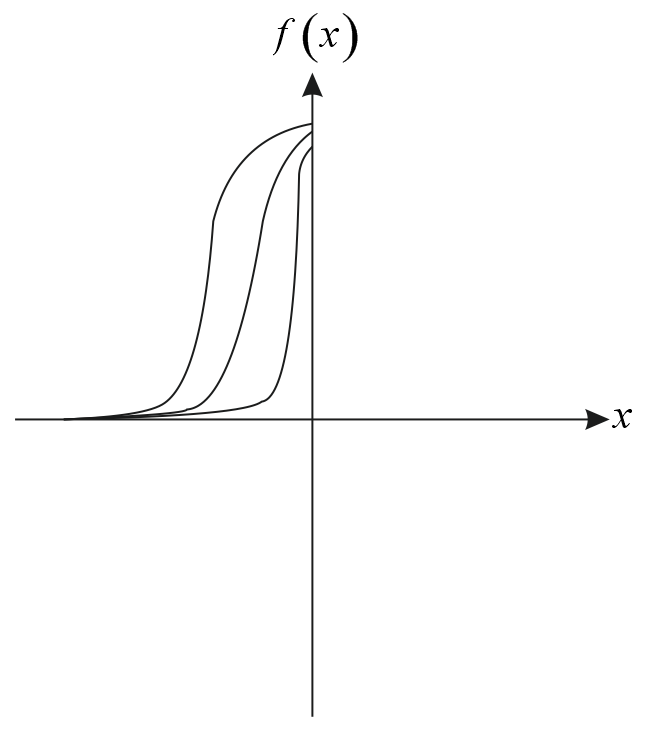

Рисунок 15 Униполярная функция

Рисунок 16 Биполярная функция

Параметр

выбирается пользователем. Его значения

влияет на форму функции активации.

При

выбирается пользователем. Его значения

влияет на форму функции активации.

При функция

превращается в ступенчатую функцию,

идентичную функции активации персептрона.

Чаще всего используется

функция

превращается в ступенчатую функцию,

идентичную функции активации персептрона.

Чаще всего используется .

.

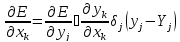

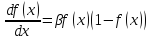

Важным свойством сигмоидальной функции является её дифференцируемость:

- униполярная

- униполярная

- биполярная

- биполярная

Рисунок 17 График производной

Сигмоидальный нейрон обучается с учителем по принципу минимизации целевой функции.