9.5. КОДИРОВАНИЕ ПРИ НАЛИЧИИ ШУМОВ

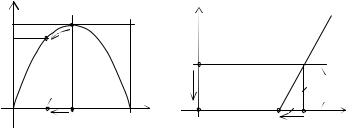

Подведем некоторые итоги. Была введена модель канала передачи информации. Под скоростью передачи информации понимаем среднее количество информации, приходящееся на один канальный символ. Обозначим скорость передачи информации через R H (X ;Y ) H (X ) H (X /Y ) . Очевидно, что R H (X ) , ибо

нельзя принять больше информации, чем посылается.

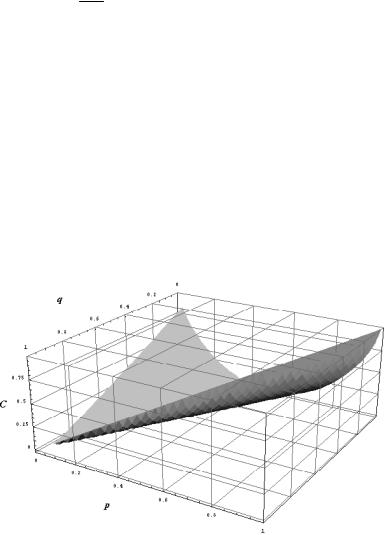

Под пропускной способностью канала C max H ( X ;Y ) по-

{ p( xk )}

нимается максимальное среднее значение информации на символ, которое можно передать по данному каналу. Пропускную способность канала при передаче можно достичь надлежащим выбором источника информации и соответствующим выбором метода кодирования.

Ненадежность передачи по каналу определяется как H (X /Y ) H (X ) R и соответствует неопределенности, которая

имеется на приемном конце по отношению к переданному сообщению после оценки принятого сигнала. Ненадежность удовлетворяет соотношению 0 H ( X / Y ) H (X ) .

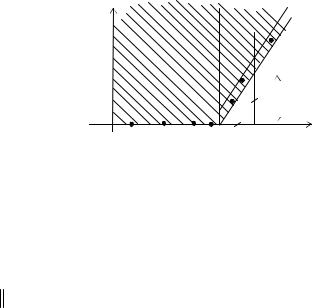

ТЕОРЕМА 9.4 (основная теорема Шеннона). Если дискретный источник создает сообщения со скоростью H ( X ) и если

H ( X ) C , то существует такая система кодирования, что сооб-

щения источника могут быть переданы по каналу с произвольно малой ненадежностью. Если H (X ) C , то можно закодировать

сообщения таким образом, что ненадежность передачи по каналу станет меньше, чем H (X ) C где 0 сколь угодно мало, и

не существует способа кодирования, обеспечивающего ненадежность передачи, меньше чем H (X ) C .

Примем теорему без доказательства, но дадим ее более подробную интерпретацию. Итак, теорема утверждает справедливость

неравенств H C H(X /Y) H(X ) C . Существование

вполне определенной пропускной способности для канала с шумом на первый взгляд кажется нереальным. Однако ясно, что можно уменьшить вероятность ошибки, посылая информацию в избыточной форме. Так, например, многократно повторяя передачу сооб-