2

.pdf

72 Розділ 1. Нейронні мережі: означення та основні властивості

нейронами шару F1 та шару F2 існують двонаправлені зв’язки. Механізм літерального гальмування також потребує внутрішніх зв’язків між нейронами шару F2 .

Рис.1.25. Нейронна мережа типу ART.

Особливістю мереж типу ART є наявність елементів глобального управління, які реалізують алгоритм функціонування нейронної мережі. Вузли G1 і G2 керують

активністю відповідних шарів нейронів, а R забезпечує виконання операції початкової установки.

Введемо позначення: n ― кількість нейронів порівняльного шару; m ― кількість нейронів розпізнавального шару;

W ― множина вагових коефіцієнтів зв’язку між нейронами шару F1 та F2 ; r ― величина порога подібності.

Розділ 1. Нейронні мережі: означення та основні властивості |

73 |

|||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

|

Після |

надходження |

на |

вхід |

вектора |

сигналів |

X , |

|||||||||||||||||

(xi { 0,1}, i = 1,2,...,n), |

нейронна |

|

мережа |

формує |

значення |

|||||||||||||||||||

прямої активації Tj на виході шару F2 за формулою: |

|

|

||||||||||||||||||||||

|

|

|

|

|

Tj = |

|

w j |

∩ X |

|

, |

j = 1,...,m , |

(1.52) |

||||||||||||

|

|

|

|

|

|

|

||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||||

|

|

|

|

|

|

β + |

|

w j |

|

|||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

де w j = (w1j ,w2 j ,...,wij,...,wnj ); |

|

|

|

. |

|

― оператор норми |

|

|

||||||||||||||||

|

|

|

|

|

||||||||||||||||||||

|

|

m |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

u |

= ∑u j ; β > 0 ― параметр вибору. |

|

|

|

|

|

|||||||||||||||||

|

|

j=1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Після цього запускається внутрішній ітераційний процес |

|||||||||||||||||||||||

літерального гальмування: |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1 |

|

|

|

|

|

|

||

|

|

|

T |

|

(τ +1)= f T |

|

(τ )− |

|

|

m T (τ ) |

(1.53) |

|||||||||||||

|

|

|

j |

j |

|

|

|

|||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

m −1 |

∑ i |

|

|

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

i=1 |

|

|

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

i≠ j |

|

|

|

|

||

де τ ― порядковий номер внутрішньої ітерації. |

|

|

|

|||||||||||||||||||||

|

Результатом цього процесу є вибір нейрона |

j |

з максимальною |

|||||||||||||||||||||

активністю, і тому вектор сигналів зворотного зв’язку TJ містить тільки один відмінний від нуля елемент:

TJ = max{Tj j =1,2,...,m} .

На цьому закінчується початкова фаза аналізу вхідного вектора. Наступна робоча фаза починається з операції порівняння на першому шарі нейронів. Вектор вагових коефіцієнтів w j нейрона j порівнюється з вектором X :

|

w j ∩ X |

|

≥ r . |

(1.54) |

||

|

|

X |

|

|

||

|

|

|

|

|||

|

|

|

|

|

||

|

|

|

|

|

|

|

Якщо нерівність (1.54) виконується, то цей факт свідчить про те, що знайдено прототип, який перевищує поріг подібності. Для того, щоб уточнити параметри знайденого прототипу,

74 Розділ 1. Нейронні мережі: означення та основні властивості

виконують процедуру корекції відповідних вагових коефіцієнтів за формулою:

w j (t +1)=η [w j (t)∩ X] + (1−η)w j (t), |

(1.55) |

де t ― номер кроку навчання; η ― коефіцієнт |

навчання |

η [0,1] . Якщо нерівність (1.54) не виконується, то це свідчить

про відсутність відповідного прототипу для вхідного образу. У цьому випадку вузлом R активується сигнал початкової установки для вузла j , що вилучає його з подальшої роботи.

Після цього цикл пошуку прототипу повторюється без участі нейрона, який був переможцем у попередньому циклі.

Якщо після гальмування всіх нейронів шару F2 не буде

знайдений образ, що відповідав би вхідному вектору, то даний вхідний вектор вважається новим. Під нього виділяється невикористаний нейрон шару F2 з відповідною модифікацією

матриці вагових коефіцієнтів W .

Як видно з опису, нейронна мережа ART-1 здатна працювати тільки з бінарними вхідними сигналами. Розширення сфери представлення вхідного образу досягається в подальших версіях ART-2 та ART-3. Особливістю роботи з аналоговими сигналами є необхідність використовування більш точних засобів порівняння векторів даних, оскільки відстань між порівнюваними векторами в аналоговому просторі може бути як завгодно малою. Для підвищення розпізнавальних властивостей застосовують багатошарову архітектуру з послідовним уточненням відмінностей на кожному з шарів. Така архітектура підвищує розпізнавальні властивості ART-мереж, але залишає неподоланим основний недолік, який полягає в концентрації пам’яті про конкретний прототип лише в одному нейроні. Така властивість не відповідає біологічній пам’яті, яка розподілена між багатьма нейронами.

( ) a при a > 0, f a = ≤

0 при a 0.

Значення вагових коефіцієнтів задають, виходячи з виразу:

− d |

при i ≠ j, |

|

|

wij = |

при |

i = j. |

(1.57) |

1 |

|

||

76 Розділ 1. Нейронні мережі: означення та основні властивості

Рис.1.27. Мережа MAXNET.

З метою визначення нейрона-переможця застосовують ітераційний процес, який продовжується до виконання умови закінчення алгоритму:

|

|

|

|

|

a j (τ +1) = f a j (τ )− d ∑ak (τ ) |

, де j = 1,...,m. |

(1.58) |

||

|

k≠ j |

|

|

|

|

|

|

|

|

Умовою його закінчення є нульове значення на виході всіх нейронів, крім одного.

1.4.4.3. Ієрархічні мережі типу ART

Подальший розвиток нейронних мереж типу ART привів до побудови модульних структур, кожен з модулів у яких є тривіальною мережею ART. Відомі структури з послідовним з’єднанням модулів [109,31,32], які отримали назву ієрархічних ART-мереж. В залежності від структури міжмодульних зв’язків розрізняють дві моделі ієрархічних ART-мереж: об’єднуючі (ARTО) та розділяючі (ARTR). Ієрархічні мережі реалізують процес розпізнавання вхідних образів шляхом формування ієрархії кластерів. Для ARTО-мереж величина порога подібності r обернено пропорційна до номера модуля. Тому перший модуль завжди формує потенційно велику кількість кластерів, що узагальнюються в наступних модулях. Оберненою до даної є стратегія ARTR-мереж. Для них величина порога новизни

Розділ 1. Нейронні мережі: означення та основні властивості 77

збільшується пропорційно до номера модуля, що призводить до формування спочатку найбільш загальних кластерів з подальшим їх уточненням в наступних модулях.

Формально ієрархічні ART-мережі задають кортежем параметрів

I = (k,n,m, β,r,η) , |

(1.59) |

де значення параметрів визначаються наступним чином: k ― кількість модулів;

n = ( n1,n2 ,...,nk ) ― кількість нейронів у шарах F0 та F1 ; m = (m1,m2 ,...,mk )― кількість нейронів у шарі F2 ;

β = (β1,β2 ,...,βi ,...,βk ), 0 < βi <1― параметри вибору; r = (r1,r2 ,...,rk )― пороги подібності;

η = (η1,η2 ,...,ηk )― коефіцієнти навчання.

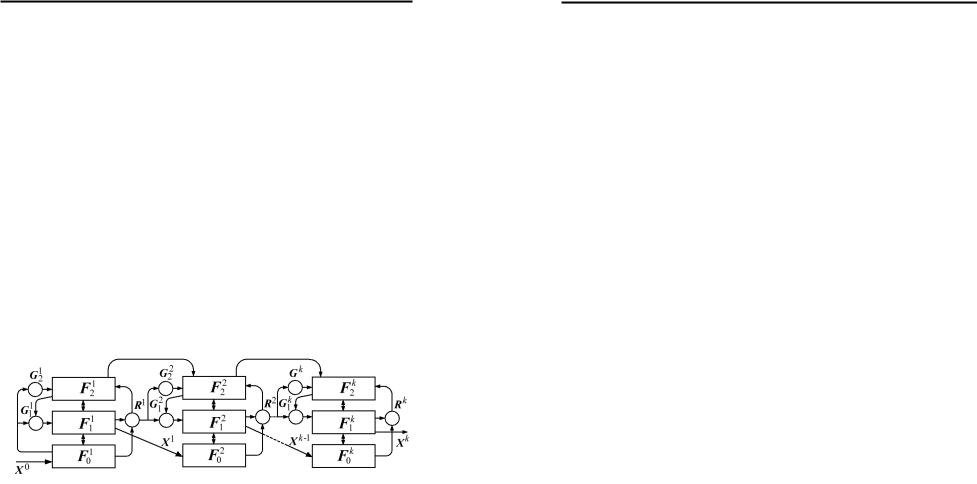

ARTО-мережа, що складається з k послідовно з’єднаних модулів, показана на рис.1.28.

Рис.1.28. Нейронна мережа типу ARTО.

Локальні дані, виходячи з принципів роботи ART-мережі, надходять на вхід модуля з номером 1 < l ≤ k і визначаються у відповідності до виразу:

Xl = Xl−1 ∩ w |

l−1,J |

, |

(1.60) |

|

|

|

78 Розділ 1. Нейронні мережі: означення та основні властивості

де wl−1,J ― вектор вагових коефіцієнтів нейрона-переможця

шару Fl−1 . |

|

|

|

|

|

|

|

|

|

|

|

2 |

|

|

|

|

|

|

|

|

|

|

|

В модулі l |

корекція знайденого |

прототипу |

відбувається |

||||||||

згідно з формулою (1.55). Тому при η = 1 одержуємо |

|

|

|||||||||

|

|

w |

|

= Xl ∩ w |

l,J |

. |

|

|

|

(1.61) |

|

|

|

l,J |

|

|

|

|

|

|

|

||

Поширюючи |

залежності |

|

(1.60) |

та |

(1.61) |

|

|

на |

модулі |

||

l −1, l − 2,...,2 , одержимо |

|

|

|

|

|

|

|

|

|

||

|

w |

= X1 |

∩ w |

∩ w |

2,J |

∩...∩ w |

l,J |

, |

(1.62) |

||

|

l,J |

|

|

1,J |

|

|

|

|

|||

де J ― номер нейрона-переможця у модулі l . |

|

|

|

|

|||||||

З (1.61) та (1.62) одержуємо |

|

|

|

|

|

|

|

|

|||

|

|

wl,J = wl−1,J ∩ wl,J , |

|

|

|

(1.63) |

|||||

тобто ARTО-мережа формує узагальнені ієрархічні категорії на більш високих рівнях.

Протилежні функції виконує розподільна ієрархічна ARTRмережа, зображена на рис.1.29.

Рис.1.29. Нейронна мережа типу ARTR.

В такій мережі тільки відмінність між вхідним образом та його прототипом передається на наступний модуль ієрархічної структури. Зв’язки між модулями забезпечують чотири множини з’єднань, принципово новою з яких є множина V . Асоціативне з’єднання V , що має назву ієрархічної пам’яті, призначене для встановлення зв’язків між кластером та його одночасно

Розділ 1. Нейронні мережі: означення та основні властивості 79

існуючими на мережі підкластерами. Якщо в першому модулі активований кластер, то в наступних модулях можуть бути активовані тільки підкластери даного кластера.

Локальний вхід модуля l визначається відповідно до виразу:

X l = X l−1 − X l−1 ∩ wl−1,J , l = 2,...,k . |

(1.64) |

Виходячи з того, що ми розглядаємо дискретне представлення

вхідного образу та прототипу, (1.64) запишемо у вигляді: |

|

||||||||||||||

|

|

X l = X l−1 ∩ |

|

l−1,J , |

|

(1.65) |

|||||||||

w |

|

||||||||||||||

де wl−1,J є логічним запереченням |

wl−1,J |

. Після рекурсивного |

|||||||||||||

застосування (1.65) до шарів |

l,l −1,...,2 |

одержимо вираз для |

|||||||||||||

вхідного образу шару l +1: |

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

X l+1 = X1 ∩ |

|

1,J |

∩ ...∩ |

|

|

l,J |

= |

|

|||||

|

|

w |

w |

(1.66) |

|||||||||||

|

|

= X1 ∩ |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

( w |

|

... w |

l,J |

|

) |

l =1,...,k. |

|

||||||

|

|

|

1,J |

|

|

|

|

|

|

|

|

|

|

|

|

Позначимо глобальний прототип категорії J |

на рівні |

l як |

|||||||||||||

Wl,J . Тоді: |

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

Wl,J = w1 w2 ... wk , l = 1,...,k . |

(1.67) |

||||||||||||

Отже, у випадку ARTR-мережі, глобальний прототип є розділеним між її модулями, кожен з яких забезпечує формування підкластера на своєму ієрархічному рівні.