5. Этап опытной эксплуатации

На этом этапе проверяется пригодность ЭС для конечного пользователя. Пригодность ЭС для пользователя определяется в основном удобством работы с ней и ее полезностью. Под полезностью ЭС понимается ее способность в ходе диалога определять потребности пользователя, выявлять и устранять причины неудач в работе, а также удовлетворять указанные потребности пользователя (решать поставленные задачи). В свою очередь, удобство работы с ЭС подразумевает естественность взаимодействия с ней (общение в привычном, не утомляющем пользователя виде), гибкость ЭС (способность системы настраиваться на различных пользователей, а также учитывать изменения в квалификации одного и того же пользователя) и устойчивость системы к ошибкам (способность не выходить из строя при ошибочных действиях неопытного пользователях).

В ходе разработки ЭС почти всегда осуществляется ее модификация. Выделяют следующие виды модификации системы: переформулирование понятий и требований, переконструирование представления знаний в системе и усовершенствование прототипа. Экспертные системы, параллельные и последовательные решения.

Как мы можем заметить, в большинстве алгоритмов распознавания образов подразумевается, что к началу работы алгоритма уже известна вся входная информация, которая перерабатывается параллельно. Однако ее получение зачастую требует определенных усилий. Да и наши наблюдения за реальными экспертами подтверждают, что зачастую они задают два-три вопроса, после чего делают правильные выводы. Представьте себе, если бы врач (эксперт в области медицины) перед постановкой диагноза "ангина" заставлял бы пациента пройти полное обследование вплоть до кулоноскопии и пункции позвоночника.

Соответственно большинство алгоритмов модифицируются, чтобы обеспечить выполнение следующих условий:

алгоритмы должны работать в условиях неполной информации (последовательно);

последовательность запроса информации должна быть оптимальна по критериям быстроты получения результата и (или) наименьшей трудоемкости (болезненности, стоимости и т.д.) получения этой информации.

Одной из возможных стратегий для оптимизирования запросов является стратегия получения в первую очередь той информации, которая подтверждает либо опровергает наиболее вероятный на текущий момент результат. Другими словами мы пытаемся подтвердить или опровергнуть наши догадки (обратный вывод)

6. Прототип и жизненный цикл экспертной системы

При разработке практически всех инструментальных средств за основу принимается методология автоматизации проектирования на базе использования прототипов. По отношению к программному обеспечению термин прототип означает "работающую модель программы, которая функционально эквивалентна подмножеству конечного продукта". Идея состоит в том, чтобы на ранней стадии работы над проектом разработать упрощенную версию конечной программы, которая могла бы послужить доказательством продуктивности основных идей, положенных в основание проекта. Прототип должен быть способен решать какую-либо из нетривиальных задач, характерных для заданной области применения. На основе анализа опыта работы с прототипом разработчики могут уточнить требования к системе в целом и ее Основным функциональным характеристикам. Работоспособность прототипа может послужить очевидным доказательством возможности решения проблем с помощью создаваемой системы еще до того, как на ее разработку будут потрачены значительные средства.

После всестороннего анализа прототип откладывается в сторону и начинается разработка рабочей версии программы, которая должна решать весь комплекс задач, определенных в спецификации проекта. Процесс разработки экспертной системы, как правило, состоит из последовательности отдельных этапов, на которых наращиваются возможности системы, причем каждый из этапов подразделяется на фазы проектирования, реализации, компоновки и тестирования. В результате после каждого этапа наращивания возможностей в распоряжении пользователя имеется система, которая способна справляться со все более сложными вариантами проблемы.

Такая методика проектирования несколько отличается от методики разработки программ других видов. При создании большинства программных продуктов чаще используется другая модель процесса- сначала разрабатывается спецификация продукта, затем выполняется планирование, проектирование компонентов, их реализация, компоновка комплекса и тестирование конечного варианта. Тот факт, что при разработке экспертных систем есть возможность сначала построить и всесторонне испытать прототип, позволяет избежать множества переделок в процессе создания рабочей версии системы. Но технология последовательного наращивания функциональных возможностей таит в себе и проблему интеграции новых функций с реализованными в предыдущих вариантах. Инструментальные средства разработки экспертных систем и создавались, в первую очередь, с целью преодоления возникающих при этом сложностей на основе модульного представления знаний.

При неудовлетворительном функционировании прототипа эксперт и инженер по знаниям имеют возможность оценить, что именно будет включено в разработку окончательного варианта системы.

Если первоначально выбранные объекты или свойства оказываются неподходящими, их необходимо изменить. Можно сделать оценку общего числа эвристических правил, необходимых для создания окончательного варианта экспертной системы. Иногда при разработке промышленной системы выделяют дополнительные этапы: демонстрационный прототип; исследовательский прототип; действующий прототип; промышленная система.

Однако чаще реализуется плавный переход от демонстрационного прототипа к промышленной системе, при этом, если программный инструментарий выбран удачно, необязательна перепись другими программными средствами.

Понятие же коммерческой системы в нашей стране входит в понятие промышленный программный продукт, или промышленной ЭС в этой работе.

Переход от прототипа к промышленной экспертной системе.

Демонстрационный прототип ЭС. Система решает часть задач, демонстрируя неспособность подхода (несколько десятков правил или понятий)

Исследовательский прототип. ЭС Система решает большинство задач, но не устойчива в работе и не полностью проверена [несколько сотен правил или понятий). Действующий прототип ЭС. Система надежно решает все задачи на реальных примерах, но для сложной задачи требует много времени и памяти.

Промышленная система. Система обеспечивает высокое качество решений при минимизации требуемого времени и памяти: переписывается с использованием более эффективных средств представления знаний. Коммерческая система Промышленная система, пригодная к продаже, т.е. хорошо документирована и снабжена сервисом

Основное на этом этапе заключается в добавлении большого числа дополнительных эвристик. Эти эвристики обычно увеличивают глубину системы, обеспечивая большее число правил для трудноуловимых аспектов отдельных случаев. В то же время эксперт и инженер по знаниям могут расширить охват системы, включая правила, управляющие дополнительными подзадачами или дополнительными аспектами экспертной задачи (метазнания).

После установления основной структуры ЭС инженер по знаниям приступает к разработке и адаптации интерфейсов, с помощью которых система будет общаться с пользователем и экспертом. Необходимо обратить особое внимание на языковые возможности интерфейсов, их простоту и удобство для управления работой ЭС. Система должна обеспечивать пользователю возможность легким и естественным образом спрашивать непонятное, приостанавливать работу и т.д. В частности, могут оказаться полезными графические представления.

Жизненный цикл экспертной системы состоит из этапов разработки и сопровождения. На этапе разработки создается программное обеспечение и база знаний экспертной системы, на этапе сопровождения происходит исправление выявленных ошибок и пополнение базы знаний без участия разработчиков (если последнее допускается архитектурой экспертной системы).

Применение экспертной системы с базой знаний, неизменяемой в процессе эксплуатации, возможно при достаточно стабильной в течение длительного времени предметной области, в которой решаются задачи. Примерами таких предметных областей являются разделы математического анализа, описание правил диагностики различных заболеваний.

Примерами областей применения, требующих гибкости со стороны создания и пополнения базы знаний, являются: планирование производства, проектирование и диагностика в области электроники, вычислительной техники и машиностроения.

Лекция 11. Автоматическое рассуждение. Основные механизмы дедукции (логического вывода)

Заставить машину выполнять простой процесс рассуждений несложно. Эта способность составляет ядро большинства ЭС. В целом знания ЭС должны быть введены в форме правил для того, чтобы могли быть реализованы процессы автоматического рассуждения. Как уже говорилось выше, та часть программы, которая применяет правила, а затем управляет рассуждениями, получила название механизма вывода.

Логический вывод - центральное понятие в ЭС. Оно имеет два аспекта: 1) использование рассуждений для нахождения различных предположений, которые обусловлены имеющимися фактами и правилами, или 2) для изучения заключений, которые представляют интерес и могут быть истинными. Первый метод носит название прямой цепочки рассуждений, второй - обратной цепочки рассуждений. Почти все экспертные системы построены либо на первом, либо на втором методе.

Прямая цепочка рассуждений предполагает использование правил для дудукции (логического вывода) новых фактов, а также фактов, которые существовали и ранее, но могут быть сделаны явными посредством применения правил. Механизм вывода циклически просматривает все правила, исследуя их по очереди выясняя, является ли информация на левой стороне истинной. Если она истинна, механизм вывода добавляет факт на правой стороне правила к хранимым истинным фактам. Затем он переходит к следующему правилу, и процесс повторяется. Проверив все правила, механизм начинает работу заново. Т.о. механизм вывода работает для пополнения изначального запаса истинных фактов фактами, которые подразумеваются посредством набора правил.

Однако, в системе с реальным числом правил имеется столь много подразумеваемых (скрытых) фактов, что, будучи обнаружены, они затмят те несколько фактов, которые действительно представляют интерес и являются полезными. В подобных случаях система должна иметь дополнительный механизм (в зависимости от проблемы) для того, чтобы определить, с каким следующим правилом ей предстоит работать. Вместо простого цикла, который механически выбирает правила, механизм выбора четко устанавливает приоритет выбора тех или иных фактов и правил. ЭС на базе прямой цепочки рассуждений чаще всего применяют в планировании или проектировании.

Пример прямой цепочки рассуждений.

Для ЭС фондовой биржи можно было бы воспользоваться, например, такими правилами:

ЕСЛИ ПРОЦЕНТНЫЕ СТАВКИ - ПАДАЮТ, ТО УРОВЕНЬ ЦЕН НА БИРЖЕ - РАСТЕТ

ЕСЛИ ПРОЦЕНТНЫЕ СТАВКИ - РАСТУТ, ТО УРОВЕНЬ ЦЕН НА БИРЖЕ - ПАДАЕТ

ЕСЛИ ВАЛЮТНЫЙ КУРС ДОЛЛАРА - ПАДАЕТ, ТО ПРОЦЕНТНЫЕ СТАВКИ - РАСТУТ

ЕСЛИ ВАЛЮТНЫЙ КУРС ДОЛЛАРА - РАСТЕТ, ТО ПРОЦЕНТНЫЕ СТАВКИ - ПАДАЮТ

Предположим, что создана фирма, дающая на основе этих правил консультации в области биржевых операций. Клиент сообщил, что валютный курс доллара падает по отношению к основным валютам других стран, и попросил совета Цель заключается в выборе правильного поведения на бирже, но останется ли клиент в выигрыше, зависит от пока еще не определенных условий.

Для нашего примера необходимо, чтобы в условной части какого-либо правила содержалось бы условие ВАЛЮТНЫЙ КУРС ДОЛЛАРА ПАДАЕТ. Такое условие содержится в правиле 3. В соответствии с этим правилом можно сделать вывод о росте процентных ставок. Но о валютном курсе упоминается еще в правиле 4, но условие, записанное в этом правиле, не соответствует исходному состоянию падения курса доллара, и поэтому правило 4 в дальнейших рассуждениях не будет участвовать. Правило 3, в свою очередь, порождает новую ситуацию: ПРОЦЕНТНЫЕ СТАВКИ - РАСТУТ. Необходимо проверить, не приведет ли она к другим выводам. Видно, что в правиле 1 подходящего условия нет, а в правиле 2 есть. Возникает новая ситуация: УРОВЕНЬ ЦЕН НА БИРЖЕ - ПАДАЕТ и рассуждения продолжаются.

Еще раз выполняется проверка всех правил, но ни в одном правиле в условной части не упоминается уровень цен на бирже, и на этом рассуждения заканчиваются. Клиенту можно сказать следующее: когда обменный курс доллара падает, растут процентные ставки и уровень цен на бирже падает.

Рассмотренный пример иллюстрирует работу типичной системы прямых рассуждений:

Система содержит описание ряда ситуаций.

Для каждой ситуации система ищет в базе знаний правила, в условной части которых содержится соответствующее условие.

В соответствии с констатирующей частью (частью ТО) каждое правило может генерировать новые ситуации, которые добавляются к уже существующим.

Система обрабатывает каждую вновь сгенерированную ситуацию. При наличии хотя бы одной такой ситуации выполняются действия, начиная с пункта 2. Рассуждения заканчиваются, когда нет больше необработанных ситуаций.

Обратная цепочка рассуждений. Обратной цепочка рассуждений называется потому, что начинается с уже происшедшего события и идет к его истокам. Программные средства, работающие по принципу обратной цепочки рассуждений, предназначены для поиска причин по уже известному результату. Цепочка выполняется с помощью серии вопросов, которые система ИИ задает человеку. Система, реализующая прямую цепочку рассуждений, на основании имеющихся условий делает возможные логические выводы; система, реализующая обратную цепочку рассуждений по имеющимся выводам, ищет необходимые для них условия.

Разработка ЭС, в которой реализуется обратная цепочка рассуждений.

Задача: к директору крупной технической фирмы пришел посетитель, желающий устроится на работу. Директор располагает сведениями о его квалификации, о потребностях фирмы в специалистах и общем положении дел в фирме. Ему нужно решить, какую должность в фирме может занять посетитель.

На первый взгляд задача не очень сложная, но на решение директора влияет много факторов. Например, претендент работает в данной области недавно, но уже сделал важное открытие или он закончил учебное заведение с посредственными оценками, но несколько лет работал по специальности. В данной ситуации люди ведут себя по-разному, и хотя для того, чтобы получить работу необходимо, удовлетворять определенным критериям, в биографии претендента могут быть самые различные факты, анализ которых поможет подобрать для него соответствующую должность.

Поскольку в задаче надо выбрать один из нескольких возможных вариантов (должностей), для ее решения можно воспользоваться обратной цепочкой рассуждений. В действительности ответ уже существует. Перед директором сидит человек и всеми силами старается произвести на него хорошее впечатление. Если директора этот человек устраивает, для него нужно подобрать подходящую должность. Директору необходимо задать посетителю такие вопросы, ответы на которые дают возможность сделать правильный выбор.

Задача поставлена. Теперь нужно ее наглядно представить. Для описания подобных задач обычно используются диаграммы, которые называются деревьями решений. Деревья решений дают необходимую наглядность и позволяют проследить ход рассуждений.

Диаграммы называются деревьями решений потому, что, подобно настоящему дереву, имеют ветви. Ветви деревьев решений заканчиваются выводами. Для нашего примера вывод заключается в том, предложит ли директор должность поступающему на работу, и если да, то какую. Многие задачи сложны, и их непросто представить. Дерево решений помогает преодолеть эти трудности.

На рис.19 показано дерево решений для примера с приемом на работу. Видно, что диаграмма состоит из кружков и прямоугольников, которые называются вершинами. Каждой вершине присваивается номер. На вершины можно ссылаться по этим номерам. Линии, соединяющие вершины, называются дугами или ветвями. Кружки, содержащие вопросы, называются вершинами решений. Прямоугольники содержат цели диаграммы и означают логические выводы. Линии показывают направление диаграммы. Многие вершины имеют несколько ветвей, связывающих их с другими вершинами. Выбор выходящей из вершины ветви определяется проверкой условия, содержащегося в вершине. Например, вершина 5 содержит вопрос, на который есть два возможных ответа, и поэтому у нее два пути в зависимости от среднего балла посетителя за время учебы, т.е. возможен выбор одной из двух ветвей.

-

Посетителю

Посетителюотказать

9

<2 <2

Предложить посетителю

Должность инженера по

эксплуатации?

10

<3.5

<3.5

-

Посетителю

Посетителюотказать

2

Нет

Да

Да

Да

Да

-

Возможно

посетитель будет принят на работу

Возможно

посетитель будет принят на работу3

Да

>=3.5

Да

>=3.5

-

Да

Посетителюпредложить

должность

научного

сотрудника

6

Посетителю

предложить

должность

инженера-

конструктора

8

Рис.19. Дерево решений для выбора должности.

В программе под средний балл сначала отводится переменная, а затем ей присваивается значение. Можно сказать, что вершины содержат переменные, а пути - это условия, в соответствии с которыми переменным присваиваются значения. После того как для проблемной области сформулированы правила, эти условия становятся условными частями (ЕСЛИ) правила. Прямоугольники содержат частные или общие выводы. Общая цель системы, в которой реализованы обратные рассуждения, - получить окончательный ответ. Локальной целью может быть содержащийся в прямоугольнике с вершиной 3 ответ на вопрос, будет ли посетителю предложена должность. Однако эта вершина имеет и исходящие ветви, и, следовательно, через нее может проходить путь к следующему логическому выводу. В последнем случае, поскольку исходящая ветвь не содержит условия и она только одна, говорят, что вершина содержит локальный вывод для другой цели. Локальный вывод - это также составляющая условной части правила.

Замечания по разработке системы

Система, реализующая обратную цепочку рассуждений, должна выполнять следующие шаги:

1. Определить переменную логического вывода.

2. В списке логических выводов искать первое вхождение этой переменной. Если переменная найдена, в стек логических выводов поместить номер соответствующего правила и установить номер условия равным 1. Если переменная не найдена, сообщить пользователю, что ответ найти невозможно.

Присвоить значения всем переменным условия из данного правила.

Если в списке переменных указано, что какой-либо переменной условия не присвоено значение и ее нет среди переменных логического вывода (ее нет в списке логических выводов), запросить ее значение у пользователя.

Если какая-либо переменная условия входит в переменные логического вывода, поместить в стек номер правила, в логический вывод которого она входит, и вернуться к шагу 3.

Если из правила нельзя определить значение переменной, удалить соответствующий ему элемент из стека и в списке логических выводов продолжить поиск правила с этой переменной логического вывода.

Если такое правило найдено, перейти к шагу 3.

Если переменная не найдена ни в одном из оставшихся правил в логическом выводе, правило для предыдущего вывода не верно. Если предыдущего вывода не существует, сообщить пользователю, что ответ получить невозможно. Если предыдущий вывод существует, вернуться к шагу 6.

Определить значение переменной из правила, расположенного в начале стека; правило из стека удалить. Если есть еще переменные логического вывода, увеличить значение номера условия и для проверки оставшихся переменных вернуться к шагу 3. Если больше нет переменных логического вывда, сообщить пользователю окончательный вывод.

Рассмотренный выше алгоритм, реализующий обратную цепочку рассуждений, можно настроить на любую базу знаний, которая состоит из правил.

Состояние и тенденции развития искусственного интеллекта

Программные средства, базирующиеся на технологии и методах искусственного интеллекта, получили значительное распространение в мире. Их важность, и, в первую очередь, экспертных систем и нейронных сетей, состоит в том, что данные технологии существенно расширяют круг практически значимых задач, которые можно решать на компьютерах, и их решение приносит значительный экономический эффект. В то же время, технология экспертных систем является важнейшим средством в решении глобальных проблем традиционного программирования: длительность и, следовательно, высокая стоимость разработки приложений; высокая стоимость сопровождения сложных систем; повторная используемость программ и т.п. Кроме того, объединение технологий экспертных систем и нейронных сетей с технологией традиционного программирования добавляет новые качества к коммерческим продуктам за счет обеспечения динамической модификации приложений пользователем, а не программистом, большей "прозрачности" приложения (например, знания хранятся на ограниченном естественном языке, что не требует комментариев к ним, упрощает обучение и сопровождение), лучших графических средств, пользовательского интерфейса и взаимодействия.

В недалекой перспективе экспертные системы будут играть ведущую роль во всех фазах проектирования, разработки, производства, распределения, продажи, поддержки и оказания услуг. Их технология, получив коммерческое распространение, обеспечит революционный прорыв в интеграции приложений из готовых интеллектуально-взаимодействующих модулей.

Коммерческий рынок продуктов искусственного интеллекта в мире имеет несколько основных направлений:

1) экспертные системы; теперь их часто обозначают еще одним термином - "системы, основанные на знаниях";

2) нейронные сети и "размытые" (fuzzy) логики;

3) естественно-языковые системы.

Рынок этот можно разделить и иначе: на системы искусственного интеллекта (приложения) и инструментальные средства, предназначенные для автоматизации всех этапов существования приложения.

Успехи систем искусственного интеллекта

Использование экспертных систем и нейронных сетей приносит значительный экономический эффект. Так, например:

- American Express сократила свои потери на 27 млн. долларов в год благодаря экспертной системе, определяющей целесообразность выдачи или отказа в кредите той или иной фирме;

- DEC ежегодно экономит 70 млн. долларов в год благодаря системе XCON/XSEL, которая по заказу покупателя составляет конфигурацию вычислительной системы VAX. Ее использование сократило число ошибок от 30% до 1%;

- Sira сократила затраты на строительство трубопровода в Австралии на 40 млн. долларов за счет управляющей трубопроводом экспертной системы.

Причины, приведшие системы искусственного интеллекта к коммерческому успеху, следующие:

1. Специализация. Переход от разработки инструментальных средств общего назначения к проблемно/предметно специализированным средствам, что обеспечивает сокращение сроков разработки приложений, увеличивает эффективность использования инструментария, упрощает и ускоряет работу эксперта, позволяет повторно использовать информационное и программное обеспечение (объекты, классы, правила, процедуры).

2. Использование языков традиционного программирования и рабочих станций. Переход от систем, основанных на языках искусственного интеллекта (Lisp, Prolog и т.п.), к языкам традиционного программирования (С, С++ и т.п.) упростил "интегрированность" и снизил требования приложений к быстродействию и емкости памяти. Использование рабочих станций вместо ПК резко увеличило круг возможных приложений методов искусственного интеллекта.

3. Интегрированность. Разработаны инструментальные средства искусственного интеллекта, легко интегрирующиеся с другими информационными технологиями и средствами (с CASE, СУБД, контроллерами, концентраторами данных и т.п.).

4. Открытость и переносимость. Разработки ведутся с соблюдением стандартов, обеспечивающих данные характеристики .

5. Архитектура клиент/сервер. Разработка распределенной информационной системы в данной архитектуре позволяет снизить стоимость оборудования, используемого в приложении, децентрализовать приложения, повысить надежность и общую производительность, поскольку сокращается объем информации, пересылаемой между ЭВМ, и каждый модуль приложения выполняется на адекватном оборудовании.

Итак, в области искусственного интеллекта наибольшего коммерческого успеха достигли экспертные системы и средства для их разработки. В свою очередь, в этом направлении наибольшего успеха достигли проблемно/предметно специализированные средства.

Экспертные системы реального времени - основное направление искусственного интеллекта.

Среди специализированных систем, основанных на знаниях, наиболее значимы экспертные системы реального времени, или динамические экспертные системы. На их долю приходится 70 процентов этого рынка.

Значимость инструментальных средств реального времени определяется не столько их бурным коммерческим успехом (хотя и это достойно тщательного анализа), но, в первую очередь, тем, что только с помощью подобных средств создаются стратегически значимые приложения в таких областях, как управление непрерывными производственными процессами в химии, фармакологии, производстве цемента, продуктов питания и т.п., аэрокосмические исследования, транспортировка и переработка нефти и газа, управление атомными и тепловыми электростанциями, финансовые операции, связь и многие другие.

Классы задач, решаемых экспертными системами реального времени, таковы: мониторинг в реальном масштабе времени, системы управления верхнего уровня, системы обнаружения неисправностей, диагностика, составление расписаний, планирование, оптимизация, системы-советчики оператора, системы проектирования.

Статические экспертные системы не способны решать подобные задачи, так как они не выполняют требования, предъявляемые к системам, работающим в реальном времени:

1. Представлять изменяющиеся во времени данные, поступающие от внешних источников, обеспечивать хранение и анализ изменяющихся данных.

2. Выполнять временные рассуждения о нескольких различных асинхронных процессах одновременно (т.е. планировать в соответствии с приоритетами обработку поступивших в систему процессов).

3. Обеспечивать механизм рассуждения при ограниченных ресурсах (время, память). Реализация этого механизма предьявляет требования к высокой скорости работы системы, способности одновременно решать несколько задач (т.е. операционные системы UNIX, VMS, Windows NT, но не MS-DOS).

4. Обеспечивать "предсказуемость" поведения системы, т.е. гарантию того, что каждая задача будет запущена и завершена в строгом соответствии с временными ограничениями. Например, данное требование не допускает использования в экспертной системе реального времени механизма "сборки мусора", свойственного языку Lisp.

5. Моделировать "окружающий мир", рассматриваемый в данном приложении, обеспечивать создание различных его состояний.

6. Протоколировать свои действия и действия персонала, обеспечивать восстановление после сбоя.

7. Обеспечивать наполнение базы знаний для приложений реальной степени сложности с минимальными затратами времени и труда (необходимо использование объектно-ориентированной технологии, общих правил, модульности и т.п.).

8. Обеспечивать настройку системы на решаемые задачи (проблемная/предметная ориентированность).

9. Обеспечивать создание и поддержку пользовательских интерфейсов для различных категорий пользователей.

10. Обеспечивать уровень защиты информации (по категориям пользователей) и предотвращать несанкционированный доступ.

Подчеркнем, что кроме этих десяти требований средства создания экспертных систем реального времени должны удовлетворять и перечисленным выше общим требованиям.

Лекция 12. Нейронные сети. Применение нейронных сетей.

В качестве определения нейронных сетей может быть принято: ИНС (искусственная нейронная сеть) – параллельно распределенная структура обработки информации, состоящая из отдельных элементов (нейронов), соединенных между собой связями.

Нейрокомпьютеры (компьютеры, построенные на основе нейронных сетей) обладают целым рядом свойств, привлекательных с точки зрения их практического использования:

1. Сверхвысокое быстродействие за счет использования массового параллелизма обработки информации.

2. Толерантность к ошибкам: работоспособность сохраняется при повреждении значительного числа нейронов.

3. Способность к обучению; программирование вычислительной системы заменяется обучением.

4. Способность к распознаванию образов в условиях сильных помех и искажений.

Однако, первые 2 свойства имеют место только при аппаратной реализации нейронных сетей. Аппаратно реализованные нейронные сети обеспечивают решение сложных задач за времена порядка времен срабатывания цепочек электронных и/или оптических элементов. Решение слабо зависит от неисправности отдельного нейрона. Это делает их привлекательными для использования в составе бортовых вычислительных систем.

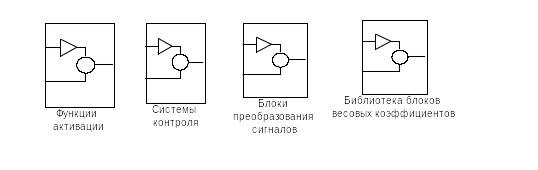

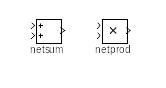

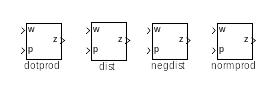

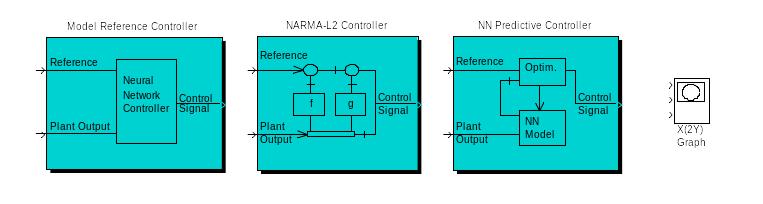

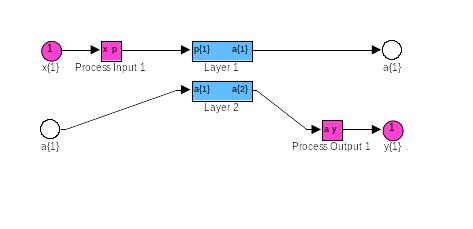

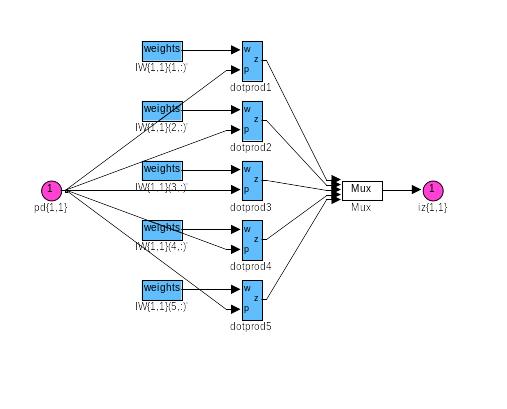

Пакет Neural Networks Toolbox cистемы Matlab содержит средства для проектирования, моделирования, обучения и использования множества известных парадигм современного аппарата искусственных нейронных сетей: от базовых моделей персептрона до самых современных ассоциативных и самоорганизующихся сетей.

В настоящее время ИНС применяются для решения многих неформализуемых или трудно формализуемых задач:

распознавания и синтеза речи;

распознавания аэрокосмических изображений;

прогнозирования котировки ценных бумаг и курса валют;

предупреждения мошенничества с кредитными карточками;

оценки стоимости недвижимости;

оценки финансового состояния предприятий и риска невозврата кредитов;

обработки радиолокационных сигналов;

контроля движения на скоростных автомагистралях и железных дорогах;

диагностики в медицине;

добычи знаний из больших объемов данных в бизнесе, финансах и научных исследованиях.

Нейронные сети можно использовать при следующих условиях:

Если задачу может решать человек.

Если при решении задачи можно выделить множество входных факторов (сигналов, признаков, данных и т.п.) и множество выходных факторов.

Если изменения входных факторов приводит к изменению выходных.

В то же время применение нейронных сетей при решении некоторых задач может оказаться эффективнее использования разума человека. Это объясняется тем, что человеческий разум ориентирован на решение задач в трехмерном пространстве. Многомерные задачи для него характеризуются значительно большей трудоемкостью. Искусственным нейронным сетям не свойственно такое ограничение. Им все равно решать трехмерную или 10-мерную задачу.

Место нейросетевой технологии среди других методов обработки данных показано на рис.20.

Рис.20. Область использования нейронніх сетей

Подобно биологической нейронной системе ИНС является вычислительной системой с огромным числом параллельно функционирующих простых процессоров с множеством связей. Модели ИНС в некоторой степени воспроизводят "организационные" принципы, свойственные мозгу человека. Моделирование биологической нейронной системы с использованием ИНС может также способствовать лучшему пониманию биологических функций. Такие технологии производства, как VLSI (сверхвысокий уровень интеграции) и оптические аппаратные средства, делают возможным подобное моделирование.

Глубокое изучение ИНС требует знания нейрофизиологии, науки о познании, психологии, физики (статистической механики), теории управления, теории вычислений, проблем искусственного интеллекта, статистики/математики, распознавания образов, компьютерного зрения, параллельных вычислений и аппаратных средств (цифровых/аналоговых/VLSI/оптических).

С другой стороны, ИНС также стимулируют эти дисциплины, обеспечивая их новыми инструментами и представлениями. Этот симбиоз жизненно необходим для исследований по нейронным сетям. Представим некоторые проблемы, решаемые в контексте ИНС и представляющие интерес для ученых и инженеров.

Классификация образов. Задача состоит в указании принадлежности входного образа (например, речевого сигнала или рукописного символа), представленного вектором признаков, одному или нескольким предварительно определенным классам. К известным приложениям относятся распознавание букв, распознавание речи, классификация сигнала электрокардиограммы, классификация клеток крови.

Кластеризация/категоризация. При решении задачи кластеризации, которая известна также как классификация образов "без учителя", отсутствует обучающая выборка с метками классов. Алгоритм кластеризации основан на подобии образов и размещает близкие образы в один кластер. Известны случаи применения кластеризации для извлечения знаний, сжатия данных и исследования свойств данных.

Аппроксимация функций. Предположим, что имеется обучающая выборка ((x1,y1), (x2,y2)..., (xn,yn)) (пары данных вход-выход), которая генерируется неизвестной функцией f(x), искаженной шумом. Задача аппроксимации состоит в нахождении оценки неизвестной функции f(x). Аппроксимация функций необходима при решении многочисленных инженерных и научных задач моделирования.

Предсказание/прогноз. Пусть заданы n дискретных отсчетов {y(t1), y(t2)..., y(tn)} в последовательные моменты времени t1, t2,..., tn . Задача состоит в предсказании значения y(tn+1) в некоторый будущий момент времени tn+1. Предсказание/прогноз имеют значительное влияние на принятие решений в бизнесе, науке и технике. Предсказание цен на фондовой бирже и прогноз погоды являются типичными приложениями техники предсказания/прогноза.

Оптимизация. Многочисленные проблемы в математике, статистике, технике, науке, медицине и экономике могут рассматриваться как проблемы оптимизации. Задачей алгоритма оптимизации является нахождение такого решения, которое удовлетворяет системе ограничений и максимизирует или минимизирует целевую функцию. Задача коммивояжера, относящаяся к классу NP-полных, является классическим примером задачи оптимизации.

Управление. Рассмотрим динамическую систему, заданную совокупностью {u(t), y(t)}, где u(t) является входным управляющим воздействием, а y(t) - выходом системы в момент времени t. В системах управления с эталонной моделью целью управления является расчет такого входного воздействия u(t), при котором система следует по желаемой траектории, диктуемой эталонной моделью. Примером является оптимальное управление двигателем.

При применении нейронных сетей необходимо решить следующие задачи:

Постановка задачи, пригодной для решения с помощью нейронной сети.

Выбор модели ИНС.

Подготовка исходных данных для обучения ИНС.

Обучение ИНС.

Собственно решение задачи с помощью обученной ИНС

Кроме того, иногда нужен еще один этап – интерпретация решения, полученного нейронной сетью.

Наиболее трудоемкими процессами при использовании нейронных сетей являются подготовка исходных данных для обучения и обучение нейронной сети.

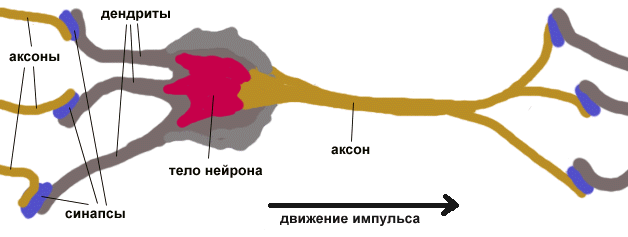

Нервная система и мозг человека состоят из нейронов, соединенных между собой нервными волокнами (рис.21). Нервные волокна способны передавать электрические импульсы между нейронами. Все процессы передачи раздражений от нашей кожи, ушей и глаз к мозгу, процессы мышления и управления действиями - все это реализовано в живом организме как передача электрических

импульсов между нейронами. Рассмотрим строение биологического нейрона. Каждый нейрон имеет отростки нервных волокон двух типов - дендриты, по которым принимаются импульсы, и единственный аксон, по которому нейрон может передавать импульс. Аксон контактирует с дендритами других нейронов через специальные образования - синапсы, которые влияют на силу импульса.

Рис. 21. Строение биологического нейрона

Можно считать, что при прохождении синапса сила импульса меняется в определенное число раз, которое мы будем называть весом синапса. Импульсы, поступившие к нейрону одновременно по нескольким дендритам, суммируются. Если суммарный импульс превышает некоторый порог, нейрон возбуждается, формирует собственный импульс и передает его далее по аксону. Передача информации между нейронами осуществляется ЭЛЕКТРИЧЕСКИМИ ИМПУЛЬСАМИ. Под действием этих сигналов возникает процесс химической диффузии ионов натрия, калия, хлора и некоторых других элементов, изменяющий электрический ПОТЕНЦИАЛ МЕМБРАНЫ. Когда этот потенциал (суммарный импульс) достигает некоторой величины, называемой ПОРОГОМ НЕЙРОНА, нейрон возбуждается и вырабатывает импульс, который уходит по аксону. При этом потенциал мембраны резко падает и нейрон "разряжается". После некоторой паузы нейрон может опять сформировать импульс. Важно отметить, что веса синапсов могут изменяться со временем, а значит, меняется и поведение соответствующего нейрона. Выходной сигнал проходит по ветвям аксона и достигает СИНАПСОВ, которые соединяют аксоны с дендритными деревьями других нейронов. Все нейроны вырабатывают сигналы только ОДНОГО ЗНАКА. Если импульсы, поступающие на СИНАПС, приводят к повышению мембранного потенциала, то такой СИНАПС называется ВОЗБУЖДАЮЩИМ. В противном случае СИНАПС называется ТОРМОЗЯЩИМ. Величина входного сигнала, генерируемого синапсом, может быть различной даже при одинаковой величине сигнала, проходящего через синапс. Эти различия определяются эффективностью или ВЕСОМ СИНАПСА.

Важно отметить, что веса синапсов могут изменяться со временем, а значит, меняется и поведение соответствующего нейрона.

Под нейронными сетями подразумеваются вычислительные структуры, которые моделируют простые биологические процессы, обычно ассоциируемые с процессами человеческого мозга. Адаптируемые и обучаемые, они представляют собой распараллеленные системы, способные к обучению путем анализа положительных и отрицательных воздействий. Элементарным преобразователем в данных сетях является искусственный нейрон или просто нейрон, названный так по аналогии с биологическим прототипом.

К настоящему времени предложено и изучено большое количество моделей нейроноподобных элементов и нейронных сетей.

Структура искусственного нейрона

Структура искусственного нейрона показана на рис. 22. В состав нейрона входят умножители (синапсы), сумматор и нелинейный преобразователь.

Рис.22. Структура искусственного нейрона

Синапсы осуществляют связь между нейронами и умножают входной сигнал на число, характеризующее силу связи, - вес синапса. Сумматор выполняет сложение сигналов, поступающих по синаптическим связям от других нейронов, и внешних входных сигналов. Нелинейный преобразователь реализует нелинейную функцию одного аргумента – выхода сумматора. Эта функция называется функцией активации или передаточной функцией нейрона. Нейрон в целом реализует скалярную функцию векторного аргумента. Нетрудно построить математическую модель описанного процесса. Математическая модель нейрона описывается соотношениями:

![]()

где

![]() вес

синапса,

вес

синапса,

![]() ;

;

![]() результат

суммирования;

результат

суммирования;

![]() компонент

входного вектора (входной сигнал);

компонент

входного вектора (входной сигнал);

![]() выходной

сигнал нейрона;

выходной

сигнал нейрона;

![]() число

входов нейрона;

число

входов нейрона;

![]() нелинейное

преобразование (функция активации или

передаточная функция);

нелинейное

преобразование (функция активации или

передаточная функция);

![]() значение

смещения (в нейронную сеть иногда вводя

смещение, которое действует как весовой

коэффициент от ячейки с активацией,

равной 1; смещение увеличивает входное

воздействие в сеть на единицу; вместо

смещения в ряде случаев применяется

фиксированный порог для функции

активации).

значение

смещения (в нейронную сеть иногда вводя

смещение, которое действует как весовой

коэффициент от ячейки с активацией,

равной 1; смещение увеличивает входное

воздействие в сеть на единицу; вместо

смещения в ряде случаев применяется

фиксированный порог для функции

активации).

Лекция 13. НС. Функции активации

В

общем случае входной сигнал, весовые

коэффициенты и значения смещения могут

принимать вещественные значения. Выход

![]() определяется видом функции акитивации

и может быть как действительным, так и

целым.

определяется видом функции акитивации

и может быть как действительным, так и

целым.

Синаптические веса с положительными весами называют возбуждающими, с отрицательными – тормозящими.

Нейрон

преобразует полученный суммарный

импульс в соответствии с некоторой

передаточной функцией

![]() .

Таким образом, нейрон полностью

описывается своими весами

.

Таким образом, нейрон полностью

описывается своими весами

![]() и передаточной функцией

.

Получив набор чисел (вектор)

и передаточной функцией

.

Получив набор чисел (вектор)

![]() в качестве входов, нейрон выдает некоторое

число y на выходе.

в качестве входов, нейрон выдает некоторое

число y на выходе.

На

входной сигнал

![]() нелинейный преобразователь отвечает

выходным сигналом

,

который представляет собой выход нейрона

нелинейный преобразователь отвечает

выходным сигналом

,

который представляет собой выход нейрона

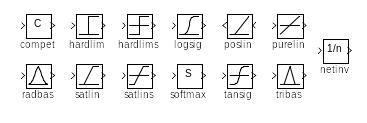

![]() Примеры активационных функций представлены

в табл.1 и на рис.23.

Примеры активационных функций представлены

в табл.1 и на рис.23.

Рис. 23.Примеры активационных функций: а – пороговая; б – полулинейная с насыщением; в – сигмоид (логистическая); г сигмоид (гиперболический тангенс)

Табл.1

Название |

Формула |

Область значений |

Порогоговая |

|

(0,1) |

Знаковая |

|

(-1,1) |

Сигмоидальная (логистическая) |

|

(0,1) |

Полулинейная |

|

|

Линейная |

|

|

Радиальная базисная (гауссова) |

|

(0,1) |

Полулинейная с насыщением |

|

(0,1) |

Линейная с насыщением |

|

(-1,1) |

Гиперболический тангенс (сигмоидальная) |

|

(-1,1) |

Треугольная |

|

(0,1) |

Одной из наиболее распространенных является нелинейная функция с насыщением, так называемая логистическая функция или сигмоид:

Одно из ценных свойств сигмоидальной функции – простое выражение для ее производной:

![]() ,

,

которое используется в некоторых алгоритмах обучения.

Классификация нейронных сетей. Как работает нейросеть

Искусственная

нейронная сеть

(ИНС)

- это набор нейронов, соединенных между

собой. Как правило, передаточные функции

всех нейронов в сети фиксированы, а веса

являются параметрами сети и могут

изменяться. Некоторые входы нейронов

помечены как внешние входы сети, а

некоторые выходы - как внешние выходы

сети. Подавая любые числа на входы сети,

мы получаем какой-то набор чисел на

выходах сети. Таким образом, работа

нейросети состоит в преобразовании

входного вектора

![]() в выходной вектор

в выходной вектор

![]() ,

причем это преобразование задается

весами сети.

,

причем это преобразование задается

весами сети.

Нейронные сети различают по структуре сети (связей между нейронами), особенностям модели нейрона, особенностям обучения сети. По структуре нейронные сети можно разделить (рис.24) на неполносвязные (или слоистые) и полносвязные, со случайными и регулярными связями, с симметричными и несимметричными связями.

Рис.24. Архитектуры нейронных сетей: а – полносвязная сеть; б – многослойная сеть с последовательными связями; в – слабосвязные сети

Неполносвязные нейронные сети (описываемые неполносвязным ориентированным графом и обычно называемые персептронами), подразделяются на однослойные (простейшие персептроны) и многослойные, с прямыми, перекрестными и обратными связями. Классическим вариантом слоистых сетей являются сети прямого распространения (рис.25).

В нейронных сетях с прямыми связями нейроны j-ого слоя по входам могут соединяться только с нейронами i-ых слоев, где j > i , т.е. с нейронами нижележащих слоев. В нейронных сетях с перекрестными связями допускаются связи внутри одного слоя, т.е. выше приведенное неравенство заменяется на j > = i В нейронных сетях с обратными связями используются и связи j-ого слоя по входам с i-ым при j < i. Кроме того, по виду связей различают персептроны с регулярными и случайными связями.

Рис.25. Многослойная (двухслойная) сеть прямого распространения

По способу подачи информации на входы нейронной сети различают:

подачу сигналов на синапсы входных нейронов;

подачу сигналов на выходы входных нейронов;

подачу сигналов в виде весов синапсов входных нейронов;

аддитивную подачу на синапсы входных нейронов.

По способу съема информации с выходов нейронной сети различают:

съем с выходов выходных нейронов;

съем с синапсов выходных нейронов;

съем в виде значений весов синапсов выходных нейронов;

аддитивный съем с синапсов выходных нейронов.

Пo организации обучения разделяют обучение нейронных сетей с учителем (supervised neural networks) и без учителя (nonsupervised). При обучении с учителем предполагается, что есть внешняя среда, которая предоставляет обучающие примеры (значения входов и соответствующие им значения выходов) на этапе обучения или оценивает правильность функционирования нейронной сети и в соответствии со своими критериями меняет состояние нейронной сети или поощряет (наказывает) нейронную сеть, запуская тем самым механизм изменения ее состояния. Под состоянием нейронной сети, которое может изменяться, обычно понимается:

веса синапсов нейронов (карта весов - map) (коннекционистский подход);

веса синапсов и пороги нейронов (обычно в этом случае порог является более легко изменяемым параметром, чем веса синапсов);

установление новых связей между нейронами (свойство биологических нейронов устанавливать новые связи и ликвидировать старые называется пластичностью).

По способу обучения разделяют обучение по входам и по выходам. При обучении по входам обучающий пример представляет собой только вектор входных сигналов, а при обучении по выходам в него входит и вектор выходных сигналов, соответствующий входному вектору.

По способу предъявления примеров различают предъявление одиночных примеров и "страницы" примеров. В первом случае изменение состояния нейронной сети (обучение) происходит после предъявления каждого примера. Во втором - после предъявления "страницы" (множества) примеров на основе анализа сразу их всех.

Практически любую задачу можно свести к задаче, решаемой нейросетью.

В табл.2 показано, каким образом следует сформулировать в терминах нейросети задачу распознавания рукописных букв.

Поясним, зачем требуется выбирать выход с максимальным уровнем сигнала. Дело в том, что уровень выходного сигнала, как правило, может принимать любые значения из какого-то отрезка. Однако, в данной задаче нас интересует не аналоговый ответ, а всего лишь номер категории (номер буквы в алфавите). Поэтому используется следующий подход - каждой категории сопоставляется свой выход, а ответом сети считается та категория, на чьем выходе уровень сигнала максимален. В определенном смысле уровень сигнала на выходе "А" - это достоверность того, что на вход была подана рукописная буква "A". Задачи, в которых нужно отнести входные данные к одной из известных категорий, называются задачами классификации. Изложенный подход - стандартный способ классификации с помощью нейронных сетей.

Табл.2. Задача распознавания рукописных букв в терминах нейросети

Задача распознавания рукописных букв |

|

Дано: растровое черно-белое изображение буквы размером 30x30 пикселов |

Надо: определить, какая это буква (в алфавите 33 буквы) |

Формулировка для нейросети |

|

Дано: входной вектор из 900 двоичных символов (900=30x30) |

Надо: построить нейросеть с 900 входами и 33 выходами, которые помечены буквами. Если на входе сети - изображение буквы "А", то максимальное значение выходного сигнала достигается на выходе "А". Аналогично сеть работает для всех 33 букв. |

Затем можно переходить к следующему вопросу «как строить сеть». Это решается в два этапа:

выбор типа (архитектура сети);

подбор весов (обучение) сети.

На первом этапе следует выбрать следующее:

какие нейроны мы хотим использовать (число входов, передаточные функции);

каким образом следует соединить их между собой;

что взять в качестве входов и выходов сети.

Лекция 14. НС (продолжение)

Эта задача на первый взгляд кажется необозримой, но необязательно придумывать нейросеть "с нуля" - существует несколько десятков различных нейросетевых архитектур, причем эффективность многих из них доказана математически. Наиболее популярные и изученные архитектуры - это многослойный персептрон, нейросеть с общей регрессией, сети Кохонена и другие. На втором этапе нам следует "обучить" выбранную сеть, то есть подобрать такие значения ее весов, чтобы сеть работала нужным образом. Необученная сеть подобна ребенку - ее можно научить чему угодно. В используемых на практике нейросетях количество весов может составлять несколько десятков тысяч, поэтому обучение - действительно сложный процесс. Для многих архитектур разработаны специальные алгоритмы обучения, которые позволяют настроить веса сети определенным образом. Наиболее популярный из этих алгоритмов - метод обратного распространения ошибки (Error Back Propagation), используемый, например, для обучения персептрона.

В зависимости от функций, выполняемых нейронами в сети, можно выделить три их типа:

1) входные нейроны – на них подается входной вектор, кодирующий входное воздействие или образ внешней среды; вычислительных процедур в этих нейронах не осуществляется, информация передается со входа на выход путем изменения его активации;

2) выходные нейроны – выходные значения которых представляют выход сети;

3) промежуточные нейроны – составляют основу ИНС, преобразования в них выполняются по вышеприведенным формулам.

Выбор структуры ИРС осуществляется в соответствии с особенностями и сложностью задачи. Для решения некоторых отдельных типов задач существуют оптимальные конфигурации. Если же задача не может быть сведена ни к одному из известных типов, разработчику приходится решать проблему синтеза новой конфигурации, причем необходимо руководствоваться следующими принципами:

возможности сети возрастают с увеличением числа ячеек сети, плотности связи между ними и числом выделенных слоев;

2) введение обратных связей наряду с увеличением возможностей сети поднимает вопрос о динамической устойчивости сети;

сложность алгоритмов функционирования сети (например, введения нескольких типов синапсов) также способствует усилению возможностей сети.

В большинстве случаев оптимальный вариант получается на основе интуитивного подбора, хотя в литературе приведены доказательства того, что для любого алгоритма существует нейронная сеть, которая может его реализовать.

Многие

задачи: распознавания образов (зрительных,

речевых), управления, прогнозирования,

идентификации сложных систем, сводятся

к следующей постановке: необходимо

построить отображение

![]() такое,

чтобы в ответ на каждый возможный входной

сигнал Х формировался правильный

выходной сигнал Y.

Отображение

задается конечным набором пар («вход»,

«известный выход»). Число таких пар

(обучающих примеров) существенно меньше

общего числа возможных сочетаний

значений входных и выходных сигналов.

Совокупность всех обучающих примеров

носит название обучающей выборки.

такое,

чтобы в ответ на каждый возможный входной

сигнал Х формировался правильный

выходной сигнал Y.

Отображение

задается конечным набором пар («вход»,

«известный выход»). Число таких пар

(обучающих примеров) существенно меньше

общего числа возможных сочетаний

значений входных и выходных сигналов.

Совокупность всех обучающих примеров

носит название обучающей выборки.

В задачах разпознавания образов Х – некоторое представление образа (изображение, вектор чисел), Y – номер класса, к которому принадлежит входной образ.

В задачах управления Х – набор контролируемых параметров управляемого объекта, Y – код, определяющий управляющее воздействие, соответствующее текущим значениям контролируемых параметров.

В задачах прогнозирования в качестве входных сигналов используются временные ряды , представляющие значения контролируемых переменных на некотором интервале времени. Выходной сигнал – множество переменных, которое является подмножеством переменных входного сигнала.

Вообще

говоря, большая часть прикладных задач

может быть сведена к реализации некоторого

сложного многомерного функционального

преобразования

![]()

В результате построения такого преобразования (отображения) необходимо добиваться того, чтобы обеспечивалось формирование правильных выходных сигналов в соответствии:

1) со всеми примерами обучающей выборки;

2) со всеми возможными входными сигналами, которые не вошли в обучающую выборку.

Отметим,

что теоретической основой для построения

НС является следующее утверждение: для

любого множества пар входных-выходных

векторов произвольной размерности

существует двухслойная однородная

нейронная сеть с последовательными

связями, с сигмоидальными передаточными

функциями и с конечным числом нейронов,

которая для каждого входного вектора

![]() формирует

соответствующий ему выходной вектор

формирует

соответствующий ему выходной вектор

![]()

Таким образом, для представления многомерных функций многих переменных может быть использована однородная нейронная сеть, имеющая всего один скрытый слой, с сигмоидальными передаточными функциями нейронов.

Для

оценки числа нейронов в скрытых слоях

ОНС можно воспользоваться формулой для

оценки необходимого числа синаптических

весов

![]() (в многослойной сети с сигмоидальными

передаточными функциями):

(в многослойной сети с сигмоидальными

передаточными функциями):

![]()

где n – размерность входного сигнала, m –размерность выходного сигнала, N – число элементов обучающей выборки.

Число

нейронов в двухслойной сети составит:

![]() или

или

![]()

Теорема о полноте. Любая непрерывная функция на замкнутом ограниченном множестве может быть равномерно приближена функциями, вычисляемыми нейронными сетями, если функция активации нейрона дважды непрерывно дифференцируема и нелинейна.

Таким образом, НС являются универсальными аппроксимирующими системами.

Задавшись определенной структурой ИНС, отвечающей какой-либо задаче, разработчик сети должен найти оптимальные значения всех весовых коэффициентов. Этот этап называется обучением ИНС.

Обучение нейронной сети

Таким образом, нейросети составлены из простых элементов, действующих параллельно. Можно обучить нейросеть, регулируя значения весов между элементами. Обычно сеть регулируется или обучается так, чтобы частный вход вел к целевому выходу. Регулируемая сеть основана на сравнении выхода и цели, пока сетевой выход не будет соответствовать цели. Обычно имеется много обучающих пар вход/цель. Количество обучающих пар выбирается в зависимости от постановки задачи. Переменные, выступающие в роли входных и выходных сигналов НС, могут представлять собой экспериментальные данные, получаемые измерением выходных параметров объекта при задании определенных входных.

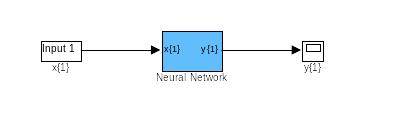

Обучить нейронную сеть - значит, сообщить ей, чего мы от нее добиваемся. Этот процесс очень похож на обучение ребенка алфавиту. Показав ребенку изображение буквы "А", мы спрашиваем его: "Какая это буква?" Если ответ неверен, мы сообщаем ребенку тот ответ, который мы хотели бы от него получить: "Это буква А". Ребенок запоминает этот пример вместе с верным ответом, то есть в его памяти происходят некоторые изменения в нужном направлении. Мы будем повторять процесс предъявления букв снова и снова до тех пор, когда все 33 буквы будут твердо запомнены. Такой процесс называют "обучение с учителем" (рис.26).

При обучении сети мы действуем совершенно аналогично. У нас имеется некоторая база данных, содержащая примеры (набор рукописных изображений букв). Предъявляя изображение буквы "А" на вход сети, мы получаем от нее некоторый ответ, не обязательно верный. Нам известен и верный (желаемый) ответ - в данном случае нам хотелось бы, чтобы на выходе с меткой "А" уровень сигнала был максимален. Обычно в качестве желаемого выхода в задаче классификации берут набор (1, 0, 0, ...), где 1 стоит на выходе с меткой "А", а 0 - на всех остальных выходах. Вычисляя разность между желаемым ответом и реальным ответом сети, мы получаем 33 числа - вектор ошибки. Алгоритм обратного распространения ошибки - это набор формул, который позволяет по вектору ошибки вычислить требуемые поправки для весов сети. Одну и ту же букву (а также различные изображения одной и той же буквы) мы можем предъявлять сети много раз. В этом смысле обучение скорее напоминает повторение упражнений в спорте - тренировку.

Рис.26. Иллюстрация процесса обучения НС

Оказывается, что после многократного предъявления примеров веса сети стабилизируются, причем сеть дает правильные ответы на все (или почти все) примеры из базы данных. В таком случае говорят, что "сеть выучила все примеры", " сеть обучена", или "сеть натренирована". В программных реализациях можно видеть, что в процессе обучения величина ошибки (сумма квадратов ошибок по всем выходам) постепенно уменьшается. Когда величина ошибки достигает нуля или приемлемого малого уровня, тренировку останавливают, а полученную сеть считают натренированной и готовой к применению на новых данных. Важно отметить, что вся информация, которую сеть имеет о задаче, содержится в наборе примеров. Поэтому качество обучения сети напрямую зависит от количества примеров в обучающей выборке, а также от того, насколько полно эти примеры описывают данную задачу. Так, например, бессмысленно использовать сеть для предсказания финансового кризиса, если в обучающей выборке кризисов не представлено. Считается, что для полноценной тренировки требуется хотя бы несколько десятков (а лучше сотен) примеров. Повторим еще раз, что обучение сети - сложный и наукоемкий процесс. Алгоритмы обучения имеют различные параметры и настройки, для управления которыми требуется понимание их влияния.

Лекция 15. Алгоритмы обучения нейронных сетей

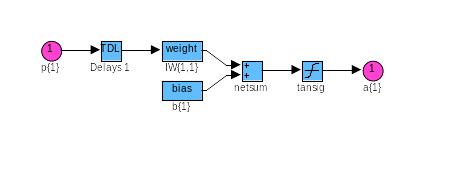

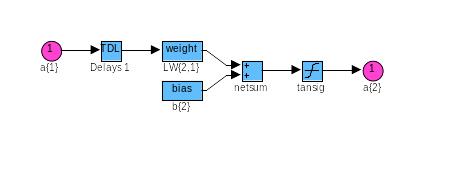

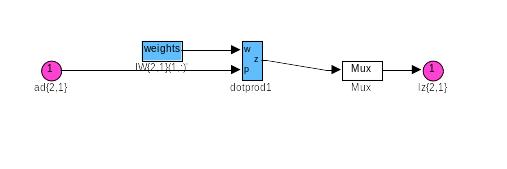

Рассмотрим идею одного из самых распространенных алгоритмов обучения – алгоритма обратного распространения ошибки. Это итеративный градиентный алгоритм обучения, который используется с целью минимизации среднеквадратичного отклонения текущего выхода от желаемого выхода в многослойных нейронных сетях. Этот алгоритм используется для обучения многослойных НС с последовательными связями вида рис.25. Нейроны в таких сетях делятся на группы с общим входным сигналом - слои. На каждый нейрон первого слоя подаются все элементы внешнего входного сигнала. Все выходы нейронов m-го слоя подаются на каждый нейрон слоя m+1. Нейроны выполняют взвешенное суммирование элементов входных сигналов. К сумме элементов входных сигналов, помноженных на соответствующие синаптические веса, прибавляется смещение нейрона. Над результатом суммирования выполняется нелинейное преобразование - функция активации (передаточная функция). Значение функции активации есть выход нейрона.

В многослойных сетях оптимальные выходные значения нейронов всех слоев, кроме последнего, как правило, неизвестны, и трех- или более слойный персептрон уже невозможно обучить, руководствуясь только величинами ошибок на выходах НС. Наиболее приемлемым вариантом обучения в таких условиях оказался градиентный метод поиска минимума функции ошибки с рассмотрением сигналов ошибки от выходов НС к ее входам, т.е. в направлении, обратном прямому распространению сигналов в обычном режиме работы. Этот алгоритм обучения НС получил название процедуры обратного распространения.

В данном алгоритме функции ошибки представляют собой сумму квадратов рассогласования (ошибки) желаемого выхода сети и реального. При вычислении элементов вектора градиента использован своеобразный вид производных функций активации сигмоидного типа. Алгоритм действует циклически и его циклы принято называть эпохами. На каждом этапе на вход сети поочередно подаются все обучающие наблюдения, выходные значения сети сравниваются с целевыми значениями и вычисляется ошибка. Значение ошибки, а также градиента поверхности ошибок используется для корректировки весов, после чего все действия повторяются. Начальная конфигурация сети выбирается случайным образом, и процесс обучения прекращается либо когда пройдено определенное количество эпох, либо когда ошибка достигнет некоторого определенного уровня малости, либо когда ошибка перестанет уменьшаться.

Обучение сети методом ОРО включает в себя три этапа:

Прямое распространение входного обучающего образа

Вычисление ошибки и ее обратное распространение

Регулирование весов

Этот метод основан на вычислении вектора градиента поверхности ошибок, который указывает направление кратчайшего спуска по поверхности из данной точки. Последовательность шагов приводит после ряда итераций к минимуму поверхности ошибок. Основная трудность здесь представляет выбор длины шага. На практике величина шага принимается пропорциональной крутизне склона с постоянной, называемой скоростью обучения. Рассмотрим алгоритм для многослойного прямонаправленного персептрона (МПП) (рис.27).

Рис. 27. Схема трехслойного персептрона

Обозначим

через

![]() входные

нейроны;

входные

нейроны;

![]() нейроны

скрытого слоя;

нейроны

скрытого слоя;

![]() выходные

нейроны;

выходные

нейроны;

![]() веса

от ячеек входного слоя к нейронам

скрытого слоя;

веса

от ячеек входного слоя к нейронам

скрытого слоя;

![]() веса

от нейронов скрытого слоя к выходным

нейронам. Индексом р

веса

от нейронов скрытого слоя к выходным

нейронам. Индексом р

![]() обозначим различные образы, предъявляемые

на вход. Входные сигналы могут быть

бинарными,

биполярными

или непрерывными.

обозначим различные образы, предъявляемые

на вход. Входные сигналы могут быть

бинарными,

биполярными

или непрерывными.

Поведение

сети определяется на основе ряда пар

«вход-выход». Каждый обучающий пример

состоит из n

входных сигналов

и m

требуемых выходных сигналов

![]() Обучение МПП для конкретной задачи

эквивалентно нахождению таких значений

всех синаптических весов, при которых

для соответствующего входа формируется

требуемый выход или обучение многослойной

сети заключается в регулировании всех

весов таким образом, что ошибка между

требуемыми выходными

Обучение МПП для конкретной задачи

эквивалентно нахождению таких значений

всех синаптических весов, при которых

для соответствующего входа формируется

требуемый выход или обучение многослойной

сети заключается в регулировании всех

весов таким образом, что ошибка между

требуемыми выходными

![]() и действительными выходными

и действительными выходными

![]() сигналами,

усредненная по всем обучающим примерам,

была минимальна. При предъявлении образа

р на вход сети скрытая ячейка j

принимает сигнал:

сигналами,

усредненная по всем обучающим примерам,

была минимальна. При предъявлении образа

р на вход сети скрытая ячейка j

принимает сигнал:

![]()

и на своем выходе с помощью функции активации вырабатывает такой сигнал:

![]()

Выходная

ячейка с номером

![]() суммирует сигналы от нейронов скрытого

слоя, образуя сигнал, равный:

суммирует сигналы от нейронов скрытого

слоя, образуя сигнал, равный:

![]()

и после воздействия функции активации формирует выходной сигнал (пороговые значения отброшены, т.к. они всегда могут быть введены в сеть):

![]()

В качестве функции ошибок примем функцию вида:

![]()

где

![]() требуемое

значение выхода.

требуемое

значение выхода.

Подставляя

в последнее выражение значение для

![]() ,

получим:

,

получим:

![]()

![]()

Функция

![]() является

непрерывно дифференцируемой функцией

от каждого веса, входящего в него

выражения, поэтому можно воспользоваться

алгоритмом градиентного спуска для

нахождения весов.

является

непрерывно дифференцируемой функцией

от каждого веса, входящего в него

выражения, поэтому можно воспользоваться

алгоритмом градиентного спуска для

нахождения весов.

Для весов между скрытым и выходными слоями правило градиентного спуска дает:

![]()

где

![]() ,

,

![]() коэффициент

скорости обучения (

коэффициент

скорости обучения (![]() ).

).

Для весов между входным и скрытым слоями нужно продифференцировать выражение для , воспользовавшись цепным правилом:

где

![]()

Отметим,

что уравнения для

![]() и

и

![]() имеют одинаковую форму, но различаются

значениями параметра

имеют одинаковую форму, но различаются

значениями параметра

![]() В общем случае при произвольном числе

слоев правило изменения весов в методе

ОРО имеет вид:

В общем случае при произвольном числе

слоев правило изменения весов в методе

ОРО имеет вид:

![]()

где

суммирование производится по всем

предъявляемым образам; выход и вход

относятся к двум концам

![]() и

и

![]() синаптического соединения;

синаптического соединения;

![]() активация

от скрытой ячейки или реального входы.

Значения

активация

от скрытой ячейки или реального входы.

Значения

![]() зависят от рассматриваемого слоя; для

последнего слоя эта величина определяется

по выражению

зависят от рассматриваемого слоя; для

последнего слоя эта величина определяется

по выражению

![]() ,

а для других слоев – формулой подобной

,

а для других слоев – формулой подобной

![]()

Выражения, определяющие правила изменения весов, записаны в виде сумм по предъявляемым образам, однако обычно образы поступают на вход последовательно: образ р предъявляется на вход, и по окончании прохода «вперед-назад» по сети все веса изменяются перед предъявлянием следующего образа. Это уменьшает функцию ошибок Е на каждом шаге. Если образы выбираются в случайном порядке, то движение по пространству весов происходит стохастически, что позволяет более широко исследовать поверхность ошибок. Альтернативная версия изменения весов (групповое обучение) заключается в минимизации функции ошибки таким образом, что весовые изменения накапливаются по всем обучающим примерам и только затем происходит модификация весов.

Этот алгоритм представляет собой следующую последовательность шагов.

1. Инициировать веса, приняв их малыми случайными величинами.

2. Если условие остановки не выполняется, делать шаги 3-10.

3.

Выбирается очередная обучающая пара

![]() из обучающего множества; вектор Х

подается на вход сети. Для каждой

обучающей пары выполнять шаги 4-9.

из обучающего множества; вектор Х

подается на вход сети. Для каждой

обучающей пары выполнять шаги 4-9.

Прямой проход по сети.

4. Каждая входная ячейка принимает входной сигнал и распространяет его ко всем нейронам скрытого слоя.

5.

Каждая ячейка скрытого слоя

![]() суммирует свои взвешенные входные

сигналы

суммирует свои взвешенные входные

сигналы

![]() применяет к полученной сумме функцию

активации, формируя выходной сигнал

применяет к полученной сумме функцию

активации, формируя выходной сигнал

![]() который посылается ко всем ячейкам

выходного слоя.

который посылается ко всем ячейкам

выходного слоя.

6.

Каждая выходная ячейка

![]() суммирует

взвешенные сигналы:

суммирует

взвешенные сигналы:

![]()

формируя после применения функции активации выходной сигнал сети:

![]()

Обратное распространение ошибки.

7.

Каждая выходная ячейка сопоставляет

свое значение выхода с требуемой

целевой величиной и вычисляет параметр![]()

![]()

После чего определяется корректировочный член для весов:

![]()

а

параметры

![]() посылаются в нейроны скрытого слоя.

посылаются в нейроны скрытого слоя.

8.

Каждая скрытая ячейка

![]() суммирует свои

суммирует свои

![]() входы

от нейронов выходного слоя:

входы

от нейронов выходного слоя:

![]()

Результат

умножается на производную от функции

активации для определения

![]()

![]()

и

вычисляется поправочный член:

![]()

Изменение весов.

9. Веса между скрытым и выходными слоями модифицируются следующим образом:

![]()

Аналогичным образом изменяются веса между входным и скрытыми слоями:

![]()

10. Проверка условия остановки: минимизация ошибки между требуемым и реальным выходными сигналами.

Схема алгоритма ОРО представлена на рис.28.

Рис.28. Вычислительная схема метода ОРО

Лекция 16. Практические рекомендации при использовании алгоритма ОРО

Выбор начальных значений. Этот этап оказывает влияние на достижение сетью глобального минимума функции ошибки и на скорость схождения к минимуму. С одной стороны, значения начальных весов не должны быть очень большими, иначе начальные входные сигналы в каждую скрытую или входную ячейку попадут в диапазон, где производная сигмоидной функции активации имеет очень малую величину. С другой стороны, если начальные значения взять достаточно малыми, то сетевой вход в скрытый или выходной нейрон будет ближе к нулю, что приведет к очень медленному обучению. Общее правило инициирования начальных весов заключается в выборе их значений из равномерно распределенных величин в интервале (-0,5…0,5) – иногда этот интервал может быть несколько меньше или больше, но не превышать

Значения весов могут положительными

или отрицательными, поскольку

окончательные веса после обучения

также могут иметь любой знак.

Значения весов могут положительными

или отрицательными, поскольку

окончательные веса после обучения

также могут иметь любой знак.Продолжительность обучения сети. Предлагается использовать две серии данных во время обучения: серию обучающих образов и серию контрольных образов. Эти две серии являются раздельными. Регулирование веса основано на обучающих образах. Однако во время обучения ошибка вычисляется с использованием контрольных образов. До тех пор пока ошибка для контрольных образов уменьшается, процесс обучения продолжается. При возрастании этой ошибки сеть начинает терять свою способность к обобщению, и в этот момент обучение прекращается.

Количество требуемых обучаемых пар. Для соотношения между числом обучаемых образов Р, количеством регулируемых весов

и

точностью классификации

и

точностью классификации

предложено

использовать следующее выражение:

предложено

использовать следующее выражение:

Например, для

Например, для

многослойная сеть с 80 регулируемыми

весами потребует 800 обучаемых образов,

чтобы быть уверенным в правильной

классификации 90% предъявляемых

контрольных образов.

многослойная сеть с 80 регулируемыми

весами потребует 800 обучаемых образов,

чтобы быть уверенным в правильной

классификации 90% предъявляемых

контрольных образов.Представление данных. Для нейронной сети легче обучиться набору различных состояний, чем отклику с непрерывным значением.

Во многих задачах входные и выходные векторы имеют составляющие в одном и том же диапазоне величин. Вследствие того, что один из членов в выражении для корректировки весов является активацией ячейки предыдущего слоя, нейроны, имеющие нулевую активацию, обучаться не будут. Обучение может быть улучшено в том случае, если входной вектор представлен в биполярной форме, а в качестве функции активации используется биполярная сигмоида (биполярная сигмоида очень близка к функции гиперболического тангенса).

5.

Введение инерционной поправки. Показано,

что поиск минимума функции ошибок

методом градиентного спуска оказывается

достаточно медленным, если скорость

обучения

![]() мала, и приводить к значительным

осцилляциям при большой скорости

мала, и приводить к значительным

осцилляциям при большой скорости

![]()

6.

Модификация функции активации. Диапазон

функции активации должен соответствовать

диапазону целевых значений конкретной

задачи. Бинарная сигмоидная функция

вида

![]() с производной

с производной

![]()

Может быть изменена для перекрытия любого требуемого диапазона с центром при любом значении х и необходимом наклоне.

Сигмоида

может иметь расширенный диапазон, чтобы

отображать значения в интервале

![]() для

любых

для

любых

![]() и

и

![]() .

Для этого нужно ввести параметры

.

Для этого нужно ввести параметры

![]()

Тогда сигмоидная функция:

![]()

имеет требуемые свойства , т.е. диапазон . Ее производная выражается как:

![]()

Наклон

сигмоидной функции может быть изменен

с помощью введенного параметра

![]()

7. Число нейронов в скрытом слое. Подход при выборе скрытых нейронов заключается в том, что на первом этапе число таких нейронов берется заведомо большим, чем требуется, а далее, по мере обучения сети, излишние нейроны убираются. Все нейроны, которые не вносят вклад в решение или дают информацию, не требующуюся в последующем слое, рассматриваются как лишние и удаляются из скрытого слоя. На практике считается, что сеть достигла сходимости, если разность между требуемым и действительным выходами не превышает 0,1. Если два скрытых нейрона дают приблизительно одинаковый выход для всех обучающих примеров, то только один из них действительно необходим, так как оба нейрона переносят одинаковую информацию. После удаления тех ячеек, которые не дают вклада в решение, значения веса уменьшения сети должны быть изменены путем переобучения сети для получения требуемых характеристик.

Классический метод ОРО относится к алгоритмам с линейной сходимостью. Его известными недостатками являются: невысокая скорость сходимости (большое число итераций), возможность сходится не к глобальному, а к локальным решениям. Возможен также паралич сети – большинство нейронов функционируют при очень больших значениях аргумента функции активации, т.е. на пологом участке (т.к. ошибка пропорциональна производной, которая на данных участках мала, то процесс обучения практически замирает). Для устранения этих недостатков были предложены многочисленные модификации алгоритма ОРО.

Обучение без учителя. Главная черта, делающая обучение без учителя привлекательным, - это его «самостоятельность». Процесс обучения, как и в случае с учителем, заключается в подстройке весов синапсов. Очевидно, что подстройка весов синапсов может проводиться только на основании информации, доступной в нейроне, т.е. информации о его состоянии, уже имеющихся весовых коэффициентов и поданном векторе Х. Исходя их этого и по аналогии с известными принципами самоорганизации нервных клеток, построены алгоритмы обучения Хебба и Кохонена. Общая идея данных алгоритмов заключается в том, что в процессе самообучения путем соответствующей коррекции весовых коэффициентов усиливаются связи между возбужденными нейронами.

Типы нейронных сетей

Многослойные нейронные сети – эти сети с сигмоидными передаточными функциями являются наиболее общими, универсальными сетевыми архитектурами. Имеются различные структуры многослойных сетей: с последовательными, перекрестными и обратными связями, с фиксированной и переменной структурой. С ростом числа слоев возрастают как сложность построения сети, так и качество ее работы. Многослойные нейронные сети являются универсальными аппроксиматорами.

Сеть Кохонена – кластерный анализ, распознавание образов, классификация. Слой Кохонена самообучается.

Нейронные сети встречного распространения – распознавание и восстановление образов, сжатие данных (с потерей информации), статистический анализ. Сеть содержит два слоя с последовательными связями: первый слой Кохонена, второй Гроссберга. Преимущества: 1) сеть проста; 2) сеть быстро обучается; сеть дает возможность строить функцию и обратную к ней функцию, что находит применение при решении практических задач. Недостатки. Слабая теоретическая проработка. Сеть не дает возможность строить точные аппроксимации.

Нейронные сети Хопфилда и Хемминга – позволяют просто и эффективно разрешить задачу воссоздания образов по неполной и искаженной информации.

Сети с радиальными базисными функциями (RBF) – двухслойная сеть без обратных связей, которая содержит скрытый слой радиально-симметричных скрытых нейронов (шаблонный слой). Сети RBF моделируют произвольную нелинейную функцию с помощью всего одного промежуточного слоя. Параметры линейной комбинации в выходном слое можно полностью оптимизировать с помощью хорошо известных методов линейной оптимизации, которые работают быстро и не испытывают трудностей с локальными минимумами, так мешающими при обучении с использованием алгортима ОРО. Поэтому сеть RBF обучается на порядок быстрее, чем с использованием алгоритма ОРО. Недостатками сетей RBF являются: сети обладают плохими экстрапалирующими свойствами и получаются весьма громоздкими при большой размерности вектора входов. Модификацией сети RBF является радиальная базисная сеть с нулевой ошибкой.

Другими модификациями являются вероятностные нейронные сети (PNN) и обобщенно-регрессионная нейронная сеть (GRNN).