- •И математической статистике

- •Ч а с т ь III

- •2. Описание случайных процессов и полей

- •3. Представления и преобразования случайных функций

- •4. Стационарность и однородность случайных функций;

- •5. Непрерывность, дифференцируемость и интегрируемость

- •6. Спектральное представление случайных процессов и полей

- •§2. Марковские процессы

- •2.1. Последовательности зависимых испытаний. Цепи Маркова.

- •2.2. Марковские процессы.

- •§3. Элементы теории систем массового обслуживания (смо)

- •3.1. Основные понятия, определения и компоненты моделей смо

- •3.2. Потоки событий.

- •3.3. Классификация смо и их основные характеристики

- •Раздел 2. Вариаты практических заданий задачи для самостоятельного решения

- •Раздел 3. Решения вариатов типовых заданий задача 1.

- •Задача 2.

- •Задача 3.

- •Задача 4.

- •I. Свойства дельта- функции и некоторых других обобщённых функций

- •II. Использование таблиц распределения пуассона при решении задач смо

- •III. Статистические таблицы

- •Примечания:1) функция Лапласа и интеграл ошибоксвязаны соотношением;

- •Содержание

- •Часть III

§2. Марковские процессы

2.1. Последовательности зависимых испытаний. Цепи Маркова.

Ранее (часть I) мы подробно рассмотрели последовательности независимых испытаний. В этом пункте мы рассмотрим пример одного важного случая последовательности зависимых испытаний.

Будем производить ряд последовательных испытаний, в результате каждого из которых может наступить или не наступить некоторое событие А.

Пусть в случае наступления события А при n-м по порядку испытании

вероятность его наступления при (n +1) -м испытании равна а, а в случае его

не наступления при n-м испытании вероятность его наступления при (n +1) –м испытании равна b. Очевидно, 0 ≤ a, b ≤ 1.

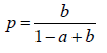

Замечание 2.1. Важность представленного выше результата состоит в том, что это достаточно естественное качественное утверждение получает через формулу доверительного интервала для вероятности p с коэффициентом доверия α вполне определенную количественную интерпретацию:

![]()

Поставим следующую задачу: зная вероятность p1 его наступления при первом по порядку испытании, определить вероятность pn его наступления при каждом n-м испытании.

Пусть

An

- событие,

означающее наступление события А

при n-м

испытании. Тогда, поскольку событие An

и противоположное

ему событие

![]() прикаждом

данном значении n

образуют

полную группу событий. то по формуле

полной вероятности получаем:

прикаждом

данном значении n

образуют

полную группу событий. то по формуле

полной вероятности получаем:

![]()

Согласно введенным выше обозначениям,

![]()

![]()

Поэтому

![]() (2.1.1)

(2.1.1)

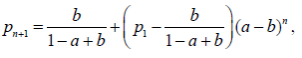

Найдем из уравнений (1) величину вероятности pn как функцию от ве-

личин n (n ≥ 2), a, b и p1 .

Заметим, прежде всего, что величина

решает уравнение

p = ap + b(1− p) , (2.1.2)

в которое превращается уравнение (1) при pn ≡ p для всех n.

Для решения уравнения (1) положим pn = p + pn* , где p – решение урав-

нения (2). Подставляя это в (1), получим для определения pn* рекуррентные соотношения

![]()

откуда, принимая во внимание (2):

![]()

Последнее соотношение, очевидно, дает

![]()

Переходя

от

![]() получим:

получим:

![]()

или

(2.1.3)

(2.1.3)

что и решает нашу задачу.

Примечание. Последняя формула справедлива при a ≠ 1, либо b ≠ 0 . В

том крайнем случае, когда одновременно a =1, b = 0, из (1) получаем сразу

![]()

Этот тривиальный частный случай, очевидно, практически малоинтересен.

Если 0 ≤ a < 1 и 0 < b ≤ 1, то соотношение (3) показывает, между про-

чим, что при n → ∞ общее решение имеет вполне определенный предел, не зависящий от p1 , а именно:

Рассмотренный выше пример последовательности зависимых испыта-ний представляет собой частный случай так называемых цепей Маркова, ко-торые имеют большое прикладное значение.

Пусть дана последовательность дискретных случайных величин ξ1, ξ2, …, ξn, …, имеющих одинаковые конечные или счётные множества возможных значений. Все случайные величины ξk связаны таким образом, что значение, принятое величиной ξk – 1 , вполне определяет закон распределения случайной величины ξk , и этот закон не зависит от значений принятых случайными ξj с j < k – 1. Используя соответствующие условные вероятности можно записать основное свойство цепей Маркова – марковское свойство:

P{ ξk | ξ1, ξ2, …, ξk – 1} = P{ ξk | ξk – 1}

Такая последовательность называется простой цепью Маркова.

Иначе: пусть некоторая физическая система находится в одном из состояний E1, E2, …, Ek, … . В фиксированные моменты времени t1, t2 , …, tn , … система под влиянием случайных факторов может переходить из одного состояния в другое, причём в любой момент времени tk вероятность системе оказаться в наперёд заданном состоянии Ej вполне определяется тем состоянием, в котором она находилась непосредственно перед скачком, и не зависит от всех остальных состояний, в которых эта система находилась до момента tk – 1 ; тогда говорят, что поведение этой системы описывается (или управляется) простой цепью Маркова;

![]()

– вероятность перехода из состояния Ei (в момент tn – 1) в состояние Ej в момент tn называется переходной вероятностью этой цепи.

Замечание 2.2. Можно также ввести понятие сложной цепи Маркова порядка m (m > 1), если вероятность случайной величины ξk (как правило, это значение случайного процесса в момент времени tk) зависит только от m случайных величин непосредственно предшествовавших ξk :

P{ ξk | ξ1, ξ2, …, ξk – 1} = P{ ξk | ξ k – m , ξ k –m + 1, …, ξk – 1.

Так как известна методика, при помощи которой сложная цепь Маркова порядка m может быть сведена к простой цепи Маркова для m-мерного вектора, то можно ограничиться рассмотрением только простых цепей.

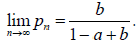

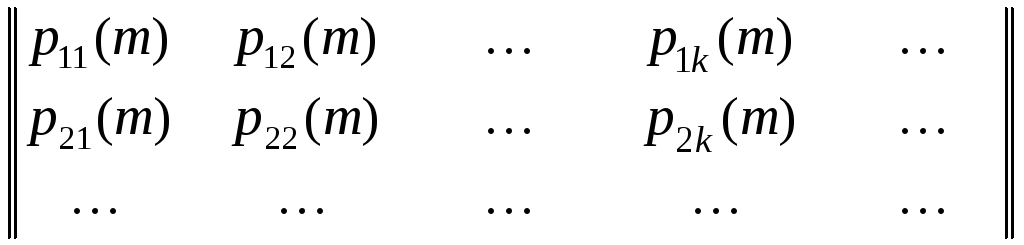

Цепь

Маркова задаётся матрицами

перехода (переходными

матрицами;

матрицами переходных вероятностей)

π(n)

= ![]() ,

элементами которой являются вероятности

перехода в момент tn,

и вероятностями всех состояний системы

в начальный момент времени t0

= 0. Эти вероятности p01,

p02,

…, p0k

, … называются начальными

вероятностями

состояний системы.

,

элементами которой являются вероятности

перехода в момент tn,

и вероятностями всех состояний системы

в начальный момент времени t0

= 0. Эти вероятности p01,

p02,

…, p0k

, … называются начальными

вероятностями

состояний системы.

Замечание 2.3. Правильнее было бы матрицу перехода и сами переходные вероятности запараметризовать двумя параметрами: π(n, m) = || P{ Ej, tn | Ei, tm} ||, определяющими не моменты времени до и после перехода, хотя при мгновенном скачке это не требуется.

Если все переходные вероятности зависят только от разности временных параметров, т. е. π(n, m) = π(n – m), n > m ≥ 0, то цепь Маркова называется однородной.

Если

все переходные вероятности не зависят

от времени (т. е.![]() =

pij

, n

= 1, 2, …), то

цепь Маркова называется стационарной.

Тогда матрица π будет иметь вид, задаваемый

соотношением

=

pij

, n

= 1, 2, …), то

цепь Маркова называется стационарной.

Тогда матрица π будет иметь вид, задаваемый

соотношением

, (2.1.4)

, (2.1.4)

причём условие суммирования выполняется при любом фиксированном j, 0 ≤ pij ≤ 1. Такая матрица называется стохастической. Если, к тому же, и сумма элементов каждого столбца матрицы равна единице, то такую переходную матрицу называют дважды стохастической.

Обозначим через pij(m) – вероятность перехода системы, управляемой однородной цепью Маркова, из состояния Ei в состояние Ej за m «шагов». Матрица перехода через m шагов имеет вид

πm

=

.

.

Тогда (легко доказать по индукции)

πm = πm. (2.1.5)

Вероятность pij(m) удовлетворяет уравнению Маркова

pij(m)

=

![]() , (2.1.6)

, (2.1.6)

где s может принимать любое целое значение из отрезка [0, m].

Замечание 2.4. Уравнение (2.1.6), а чаще его очевидные обобщения и аналоги, называют также уравнением Смолуховского или уравнением Колмогорова - Чепмена.

Безусловная

вероятность pj

(n)

=

![]() называется абсолютной

вероятностью системе

оказаться в момент tn

в состоянии Ej.

называется абсолютной

вероятностью системе

оказаться в момент tn

в состоянии Ej.

Эргодическая

теорема Маркова. Если

существует такое натуральное число n,

что все элементы матрицы πn

= πn

строго

положительные, то для каждого j=1,

2, …, k,…

существует предел

![]() ,

не зависящий отi.

Вероятности pj

называются финальными

вероятностями состояний

системы,

,

не зависящий отi.

Вероятности pj

называются финальными

вероятностями состояний

системы,

![]() ;

;

![]() . (2.1.7)

. (2.1.7)

Финальные вероятности pj являются решением системы линейных уравнений

pj

=

![]() ,

j

= 1, 2, …; pj

> 0,

,

j

= 1, 2, …; pj

> 0,

![]() (2.1.8)

(2.1.8)

Цепь Маркова, для которой существуют финальные вероятности, называется эргодической или регулярной. Если все финальные вероятности строго положительны, цепь называется положительно регулярной.

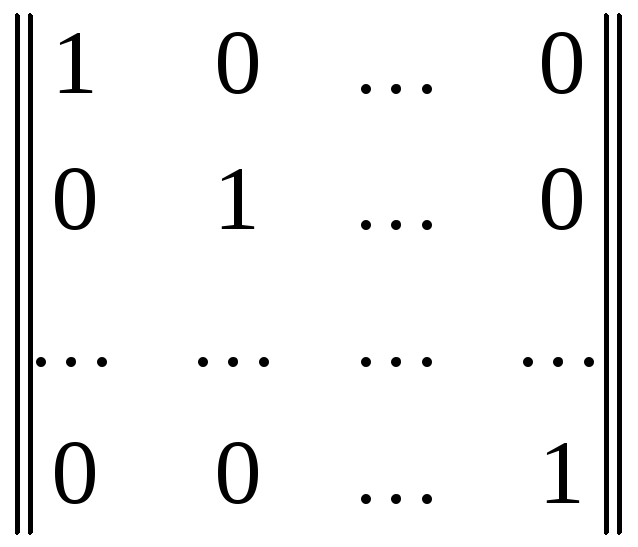

Пусть

E

=

– единичная матрица порядка, равного

порядку переходной матрицы π

(подразумеваются

цепи с конечным числом состояний), а λ

– параметр. Тогда матрица

– единичная матрица порядка, равного

порядку переходной матрицы π

(подразумеваются

цепи с конечным числом состояний), а λ

– параметр. Тогда матрица

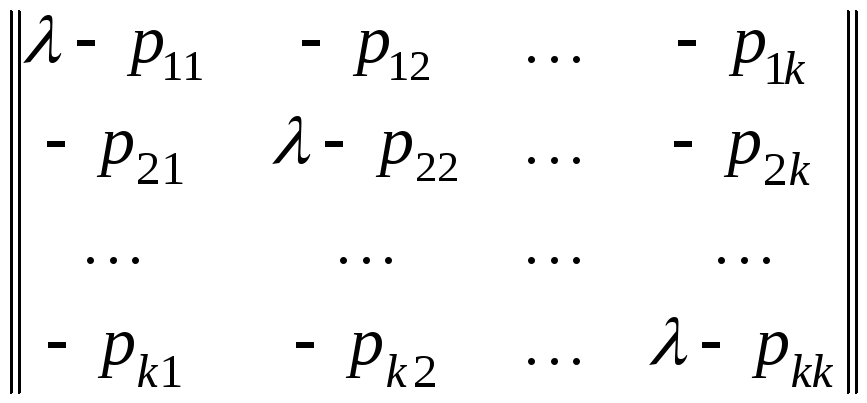

||

λ

E

– π||=

(2.1.9)

(2.1.9)

называется характеристической матрицей данной цепи Маркова. Её определитель обозначается через | λ E – π|, а уравнение

| λ E – π| = 0 (2.1.10)

Называется характеристическим уравнением. Все корни характеристического уравнения называются характеристическими числами матрицы. Одно из них всегда равно 1, а все остальные по модулю не превосходят 1.

Если цепь Маркова эргодична, то все остальные характеристические числа по модулю строго меньше единицы и главные миноры Pj j (λ) характеристической матрицы при λ = 1 строго положительны.

Примечание: главным минором Pj j (λ) называется минор элемента (λ – pj j) характеристической матрицы.

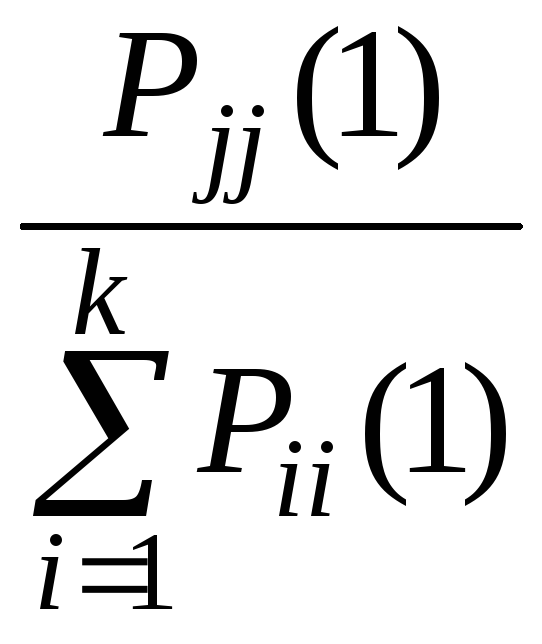

Тогда финальные вероятности pj вычисляются по формулам

pj

=

. (1.2.11)

. (1.2.11)

Состояние

Ei

называется несущественным,

если существует состояние Ej

и целое

число k,

такие, что из состояния Ej

возможен переход в состояние Ei

через k

шагов, но невозможен возврат из Ei

в Ej

ни через какое число шагов: pi

j

(k)

> 0, pj

i

(m)

= 0, m

= 1, 2, … . Если

Ej

– несущественное состояние, то pj

=

![]() = 0 для любогоi.

= 0 для любогоi.

Все остальные состояния называются существенными. Если существуют такие целые числа k и m, что pi j (k) > 0, pj i (m) > 0, то состояния Ei и Ej называются связанными или сообщающимися.

Все существенные состояния системы разбиваются на несвязанные (или изолированные) классы состояний. Все состояния каждого из классов связаны. Попав в данный класс, система в дальнейшем не может выйти из него. Если система находится в несущественном состоянии, то с вероятностью 1 она рано или поздно попадёт в один из классов существенных состояний.

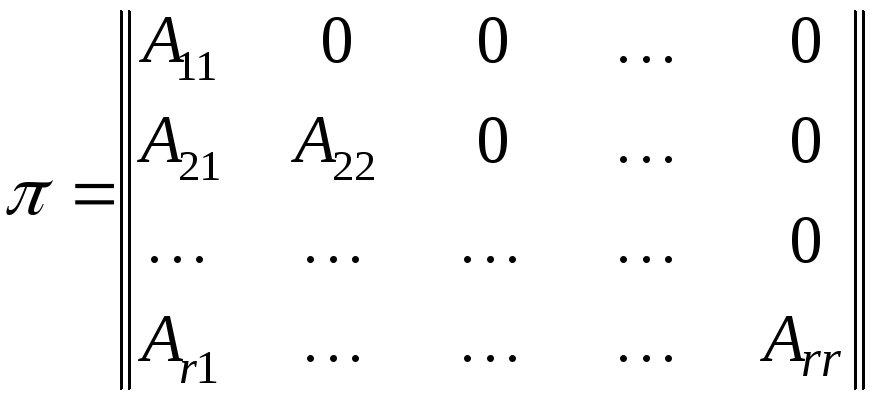

Если все состояния системы разбиваются на классы S(1), S(2), …, S(r) , то переходная матрица цепи Маркова перестановкой соответствующих строк и одновременно столбцов с теми же номерами приводится к виду

, (2.1.12)

, (2.1.12)

где A11, A22, …, Ar r – квадратные матрицы порядков числам состояний соответствующего класса S(j), и более не разложимые подобным образом; нули обозначают подматрицы, все элементы которых равны нулю, а Ai j при i ≠ j – какие-нибудь подматрицы (что получится). Такая матрица называется разложимой. Матрица, которую нельзя привести к подобному виду называется неразложимой. Если все Ai j = 0 при i < j, то матрица называется вполне разложимой.

Состояние Ej называется возвратным, если система из этого состояния с вероятностью 1 с течением времени снова вернётся в это состояние. В противном случае (т. е. когда вероятность возвращения в это состояние меньше 1) состояние называется невозвратным.

Возвратное состояние с бесконечным математическим ожиданием времени возвращения называется нулевым.

Состояние Ej называется периодическим с периодом m, если возвращение в это состояние возможно лишь за число шагов, кратное m > 1, и m есть наименьшее из целых чисел с этим свойством.

Возвратное состояние, не являющееся ни нулевым, ни периодическим, называется эргодическим.