- •Оренбург 2008 г.

- •Оренбург

- •Оглавление

- •Введение

- •Краткая характеристика дисциплины

- •Основные требования к уровню освоения содержания дисциплины

- •Основные понятия информатики История развития информатики

- •Структура современной информатики

- •Информатика как единство науки и технологии

- •Структура современной информатики

- •Место информатики в системе наук

- •Социальные аспекты информатики

- •Правовые аспекты информатики

- •Этические аспекты информатики

- •Общая характеристика процессов сбора, передачи, обработки и накопления информации различные уровни представлений об информации

- •Виды и свойства информации

- •Качество информации

- •Восприятие, сбор, передача обработка и накопление информации

- •Единицы измерения информации

- •Семантическая мера информации

- •Прагматическая мера информации

- •Системы счисления

- •Перевод из десятичной системы счисления в двоичную

- •Восьмеричная и шестнадцатеричная системы

- •Арифметические и логические основы цифровых эвм Почему компьютер считает не так, как мы?

- •Отрицательные числа в компьютере

- •Алгоритмизация и программирование Понятие и свойства алгоритма

- •Правила построения алгоритмов

- •Виды алгоритмов

- •Способы записей алгоритмов

- •3. Описание на каком-либо языке программирования (программа).

- •Блок схема

- •Символы блок-схем

- •Структуры алгоритмов

- •Рекомендуемая литература

Восприятие, сбор, передача обработка и накопление информации

Восприятие информации — процесс преобразования сведений, поступающих в техническую систему или живой организм из внешнего мира, в форму, пригодную для дальнейшего использования. Благодаря восприятию информации обеспечивается связь системы с внешней средой (в качестве которой могут выступать человек, наблюдаемый объект, явление или процесс и т.д.). Восприятие информации необходимо для любой информационной системы.

Современные информационные системы, создаваемые, как правило, на базе ЭВМ, в качестве своей составной части имеют более или менее развитую систему восприятия. Система восприятия информации представляет довольно сложный комплекс программных и технических средств. Для развитых систем восприятия можно выделить несколько этапов переработки поступающей информации: предварительная обработка для приведения входных данных к стандартному для данной системы виду, выделение в поступающей информации семантически и прагматически значимых информационных единиц, распознавание объектов и ситуаций, коррекция внутренней модели мира. В зависимости от анализаторов, входящих в комплекс технических средств системы восприятия, организуется восприятие зрительной, акустической и других видов информации. Кроме того, различают статическое и динамическое восприятие.

Сбор информации — это процесс получения информации из внешнего мира и приведение ее к стандарту для данной информационной системы. Обмен информацией между воспринимающей ее системой и окружающей средой осуществляется посредством сигналов. Сигнал можно определить как средство перенесения информации пространстве и времени. В качестве носителя сигнал: могут выступать звук, свет, электрический ток, магнитное поле и т.п. Сбор информации, как правило, сопровождается ее регистрацией, т.е. фиксацией информации на материальном носителе (документе или машинном носителе).

Передача информации осуществляется различными способами: с помощью курьера, пересылка по почте, доставка транспортными средствами, дистанционная передача по каналам связи. Дистанционная передача по каналам связи сокращает время передачи данных. Для ее осуществления необходимы специальные технические средства. Некоторые технические средства сбора и регистрации, собирая автоматически информацию с датчиков, установленных на рабочих местах, передают ее в ЭВМ.

Дистанционно может передаваться как первичная информация с мест ее возникновения, так и результатная в обратном направлении. В этом случае результатная информация отражается на различных устройствах: дисплеях, табло, печатающих устройствах. Поступление информации по каналам связи в центр обработки в основном осуществляется двумя способами: на машинном носителе и непосредственно в ЭВМ при помощи специальных программных и аппаратных средств.

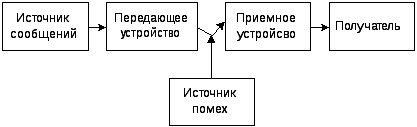

Общая схема передачи информации:

В современных развитых информационных системах машинная обработка информации предполагает последовательно-параллельное во времени решение вычислительных задач. Это возможно при наличии определенной организации вычислительного процесса. Вычислительная задача по мере необходимости обращается с запросами в вычислительную систему. Организация процесса предполагает определение последовательности решения задач и реализацию вычислений. Последовательность решения задается, исходя из их информационной взаимосвязи, когда результаты решения одной задачи используются как исходные данные для решения другой.

Технология электронной обработки информации — человеко-машинный процесс исполнения взаимосвязанных операций, протекающих в установленной последовательности с целью преобразования исходной (первичной) информации в результатную. Операция представляет собой комплекс совершаемых технологических действий, в результате которых информация преобразуется. Технологические операции разнообразны по сложности, назначению, технике реализации, выполняются на различном оборудовании многими исполнителями.

Хранение и накопление информации вызвано многократным ее использованием, применением постоянной информации, необходимостью комплектации первичных данных до их обработки.

Хранение информации осуществляется на машинных носителях в виде информационных массивов, где данные располагаются по установленному в процессе проектирования группировочному признаку.

Кодирование информации

С целью засекречивания информации

применяется ее

кодирование.

С

незапамятных времен появились коды

в

виде

криптограмм (по-гречески — тайнопись).

целью засекречивания информации

применяется ее

кодирование.

С

незапамятных времен появились коды

в

виде

криптограмм (по-гречески — тайнопись).

Самый первый код связан с именем изобретателя телеграфного аппарата Сэмюэля Морзе и известен как азбука Морзе. Каждой букве или цифре в азбуке Морзе соответствует своя последовательность из кратковременных (называемых точками) и длительных (тире) сигналов, разделяемых паузами.

Способы кодирования информации следующие: символьный, лингвистический, табличный, графический. Любой способ кодирования характеризуется наличием основы (алфавит, тезаурус, спектр цветности, система координат, основание системы счисления и т.п.) и правил конструирования информационных образов на этой основе.

Часто информация кодируется числовыми кодами в той или иной системе счисления, особенно это актуально при представлении информации в компьютере Естественно, что одно и тоже количество разрядов в разных системах счисления может передать разное число состояний отображенного объекта, что можно представить в виде соотношения

N = mn

где N – число всевозможных отображаемых состояний ;

m – основание системы счисления ( разнообразие символов применяемых в алфавите);

n – число разрядов (символов) в сообщении

Пример. По каналу связи передается n – разрядное сообщение, использующее m различных символов. Так как количество всевозможных кодовых комбинаций будет N = mn, то при равновероятности появления любой из них количество информации, приобретенной абонентом в результате получения сообщения, будет I = log N = n log m – формула Хартли. Если в качестве основания логарифма принять m, то I = n. В данном случае количество информации ( при условии полного априорного незнания абонентом содержания сообщения ) будет равно объему данных I = Vд , полученных по каналу связи.

Для неравновероятных состояний системы всегда I < VД = n .

Наиболее часто используются двоичные и десятичные логарифмы. Единицами измерения в этом случае будут бит и дит.

Коды, использующие два различных элементарных сигнала, называются двоичными. Если отвлечься от физической природы сигналов, удобно обозначать их символами 0 и 1. Тогда кодовые слова можно представлять как последовательность из нулей и единиц.

Существует много кодов: двоичный код обмена информации ДКОИ, восьмеричный код обмена информацией КОИ-8, в современных персональных компьютерах информация представляется в коде ASCII (American Standard Code for Information Interchange) — американский стандартный код для обмена информацией. В России используется так называемая альтернативная ASCII кодировка, содержащая символы русского алфавита.

При вводе информации в компьютер каждый символ - буква русского или латинского алфавита, цифра, знак пунктуации или действия кодируется определенной последовательностью из восьми двоичных цифр в соответствии с таблицей кодирования. Комбинация из 8 бит называется байтом, или слогом.

Вероятностный подход

к определению количества информации

Важно при создании передающих систем знать, какое количество информации пройдет через эту передающую систему.

Количественный подход — наиболее разработанная ветвь теории информации. В соответствии с этим определением совокупность 100 букв — фраза из 100 букв из газеты, пьесы Шекспира или теоремы Эйнштейна — имеет в точности одинаковое количество информации.

Такое определение количества информации является полезным и практичным. Оно соответствует задаче инженера связи, который должен передать всю информацию, содержащуюся в поданной телеграмме, вне зависимости от ценности этой информации для адресата. Передающей системе необходимо передать нужное количество информации за определенное время.

Оценка количества информации основывается на законах теории вероятностей, точнее, определяется через вероятности событий.

Сообщение о событии, у которого только два одинаково возможных исхода, содержит одну единицу информации называемую битом. Выбор единицы информации не случаен. Он связан с наиболее распространенным двоичным способом ее кодирования при передаче и обработке.

Известно, что количество информации зависит от вероятностей тех или иных исходов события. Если событие, как говорят ученые, имеет два равновероятных исхода, это означает, что вероятность каждого исхода равна 1 : 2. Такова вероятность выпадения «орла» или «решки» при бросании монеты. Если событие имеет три равновероятных исхода, то вероятность каждого равна 1 : 3. Следует отметить, что сумма вероятностей всех исходов всегда равна единице: ведь какой-нибудь из всех возможных исходов обязательно наступит.

Событие может иметь и неравновероятные исходы. Так, при футбольном матче между сильной и слабой командами вероятность победы сильной команды велика — например, 4 : 5. Вероятность ничьей намного меньше, например 3 : 0. Вероятность же поражения совсем мала.

Количество информации — это мера уменьшения неопределенности некоторой ситуации. Различные количества информации передаются по каналам связи, и количество проходящей информации не может быть больше его пропускной способности. Ее определяют по количеству информации за единицу времени.