Ответы на экзамен Котюргина / saaty

.pdf

|

|

|

|

|

|

|

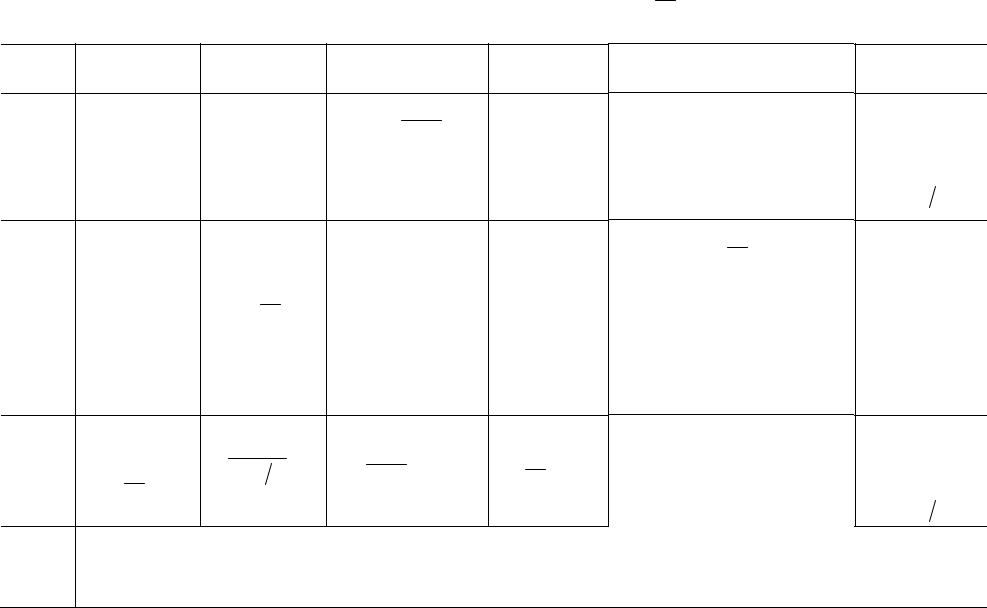

Таблица 9.1. Четыре метода возмущений при a ωj |

= g |

ij |

|

|

|

|

|

|

|||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

ij ω |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

i |

|

|

|

|

|

|

|

|

|

|

Предположения |

|

|

|

|

|

|

|

|

|

|

Предположения |

|

|

|

|

|

|

|

|

|

|

||

|

в случае согла- |

|

Задача |

|

Решение |

|

|

|

Задача |

|

|

|

Решение |

|||||||||||

|

|

|

в общем случае |

|

|

|

|

|

|

|||||||||||||||

|

сованности |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

n |

ω |

|

|

|

ω = |

|

aij |

|

|

n |

|

|

|

|

|

|

|

Нормализован- |

||

|

gij =1, |

∑aij |

|

= n , |

|

|

|

, |

|

|

|

|

ωi |

|

|

|

|

ный правый соб- |

||||||

Арифме- |

i |

|

i |

|

n |

n |

∑aij |

= λmax , |

|

|

||||||||||||||

тическое |

n |

|

|

j=1 |

ωj |

|

|

|

∑aij |

∑gij = λmax , |

ωj |

|

|

ственный вектор; |

||||||||||

∑gij |

= n |

i =1, …, n , |

|

|

|

i=1 |

|

j=1 |

|

j=1 |

|

|

|

|

|

индекс согласо- |

||||||||

среднее |

|

n |

|

|

|

j =1, …, n |

|

|

Aω = λmaxω |

|

|

|

ванности |

|||||||||||

|

j=1 |

|

|

|

Aω = nω |

|

∑ωi =1 |

|

|

|

|

|

(λmax −n) (n −1) |

|||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||

|

|

|

|

|

|

|

|

|

|

i=1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

n |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

∏aij ωj = µ |

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

j=1 |

|

ω |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

i |

|

|

|

|

|

Средне- |

gij =1, |

n |

ω |

|

|

|

|

|

|

|

|

Обычно заменяется на критерий |

То же, что и в |

|||||||||||

геомет- |

n |

|

|

∏aij |

|

j |

=1 , |

|

|

|

|

1/ n |

n |

логарифмических средних квад- |

случае согласо- |

|||||||||

рическое |

|

|

ωi |

|

|

|

|

∏gij = µ |

ратов: |

|

|

|

|

|

|

|

|

ванности; не |

||||||

∏gij |

=1 |

j=1 |

|

|

ωi = (naij ) |

|

|

|

|

|

|

|

|

|||||||||||

по стро- |

|

i =1, …, n |

|

|

|

|

|

j=1 |

n |

|

|

|

|

|

ω |

|

2 |

имеется меры |

||||||

кам |

j=1 |

|

|

|

|

|

|

|

|

|

|

|

|

−log |

= |

согласованности |

||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

min ∑ |

log aij |

ω |

i |

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

i, j=1 |

|

|

|

|

j |

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

min log2 µ |

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

n |

|

|

|

|

|

|

|

|

|

|

|

|

|

Нормализован- |

|

gij =1, |

n |

1 |

|

|

|

∑aij |

|

n |

n |

|

|

|

|

|

|

|

|

|

ный левый собст- |

||||

Гармони- |

∑i=1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

венный вектор; |

|||||||||

n |

1 |

|

a u |

|

u |

= n , |

ui |

= i=1 |

|

, |

∑ui =1 |

∑ 1 = λmax |

|

|

uA = λmaxu |

|

|

|

||||||

ческое |

|

j |

|

|

|

|

|

|

индекс согласо- |

|||||||||||||||

среднее |

∑ |

gij |

= n |

|

ij |

|

i |

|

aij |

|

|

i=1 |

j=1 gij |

|

|

|

|

|

|

|

|

|

ванности |

|

|

uA = nu |

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||||

|

j=1 |

|

|

(обратное первому |

|

|

|

|

|

|

|

|

|

|

(λmax −n) (n −1) |

|||||||||

|

|

|

|

|

|

|

|

|

|

случаю наверху) |

|

|

|

|

|

|

|

|

|

|

||||

Средне- |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

геомет- |

|

|

|

|

|

|

|

|

То же, что и для среднегеометрического по строчкам |

|

|

|

|

|

||||||||||

рическое |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

по таб- |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

лицам |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

216 |

|

|

|

|

|

|

|

|

|

|

|