- •Вопрос 2.

- •Часть 1.Количественная мера информации для равновозможных событий

- •Часть 2. Мера р. Хартли

- •Вопрос 3.

- •Вопрос 4.

- •Вопрос 5.

- •Вопрос 6. Свойства энтропии источника дискретных сообщений

- •Вопрос 7. Энтропия источника совместных сообщений

- •Вопрос 8. Что такое условная энтропия?

- •Вопрос 9.

- •Вопрос 10. Свойства количественной меры информации при неполной достоверности результатов опыта.

- •Вопрос 11. Вычисление количественной меры информации для двоичного канала с помехами.

- •Вопрос 12. Как оценивается избыточность источника сообщений?

- •Вопрос 13.

- •Вопрос 23.

- •Вопрос 24. Приведите модель двоичного канала с шумами

- •Вопрос 25.

- •Вопрос26. Формула Шеннона для аналогового канала с шумами.

- •Вопрос 27. Энтропия источника при наличии коррелятивных связей между двумя соседними символами

- •Вопрос 28. Принципы помехоустойчивого кодирования. Кодовое расстояние.

- •Вопрос 29. Вероятность ошибочного приема кодовой информации для простого двоичного кода и для кода с исправлением ошибок кратности t.

- •Вопрос 30. Простейшие избыточные коды.

- •Вопрос 31. Групповой код Хемминга. Принципы построения. Синдром ошибки. Коды с обнаружением и исправлением ошибок. Код хемминга

- •Вопрос 32. Определение числа проверочных элементов.

- •Вопрос 33. Определение проверочных элементов, входящих в каждую группу. Исправляющая способность кода хемминга

Вопрос 4.

Энтропия источника дискретных (цифровых) сообщений

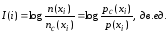

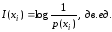

Формула

(1.2),

,

устанавливает непосредственную связь

между количеством информации, получаемой

о некотором i-м

событии (xi)

в результате опыта, и изменением

вероятности этого события до (p(xi))

и после (pc(xi))

опыта.

,

устанавливает непосредственную связь

между количеством информации, получаемой

о некотором i-м

событии (xi)

в результате опыта, и изменением

вероятности этого события до (p(xi))

и после (pc(xi))

опыта.

Эта связь может быть обобщена и на случай, когда имеется некоторое конечное множество независимых событий xi с разными априорными вероятностями p(xi). Такие события называют разновозможными событиями. Указанную зависимость получил Клод Шеннон, существенно развивший количественную меру информации соотечественника Р. Хартли.

Рассмотрим

некоторое конечное множество

событий

событий

.

Такими событиями могут быть, например,

состояния регистра данных компьютера.

Допустим, что эти события независимы и

несовместны. Независимость означает,

что наступление одного события не

зависит от того, было или не было до

этого другое событие. Несовместность

означает, что разные события не могут

происходить одновременно. Например,

после аналого-цифрового преобразования

(АЦП) происходит запись результата,

представляющего собой двоичное

n-разрядное

число в регистр. Регистр не может

находиться одновременно в двух разных

состояниях, т.е. в него нельзя одновременно

записать два разных числа.

.

Такими событиями могут быть, например,

состояния регистра данных компьютера.

Допустим, что эти события независимы и

несовместны. Независимость означает,

что наступление одного события не

зависит от того, было или не было до

этого другое событие. Несовместность

означает, что разные события не могут

происходить одновременно. Например,

после аналого-цифрового преобразования

(АЦП) происходит запись результата,

представляющего собой двоичное

n-разрядное

число в регистр. Регистр не может

находиться одновременно в двух разных

состояниях, т.е. в него нельзя одновременно

записать два разных числа.

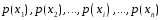

Пусть

априорные вероятности событий xi

соответственно равны

.

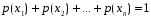

Для несовместных событий выполняется

условие

.

Для несовместных событий выполняется

условие

.

.

Это означает, что в течение некоторого наблюдаемого отрезка времени всегда происходит лишь одно из этих событий.

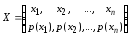

Множество с известным распределением вероятностей его элементов будем называть ансамблем, который можно представить как

. (1.4)

. (1.4)

Ансамбль

(1.4) рассматривается как некоторая модель

физической системы, которая может

находиться в

различных состояниях или в которой

может происходить

различных состояниях или в которой

может происходить

различных событий (вспомните ранее

упомянутый регистр данных). В этой модели

мы рассматриваем случай, когда эти

события независимы и несовместны.

различных событий (вспомните ранее

упомянутый регистр данных). В этой модели

мы рассматриваем случай, когда эти

события независимы и несовместны.

Используя

формулу (1.2), можно сказать, что достоверное

сообщение [ ]

о том, что из всех событий происходит

именно событие

]

о том, что из всех событий происходит

именно событие ,

несет в себе количество информации,

равное

,

несет в себе количество информации,

равное

(1.5)

(1.5)

Из (1.5) следует, что сообщение о событии несет тем большее количество информации, чем меньше априорная вероятность этого события. Данное положение хорошо согласуется с интуитивным представлением об информации. Нас нисколько не удивит сообщение в разгар лета, что завтра ожидается теплый день. Неопределенность такого события ничтожно мала, и поэтому услышанное нами сообщение содержит очень мало нового – мало информации. Если бы мы вдруг услышали сообщение, что завтра ожидаются заморозки, то в этом сообщении (если оно, конечно, достоверно) для нас содержалось бы гораздо больше информации. Таким образом, формула (1.5) согласуется с нашими интуитивными представлениями.

Формула (1.5) указывает, что в конечном ансамбле Х сообщения xi о разных событиях несут в общем случае разное количество информации. При решении большинства задач, связанных с построением систем передачи и преобразования информации, оказалось достаточным знать среднее количество информации, приходящееся на одно достоверное сообщение.

Среднее

значение аср

нескольких (n)

случайных величин a1,

a2,,…,an

в соответствии с правилами теории

вероятностей [Вентцель Е.С., Овчаров

Л.А. Теория вероятностей и ее инженерные

приложения. – М.: Высшая школа, 2010. – 480

с.] может быть определено как математическое

ожидание (МО):

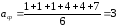

Пример. Имеется ряд чисел: 1, 1, 1, 4, 4, 7. Определить среднее значение.

Из арифметики вы знаете, что надо все сложить и поделить на общее количество чисел

.

.

А теперь запишем это в таком виде

На предыдущей лекции мы с вами определили, что называется отношение числа элементарных исходов, благоприятствующих данному событию, к числу всех равновозможных исходов опыта, в котором может появиться это событие, есть вероятность события.

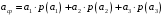

В нашем примере имеется 3 события: а1 – появление числа «1» с вероятностью р(а1)=3/6, а2 – появление числа «4» с вероятностью р(а2)= 2/6 и а3 –появление числа «7» с вероятностью р(а3)=1/6. Таким образом, можем записать выражение для среднего значения

,

,

т.е. получили приведенную выше формулу для МО.

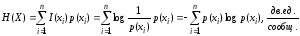

В

нашем случае случайными величинами

являются частные меры количества

информации

,

поэтому среднее количество информации,

приходящееся на одно достоверное

сообщение определяется как

,

поэтому среднее количество информации,

приходящееся на одно достоверное

сообщение определяется как

.

.

С

учетом формулы (1.5), определяющей

,

получим

,

получим

.

(1.6)

.

(1.6)

В

данном случае

является мерой количества информации,

приходящейся в среднем на одно достоверное

сообщение о событии

является мерой количества информации,

приходящейся в среднем на одно достоверное

сообщение о событии

при передаче и преобразовании большого

числа

при передаче и преобразовании большого

числа

таких сообщений.

таких сообщений.

Эту

мера количества информации предложил

К. Шеннон. Она более общая, чем мера

Хартли, и получила название энтропии

конечного ансамбля дискретных событий

.

.