- •Вопрос 2.

- •Часть 1.Количественная мера информации для равновозможных событий

- •Часть 2. Мера р. Хартли

- •Вопрос 3.

- •Вопрос 4.

- •Вопрос 5.

- •Вопрос 6. Свойства энтропии источника дискретных сообщений

- •Вопрос 7. Энтропия источника совместных сообщений

- •Вопрос 8. Что такое условная энтропия?

- •Вопрос 9.

- •Вопрос 10. Свойства количественной меры информации при неполной достоверности результатов опыта.

- •Вопрос 11. Вычисление количественной меры информации для двоичного канала с помехами.

- •Вопрос 12. Как оценивается избыточность источника сообщений?

- •Вопрос 13.

- •Вопрос 23.

- •Вопрос 24. Приведите модель двоичного канала с шумами

- •Вопрос 25.

- •Вопрос26. Формула Шеннона для аналогового канала с шумами.

- •Вопрос 27. Энтропия источника при наличии коррелятивных связей между двумя соседними символами

- •Вопрос 28. Принципы помехоустойчивого кодирования. Кодовое расстояние.

- •Вопрос 29. Вероятность ошибочного приема кодовой информации для простого двоичного кода и для кода с исправлением ошибок кратности t.

- •Вопрос 30. Простейшие избыточные коды.

- •Вопрос 31. Групповой код Хемминга. Принципы построения. Синдром ошибки. Коды с обнаружением и исправлением ошибок. Код хемминга

- •Вопрос 32. Определение числа проверочных элементов.

- •Вопрос 33. Определение проверочных элементов, входящих в каждую группу. Исправляющая способность кода хемминга

Вопрос 10. Свойства количественной меры информации при неполной достоверности результатов опыта.

Некоторые свойства количественной меры информации источника дискретных сообщений при неполной достоверности результатов опыта

1.7.1. Количество

информации, содержащееся в опытах

относительно интересующих нас событий

относительно интересующих нас событий

,

не превосходит энтропии событий

,

не превосходит энтропии событий

,

т.е.

,

т.е.

.

.

Этот максимум достигается лишь при выполнении условия (1.18), т.е. если результат опыта достоверно определяет событие.

1.7.2.  ,

т.е. энтропия может быть истолкована

как информация, содержащаяся в событиях

(опытах) относительно самих себя. Из

этого непосредственно вытекает, что

энтропия событий есть наибольшее

количество информации об этих событиях,

которое можно получить из опытов.

,

т.е. энтропия может быть истолкована

как информация, содержащаяся в событиях

(опытах) относительно самих себя. Из

этого непосредственно вытекает, что

энтропия событий есть наибольшее

количество информации об этих событиях,

которое можно получить из опытов.

1.7.3.  ,

если

,

если

при всех значениях

при всех значениях

и

и

,

что имеет место для статистически

независимых событий. Это означает, что

количество получаемой информации равно

нулю, когда исход опытов не зависит от

исхода событий. Данный вывод полностью

согласуется с нашими интуитивными

представлениями.

,

что имеет место для статистически

независимых событий. Это означает, что

количество получаемой информации равно

нулю, когда исход опытов не зависит от

исхода событий. Данный вывод полностью

согласуется с нашими интуитивными

представлениями.

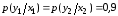

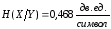

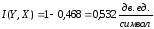

Вопрос 11. Вычисление количественной меры информации для двоичного канала с помехами.

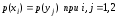

Применительно

к этому примеру рассмотрим двоичный

канал передачи данных, который был

упомянут ранее в примере (раздел 1.3). В

отличие от него будем считать, что на

выходе этого канала из-за искажений,

обусловленных помехами и сбоями в

аппаратуре, принятые символы двоичного

канала оказываются недостоверными,

т.е. вероятность правильного приема

символов оказывается меньше 1 и в

соответствии с формулой (1.18). Пусть будем

иметь

.

Вероятность ошибочного приема символов

двоичного кода

.

Вероятность ошибочного приема символов

двоичного кода

.

Для рассматриваемого примера примем

.

Для рассматриваемого примера примем

.

.

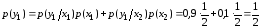

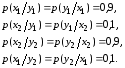

Для

вычисления

воспользуемся (1.22), (1.16) и (1.6). Из (1.6)

получаем

воспользуемся (1.22), (1.16) и (1.6). Из (1.6)

получаем

.

.

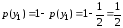

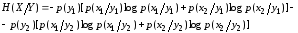

В данном случае

,

,

.

.

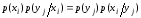

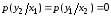

Условные

вероятности

найдем из равенства

найдем из равенства

и, следовательно,

.

.

Для нашей задачи имеем

и, следовательно,

или

По аналогии с (1.16) получаем

или

,

,

.

.

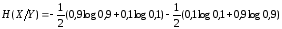

В итоге согласно (1.22) имеем

.

.

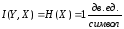

Если бы в рассматриваемом случае двух событий опыт был достоверным, т.е. выполнялись условия

,

,

то очевидно, что

.

.

Таким образом, недостоверность опыта, когда вероятность ошибочного исхода составляет 0,1, приводит к уменьшению количества информации, получаемой из опыта, почти в 2 раза.

Вопрос 12. Как оценивается избыточность источника сообщений?

Избыточность источника сообщений

Вспомним

теперь, что энтропия характеризует

количество информации, приходящееся в

среднем на одно сообщение. Рассмотренные

ранее примеры показывают, что при

одинаковом количестве различных символов

(сообщений) количество информации,

приходящееся на одно сообщение, может

быть различным в зависимости от

статистических характеристик источника.

Энтропия источника максимальна и равна

,

если символы вырабатываются с равными

вероятностями; если же это не так и

некоторые символы повторяются часто,

а другие редко, то энтропия источника

уменьшается, а при появлении дополнительных

коррелятивных связей между символами

энтропия становится еще меньшей. Это

положение хорошо согласуется с интуитивным

представлением о количестве информации,

вырабатываемой тем или иным источником.

Так, например, если из предшествовавшего

опыта свойства лектора или докладчика

известны настолько хорошо, что слушатели

с высокой степенью достоверности знают,

о чем он будет говорить, то количество

информации, сообщаемой таким лектором,

будет очень малым, несмотря на большое

количество произнесенных слов.

,

если символы вырабатываются с равными

вероятностями; если же это не так и

некоторые символы повторяются часто,

а другие редко, то энтропия источника

уменьшается, а при появлении дополнительных

коррелятивных связей между символами

энтропия становится еще меньшей. Это

положение хорошо согласуется с интуитивным

представлением о количестве информации,

вырабатываемой тем или иным источником.

Так, например, если из предшествовавшего

опыта свойства лектора или докладчика

известны настолько хорошо, что слушатели

с высокой степенью достоверности знают,

о чем он будет говорить, то количество

информации, сообщаемой таким лектором,

будет очень малым, несмотря на большое

количество произнесенных слов.

Для того чтобы выяснить, насколько хорошо в источнике сообщений используются разные символы (а источник будет тем лучше, чем больше информации он будет вырабатывать), вводится параметр, называемый избыточностью и равный

.

(1.24)

.

(1.24)

При

этом

есть максимальная энтропия или наибольшее

количество информации, которое может

приходиться на один символ источника

при данном числе

есть максимальная энтропия или наибольшее

количество информации, которое может

приходиться на один символ источника

при данном числе

используемых символов.

используемых символов.

Из

(1.24) видно, что при

энтропия источника

энтропия источника ,

т.е. источник генерирует максимальное

количество информации на символ. Если

,

т.е. источник генерирует максимальное

количество информации на символ. Если

,

то

,

то

и, следовательно, информация, вырабатываемая

источником, равна нулю. В общем случае

и, следовательно, информация, вырабатываемая

источником, равна нулю. В общем случае

.

Чем меньше избыточность

.

Чем меньше избыточность

,

тем рациональнее работает источник,

тем большее количество информации он

вырабатывает.

,

тем рациональнее работает источник,

тем большее количество информации он

вырабатывает.

Следует,

однако, иметь в виду, что не всегда нужно

стремиться к тому, чтобы

.

Некоторая избыточность бывает полезной

для обеспечения надежности передачи,

регистрации и других преобразований

информации. Известно, например, что

лектора, который не повторяет или не

разъясняет более подробно, на примерах

отдельные положения, слушать и

конспектировать значительно труднее,

чем лектора, который в разумной мере

пользуется этими приемами.

.

Некоторая избыточность бывает полезной

для обеспечения надежности передачи,

регистрации и других преобразований

информации. Известно, например, что

лектора, который не повторяет или не

разъясняет более подробно, на примерах

отдельные положения, слушать и

конспектировать значительно труднее,

чем лектора, который в разумной мере

пользуется этими приемами.

Если не различать буквы «е» и «ё», а также мягкий и твердый знаки, то в русском алфавите всего 31 буква, к ним нужно добавить еще пробел между словами, так что всего получается 32 символа. Если бы все символы были равновероятны, то энтропия такого языка была бы равна

.

.

В действительности, однако, вероятности различных символов различны; так, например, вероятность буквы «о» равна приблизительно 0,09, а буквы «ф» – 0,002. Кроме того, между символами имеют место значительные коррелятивные связи.

Проведенные исследования дают следующие значения энтропии:

при учете разной вероятности отдельных символов

,

,

при учете коррелятивных связей между двумя символами

,

,

при учете коррелятивных связей между тремя символами

.

.

Таким образом, можно утверждать, что избыточность русского языка

.

.

Анализ

английского языка с учетом коррелятивных

связей, распространяющихся на восемь

соседних букв, показал, что избыточность

его

.

Если учесть коррелятивные связи,

распространяющиеся на достаточно

большое число букв, то можно, по-видимому,

убедиться что избыточность русского и

других европейских языков более 50.%.

Наличие этой избыточности позволяет

легко исправлять отдельные ошибки или

восстанавливать пропуски букв и даже

слогов без искажения текста.

.

Если учесть коррелятивные связи,

распространяющиеся на достаточно

большое число букв, то можно, по-видимому,

убедиться что избыточность русского и

других европейских языков более 50.%.

Наличие этой избыточности позволяет

легко исправлять отдельные ошибки или

восстанавливать пропуски букв и даже

слогов без искажения текста.