УМК по ТВ и МС

.pdfПродифференцировав по p равенство ( p + q)n = ∑nk =0 Cnk pk qn−k , получим

n( p + q)n−1 = ∑nk =0 kCnk pk −1qn−k .

Умножим обе части последнего равенства на p: np( p + q)n−1 = ∑nk =0 kCnk pk qn−k = M [ξ],

откуда, учитывая, что p + q =1, получим M[ξ] = np( p + q)n−1 = np .

Пример 2.9. Пусть случайная величина Π имеет пуассоновское распределение с параметром λ > 0. Определим ее математическое ожидание:

|

∞ |

|

λk |

|

∞ |

λk −1 |

|

|

λ λ2 |

|

|||

|

∑ |

|

|

|

∑ |

|

|

|

|

|

|

|

|

M[Π] = |

|

k |

k! |

e−λ = λe−λ |

k =1 (k −1)! |

= λe−λ 1 |

+ |

1! |

+ |

2! |

+ ... = λe−λeλ = λ. |

||

|

k=0 |

|

|

|

|

|

|

||||||

2.5. Общие свойства математического ожидания

Предложение 2.5. Имеют место свойства:

1)Если случайная величина ξ = ξ(ω) постоянна, то есть, для некоторой константы c R имеет место P{ω: ξ(ω) = c} =1, то M[ξ] = c ;

2)Если ω ξ(ω) ≥ 0 , то математическое ожидание M[ξ] неотрицательно при

условии, что оно существует;

3) |

M[cξ] = cM[ξ] для любого c R; |

||

4) |

Если M[ξ1 ],K, M[ξn ] |

существуют, то M[ξ1 +K+ξn ] = M[ξ1 ] +K+ M[ξn ]; |

|

5) |

Если M[ξ]и M[η] существуют и ξ(ω) ≤ η(ω) для всех ω Ω, то M[ξ] ≤ M[ξ] . |

||

|

Доказательство. Свойства 1), 2) и 3) очевидны. Докажем 4). |

||

|

M[ξ1 +... + ξn ] = ∑(ξ1 (ω) +... + ξn (ω))P(ω) = |

||

|

|

ω Ω |

|

|

|

= ∑ ξ1 (ω)P(ω) +K+ ∑ξn (ω)P(ω) = M[ξ1 ] +... + M[ξn ] . |

|

|

|

ω Ω |

ω Ω |

|

Докажем 5). Так как при каждом ω имеет место M[ξ] ≤ M[η], то |

||

|

∑ ξ(ω)P(ω) ≤ ∑η(ω)P(ω) , что влечет M[ξ] ≤ M[ξ]. |

||

|

ω Ω |

ω Ω |

|

Замечание 2.3. Свойства 3) и 4) называются свойствами линейности математического ожидания.

2.6. Дисперсия случайной величины

Определение 2.9. Дисперсией случайной величины ξ называется число

D[ξ] =& M [ξ − M [ξ]]2 . |

(2.3) |

Очевидно, что дисперсия всегда неотрицательна. |

|

Замечание 2.4. Иногда для вычислений более удобна формула, |

|

D[ξ] = M[ξ2 ] − M[ξ]2 , |

(2.4) |

31

которая легко выводится из свойств математического ожидания.

Дисперсия характеризует степень рассеяния значений случайной величины относительно ее математического ожидания. Если все значения случайной величины тесно сконцентрированы около ее математического ожидания и большие отклонения от математического ожидания маловероятны, то такая случайная величина имеет малую дисперсию. Если значения случайной величины рассеяны и велика вероятность больших отклонений от математического ожидания, то такая случайная величина имеет большую дисперсию. Величина

σξ = D[ξ] называется средним квадратическим отклонением значений слу-

чайной величины ξ относительно ее математического ожидания.

Пример 2.10. Дисперсия бернуллиевской случайной величины:

D[ξ] =1 (p − M[ξ])2 + 0 ((1 − p) − M[ξ])2 =1 ( p − p)2 + 0 (1 − 2 p)2 =1.

Пример 2.11. Найдем дисперсию пуассоновской случайной величины. Воспользуемся формулой (2.4). Вначале получим формулу для M[Π2]:

|

|

|

∞ |

|

|

k |

|

|

|

∞ |

|

k |

|

|

|

|

∞ |

|

k |

|||||

M[Π2 |

] = ∑k 2 λ |

e−λ = e−λ ∑ |

|

kλ |

|

|

= e−λ ∑ |

[(k −1) +1]λ |

|

= |

||||||||||||||

|

|

|

|

|

|

|

(k −1)! |

|

||||||||||||||||

|

|

k=0 |

|

k! |

|

|

k =1 (k −1)! |

|

|

k=1 |

|

|

|

|||||||||||

|

∞ |

|

|

k −2 |

|

|

∞ |

|

k −1 |

|

|

|

|

|

|

|

|

|

|

|

||||

= λ2e−λ ∑ |

|

λ |

|

|

|

|

+ λe−λ ∑ |

λ |

|

|

|

= |

|

|

|

|

|

|

|

|

||||

|

|

|

|

|

|

(k −1)! |

|

|

|

|

|

|

|

|

||||||||||

|

k=2 (k − 2)! |

|

|

k=1 |

|

|

|

|

|

|

|

|

|

|||||||||||

|

|

+ |

λ |

+ |

λ2 |

|

|

+ λe−λ |

|

+ |

λ |

+ |

λ2 |

|

|

= λ2e−λeλ |

+ λe−λeλ = λ2 + λ . |

|||||||

= λ2e−λ 1 |

|

|

|

|

+ ... |

1 |

|

|

|

+ ... |

||||||||||||||

|

|

|

|

1! |

|

2! |

|

|

|

|

|

|

|

1! |

|

2! |

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

Теперь D[Π] = M[Π2 ] − M[Π]2 = (λ2 + λ) − λ2 = λ .

Пример 2.12. Найти дисперсию числа очков, выпавших при бросании игральной кости.

Решение. Распределение случайной величины ξ – «число очков, выпавших на игральной кости» и ее математическое ожидание получены в примере 2.4. Воспользуемся формулой (2.4).

M [ξ2 ] = ∑k 2 pk =12 |

1 |

|

+ 2 |

2 |

1 |

+ |

32 |

1 |

|

+ 42 |

|

1 |

|

+ 52 |

1 |

+ 62 |

|

1 |

= |

91 |

. |

|||||||||

6 |

|

6 |

6 |

|

6 |

|

6 |

6 |

6 |

|||||||||||||||||||||

k |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||

Теперь D[ξ] = M[ξ |

2 |

] − M[ξ] |

2 |

= |

91 |

|

|

7 |

2 |

= |

91 |

− |

49 |

= |

182 −147 |

= |

35 |

. |

|

|||||||||||

|

|

6 |

|

− |

2 |

|

6 |

4 |

|

|

12 |

12 |

|

|||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||

2.7. Общие свойства дисперсии

Предложение 2.6. Имеют место свойства:

1) Дисперсия не изменится, если к случайной величине прибавить константу: D[ξ + c] = D[ξ]. В частности, если случайная величина η постоянна, то есть,

η(ω) = c, то D[η] = 0;

32

2) Постоянный множитель можно выносить за знак дисперсии, возводя при этом его в квадрат: D[cξ] = c2D[ξ];

3) |

D[∑n |

ξi ] = ∑n |

D[ξi ] + 2 ∑cov(ξi ,ξ j ) , где cov( , ) |

– ковариация, опреде- |

|

i=1 |

i=1 |

1≤i< j≤n |

|

ляемая по формуле |

|

|||

|

|

|||

|

cov(ξ,η) =& M [(ξ − M [ξ])(η − M [η])] # |

(2.5) |

||

Замечание 2.5. Легко видеть, что cov(ξ,ξ) = D[ξ], и что ковариация линейна по каждому из своих аргументов, а именно c1, c2 R :

cov(c1ξ1 +c2ξ2 ,η) = c1 cov(ξ1,η) +c2 cov(ξ2 ,η) , cov(ξ,c1η1 + c2η) = c1 cov(ξ,η1) + c2 cov(ξ,η2 ) .

Пользуясь свойствами математического ожидания, можно показать, что

ковариацию можно вычислять по формуле |

|

cov(ξ, η) = M[ξη] − M[ξ]M[η]. |

(2.6) |

Замечание 2.6. Особо отметим, что, в отличие от математического ожидания, дисперсия – это нелинейная операция, как видно из свойств 2) и 3). Ее можно условно назвать квадратичной функцией по аналогии с квадратичными формами в линейной алгебре.

2.8. Индикаторы событий

Здесь мы рассмотрим простейшие случайные величины, тесно связанные с событиями. Они удобны при изучении произвольных случайных величин.

Определение 2.10. Индикатором события A называется случайная величина

1, |

ω A , |

|

|

I A (ω) = |

ω A . |

0 , |

Другими словами, IA = 1, если происходит событие A, и IA = 0, если событие A не происходит. Таким образом, IA является бернуллиевской случайной величи-

ной (см. определение 2.4).

Замечание 2.7.

M[I A ] =1 P(I A (ω) =1) + 0 P(I A (ω) = 0) = P(ω A) = P(A) ,

D[I A ] = M[I A2 ] −(M[I A ])2 = P(A) −[P(A)]2 .

Предложение 2.7. Пусть дана последовательность случайных величин ξ1, … , ξn такая что все математические ожидания M[ξi] существуют и

∑i∞=1 M [ξi ]< ∞. Тогда:

a) P{ω: ∑i∞=1ξi (ω) – абсолютно сходится} = 1;

33

б) существует математическое ожидание M[∑i∞=1ξi ];

в) M[∑i∞=1ξi ] = ∑i∞=1 M[ξi ]. #

Предложение 2.8. Пусть D1, … , Dn, … – последовательность несовместных событий: i ≠ j Di I D j = . Рассмотрим случайную величину

ξ = ∑ yk ID . |

|

(2.7) |

|||||

k |

k |

|

|

||||

|

|

|

|

|

|

|

|

Предположим, что ∑ |

|

yk |

|

P(Dk ) < ∞. Тогда M [ξ] = ∑ yk P(Dk ) . |

|||

|

|

||||||

|

k |

|

|

|

|

k |

|

Доказательство. Данное утверждение есть следствие предложения 2.7. |

|||||||

Действительно, обозначим |

ξk = yk ID . Заметим, что |

M [ξk ] = yk P(Dk ) . Легко |

|||||

|

|

|

|

|

|

k |

|

проверить, что условия предложения 2.7 выполнены, т.е. M[ξ] = ∑i∞=1 M[ξi ].

Замечание 2.8. Обратим внимание на то, что в бесконечной сумме (2.7) при любом фиксированном ω только одно слагаемое отлично от нуля. Это вытекает из несовместности событий Di.

2.9. Независимость случайных величин

Определение 2.11. Дискретные случайные величины ξ1, … , ξn называются независимыми, если для всех x1, … , xn R

P{ξ1 = x1,K,ξn = xn }= P{ξ1 = x1}KP{ξn = xn },

т.е. x1,..., xn R набор {ξ1 = x1},...,{ξn = xn} есть набор независимых событий.

Предложение 2.9. События A1, … , An независимы тогда и только тогда, когда случайные величины I A1 ,..., I An взаимно независимы. #

Предложение 2.10. Предположим, что:

1)ξ1, … , ξn − независимые дискретные случайные величины,

2)Существуют математические ожидания M[ξi].

Тогда M [ξ1 Kξn ] = M [ξ1 ]KM [ξn ] .

Доказательство. Для простоты рассмотрим лишь случай n = 2 . Обозначим ξ1 = ξ, ξ2 = η. Пусть ξ и η имеют следующие распределения:

ξ |

x1 |

x2 |

P |

p1 |

P2 |

|

|

|

η |

z1 |

z2 |

P |

q1 |

q2 |

… |

xk |

… |

… |

pk |

… |

|

|

|

… |

zk |

… |

… |

qk |

… |

Пусть Aj ={ω: ξ(ω) = x j }, Bk |

={ω: η(ω) = zk }. Имеют место представления |

|||

ξ = ∑ x j I A |

j |

, η = ∑ zk IB . |

(2.8) |

|

j |

k |

k |

|

|

|

|

|

||

34

Заметим, что I

ξη = ∑∑

j k

Aj IBk = I Aj IBk . Следовательно,

x j zk I A |

j |

IB |

= ∑x j zk I A B . |

(2.9) |

|

|

k |

j,k |

j k |

|

|

|

|

|

|

|

|

Аналогично замечанию 2.8, при любом фиксированном ω в бесконечных суммах (2.8) содержится не более одного ненулевого слагаемого, так что с произведением рядов в (2.9) нет никаких проблем. Так как, если ( j, k) ≠ ( j′, k′) то

(Aj Bk ) I(Aj′Bk′) = . Поэтому можем воспользоваться доказанным выше пред-

ложением 2.8: M[ξη] = ∑x j zk P(Aj Bk ) . Поскольку ξ и η независимы, то

j,k

P( Aj Bk ) = P{ξ = x j ,η = zk } = P{ξ = x j } P{η = zk } = P( Aj )P(Bk ) .

Следовательно,

M [ξη] = ∑x j zk P( Aj )P(Bk ) = ∑x j P( Aj ) ∑zk P(Bk ) = M[ξ]M[η].

j,k |

j |

k |

Предложение 2.11. Если ξ и η независимы, то cov(ξ, η) = 0. |

||

Доказательство. |

Действительно, по |

предложению M[ξη] = M[ξ]M[η] в |

силу независимости ξ и η. С другой стороны, согласно (2.6) cov(ξ, η) = 0.

2.10. Некоррелированность случайных величин

Определение 2.12. Случайные величины ξ и η называются некоррелированными, если cov(ξ, η) = 0.

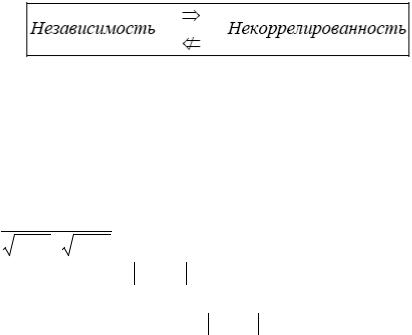

Замечание 2.9. Соотношение между некоррелированностью и независимостью случайных величин можно записать в виде:

Прямая импликация была установлена в предложении 2.11. Пример некоррелированных, но зависимых случайных величин будет приведен в § 4.4.

Таким образом, если ковариация отлична от нуля, то это свидетельствует о зависимости случайных величин. Для того чтобы иметь количественный показатель того, насколько сильно зависят друг от друга случайные величины, часто используют коэффициент корреляции:

ρ(ξ,η) = |

Cov(ξ,η) . |

(2.10) |

|

D[ξ] D[η] |

|

Оказывается, что всегда ρ(ξ, η) ≤1. Это можно доказать, применяя хорошо

известное в линейной алгебре неравенство Коши−Буняковского. Более того, из этого неравенства вытекает, что если ρ(ξ,η) =1, то случайные величины ξ и η

линейно зависимы: c1,c2 R, c12 +c22 > 0 : c1ξ+c2η = 0 .

35

Замечание 2.10. Линейная зависимость случайных величин ξ и η является частным случаем их функциональной зависимости, то есть зависимости вида f (ξ(ω),η(ω)) = 0 , где f – некоторая (необязательно линейная) функция двух ве-

щественных переменных. Из вышесказанного следует, что коэффициент корреляции хорошо отражает степень линейной зависимости между случайными величинами. Вместе с тем, позже будет показано, что коэффициент корреляции может быть совершенно «нечувствителен» к функциональной зависимости

(см. замечание 4.2).

Замечание 2.11. Если ξ1, … , ξn независимы, то D[∑in=1ξi ] = ∑in=1 D[ξi ] .

Вытекает из п. 3) предложения 2.6 и предложения 2.11.

Пример 2.13. Рассмотрим схему Бернулли для последовательности из n независимых испытаний. Введем случайные величины ξ1, … , ξn, которые являются независимыми и имеют бернуллиевское распределение

1, |

с вероятностью p, |

ξi = |

с вероятностью 1 – p. |

0, |

Число успехов в последовательности n независимых испытаний можно записать в виде νn = ξ1 + ... + ξn . Тогда математическое ожидание и дисперсия числа

успехов νn будут соответственно равны

M [νn ] = M [ξ1 ] +K+ M[ξn ] = np ; D[νn ] = D[ξ1 ] +K+ D[ξn ] = np(1− p) .

Пример 2.14. Случайные величины ξ и η независимы. Известны дисперсии этих величин: D[ξ] = 5; D[η] = 9. Найти дисперсию случайной величины

ϕ = 2ξ − η + 5.

Решение. Используя свойства дисперсии (см. предложение 2.6), получим

D[ϕ] = D[2ξ − η + 5] = 22 D[ξ] + (−1)2 D[η] = 4 5 + 9 = 29 .

Пример 2.15. Доказать, что для независимых случайных величин ξ и η справедливо равенство: D[ξ − η] = D[ξ] + D[η].

Решение. Воспользовавшись свойствами дисперсии, получим

D[ξ − η] = D[ξ + (−η)] = D[ξ] + D[(−1) η] =

= D[ξ] + (−1)2 D[η] = D[ξ] + D[η] .

2.11. Предельные теоремы для схемы Бернулли

Выше приведено значительное число точных результатов, относящихся к последовательности независимых испытаний Бернулли и связанному с ней биномиальному распределению. Мы знаем, что число успехов νn в последовательности из n независимых испытаний Бернулли, можно представить в виде νn = ξ1 +... + ξn , где ξ1,...,ξn – независимые одинаково распределенные бернул-

36

лиевские случайные величины. Мы знаем в явном виде распределение νn , а именно,

Pn, p (k) =& P{νn =k} =Cnk pk (1 − p)n−k ,

где p – вероятность успеха в единичном испытании.

Вместе с тем, во многих задачах приходится находить вероятности Pn,p(k) при больших значениях n. Это может вызвать значительные вычислительные трудности ввиду громоздкости биномиальных коэффициентов Cnk и необходимости возводить числа p и (1 − p) в высокие степени.

Пример 2.16. Определим вероятность получить не менее десяти успехов в 1000 испытаний схемы Бернулли с вероятностью успеха 0,003. Вероятность этого события равна любому из выражений:

1000 |

|

9 |

|

∑C1000k |

(0,003)k (0,997)1000−k |

=1 − ∑C1000k (0,003)k (0,997)1000 |

−k . |

k =10 |

|

k =0 |

|

Вычисление даже одного слагаемого в этих выражениях весьма проблематично. Ниже мы рассмотрим две важные предельные ситуации, когда биномиаль-

ное распределение может быть приближено другими распределениями.

2.11.1. Пуассоновское приближение

Рассмотрим последовательность серий:

{E11}; {E21, E22}; {En1, En2 , ..., Enn}; ...,

в которой события одной серии взаимно независимы между собой и каждое из них имеет вероятность pn, зависящую только от номера серии n.

Предложение 2.12. (Предельная теорема Пуассона). Пусть pn → 0 при n → ∞ таким образом, что npn → λ, где λ > 0 – заданное число. Тогда для лю-

бого фиксированного k

Pn, pn (k) − λkk! e−λ →0 .

Другими словами, в описанном предельном переходе биномиальные вероятности Pn,p(k) аппроксимируются пуассоновским распределением.

Доказательство. Для краткости будем считать n → ∞, pn = λ/ n . Тогда

|

|

|

k |

λ |

k |

− |

λ n−k |

= |

|

n(n −1)...(n − k +1) λ |

k |

|

− |

λ n−k |

= |

||||||||||||||||||||

P |

λ (k) =Cn |

|

|

|

|

1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1 |

|

|

||||||||

|

|

|

|

|

|

|

|

|

|

k! |

|

|

|

|

|

|

|||||||||||||||||||

n, n |

|

|

n |

|

|

|

n |

|

|

|

|

|

|

|

|

|

|

|

|

n |

|

|

|

|

n |

|

|

||||||||

|

= |

λk |

|

|

− |

λ n |

|

n(n −1)...(n − k +1) |

|

− |

λ −k |

= |

|

|

|

|

|

|

|

||||||||||||||||

|

k! |

1 |

|

|

|

|

|

|

|

nk |

|

|

1 |

|

|

|

|

|

|

|

|

||||||||||||||

|

|

|

|

|

n |

|

|

|

|

|

|

|

|

|

|

|

|

n |

|

−k |

|

|

|

|

|

|

|||||||||

|

|

λk |

|

|

|

|

|

λ n |

|

|

|

1 |

|

− |

k −1 |

|

|

1 − |

λ |

|

→ |

λk |

|

−λ |

|

||||||||||

|

= |

|

|

|

1 |

− |

|

|

|

1 |

|

1 |

− |

|

... 1 |

|

|

|

|

|

|

|

|

e |

|

, |

|||||||||

|

|

|

|

|

|

|

|

|

|||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

k! |

|

|

|

||||||||

|

|

k! |

|

|

|

n |

|

|

|

|

|

n |

|

|

n |

|

|

|

|

n |

|

|

|

|

|

|

|

||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

поскольку выражение в квадратных скобках стремится к единице, если k фиксировано, а n →∞.

37

Пользуясь данной теоремой, можно приближенно посчитать вероятность получить не менее десяти успехов в 1000 испытаний схемы Бернулли с вероятностью успеха 0,003 из примера 2.13. Поскольку n = 1000 «велико», а p = 0,003 «мало», то, взяв λ = np = 3, можно написать

9 |

k |

|

k |

|

1000−k |

|

9 |

3k |

|

−3 |

∞ |

3k |

|

−3 |

|

1 − ∑C1000 |

(0,003) |

|

(0,997) |

|

≈1 |

− ∑ |

|

e |

|

= ∑ |

|

e |

|

= |

|

|

|

k! |

|

k! |

|

||||||||||

k=0 |

|

|

|

|

|

|

k=0 |

|

|

k=10 |

|

|

|

||

= табличное значение Π2(10) ≈ 0,001. (2.11)

Замечание 2.12. Приведенная формулировка теоремы Пуассона ничего не говорит о скорости сходимости биномиального распределения к предельному пуассоновскому закону. Осталось решить, достаточно ли n = 103 «велико», а, p = 0,003 «мало», чтобы заменить точную вероятность P(vn = k) на приближен-

ное значение λk e−λ . Для этого нужно уметь оценивать разницу между этими k!

двумя вероятностями.

Ответ на этот вопрос можно дать, воспользовавшись следующей теоремой.

Предложение 2.13. (Теорема Пуассона с оценкой погрешности).

Пусть A {0,1,2,...,n} − произвольное множество целых неотрицательных

чисел, vn − число успехов в n испытаниях схемы Бернулли с вероятностью успеха p, λ = np. Тогда

P(vn A) − ∑λk |

e−λ |

= |

∑Cnk pk (1− p)n−k − ∑λk |

e−λ |

≤ np2 = |

λ2 |

# |

|

k A k! |

|

|

k A |

k A k! |

|

|

n |

|

Данная теорема предоставляет нам возможность самим решать, достаточно ли n «велико», а p «мало», руководствуясь полученной величиной погрешности. Какова же погрешность в (2.11)? Имеем:

∞ |

3k |

e |

−3 |

= |

|

9 |

k |

(0,003) |

k |

(0,997) |

1000−k |

− |

∞ |

3k |

e |

−3 |

≤ |

P(v1000 ≥10) − ∑ |

k! |

|

1 |

− ∑C1000 |

|

|

∑ |

k! |

|

||||||||

k=10 |

|

|

|

|

k=0 |

|

|

|

|

|

|

k=10 |

|

|

|

||

≤ np2 = 0,009.

0,009 (при вероятности около 0,001). Во всяком случае, что искомая вероятность никак не больше, чем

Пример 2.17. База отправила в магазин 500 изделий, вероятность повреждения изделия в пути 0,002. Найти вероятность того, что в пути будут повреждены 5 изделий.

Решение. По условию n = 500 – велико, p = 0,002 – мало, поэтому воспользуемся пуассоновским приближением. Имеем λ = np = 500 0,002 = 1, k = 1. Сле-

довательно искомая вероятность равна, Р500; 0,002(5) ≈ 15 e−1 = 1 ≈ 0,003.

5! 5!e

38

2.11.2. Нормальное приближение

Рассмотрим случай, когда число испытаний в схеме Бернулли растет ( n → ∞), а вероятность успеха в единичном испытании p фиксированна.

Предложение 2.14. (Локальная теорема Муавра–Лапласа). Если вероят-

ность p наступления события A в каждом испытании постоянна и отлична от 0 и 1, то вероятность Pn,p(k) того, что событие A произойдет k раз в достаточно большом числе n независимых испытаниях, приближенно равна:

Pn, p (k) ≈ |

|

f (t) |

, |

|

(2.12) |

||

np(1 − p) |

|

||||||

|

|

|

|

|

|||

|

1 |

e− |

t 2 |

|

k − np |

|

|

где f (t) = |

2 |

, t = |

|

. # |

|||

|

2π |

|

|

|

|

np(1− p) |

|

Пример 2.18. В некоторой местности из каждых 100 семей 80 имеют холодильники. Найти, используя локальную формулу Муавра–Лапласа (2.12) вероятность того, что из 400 семей 300 имеют холодильники.

Решение. Вероятность того, что семья имеет холодильник, равна p = 80/100 = 0,8. Отсюда получим:

t = |

300 − 400 0,8 |

= −2,5 , f (t) = f (−2,5) = |

1 |

e− |

2,52 |

≈ 0,0175 , |

||

2 |

||||||||

|

400 0,8 0,2 |

|

|

2π |

|

|

|

|

P |

|

(300) ≈ |

0,0175 |

= 0,0175 ≈ 0,0022 . |

|

|

||

400;0,8 |

400 0,8 0,2 |

8 |

|

|

|

|

||

|

|

|

|

|

|

|||

Пусть в условиях данного примера необходимо найти вероятность того, что от 300 до 360 семей (включительно) имеют холодильники. В этом случае по теореме сложения вероятность искомого события

P400;0,8 (300 ≤ k ≤ 360) = P400;0,8 (300) + P400;0,8 (301) + K+ P400;0,8 (360) .

Непосредственный расчет ввиду большого числа слагаемых достаточно громоздок. В таких случаях используется следующая теорема.

Предложение 2.15. (Интегральная теорема Муавра–Лапласа). Если веро-

ятность p наступления события A в каждом испытании постоянна и отлична от 0 и 1, то вероятность того, что число vn наступления события A в n независимых

испытаниях заключено в пределах от c до d, при n → ∞ : |

|||||||||||||

|

Pn, p (c ≤ vn ≤ d ) |

→ F0 (t2 ) − F0 (t1 ) , |

|

|

(2.13) |

||||||||

где |

t = c − np |

, |

t |

|

|

d − np |

, |

|

(t) = 1 t e− |

x2 |

|||

2 |

= |

F |

2 |

dx − кривая Гаусса, зна- |

|||||||||

|

|||||||||||||

|

1 |

np(1− p) |

|

|

|

np(1− p) |

|

0 |

2π −∫∞ |

|

|

||

|

|

|

|

|

|

|

|

|

|

||||

чения которой определяются из таблиц. #

39

Замечание 2.13. Предел (2.13) является универсальным, т.к. он не зависит от параметра p, который имеется в допредельном выражении. На самом деле, эта теорема является частным случаем другой, еще более универсальной, цен-

тральной предельной теоремы, которую рассмотрим в § 5.2.

Замечание 2.14. В предельном переходе « n → ∞, p фиксировано» каждая «индивидуальная» вероятность Pn,p(k) стремится к нулю. Асимптотика этого стремления описывается локальной предельной теоремой, которую можно найти в большинстве учебников. Что же касается интегральной предельной теоремы Муавра-Лапласа, то можно сказать, что она описывает предельное поведение сумм большого числа таких малых вероятностей. Действительно,

|

νn −np |

|

= |

∑ |

Pn, p (k) , |

P c ≤ |

≤d |

||||

|

np(1 − p) |

|

|

np+c np(1−p)≤k≤np+d np(1−p) |

|

таким образом, в последней сумме содержится много (порядка

n ) слагаемых.

n ) слагаемых.

Пример 2.19. По данным примера 2.18 вычислить вероятность того, что от

300до 360 (включительно) семей из 400 имеют холодильники. Решение. Применяем интегральную теорему Муавра–Лапласа:

t = 300 − 400 0,8 |

= −2,5 , |

t |

2 |

= 360 −400 0,8 |

= 5,0 , |

|

|

|||||

1 |

400 |

0,8 0,2 |

|

|

|

|

400 |

0,8 0,2 |

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

F (−2,5) = 1 −2,5 e− |

x2 |

|

|

|

F (5,0) = 1 5,0 e− |

x2 |

||||||

2 |

dx = 0,00621, |

2 |

dx =1,0 , |

|||||||||

|

0 |

2π −∫∞ |

|

|

|

|

|

|

0 |

2π −∫∞ |

|

|

|

|

|

|

|

|

|

|

|

|

|

||

P400;0,8 (300 ≤ vn ≤ 360)≈ F0 (5,0) − F0 (−2,5) =1 − 0,00621 = 0,99379 .

2.11.3. О применимости предельных теорем в схеме Бернулли

Следует различать ситуации, когда к схеме Бернулли можно применить пуассоновскую, а когда нормальную аппроксимации. Из формулировок теорем Пуассона и Муавра-Лапласа можно вывести следующие общие правила:

•если n велико, а np не велико, следует пользоваться пуассоновским приближением;

•если n велико и np(1−p) велико, то можно применять нормальное приближение.

На практике в ситуации, когда n имеет порядок сотен, поступают следующим образом: если np ≤ 10, то применяют пуассоновское приближение; если же np(1−p) ≥ 20, то пользуются нормальной аппроксимацией.

Пример 2.20. Вероятность найти белый гриб среди прочих равна 1/4. Какова вероятность того, что: а) среди 300 грибов белых будет 75; б) белых грибов будет не менее 50 и не более 100?

40