- •1. Суть и этапы управления на предприятии. Особенности их автоматизации.

- •2. Суть и особенности процессного подхода. Описание бизнес-процессов.

- •3. Информационные системы в управлении предприятием и их составляющие. Задачи, решаемые кис.

- •4. Системы управления ресурсами предприятия (erp): назначение, их состав и классификация, история возникновения.

- •5. Задачи erp-систем и их основные функциональные возможности.

- •6. Типовая архитектура erp-систем. Классификация.

- •7. Примеры erp-систем, преимущества, проблемы и этапы их внедрения.

- •8. Особенности, архитектура, преимущества и возможности системы Microsoft Dynamics Axapta.

- •9. Особенности и основные возможности решения «1с:Предприятие» по управлению торговлей.

- •10. Основные модули решения «1с:Предприятие» по управлению торговлей и примеры их использования.

- •11. Основные функциональные возможности приложений по автоматизации складского учета.

- •12. Бизнес-процессы торговой организации: виды и их особенности.

- •Раздел 2.

- •13. Суть и особенности online-продаж.

- •14. Online-продажи: безопасность, компоненты, процедура, преимущества и недостатки.

- •15. Основные этапы и особенности открытия и функционирования интернет-магазина в рб.

- •16. Каталоги и интернет-магазины для организации электронных продаж.

- •17. Основные модули и автоматизируемые процессы системы PrestaShop.

- •Раздел 3.

- •19. Логические и функциональные блоки crm-систем и их использование.

- •22. Роль и место crm-систем в erp-системах.

- •23. Использование и особенности e-crm. Типовая функциональная структура.

- •24. Структура и основные функциональные возможности Terrasoft crm.

- •Раздел 4.

- •25. Виды компьютерной графики. Кодирование графической информации.

- •26. Основные инструменты и структура программы Adobe Photoshop. Примеры использования инструментов.

- •27. Flash-технологии – назначение, особенности и составляющие. Типы анимации во Flash.

- •Раздел 5.

- •28. Типовая структура и особенности аналитических информационных систем.

- •29. Понятие и концепция хранилищ данных.

- •30. Модели хранилищ данных и основные компоненты хранилищ данных.

- •31. Технология olap, olap-куб – основные понятия.

- •32. Архитектура olap-систем, таблицы фактов, таблицы измерений. Способы реализации многомерной модели.

- •Раздел 6.

- •33. Понятие, задачи Data Mining и связи с другими дисциплинами.

- •34. Методы Data Mining. Визуальные инструменты Data Mining.

- •35. Проблемы и вопросы Data Mining. Области применения.

- •36. Метод «деревья решений».

- •37. Метод «кластеризации».

- •38. Особенности проектов Data Mining, типовая структура аналитических систем.

- •39. Основные этапы процесса Data Mining, общая схема анализа данных.

- •40. Методы эффективной работы с большими данными для Data Mining.

- •41. Deductor – принципы работы и структура платформы. Возможности взаимодействия с другими системами.

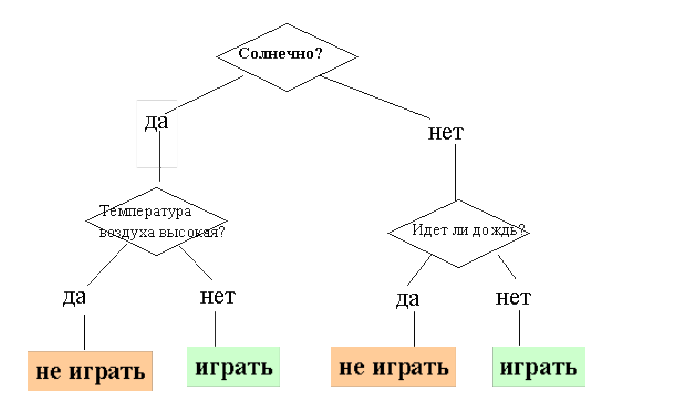

36. Метод «деревья решений».

Возникновение – 50-е годы. Метод также называют деревьями решающих правил, деревьями классификации и регрессии. Это способ представления правил в иерархической, последовательной структуре.

Пример.

Преимущества метода:

-интуитивность деревьев решений;

-возможность извлекать правила из базы данных на естественном языке;

-не требует от пользователя выбора входных атрибутов;

-точность моделей;

-разработан ряд масштабируемых алгоритмов;

-быстрый процесс обучения;

-обработка пропущенных значений;

-работа и с числовыми, и с категориальными типам данных.

Процесс конструирования:

Основные этапы алгоритмов конструирования деревьев:

-построение или создание дерева (treebuilding);

-сокращение дерева (tree pruning).

Критерии расщепления:

-мера информационного выигрыша (informationgainmeasure)

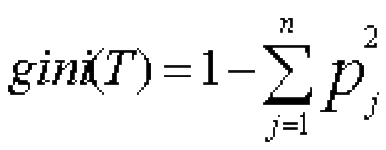

-индекс Gini, т.е.gini(T), определяется по формуле:

- Большое дерево не означает, что оно подходящее.

Остановка построения дерева.

Остановка – такой момент в процессе построения дерева, когда следует прекратить дальнейшие ветвления.

Варианты остановки:

-ранняя остановка;

-ограничение глубины дерева;

-задание минимального количества примеров.

Сокращение дерева или отсечение ветвей:

Критерии:

-точность распознавания

-ошибка.

Алгоритмы. CART.

-CART (Classification and Regression Tree)

-разработан в 1974-1984 годах четырьмя профессорами статистики

-CARTпредназначен для построения бинарного дерева решений.

Особенности:

-функция оценки качества разбиения;

-механизм отсечения дерева;

-алгоритм обработки пропущенных значений;

-построение деревьев регрессии.

Алгоритмы. С4.5

-строит дерево решений с неограниченным количество ветвей у узла.

-дискретные значения => только классификация

-каждая запись набора данных ассоциирована с одним из предопределенных классов => один из атрибутов набора данных должен являться меткой класса.

-количество классов должно быть значительно меньше количества записей в исследуемом наборе данных.

Перспективы и методы:

- разработка новых масштабируемых алгоритмов;

-метод деревьев – иерархическое, гибкое средство предсказания принадлежности объектов к определенному классу или прогнозирования значений числовых переменных.

-качество работы зависит как от выбора алгоритма, так и от набора исследуемых данных.

-чтобы построить качественную модель, необходимо понимать природу взаимосвязи между зависимыми и независимыми переменными и подготовить достаточный набор данных.

37. Метод «кластеризации».

Кластеризация – это автоматическое разбиение элементов некоторого множества на группы (кластеры) по принципу схожести.

Много практических применений в информатике и других областях:

-анализ данных (DataMining);

-группировка и распознавание объектов;

-извлечение и поиск информации.

Общая схема кластеризации:

1. выделение характеристик.

-выбор свойств, характеризующих объекты:

А) количественные характеристики (координаты, интервалы…);

Б) качественные характеристики (цвет, статус, воинское звание….).

- уменьшение размерности пространства, нормализация характеристик.

-представление объектов в виде характеристических векторов.

2. определение метрики.

-метрика выбирается в зависимости от:

А) пространства, где расположены объекты;

Б) неявных характеристик кластеров.

3. разбиение объектов на группы.

4. представление результатов.

Обычно используется один из следующих способов:

-представление кластеров центроидами;

-представление кластеров набором характерных точек;

--представление кластеров их ограничениями.

Общая схема кластеризации одна, но существуем много различных реализаций этой схемы.

Алгоритмы кластеризации:

-иерархические алгоритмы;

-минимальное покрывающее дерево;

-k-Meansалгоритм (алгоритмk-средних);

-метод ближайшего соседа;

-алгоритмы нечеткой кластеризации;

-применение нейронных сетей;

-генетические алгоритмы;

-метод закалки.

Какой алгоритм выбрать?

-генетические алгоритмы и искусственные нейронные сети хорошо распараллеливаются.

-генетические алгоритмы и метод закалки осуществляют глобальный поиск, но метод закалки сходится очень медленно.

-генетические алгоритмы хорошо работают только для одно- (двух-) мерных объектов, зато не требуется непрерывность координат.

-k-meansбыстро работает и прост в реализации, но создает только кластеры, похожие на гиперсферы.

-иерархические алгоритмы дают оптимальное разбиение на кластеры, но их трудоемкость квадратична.

-на практике лучше всего зарекомендовали себя гибридные походы, где шлифовка кластеров выполняется методом k-Means, а первоначальное разбиение – одним из более сильных методов.