- •Билет 2

- •Билет 3

- •Билет 4

- •Билет 5

- •Билет 6

- •Билет 7

- •Совместные и несовместные события. Зависимые и независимые события. Классическое и статистическое определение вероятности.

- •Задачи решаемые сппр в медицине. Пассивные, полуактивные и активные сппр. Основные компоненты активных сппр. Примеры.

- •Задача.

- •Математическое ожидание дискретного распределения

- •Математическое ожидание абсолютно непрерывного распределения

- •Билет 15

- •Билет 18

- •Основные функции субд

- •Билет 24

- •III. Сравнение двух малых групп с попарно-зависимыми вариантами:

Билет 3

Определение информации. Формула для количественного определения информации. Единицы измерения информации.

Информация — значимые сведения о чём-либо, когда форма их представления также является информацией, то есть имеет форматирующую функцию в соответствии с собственной природой.

Предметом

изучения науки информатика являются

именно данные: методы их создания,

хранения, обработки и передачи[3].

А сама информация, зафиксированная в

данных, её содержательный смысл интересны

пользователям информационных систем,

являющимся специалистами различных

наук и областей деятельности: медика

интересует медицинская информация,

геолога — геологическая, предпринимателя

— коммерческая и тп. (в том числе

специалиста по информатике интересует

информация по вопросам работы с

данными).Количество

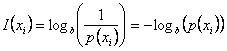

информации ![]() в

отдельно взятом единичном

сообщении

в

отдельно взятом единичном

сообщении![]() определяется

величиной, обратной вероятности появления

сообщения

определяется

величиной, обратной вероятности появления

сообщения ![]() и

вычисляется в логарифмических единицах

[2]:

и

вычисляется в логарифмических единицах

[2]:

|

. |

(4.1) |

Логарифмическая

мера, впервые предложенная в 1928 г.

английским ученым Р. Хартли, обладает

свойством аддитивности, что соответствует

нашим интуитивным представлениям об

информации. Кроме того, при ![]() количество

информации, вычисленное по (4.1), равно

нулю, что соответствует принятому

определению информации. Если источник

выдает зависимые сообщения

количество

информации, вычисленное по (4.1), равно

нулю, что соответствует принятому

определению информации. Если источник

выдает зависимые сообщения![]() ,

то они характеризуются условными

вероятностями

,

то они характеризуются условными

вероятностями .

И в этом случае количество информации

вычисляется по формуле (4.1) с подстановкой

в нее условных вероятностей сообщений.

.

И в этом случае количество информации

вычисляется по формуле (4.1) с подстановкой

в нее условных вероятностей сообщений.

Единицы измерения количества информации.

Выбор

основания логарифмов в формуле (4.1)

определяет единицы измерения количества

информации. При использовании десятичного

логарифма ![]() информация

измеряется в десятичных единицах –

дитах. В случае использования натуральных

логарифмов единицей измерения является

натуральная единица – нат. Более удобно

в системах, работающих с двоичными

кодами, использовать основание

логарифма

информация

измеряется в десятичных единицах –

дитах. В случае использования натуральных

логарифмов единицей измерения является

натуральная единица – нат. Более удобно

в системах, работающих с двоичными

кодами, использовать основание

логарифма![]() ,

и тогда информация измеряется в двоичных

единицах – дв.ед. Весьма часто вместо

двоичных единиц используется эквивалентное

название – бит, возникшее как сокращенная

запись английских слов binary digit (двоичная

цифра). 1 бит это количество информации,

которое передается единичным символом

сообщения, вероятность передачи

которого

,

и тогда информация измеряется в двоичных

единицах – дв.ед. Весьма часто вместо

двоичных единиц используется эквивалентное

название – бит, возникшее как сокращенная

запись английских слов binary digit (двоичная

цифра). 1 бит это количество информации,

которое передается единичным символом

сообщения, вероятность передачи

которого![]() :

:

|

|

|

В настоящее время термин бит в информатике, вычислительной и импульсной технике употребляется не только как единица количества информации, но и для обозначения числа двоичных символов 0 и 1, поскольку они обычно равновероятны и каждый из них несет 1 бит информации.

Количество

информации в сообщении, составленном

из ![]() символов,

определяется по формуле [2]:

символов,

определяется по формуле [2]:

|

, |

|

где ![]() –

номер символа

–

номер символа![]() из

алфавита источника;

из

алфавита источника;

![]() –

вероятность

передачи

–

вероятность

передачи ![]() -го

символа.

-го

символа.

Частота и относительная частота случайного события. Вероятность случайного события, как предел для относительной частоты. Свойства вероятности.

Относительной частотой случайного события в серии испытаний называется отношение числа испытаний, в которых это событие наступило, к числу испытаний.

Рассмотрим эксперименты с подбрасыванием монеты, при которых подсчитывается n- число подбрасываний и f – число выпадений «орла». Число f- называют частотой события «выпал орел», а число «f/n – относительной частотой этого события. Опыт показывает, что при увеличении числа экспериментов (n) относительная частота появления «орла» все более и более приближается к числу ½, которое называется вероятностью рассматриваемого события.

Задача.