- •1. Предмет эконометрики. Измеренияния в экономике. Типы шкал.

- •2. Линейность и аддитивность связей в функции

- •3. Типы данных. Выбор вида функции парной регрессии.

- •4. Смысл и оценка параметров линейной регрессии. Мнк.

- •5. Уравнение парной линейной регрессии в отклонениях

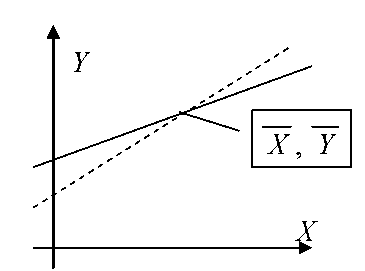

- •6. Геометрическая интерпретация мнк. Матричная форма записи мнк.

- •7. Линейный коэффициент корреляции. Коэффициент детерминации и его связь с коэффициентом корриляции.

- •8. Оценка существенности (значимости) линейной регрессии

- •9. Природа ошибок регрессии. Основные гипотезы для обоснования парной линейной регрессионной модели

- •10. Теорема Гаусса-Маркова для парной линейной регрессии.

10. Теорема Гаусса-Маркова для парной линейной регрессии.

Пусть мы имеем набор данных (наблюдений) (Xt,Yt), t=1,…,n и выполняются условия:

1 ° Yt=а+bXt+εt, t=l,...,n — спецификация модели. εt – ошибка измерения

2° Xt — детерминированная величина; вектор х=(Х1,...,Хn)' не коллинеарен вектору i=(1,...,1), т.е. не все х одинаковы.

За° E(εt)=0; 3b° Е(εt2)=σ2 — не зависит от t.

4° E(εt*εs)=0 при t≠s, некоррелированность ошибок для различных наблюдений

Задача: оценить «наилучшим» способом a, b и σ2. Термин «наилучший» означает, что найти в классе лин. (по Yt) несмещенных оценок наилучшую в смысле мин. дисперсии.

Зам. Если такая оценка найдена, то это не означает, что не существует нелинейной оценки с меньшей дисперсией.

Теорема

Гауса-Маркова.

При справедливости

1°-4° оценки

![]() и

и

![]() (*)

имеют наим. дисперсию

в классе всех лин. несмещенных оценок.

(*)

имеют наим. дисперсию

в классе всех лин. несмещенных оценок.

Доказательство.

1.

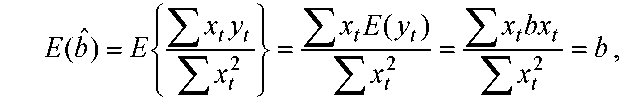

Проверка несмещенности МНК-оценок

![]() .

Используя

.

Используя

![]() ,

получим

,

получим

![]()

А из (*)=>

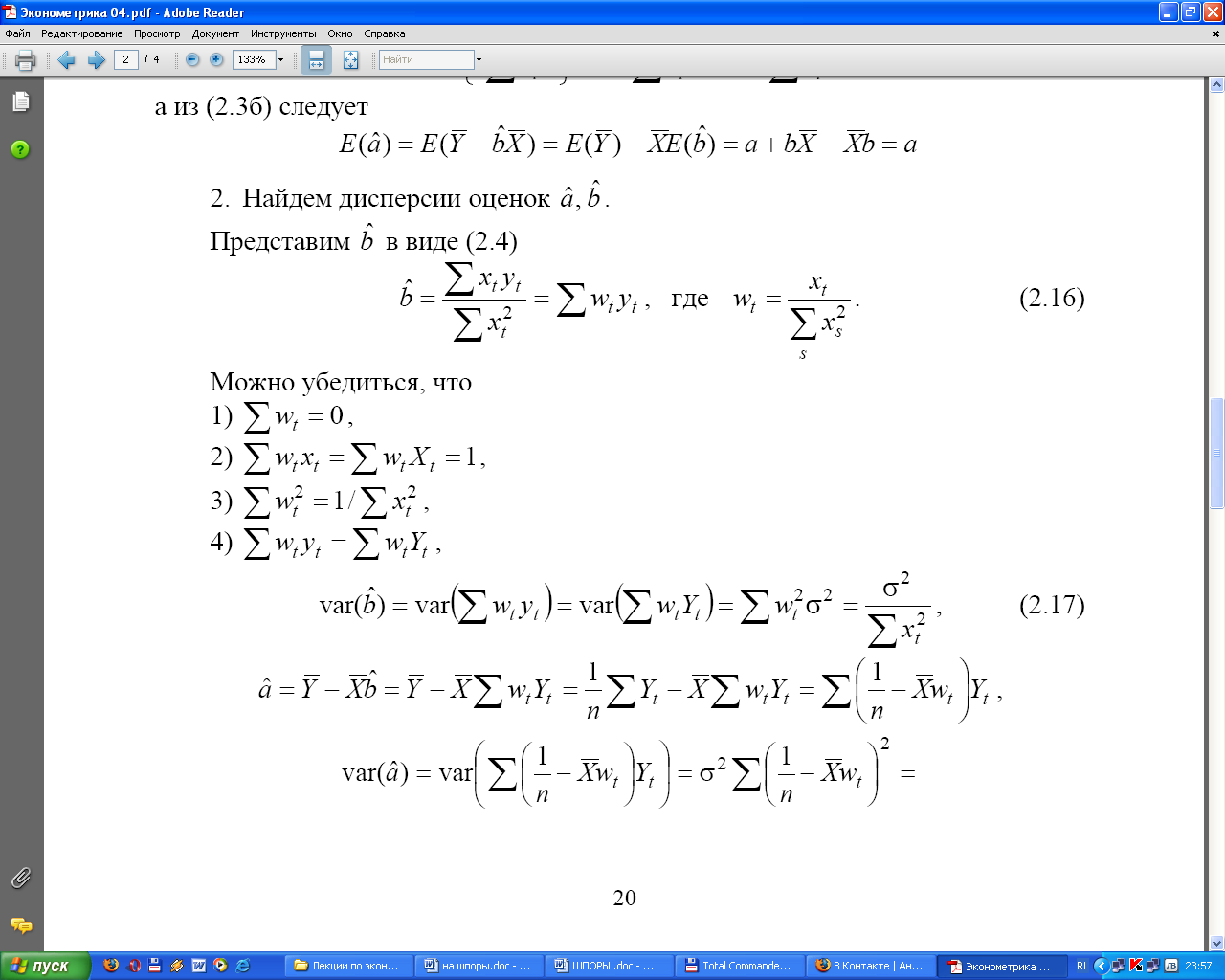

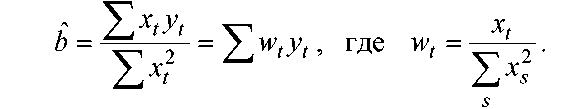

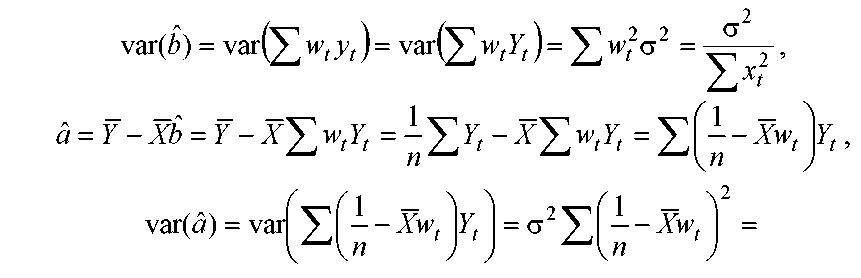

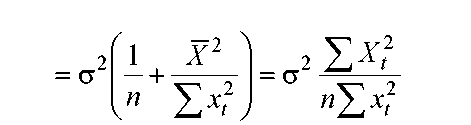

2. Оценим дисперсии aˆ, bˆ: (1)

( 2)

2)

(3)

(3)

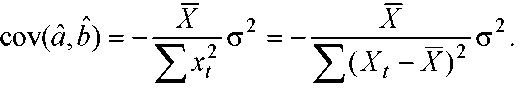

Используя (1) и (3) можно показать, что

(4)

Зам. Из (4) => cov(a^,b^)<0.

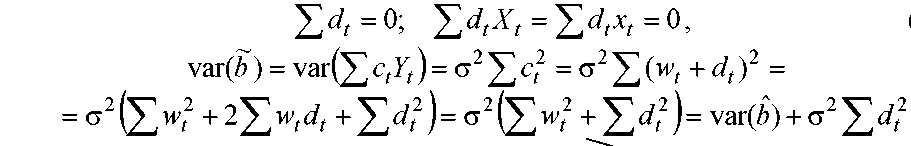

3. Покажем, что МНК-оценки явл. «наилучшими» в классе всех лин. несмещенных оценок.

Пусть

![]() =ΣctYt

— любая

другая несмещенная оценка. Пусть

ct=wt+dt,

тогда

=ΣctYt

— любая

другая несмещенная оценка. Пусть

ct=wt+dt,

тогда

![]()

справедлива

для всех a

и

b,

если

справедлива

для всех a

и

b,

если

Т.е. var(b) > var(b^), ч.т.д.