- •1 Информация, информационные технологии и информатика

- •1.1 Информация

- •1.2 Информационное общество

- •1.3 Информационные технологии

- •1.4 Информатика

- •2 Информационные системы

- •2.1 Понятие информационной системы

- •2.2 Виды обеспечения информационных систем

- •3 Базовые типы информационных систем

- •3.1 Фактографические информационные системы

- •Основная терминология, используемая в информационных системах на основе реляционных баз данных

- •Модель предметной области “Cущность-связь”

- •Нотация Баркера

- •Стандарт idef1x

- •Связь между функциональными моделями и моделями

- •3.2 Гипертекстовые информационные системы

- •История развития гипертекстовой технологии

- •Отличительные черты гипертекста

- •Основные компоненты гипертекстовой системы

- •3.3 Документальные информационные системы

- •3.4 Интеллектуальные информационные системы

- •4. Жизненный цикл информационных систем, case-технологии

- •4.1 Жизненный цикл информационных систем и его этапы

- •Структурная схема терминов

- •Реальный процесс создания ис на базе каскадной модели

- •Спиральная модель жц

- •4.2 Основы методологии проектирования ис на основе

- •Рекомендуемая литература

1 Информация, информационные технологии и информатика

1.1 Информация

Термин "информация" происходит от латинского слова «informatio» –разъяснение, осведомление, изложение.

В широком смысле информация – это сведения, знания, сообщения, являющиеся объектом хранения, преобразования, передачи и помогающие решить поставленную перед человеком задачу.

В философском смысле информация есть отражение реального мира; это сведения, которые один реальный объект содержит о другом реальном объекте. Таким образом, понятие информации связывается с определенным объектом, свойства которого она отражает.

Существуют три достаточно близких термина: информация, данные, знания, используемы в повседневной речи, обычно, как синонимы. Но в строгом смысле между ними есть отличия, дадим определения:

Данные – сведения, представленные в определенной знаковой системе и на определенном носителе для обеспечения возможностей хранения, передачи, приема и обработки этих сведений.

Уходя от способов представления, хранения и передачи, данные можно рассматривать как абстрактную субстанцию, несущую некоторую информацию. Данные безотносительны к содержанию информации.

Знание как объект коммерции и автоматизации – логически полный ограниченный набор сведений для непосредственного решения требуемой задачи (ряда задач) подготовленными специалистами.

Такие сведения выражаются в системе понятий, принятой в рамках некоторой науки или производственной деятельности, и имеют стандартное представление.

Ограниченный набор позволяет задать уровень подготовки специалистов (обладание требуемым уровнем понимания).

Рассмотрим подходы к количественному измерению информации.

Определить понятие “количество информации” довольно сложно. В решении этой проблемы наиболее распространены два основных подхода. Исторически они возникли почти одновременно. В конце 40-х годов XX века один из основоположников кибернетики американский математик Клод Шеннон развил вероятностный подход к измерению количества информации, а работы по созданию ЭВМ привели к “объемному” подходу.

Подходы к количественному измерению информации.

Различают (вероятностный), семантический, прагматический, структурный подходы и объемный подходы.

Статистический (вероятностный подход)

Количеством информации называют числовую характеристику сигнала, отражающую ту степень неопределенности (неполноту знаний), которая исчезает после получения сообщения в виде данного сигнала. Эту меру неопределенности в теории информации называют энтропией. Если в результате получения сообщения достигается полная ясность в каком-то вопросе, говорят, что была получена полная или исчерпывающая информация и необходимости в получении дополнительной информации нет. И, наоборот, если после получения сообщения неопределенность осталась прежней, значит, информации получено не было (нулевая информация).

Приведенные рассуждения показывают, что между понятиями информация, неопределенность и возможность выбора существует тесная связь. Так, любая неопределенность предполагает возможность выбора, а любая информация, уменьшая неопределенность, уменьшает и возможность выбора. При полной информации выбора нет. Частичная информация уменьшает число вариантов выбора, сокращая тем самым неопределенность.

Подход к информации как мере уменьшения неопределенности знаний позволяет количественно измерять информацию, что чрезвычайно важно для информатики.

Основоположником статистического подхода считается Клод Шеннон, в 1948 г. опубликовавший разработанную им теорию связи.

В данном случае, количество информации определяется, как мера неопределенности состояния системы, снимаемая при получении информации.

Мерой неопределенности состояния системы является энтропия, при получении информации энтропия системы уменьшается. Если о системе имеется полная информация, то ее энтропия равна 0.

В соответствии с вышесказанным:

![]() ,

,

где

![]() –

энтропия системы до получения информации,

–

энтропия системы до получения информации,

![]() –

энтропия системы после получения

информации.

–

энтропия системы после получения

информации.

Энтропия системы,

обычно, определяется в битах. Предположим,

что система

![]() имеет конечное число дискретных состояний

имеет конечное число дискретных состояний

![]() с вероятностями

с вероятностями

![]() ,

тогда энтропия системы определяется

формулой:

,

тогда энтропия системы определяется

формулой:

![]() .

.

Если состояния равновероятны, то вероятность пребывания системы в одном из состояний

![]() ,

,

где – количество состояний системы

и формула для определения энтропии упрощается:

![]() .

.

Статистический подход находит очень широкое применение. Например, задачи сжатия информации, расчета канала связи для передачи информации и т.п.

Семантический подход – оценка информации по смысловому содержанию, т.е. оценка изменения знаний после получения информации. В данном случае информация относительная величина, зависящая от имеющихся у получателя знаний. В настоящее время семантический подход еще мало развит.

Прагматический подход – определение количества информации, как меры, способствующей достижению поставленной цели.

В частности, можно ввести следующее определение:

![]() ,

где P2 –

вероятность достижения цели до получения

информации, P1

– вероятность достижения цели

после получения информации.

,

где P2 –

вероятность достижения цели до получения

информации, P1

– вероятность достижения цели

после получения информации.

Структурный подход к теории информации – в данном случае рассматривают логические и физические структуры организации информации и ее оптимальный выбор. Это актуально, например, при построении больших распределенных баз данных.

Объемный подход

В двоичной системе счисления знаки 0 и 1 будем называть битами (от английского выражения Binary digits – двоичные цифры). Создатели компьютеров отдают предпочтение именно двоичной системе счисления, потому что в техническом устройстве наиболее просто реализовать два противоположных физических состояния. Например: некоторый физический элемент, имеющий два различных состояния: намагниченность в двух противоположных направлениях; прибор, пропускающий или нет электрический ток; конденсатор, заряженный или незаряженный и т.п. В компьютере бит является наименьшей возможной единицей информации.

Объем информации, записанной двоичными знаками в памяти компьютера или на внешнем носителе информации, подсчитывается просто по количеству требуемых для такой записи двоичных символов.

При этом в частности, невозможно нецелое число битов (в отличие от вероятностного подхода).

Эти единицы чаще всего используют для указания объема памяти ЭВМ.

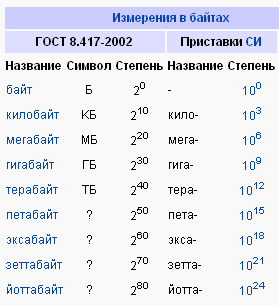

Единицы измерения информации

Объём информации можно представлять как логарифм количества возможных состояний.

Наименьшее целое число, логарифм которого положителен — это 2. Соответствующая ему единица — бит — является основой исчисления информации в цифровой технике.

I=log2 N [бит],

где N – число дискретных состояний.

Следующей по порядку популярной единицей информации является 8 бит, или байт, он может принимать одно из N=256 (28) различных значений. Именно к байту (а не к биту) непосредственно приводятся все большие объёмы информации, исчисляемые в компьютерных технологиях.

Для измерения больших количеств байтов служат единицы «килобайт», «Кбайт» (кибибайт, kibibyte, Kb) = 1024 байт. Такой порядок величин имеют, например:

сектор диска обычно равен 512 байтам, то есть половине килобайта, хотя для некоторых устройств может быть равен одному или двум кибибайт.

классический размер «блока» в файловых системах UNIX равен одному Кбайт (1024 байт).

«Страница памяти» в процессорах x86 (начиная с модели Intel 80386) имеет размер 4096 байт, то есть 4 Кбайт.

Единицы «мегабайт», «Мбайт» (mebibyte, Mb) = 1024 Кбайт = 1 048 576 байт применяются для измерения объёмов носителей информации.

Объём адресного пространства процессора Intel 8086 был равен 1 Мбайт.

Единицы «гигабайт», «Гбайт» (гибибайт, gibibyte, Gb) = 1024 мегабайт = 1048576 килобайт = 1073741824 байт.

Для исчисления ещё больших объёмов информации имеются единицы терабайт – 1012 гигабайт.

Кратные приставки для образования производных единиц для байта применяются не как обычно: уменьшительные приставки не используются совсем, увеличительные приставки кратны 1024=210, то есть килобайт равен 1024 байтам, мегабайт — 1024 килобайтам или 1 048 576 байтам и т.д. Разница возрастает с ростом веса приставки.

Между вероятностным и объемным количеством информации соотношение неоднозначное. Далеко не всякий текст, записанный двоичными символами, допускает измерение объема информации в статистическом смысле, но заведомо допускает его в объемном. Далее, если некоторое сообщение допускает измеримость количества информации в обоих смыслах, то они не обязательно совпадают, при этом статистическое количество информации не может быть больше объемного.