- •ЛЕКЦИЯ 2

- •Количество информации

- •Пример 1

- •ПРИМЕР 2

- •Единицы измерения информации

- •Кодирование чисел в ЭВМ

- •Целые числа без знака

- •Целые числа со знаком

- •Прямой и дополнительный коды

- •Прямой/дополнительный коды

- •ПРИМЕР

- •Замена операции вычитания сложением

- •Кодирование вещественных чисел

- •Кодирование числовых данных

- •Операции с плавающей точкой

- •Операции с плавающей точкой

- •Перевод дробной части вещественного числа в двоичную форму

- •Кодирование текстовых данных

- •Кодирование графических данных

- •Растровая графика

- •Векторная графика

- •Векторная графика

- •Фрактальная графика

- •Примеры фрактальной графики

- •Современные системы цветопередачи

- •Примеры задач

- •Примеры задач

ЛЕКЦИЯ 2

Информатика 2 курс 2013-2014 учебный год

Темы:

•Энтропийная концепция информации

•Кодирование данных в ЭВМ

Энтропийная концепция

информации

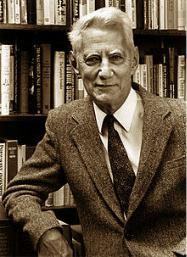

• Автор: американский ученый Клод Шеннон |

|

• Энтропия – мера неопределенности |

1916 – 2011 |

•Информация – мера устранения неопределенности в отношении исхода того или иного события

•Количество информации в сообщении зависит от вероятности его получения: чем более вероятным является сообщение, тем меньше информации содержится в нем

Количество информации

•Процесс получения информации - это выбор одного сообщения из конечного заданного

множества N равновероятных сообщений

•За единицу количества информации (1 бит)

принимается количество информации, которое содержит сообщение, уменьшающее неопределенность (энтропию) в два раза

•Количество бит информации, содержащееся в выбранном сообщении, определяют как I=log2N

(формула Хартли)

Пример 1

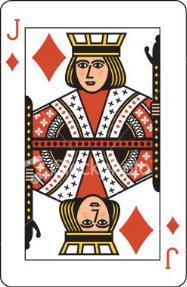

Колода содержит 32 карты. Загадана карта

Сколько вопросов с ответами да-нет надо задать, чтобы угадать карту?

1.Черная масть?

2.Бубновая масть?

3.Старше десятки?

4.Старше дамы?

5.Это валет?

Каждый раз неопределенность уменьшается в 2 раза,

т.е. каждое сообщение содержит 1 бит информации

Сколько бит информации содержит сообщение «Из колоды 32 карт выбран бубновый валет?»

32=25, 5=Log2 32