- •Министерство образования и науки Российской Федерации Государственное образовательное учреждение высшего профессионального образования "поволжский государственный университет сервиса (пвгус)"

- •Учебно-методический комплекс дисциплины

- •Содержание

- •Введение

- •Рабочая учебная программа дисциплины

- •1.1. Цели и задачи дисциплины

- •1.2.Структура и объем дисциплины

- •1.3. Содержание дисциплины Распределение фонда времени по темам и видам занятий

- •1.4. Требования к уровню освоения дисциплины и формы текущего и промежуточного контроля

- •Перечень вопросов для подготовки к зачету по дисциплине «Информатика»

- •1.5. Содержание индивидуальной работы студента (под руководством преподавателя)

- •2. Учебно-методическое пособие

- •2.1. Конспект лекций

- •Тема 1. Информация и информационные процессы

- •1.1. Системы, образованные взаимодействующими элементами, состояния элементов, обмен информацией между элементами, сигналы

- •1.2 Меры и единицы представления, измерения и хранения информации

- •Синтаксическая мера информации

- •Семантическая мера информации

- •Прагматическая мера информации

- •Единицы измерения информации.

- •1.3 Системы счисления

- •Формы представления чисел

- •Двоичная система счисления

- •Правила выполнения простейших арифметических действий.

- •1.4. Основные понятия алгебры логики. Логические основы эвм.

- •Тема 2. Информационные модели и системы

- •2.1. Информационная модель объекта

- •2.2. Алгоритм и его свойства. Структура алгоритма.

- •Тема 3.Средства и технологии создания и преобразования информационных объектов

- •3.1. Текстовые процессоры

- •3.2. Электронные таблицы

- •3.3. Базы данных

- •Виды моделей данных

- •Классификация баз данных

- •Реляционные базы данных

- •Основные понятия реляционных баз данных

- •3.4. Графические редакторы

- •Тема 4. Компьютер как средство автоматизации информационных процессов

- •4.1. История развития эвм. Понятие и основные виды архитектуры эвм

- •4.2. Состав и назначение основных элементов персонального компьютера. Центральный процессор. Системные шины и слоты расширения

- •4.3. Запоминающие устройства: классификация, принцип работы, основные характеристики

- •4.4. Устройства ввода/вывода данных, их разновидности и основные характеристики

- •4.5. Классификация программного обеспечения. Виды программного обеспечения и их характеристики.

- •4.6. Системное программное обеспечение.

- •4.7. Защита информации.

- •Вредоносные программы

- •Классификация антивирусных программ

- •Тема 5. Средства и технологии обмена информацией с помощью компьютерных сетей (сетевые технологии)

- •5.1. Локальные компьютерныесети.

- •5.2. Базовые сетевые топологии

- •5.3. Сетевое оборудование

- •5.4. Глобальные сети эвм.

- •История

- •Адресация в Интернете

- •5.5. Поисковые информационные системы

- •Тема 6. Основы социальной информатики.

- •2.3. Лабораторный практикум по дисциплине Распределение тем лабораторных занятий по времени

- •Содержание лабораторных занятий лабораторная работа №1. « кодирование информации»

- •Кодирование символьной информации

- •Кодирование графических изображений

- •Лабораторная работа №2. «информация и энтропия»

- •Лабораторная работа №3. «позиционные системы счисления»

- •Краткие теоретические сведения:

- •Формы представления чисел

- •Двоичная система счисления

- •Восьмеричная и шестнадцатеричная системы счисления

- •Взаимное преобразование двоичных, восьмеричных и шестнадцатеричных чисел

- •Двоично-десятичная система счисления

- •Лабораторная работа №4. «проектирование алгоритмов. Блок-схема алгоритма»

- •Лабораторная работа №5. «основные приемы работы в microsoft word»

- •Интересное предложение

- •Образец формул

- •Лабораторная работа №6. «Технология создания электронных таблиц в ms Excel»

- •Функции ms Excel

- •Задания для выполнения:

- •Лабораторная работа №7. «основы обработки реляционных баз данных средствами

- •1. 2. Задания для самостоятельной работы

- •Лабораторная работа №8. «Логические основы функционирование эвм»

- •Логические элементы

- •Лабораторная работа №9. «Основы работы с MathCad»

- •Лабораторная работа №10. «информационная безопасность. Основы криптографии»

- •Тулыио целзио тсдизло

- •Современные алгоритмы шифрования

- •Лабораторная работа №11. «Создание одноранговой сети»

- •Требования к оформлению и защите лабораторных работ

- •3. Учебно-методическое обеспечение дисциплины

- •3.1. Перечень основной и дополнительной литературы

- •3.2 Методические рекомендации для преподавателя

- •3.3. Методические указания студентам по изучению дисциплины

- •3.4. Методические указания для выполнения кОнтрольной работы

- •Варианты заданий для выполнения контрольной работы

- •3.5. Материально-техническое и программное обеспечение дисциплины

- •3.6. Программное обеспечение

- •Поволжский государственный университет сервиса

- •Поволжский государственный университет сервиса

- •Приложение 1

1.2 Меры и единицы представления, измерения и хранения информации

Информацией называют сведения о тех или иных объектах, явлениях или процессах в окружающей среде. Любая форма человеческой деятельности связана с передачей и обработкой информации. Она необходима для правильного управления окружающей действительностью, достижения поставленных целей и в конечном счете - для существования человека. Любая система: социально-экономическая, техническая, или система в живой природе действует в постоянной взаимосвязи с внешней средой – другими системами более высокого и более низкого уровней. Взаимосвязь осуществляется посредством информации, которая передает как команды управления, так и сведения, необходимые для принятия правильных решений. Понятие информации как важнейшего элемента системы, охватывающего все стороны ее жизнедеятельности можно считать универсальным, применимым к любым системам.

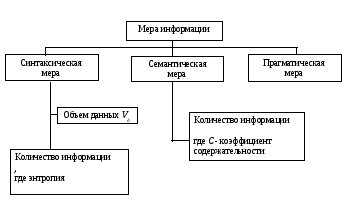

Единого научного мнения о количественном смысле понятия "информация" не существует. Разные научные направления дают различные определения исходя из тех объектов и явлений, которые они изучают. Некоторые из них считают, что информация может быть выражена количественно, давая определения количества и объема информации (меры информации), другие ограничиваются качественными толкованиями.

рис.

1.2. Классификация меры информации

рис.

1.2. Классификация меры информации

Синтаксическая мера информации

Синтаксическая мера информации используется для количественного выражения обезличенной информации, не выражающей смыслового отношения к объектам.

Объем данных Vдв сообщении измеряется количеством символов в нем. Обычно для указания объема данных считают количество двоичных символов. Двоичный символ может принимать только два различных значения: 1 и 0 (эквивалентно значениям "да" и "нет"). Двоичный символ носит названиебит(от словbinarydigit- двоичная цифра). Распространенность двоичной единицы измерения объема объясняется двоичной системой записи чисел, на которой основаны современные компьютеры. Традиционно применяется также байт (byte), равный 8 битам.

Предположим, получатель информации (наблюдатель) дважды принял одно и то же сообщение. Он получил двойной объем данных, но получил ли он двойное количество информации? Интуиция подсказывает, что нет - вторая копия не содержала новых сведений. Информацию, содержащуюся в сообщении, можно трактовать в аспекте того, насколько она была ранее неизвестна и, следовательно, является новой или неожиданной.

Количество информации Iопределяется через понятие неопределенности состояния (энтропию). Приобретение информации сопровождается уменьшением неопределенности, поэтому количество информации можно измерять количеством исчезнувшей неопределенности.

Пусть в сообщении наблюдателем получены сведения о некоторой части реальности (системе). До принятия сообщения получатель имел некоторые предварительные (априорные) сведения о системе. Мерой его неосведомленности о системе является функцияH(), которая в то же время служит и мерой неопределенности состояния системы.

После получения сообщения получатель приобрел в нем информациюI(), уменьшившую его неосведомленность (неопределенность состояния системы) так, что она стала равнаH(). Тогда количество информацииI() о системе, полученной в сообщении, определится какI() =H() -H() .

Таким образом, количество информации в сообщении измеряется изменением (уменьшением) неопределенности состояния системы после получения сообщения.

Если конечная неопределенность H()обратится в нуль, то первоначальное неполное знание заменится полным знанием и количество информацииI() =H(). Иными словами, энтропия системыH() может рассматриваться как мера информации.

Энтропия системы H(), имеющейNвозможных состояний, согласно формуле Шеннона равна

![]() ,

,

где Pi- вероятность того, что система находится вi-м состоянии.

Для случая, когда все состояния системы

равновероятны, т.е. их вероятности равны

![]() ,

,

энтропия определяется соотношением

![]() .

.

Часто информация кодируется числовыми кодами в той или иной системе счисления. Одно и то же количество цифр (символов) в разных системах счисления может передать разное число состояний отображаемого объекта, что можно представить в виде соотношения

N=mn,

где N- число всевозможных отображаемых состояний;

m- основание системы счисления (разнообразие символов, применяемых в алфавите);

n- число символов в сообщении.

Приведем пример. По каналу связи передается n- символьное сообщение, использующееmразличных символов. Так как количество всевозможных кодовых комбинаций будетN=mn , то при равной вероятности появления любой из них количество информации, приобретенной абонентом в результате получения сообщения, будет равноI = log N = n log m.

Эта формула известна как формула Хартли. Если в качестве основания логарифма принятьm, тоI=n. В данном случае количество информации (при условии полного априорного незнания абонентом содержания сообщения) будет равно объему данныхI=Vд , полученных по каналу связи. Для неравновероятных состояний системы всегдаI<Vд=n.

Наиболее часто логарифм берут по основанию 2. В этом случае количество информации измеряют в битах.

Коэффициент информативности сообщения определяется отношением количества информации к объему данных, т.е.

![]() , причем 0 <Y< 1 .

, причем 0 <Y< 1 .

CувеличениемYуменьшаются затраты на обработку информации. Поэтому обычно стремятся к повышению информативности.