- •Понятие информации. Классификация информации.

- •Свойства информации: основные, дистрибутивные и динамические.

- •Собственная информация и её свойства.

- •Энтропия, свойства энтропии.

- •Понятие о криптографических методах защиты информации. Модель Шеннона.

- •Симметричные блочные криптосистемы

- •Симметричные поточные криптосистемы.

- •Режимы использования блочных шифров.

- •Функции хеширования. Криптографические хеш-функции.

- •Генерация случайных чисел.

- •Преимущества

- •Недостатки

- •Виды асимметричных шифров

- •Назначение и применение эцп

- •Алгоритмы

- •Использование хеш-функций

- •Асимметричная схема

- •Акты Конституционного Суда Республики Беларусь

- •Вопросы обеспечения информационной безопасности, регламентируемые нормативными актами.

- •Защита прав на получение информации в закон-ве рб.

- •Категорирование информации. Государственные секреты. Категории и степени секретности.

- •21. Основные принципы отнесения сведений к государственным секретам

- •22. Государственные секреты. Обращение с государственными секретами.

- •23. Защита государственных секретов.

- •24. Органы защиты государственных секретов.

- •25. Сведения, не подлежащие отнесению к государственным секретам и засекречиванию.

- •26. Засекречивание сведений, составляющих государственные секреты.

- •27. Допуск физических лиц к государственным секретам.

- •28. Допуск юридических лиц к государственным секретам.

- •29. Закон рб об информатизации. Информационные ресурсы.

- •30. Закон рб об информатизации. Цели защиты.

- •1)Аутентификация

- •5) Безотказность

- •42. Методы обеспечения доступности. Помехоустойчивое кодирование.

- •44. Методы обеспечения доступности. Резервирование.

- •43, 45, 46. Методы обеспечения доступности. Дублирование, зеркалирование, raid (Redundant Array of Independent Disks).

- •47. Методы обеспечения доступности. Резервное копирование и восстановление.

- •48. Методы обеспечения доступности. Бесперебойное электропитание.

- •49. Методы обеспечения доступности. Заземление.

- •50, 51. Угрозы целостности и конфиденциальности.

- •56. Идентификация и аутентификация. Технологии и средства.

- •57. Биометрическая аутентификация (ба)

- •58. Протоколы аутентификации. Определение, требования к протоколам аутентификации.

- •59. Протоколы аутентификации. Основные виды атак на протоколы аутентификации.

- •60. Типы протоколов аутентификации. Простая аутентификация.

- •61. Типы протоколов аутентификации. Строгая аутентификация.

- •62. Свойства протоколов аутентификации.

- •63. Аутентификация одношаговая, двухшаговая, трехшаговая. Преимущества и недостатки.

- •88. Защита файлов и каталогов ос семейства Windows.

- •89. Принципиальные недостатки защитных механизмов ос семейства Windows.

- •90. Дополнительные средства безопасности ос семейства Windows

- •Управление доступом

- •Аутентификация и авторизация

-

Собственная информация и её свойства.

Собственная информация - статистическая функция дискретной случайной величины. Она является случайной величиной, которую следует отличать от её среднего значения – информационной энтропии. Собственную информацию можно понимать как «меру неожиданности» события - чем меньше вероятность события, тем больше информации оно содержит.

Для случайной величины X, имеющей конечное число значений:

![]()

![]()

собственная информация определяется как

![]()

Единицы измерения информации зависят от основания логарифма. В случае логарифма с основанием 2 единицей измерения является бит, если используется натуральный логарифм — то нат, если десятичный — то хартли.

Свойства собственной информации

1)

Неотрицательность:

![]() .

I(x) = 0 при p(x) = 1, т.е. предопределенный

факт никакой информации не несет.

.

I(x) = 0 при p(x) = 1, т.е. предопределенный

факт никакой информации не несет.

2) Монотонность: I(x1) > I(x2), если p(x1) < p(x2).

3) Аддитивность: для независимых x1,...,xn справедливо

![]()

-

Энтропия, свойства энтропии.

Информацио́ннаяэнтропи́я — мера неопределённости или непредсказуемости информации, неопределённость появления какого-либо символа первичного алфавита. При отсутствии информационных потерь численно равна количеству информации на символ передаваемого сообщения.

Например, в последовательности букв, составляющих какое-либо предложение на русском языке, разные буквы появляются с разной частотой, поэтому неопределённость появления для некоторых букв меньше, чем для других. Если же учесть, что некоторые сочетания букв (в этом случае говорят об энтропии n-ого порядка, см. ниже) встречаются очень редко, то неопределённость ещё более уменьшается.

Энтропия — это количество информации, приходящейся на одно элементарное сообщение источника, вырабатывающего статистически независимые сообщения.

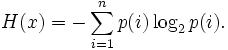

Информационная двоичная энтропия для независимых случайных событий x с n возможными состояниями (от 1 до n) рассчитывается по формуле:

Эта

величина также называется средней

энтропией сообщения. Величина

![]() называется

частной энтропией, характеризующей

только i-e состояние.

называется

частной энтропией, характеризующей

только i-e состояние.

Шеннон предположил, что прирост информации равен утраченной неопределённости, и задал требования к её измерению:

- мера должна быть непрерывной; т. е. изменение значения величины вероятности на малую величину должно вызывать малое результирующее изменение функции;

- в случае, когда все варианты равновероятны, увеличение количества вариантов (букв) должно всегда увеличивать значение функции;

- должна быть возможность сделать выбор в два шага, в которых значение функции конечного результата должно являться суммой функций промежуточных результатов.

Единственная функция, удовлетворяющая этим требованиям, имеет вид:

![]() где

K — константа (и в действительности

нужна только для выбора единиц измерения).

где

K — константа (и в действительности

нужна только для выбора единиц измерения).

Для вывода формулы Шеннона необходимо вычислить математическое ожидание «количества информации», содержащегося в цифре из источника информации. Мера энтропии Шеннона выражает неуверенность реализации случайной переменной. Таким образом, энтропия является разницей между информацией, содержащейся в сообщении, и той частью информации, которая точно известна (или хорошо предсказуема) в сообщении. Примером этого является избыточность языка — имеются явные статистические закономерности в появлении букв, пар последовательных букв, троек и т. д.

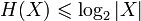

Свойства:

-

Неотрицательность:

.

. -

Ограниченность:

.

Равенство, если все элементы из X

равновероятны.

.

Равенство, если все элементы из X

равновероятны. -

Если

независимы,

то

независимы,

то

.

. -

Энтропия — выпуклая вверх функция распределения вероятностей элементов.

-

Если

имеют одинаковое распределение

вероятностей элементов, то H(X) = H(Y).

имеют одинаковое распределение

вероятностей элементов, то H(X) = H(Y).