- •Теоретичні відомості

- •Визначення складу знань та їх розподіл

- •Побудова моделі предметної області

- •Методи побудови системи понять предметної області

- •Методи встановлення взаємозв'язків між поняттями предметної області:

- •Методи встановлення семантичних відношень між поняттями предметної області

- •Контрольні питання

- •Варіанти завдань

- •Побудувати модель визначеної предметної області, використовуючи методи побудови системи понять та встановлення семантичних відношень між поняттями:

- •несправності комп’ютера;

- •Тема: Експертні системи. Побудова баз знань ЕС.

- •Структура експертних систем

- •атрибутивні зв’язки (має властивість, має значення).

- •Семантичні мережі можуть мати складну та громіздку структуру.

- •Рівні представлення і рівні детальності

- •Організація знань у базі знань

- •Контрольні питання

- •Варіанти завдань

- •Теоретичні відомості

- •Контрольні питання

- •Варіанти завдань

- •Теоретичні відомості

- •Рис. 2. Методика розробки ЕС

- •Прототипи і життєвий цикл експертної системи

- •Прикладами областей застосування, що потребують гнучкості з боку створення та поповнення бази знань, є: планування виробництва, проектування і діагностика в області електроніки, обчислювальної техніки та машинобудування.

- •Контрольні питання

- •Варіанти завдань

- •Створити та протестувати прототип ЕС відповідно варіанту. Вказати сильні та слабкі сторони створеного прототипу, шляхи його вдосконалення.

- •Вимоги до експертної системи і звіту

- •Тема: Нейронні мережі. Персептрон. Побудова та дослідження персептрона.

- •Теоретичні відомості

- •Рис. 3. Штучний нейрон

- •Навчання персептрона

- •Розглянемо алгоритм навчання з учителем.

- •Контрольні питання

- •Варіанти завдань

- •Оцінка алгоритму зворотнього поширення

- •Контрольні питання

- •Варіанти завдань

- •Тема: Нейронні мережі. Побудова та навчання нейромережі для вирішення задачі прогнозування.

- •Постановка задачі прогнозування курсу UKB/USD

- •Контрольні питання

- •Методичні рекомендації по вирішенню задачі та вимоги до звіту

- •Тема: Нейронні мережі. Побудова та навчання нейромережі для розпізнавання образів.

- •Рис.7. Структурна схема мережі Хопфілда

- •2. Розраховується новий стан нейронів

- •Рис. 9. Структурна схема мережі Хемінга

- •Алгоритм функціонування мережі Хемінга наступний:

- •Завдання: побудувати ЕС в області медичної діагностики.

- •Частина 1

- •Частина 2

- •Частина 3

- •Частина 4

- •Частина 5

максимально схожою з реальною (реального рівня складності) експертною системою, містити не менше п’ятидесятьох правил, забезпечувати не менш, ніж дворівневе прийняття рішень. Якщо якісне вирішення задачі призводить до розростання бази знань за межі приблизно ста п’ятдесяти правил, варто реалізувати частину розв’язку задачі, обмеживши множину варіантів, які опрацьовуються експертною системою, за узгодженням із викладачем. У цьому випадку деякі відповіді на питання, що задаються системою, можуть приводити до незнаходження розв’язку. Ці обмеження потрібно обов’язково описати в звіті. Реалізацію ЕС провести на мовах програмування або в програмних оболонках, вказаних викладачем.

Лабораторна робота № 5

Тема: Нейронні мережі. Персептрон. Побудова та дослідження персептрона.

Мета: Ознайомитися з моделлю персептрона, алгоритмами навчання персептронів. Одержати навики побудови, навчання та дослідження персептронів.

Теоретичні відомості

Спроби моделювання роботи мозку за допомогою побудови моделей нейронних мереж (HM) з’явилися разом з появою ЕОМ. Перші моделі нейроподібних мереж були фізичними і грунтувалися на електронних моделях нейронів. Початок цьому моделюванню поклала ідея формального нейрона Мак-Каллока і Піттса (1943 р.), що була розвинена Розенблаттом у рамках побудованих ним та іншими вченими моделей персептронів (систем для розпізнавання образів) - одного з класів сучасних штучних нейронних мереж.

Актуальність досліджень у цьому напрямку підтверджується масою різноманітних застосувань НM. Це автоматизація процесів розпізнавання образів, апроксимація функціоналів, прогнозування, створення експертних систем, організація асоціативної пам’яті і т.д.

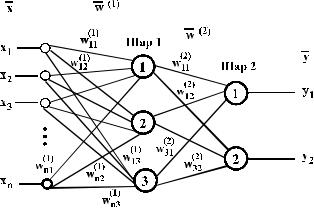

Моделі НМ можуть бути програмні й апаратні. Надалі мова йтиме про перший тип. Незважаючи на суттєві відмінності, окремі типи НМ мають декілька загальних (рис.3).

27

Рис. 3. Штучний нейрон

Основу кожної НМ складають прості, у більшості випадків - однотипні, елементи, що імітують роботу нейронів мозку. Кожен нейрон характеризується своїм поточним станом за аналогією з нервовими клітинами головного мозку (Рис.3), що можуть бути збуджені або загальмовані. Він має групу синапсів - вхідних зв’язків, сполучених із виходами інших нейронів, а також має аксон - вихідний зв’язок даного нейрона, із якого сигнал (збудження або гальмування) надходить на синапси наступних нейронів. Кожен синапс характеризується величиною синаптичного зв’язку або його вагою wi, що за фізичною суттю еквівалентна електричній провідності.

Поточний стан нейрона визначається як зважена сума його входів:

n |

|

s = åxi × wi |

(1) |

i =1 |

|

Вихід нейрона є функція його стану: |

|

y = f(s) |

(2) |

28

Рис.4. а) функція одиничного стрибка; б) лінійний поріг; в) сигмоїд - гіперболічний тангенс;

г) сигмоїд - формула (3)

Нелінійна функція f називається активаційною і може мати різний вигляд, (Рис.4). Однією з найбільше поширених є нелінійна функція з насиченням, (логістична функція або сигмоїд, тобто функція s-образного вигляду):

f (x) = |

|

1 |

(3) |

|

+e−αx |

||

1 |

|

||

Слід зазначити, що сигмоїдна функція диференційована на всій осі абсцис, що використовується в деяких алгоритмах навчання.

29

Рис. 5. Одношаровий |

персептрон |

|

|||

Як приклад |

найпростішої |

НМ |

розглянемо |

тринейронний |

|

персептрон (Рис.5), |

тобто |

таку |

мережу, нейрони |

якої мають |

|

активаційну функцію у вигляді одиничного стрибка. На n входів поступають деякі сигнали, що проходять по синапсах на 3 нейрона, що утворять єдиний шар цієї НМ і видають три вихідних сигнали:

y |

|

é n |

x |

|

× w |

|

ù |

, j=1...3. |

(4) |

j |

= f ê |

i |

ij |

ú |

|||||

|

êå |

|

|

ú |

|

|

|||

|

|

ëi=1 |

|

|

|

|

û |

|

|

Очевидно, що усі вагові коефіцієнти синапсів одного шару нейронів можна звести в матрицю W, у якій кожен елемент wij задає величину i-го синаптичного зв’язку j-ого нейрона. Таким чином, процес, що відбувається в НМ, може бути записаний у матричній формі:

Y=F(XW), |

(5) |

де X і Y – відповідно вхідний і вихідний сигнальні вектори, F(V) – |

|

активаційна функція, застосовувана поэлементно до компонентів вектора V.

30

Теоретично число шарів і число нейронів у кожному шарі може бути довільним, проте фактично воно обмежене ресурсами комп’ютера або спеціалізованої мікросхеми, на котрих реалізується НМ.

Вибір структури НМ здійснюється відповідно до особливостей і складності задачі. Для розв’язку деяких окремих типів задач вже існують оптимальні, на сьогоднішній день, конфігурації.

Процес функціонування НМ залежить від величин синаптичних зв’язків, тому в мережі потрібно знайти оптимальні значення всіх змінних вагових коефіцієнтів (деякі синаптичні зв’язки можуть бути постійними).

Цей етап називається навчанням НМ, і від того, наскільки якісно він буде виконаний, залежить здатність мережі вирішувати поставлені перед нею проблеми під час експлуатації. Навчання НМ може вестися з вчителем або без нього. У першому випадку у мережу подаються значення як вхідних, так і бажаних вихідних сигналів, і вона по деякому внутрішньому алгоритму корегує ваги своїх синаптичних зв’язків. В другому випадку виходи НМ формуються самостійно, а ваги змінюються по алгоритму, що враховує тільки вхідні і похідні від них сигнали.

Існує безліч алгоритмів навчання, що діляться на два великих класи: детерміновані і стохастичні. У першому з них корегування ваг являє собою жорстку послідовність дій, у другому - воно проводиться на основі дій, що визначаються деяким випадковим процесом.

Рис.6. Двошаровий перcептрон

31