- •Годфруа ж. Что такое психология. В 2-х т. Оглавление

- •Годфруа ж. Что такое психология. В 2-х т. Оглавление Предисловие редактора перевода

- •Предисловие

- •Представление книги

- •1. Изучение поведения – история и методы

- •Часть 1. Изучение поведения. История и методы Глава 1 Что такое поведение?

- •Эволюционная теория

- •Эволюция поведения

- •Таксисы

- •Рефлексы

- •Инстинктивное поведение

- •Врожденные пусковые механизмы

- •Импринтинг

- •Научение

- •Способность к умозаключениям

- •Эволюция человека

- •Материал для самопроверки

- •Глава 2 Что такое психология?

- •Развитие психологии

- •Рождение научной психологии

- •Заключение

- •Материал для самопроверки

- •Глава 3 Чем занимаются психологи?

- •Психология и ее разделы

- •Область научных поисков

- •Документ 3.6. Научные исследования и связанные с ними артефакты

- •Часть 2.Сознание и активация Глава 4 Внутренний мир и состояния сознания

- •Употребление наркотических средств и патологические состояния

- •Возбуждающие средства

- •Документ 4.1. Электрическая активность мозга

- •Досье 4.1. Как мы спим? Почему мы видим сны?

- •Глава 5. Наше восприятие мира

- •Внимание и восприятие

- •Экстрасенсорное восприятие

- •Глава 5

- •Глава 6 Мотивационная и эмоциональная активация

- •Мотивация и эмоции

- •Часть 3. Высшие функции и обработка информации

- •Глава 7 Научение Адаптация и научение

- •Глава 8 Память, мышление и общение Память

- •Мышление

- •Теории научения

- •Документ 8.1. Сенсорная память

- •Глава 8

- •Материал для самопроверки

- •Ответы на вопросы

- •Глава 9 Адаптация и творчество Интеллект

- •Литература

- •Материал для самопроверки

- •Часть 4. Я, другие и «иные»

- •Введение

- •Глава 10. Развитие «я» Введение

- •Различные аспекты развития

- •Этапы жизни

- •Неравномерность роста

- •Развитие нервной системы

- •Физическое развитие

- •Неонатальный период

- •Детство

- •Отрочество

- •Зрелый возраст

- •Половое развитие

- •Половая функция и размножение

- •Половое поведение и развитие

- •Когнитивное развитие

- •Этапы умственного развития ребенка и подростка

- •Умственные способности взрослого человека

- •Нравственное развитие

- •Моральное суждение в детском возрасте

- •Развитие нравственного сознания

- •Развитие личности

- •Описательные подходы

- •Бихевиористский подход

- •Когнитивный подход

- •Психодинамические подходы

- •Гуманистический подход

- •Социальное развитие

- •Этапы социализации

- •Жизненные кризисы

- •Приближение к смерти

- •Ступени смерти

- •Документ 10.1. Сексуальные фантазии: извращение или психологическое «афродизирующее средство»?

- •Документ 10.2. Детское мышление

- •Документ 10.4. Можно ли оценить личность?

- •Документ 10.5. Кто такие были Эдип и Электра?

- •Материал для самопроверки

- •Выбрать правильный ответ

- •Литература

- •Глава 11. Человек и другие люди Введение

- •Жизнь в обществе

- •Территория и индивидуальный участок

- •Факторы окружающей среды

- •Власть и подчинение

- •Конформизм

- •Влияние меньшинства

- •Альтруизм и апатия

- •Взаимодействие и коммуникация

- •Межличностное влечение

- •Коммуникация

- •Социальное восприятие

- •Впечатления

- •Каузальная атрибуция

- •Стереотипы

- •Установки

- •Составляющие установок

- •Выработка установок

- •Изменение установок

- •Предубеждения

- •Документ 11.1. «Внутренняя галактика»

- •Документ 11.2. Чем многолюднее, тем безответственнее

- •Документ 11.3. Шум и успеваемость в школе

- •Документ 11.4. Доминирование, власть и лидерство

- •Доминантное поведение

- •Документ 11.5. Приказы и жизнь других людей

- •Документ 11.6. Конформизм и преобразование действительности

- •Документ 11.7. Влияние меньшинств и социальные сдвиги

- •Документ 11.8. Безмолвные свидетели и снисходительные жертвы

- •Документ 11.9. Межличностное влечение зависит и от обоняния

- •Документ 11.10. Похвала и критика

- •Документ 11.11. Парадоксальная коммуникация, двойное принуждение и шизофрения

- •Документ 11.12. Любовь и истолкование улыбки

- •Материал для самопроверки

- •Литература

- •Глава 12. «Иные» Введение

- •Тревога и стресс

- •Что такое аномальное поведение?

- •Некоторые подходы к пониманию аномального поведения

- •Демонология

- •Медицинский подход

- •Психоаналитический подход

- •Бихевиористский подход

- •Когнитивный подход

- •Гуманистический подход

- •Социо-культурный подход

- •Классификация психических расстройств

- •Расстройства, свойственные детскому и подростковому возрасту

- •Расстройства органического происхождения

- •Расстройства, связанные со старением

- •Функциональные расстройства

- •Расстройства личности

- •«Приклеивание ярлыков» и его последствия

- •Лечение

- •Психиатрия и медицинский подход к лечению психических расстройств

- •Психотерапия

- •Поведенческая терапия (бихевиористский подход)

- •Альтернативные ресурсы и групповая терапия

- •Документ 12.1. Уравновешенный человек и «норма»

- •Документ 12.2. Жизнь и механизмы психологической защиты

- •Документ 12.3. Психические расстройства в детстве и отрочестве

- •Документ 12.4. Путешествие через психическое страдание

- •Документ 12.5. Здравый рассудок среди безумия

- •Документ 12.6. Антипсихиатрия и психиатрия: право на безумие или право на лечение?

- •Документ 12.7. Не сводится ли весь секрет терапии к эффекту плацебо?

- •Документ 12.8. Пример фрейдистской интерпретации

- •Документ 12.9. От одной формы терапии к другой...

- •Материал для самопроверки

- •Литература

- •Близнецы

- •Физиология поведения Организация нервной системы

- •Рецепторы

- •Дополнение а.1. Звук и свет

- •Эффекторы

- •Периферическая нервная система

- •Дополнение а.2. Три «мозга» и эволюция нервной системы

- •Центральная нервная система

- •Кора большого мозга

- •Дополнение а.3. Расщепленный мозг

- •Структура и функции нейрона

- •Дополнение а.4. Нервная активность и сканер

- •Литература

- •Приложение б. Статистика и обработка данных Введение

- •Дополнение б.1. Некоторые основные понятия Популяция и выборка*

- •Дополнение б. 2. Влияние потребления марихуаны на глазодвигательную координацию и время реакции (гипотетический эксперимент)

- •Описательная статистика

- •Группировка данных

- •Опытная группа

- •Расчет стандартного отклонения* для фона контрольной группы

- •Индуктивная статистика

- •Проверка гипотез

- •Дополнение б. 3. Уровни достоверности (значимости)

- •Непараметрические методы

- •Корреляционный анализ

- •Коэффициент корреляции

- •Результаты вычислений, которые предложено было сделать читателям

- •Дополнение б.5. Таблицы

- •Литература

Корреляционный анализ

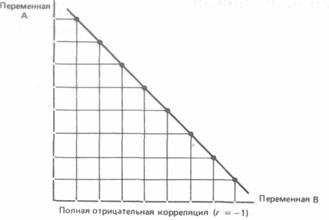

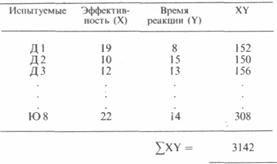

При изучении корреляций стараются установить, существует ли какая-то связь между двумя показателями в одной выборке (например, между ростом и весом детей или между уровнем IQ и школьной успеваемостью) либо между двумя различными выборками (например, при сравнении пар близнецов), и если эта связь существует, то сопровождается ли увеличение одного показателя возрастанием (положительная корреляция) или уменьшением (отрицательная корреляция) другого. Иными словами, корреляционный анализ помогает установить, можно ли предсказывать возможные значения одного показателя, зная величину другого. До сих пор при анализе результатов нашего опыта по изучению действия марихуаны мы сознательно игнорировали такой показатель, как время реакции. Между тем было бы интересно проверить, существует ли связь между эффективностью реакций и их быстротой. Это позволило бы, например, утверждать, что чем человек медлительнее, тем точнее и эффективнее будут его действия и наоборот. С этой целью можно использовать два разных способа: параметрический метод расчета коэффициента Браве - Пирсона (r) и вычисление коэффициента корреляции рангов Спирмена (rs), который применяется к порядковым данным, т. е. является непараметрическим. Однако разберемся сначала в том, что такое коэффициент корреляции.

Коэффициент корреляции

Коэффициент корреляции - это величина, которая может варьировать в пределах от -1 до 1. В случае полной положительной корреляции этот коэффициент равен плюс 1, а при полной отрицательной - минус 1. На графике этому соответствует прямая линия, проходящая через точки пересечения значений каждой пары данных:

Переменная

А

В

случае же если эти точки не выстраиваются

по прямой линии, а образуют «облако»,

коэффициент корреляции по абсолютной

величине становится меньше единицы и

по мере округления этого облака

приближается к нулю:

В случае если коэффициент корреляции равен 0, обе переменные полностью независимы друг от друга. В гуманитарных науках корреляция считается сильной, если ее коэффициент выше 0,60; если же он превышает 0,90, то корреляция считается очень сильной. Однако для того, чтобы можно было делать выводы о связях между переменными, большое значение имеет объем выборки: чем выборка больше, тем достовернее величина полученного коэффициента корреляции. Существуют таблицы с критическими значениями коэффициента корреляции Браве-Пирсона и Спирмена для разного числа степеней свободы (оно равно числу пар за вычетом 2, т. е. n-2). Лишь в том случае, если коэффициенты корреляции больше этих критических значений, они могут считаться достоверными. Так, для того чтобы коэффициент корреляции 0,70 был достоверным, в анализ должно быть взято не меньше 8 пар данных (h= п - 2 = 6) при вычислении r (табл. В.4) и 7 пар данных (h = п - 2 = 5) при вычислении rs (табл. 5 в дополнении Б. 5).

Коэффициент Браве – Пирсона

Для вычисления этого коэффициента применяют следующую формулу (у разных авторов она может выглядеть по-разному):

![]()

где

aXY-

сумма произведений данных из каждой

пары;

n-

число пар;

- средняя

для данных переменной X;

-

средняя для данных переменной Y;

SХ - стандартное

отклонение для распределения x;

sY - стандартное

отклонение для распределения у.

Теперь

мы можем использовать этот коэффициент

для того, чтобы установить, существует

ли связь между временем реакции испытуемых

и эффективностью их действий. Возьмем,

например, фоновый уровень контрольной

группы.

n= 15 ? 15,8 ? 13,4 = 3175,8;

(n – 1)SxSy= 14 ? 3,07 ? 2,29 = 98,42;

r = ![]()

Отрицательное значение коэффициента корреляции может означать, что чем больше время реакции, тем ниже эффективность. Однако величина его слишком мала для того, чтобы можно было говорить о достоверной связи между этим двумя переменными. Теперь попробуйте самостоятельно подсчитать коэффициент корреляции для экспериментальной группы после воздействия, зная, что aХУ= 2953: nXY=………

(n - 1)SXSY =……

![]()

Какой вывод можно сделать из этих результатов? Если вы считаете, что между переменными есть связь, то какова она - прямая или обратная? Достоверна ли она [см. табл. 4 (в дополнении Б. 5) с критическими значениями r]?

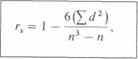

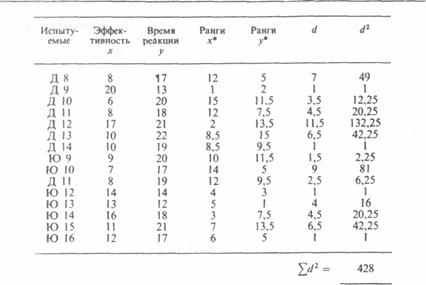

Коэффициент корреляции рангов Спирмена rs

Этот коэффициент рассчитывать проще, однако результаты получаются менее точными, чем при использовании r. Это связано с тем, что при вычислении коэффициента Спирмена используют порядок следования данных, а не их количественные характеристики и интервалы между классами. Дело в том, что при использовании коэффициента корреляции рангов Спирмена (rs) проверяют только, будет ли ранжирование данных для какой-либо выборки таким же, как и в ряду других данных для этой выборки, попарно связанных с первыми (например, будут ли одинаково «ранжироваться» студенты при прохождении ими как психологии, так и математики, или даже при двух разных преподавателях психологии?). Если коэффициент близок к + 1, то это означает, что оба ряда практически совпадают, а если этот коэффициент близок к - 1, можно говорить о полной обратной зависимости. Коэффициент rs вычисляют по формуле

где d- разность между рангами сопряженных значений признаков (независимо от ее знака), а n-число пар. Обычно этот непараметрический тест используется в тех случаях, когда нужно сделать какие-то выводы не столько об интервалах между данными, сколько об их рангах, а также тогда, когда кривые распределения слишком асимметричны и не позволяют использовать такие параметрические критерии, как коэффициент r (в этих случаях бывает необходимо превратить количественные данные в порядковые). Поскольку именно так обстоит дело с распределением значений эффективности и времени реакции в экспериментальной группе после воздействия, можно повторить расчеты, которые вы уже проделали для этой группы, только теперь не для коэффициента r, а для показателя rs. Это позволит посмотреть, насколько различаются эти два показателя*.

*

Следует помнить, что

1)

для числа попаданий 1-й ранг соответствует

самой высокой, а 15-й-самой низкой

результативности, тогда как для времени

реакции 1-й ранг соответствует самому

короткому времени, а 15-й-самому долгому;

*

Следует помнить, что

1)

для числа попаданий 1-й ранг соответствует

самой высокой, а 15-й-самой низкой

результативности, тогда как для времени

реакции 1-й ранг соответствует самому

короткому времени, а 15-й-самому долгому;

2) данным ex aequo придается средний ранг.

![]()

Таким образом, как и в случае коэффициента r, получен положительный, хотя и недостоверный, результат. Какой же из двух результатов правдоподобнее: r = -0,48 или rs = +0,24? Такой вопрос может встать лишь в том случае, если результаты достоверны. Хотелось бы еще раз подчеркнуть, что сущность этих двух коэффициентов несколько различна. Отрицательный коэффициент r указывает на то, что эффективность чаще всего тем выше, чем время реакции меньше, тогда как при вычислении коэффициента rs требовалось проверить, всегда ли более быстрые испытуемые реагируют более точно, а более медленные - менее точно. Поскольку в экспериментальной группе после воздействия был получен коэффициент rs, равный 0,24, подобная тенденция здесь, очевидно, не прослеживается. Попробуйте самостоятельно разобраться в данных для контрольной группы после воздействия, зная, что ad2 = 122,5:

![]() ;

достоверно ли?

Каков

ваш вывод?…………………………………

……………………………………………………………

…………………………………………………………………………………………………………………….

;

достоверно ли?

Каков

ваш вывод?…………………………………

……………………………………………………………

…………………………………………………………………………………………………………………….

Итак, мы рассмотрели различные параметрические и непараметрические статистические методы, используемые в психологии. Наш обзор был весьма поверхностным, и главная задача его заключалась в том, чтобы читатель понял, что статистика не так страшна, как кажется, и требует в основном здравого смысла. Напоминаем, что данные «опыта», с которыми мы здесь имели дело, - вымышленные и не могут служить основанием для каких-либо выводов. Впрочем, подобный эксперимент стоило бы действительно провести. Поскольку для этого опыта была выбрана сугубо классическая методика, такой же статистический анализ можно было бы использовать во множестве различных экспериментов. В любом случае нам кажется, что мы наметили какие-то главные направления, которые могут оказаться полезны тем, кто не знает, с чего начать статистический анализ полученных результатов.

Резюме

Существуют три главных раздела статистики: описательная статистика, индуктивная статистика и корреляционный анализ.

I. Описательная статистика 1. Задачи описательной статистики - классификация данных, построение распределения их частот, выявление центральных тенденций этого распределения и оценка разброса данных относительно средних. 2. Для классификации данных сначала располагают их в возрастающем порядке. Далее их разбивают на классы по величине, интервалы между которыми определяются в зависимости от того, что именно исследователь хочет выявить в данном распределении. 3. К наиболее часто используемым параметрам, с помощью которых можно описать распределение, относятся, с одной стороны, такие величины, как мода, медиана и средняя арифметическая, а с другой -показатели, разброса, такие как варианса (дисперсия) и стандартное отклонение. 4. Мода соответствует значению, которое встречается чаще других или находится в середине класса, обладающего наибольшей частотой. Медиана соответствует значению центрального данного, которое может быть получено после того, как все данные будут расположены в возрастающем порядке. Средняя арифметическая равна частному от деления суммы всех данных на их число. Распределение считается нормальным, если кривая распределения имеет колоколообразный вид, а все показатели центральной тенденции совпадают, что свидетельствует о симметричности распределения. 5. Диапазон распределения (размах вариаций) равен разности между наибольшим и наименьшим значениями результатов. 6. Среднее отклонение - это более точный показатель разброса, чем диапазон распределения. Для расчета среднего отклонения вычисляют среднюю разность между всеми значениями данных и средней арифметической или, упрощенно.

Среднее

отклонение = ![]() .

.

7. Еще один показатель разброса, вычисляемый из среднего отклонения, это варианса (дисперсия), равная среднему квадрату разностей между значениями всех данных и средней:

Варианса

= ![]()

8. Наиболее употребительным показателем разброса служит стандартное отклонение, равное квадратному корню из вариансы. Таким образом, это квадратный корень из суммы квадратов всех отклонений от средней:

![]()

9. Важное свойство стандартного отклонения заключается в том. что независимо от его абсолютной величины в нормальном распределении оно всегда соответствует одинаковому проценту данных, располагающихся по обе стороны от средней: 68% результатов располагаются в пределах одного стандартного отклонения в обе стороны от средней. 95%-в пределах двух стандартных отклонений и 99,7%-в пределах трех стандартных отклонений. 10. С помощью перечисленных выше показателей можно осуществить оценку различий между двумя или несколькими распределениями, позволяющую проверить, насколько эти различия могут быть экстраполированы на популяцию, из которой взяты выборки. Для этого применяют методы индуктивной статистики.

II. Индуктивная статистика

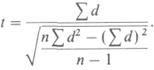

1. Задача индуктивной статистики заключается в том, чтобы оценить значимость тех различий, которые могут быть между двумя распределениями, с целью выяснить, можно ли распространить найденную закономерность на всю популяцию, из которой были взяты выборки. 2. Для того чтобы определить, достоверны ли различия между распределениями, следует выдвинутьгипотезу, которую нужно будет затем проверить статистическими методами. Нулевой гипотезойназывают предположение, согласно которому различие между распределениями недостоверно, тогда какальтернативная гипотеза утверждает противоположное. 3. В том случае, если данных достаточно, если эти данные количественные и подчиняютсянормальному распределению, для проверки гипотез используют параметрические критерии. Если же данных мало либо они являются порядковыми или качественными (см. дополнение Б.1), используют непараметрические критерии. 4. Из параметрических критериев наиболее эффективен и чаще всего используется критерий tСтьюдента. Этот критерий позволяет сравнить средние и стандартные отклонения для двух распределений. В случае если эти показатели принадлежат независимым выборкам, используют формулу

Для сопряженных выборок используют иную формулу:

5. Если необходимо сравнить три или большее число распределений, используют иной параметрическийметод.-дисперсионный анализ. При этом с помощью метода Шеффе можно выявить пары выборок, различия между которыми достоверны либо недостоверны. 6. Критерий c2 (хи-квадрат) - это непараметрический критерий, позволяющий проверить, являются ли две переменные независимыми друг от друга. По этому методу сравнивают, как распределяются эмпирические частоты в зависимости от критериев для каждой переменной, с тем, как они распределились бы теоретически, если бы переменные были независимыми. Далее с помощью таблицы, в которую сводятся все частоты, вычисляют критерий c2. Для этого сначала находят разницу между каждой эмпирической (Э) и соответствующей теоретической (Т) частотой, а затем сумму этих разностей:

c2

= a![]()

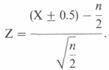

7. Критерий знаков (биномиальный тест) - еще один непараметрический метод, позволяющий легко определить, оказала ли независимая переменная существенное влияние по сравнению с исходным уровнем (фоном). Для этого сначала подсчитывают число «ухудшений» (-) или число «улучшений» ( + ), а затем сравнивают одно из этих двух чисел с тем, что могло бы получиться в результате чистой случайности (1 шанс из 2, или n/2). Для этого применяют формулу

8. Существуют и другие непараметрические тесты, которые приходится использовать для проверки гипотез тогда, когда нельзя применить параметрические критерии. К этим методам, в частности, относитсякритерий рангов, позволяющий определить, случайна или нет очередность событий в той или иной последовательности, а также критерий U и критерий Т. Последние два критерия используют в случае порядковых переменных соответственно для независимых и зависимых выборок. 9. Какой бы критерий ни использовался, его вычисленное значение следует сравнить с табличным для уровня значимости 0,05 с учетом числа степеней свободы. Если при этом вычисленный результат окажется выше, нулевая гипотеза может быть отвергнута и можно, следовательно, утверждать, что разница достоверна.

III. Корреляционный анализ

1. Задача корреляционного анализа заключается в том, чтобы установить возможную связь между двумя показателями, полученными на одной и той же или на двух различных выборках. При этом устанавливается, приводит ли увеличение какого-либо показателя к увеличению или уменьшению другого показателя. 2. Коэффициент корреляции колеблется в пределах от +1, что соответствует полной положительной корреляции, до — 1 в случае полной отрицательной корреляции. Если этот коэффициент равен 0, то никакой корреляции между двумя рядами данных нет. 3. Коэффициент корреляции Браве - Пирсона (r)-это параметрический показатель, для вычисления которого сравнивают средние и стандартные отклонения результатов двух измерений. При этом используют формулу

![]() 4. Коэффициент

корреляции рангов Спирмена (rs) -

это непараметрический

показатель, с помощью которого пытаются

выявить связь между рангами соответственных

величин в двух рядах измерений.

5.

Коэффициент корреляции может быть

значимым лишь при достаточном числе

пар данных, взятых в анализ. Это можно

проверить с помощью таблицы пороговых

значений r или rs для

уровня значимости 0,05.

4. Коэффициент

корреляции рангов Спирмена (rs) -

это непараметрический

показатель, с помощью которого пытаются

выявить связь между рангами соответственных

величин в двух рядах измерений.

5.

Коэффициент корреляции может быть

значимым лишь при достаточном числе

пар данных, взятых в анализ. Это можно

проверить с помощью таблицы пороговых

значений r или rs для

уровня значимости 0,05.