- •Предисловие

- •Лекция 1. Информация. Начальные понятия и определения

- •1. Информация и данные

- •2. Адекватность и формы адекватности информации

- •3. Качество информации

- •4. Понятие об информационном процессе

- •5. Формы представления информации

- •6. Преобразование сообщений

- •Лекция 2. Необходимые сведения из теории вероятностей

- •1. Понятие вероятности

- •2. Сложение вероятностей независимых несовместных событий

- •3. Умножение вероятностей независимых совместных событий

- •4. Нахождение среднего для значений случайных независимых величин

- •5. Понятие условной вероятности

- •6. Общая формула для вероятности произведения событий

- •7. Общая формула для вероятности суммы событий

- •Лекция 3. Понятие энтропии

- •1. Энтропия как мера неопределенности

- •2. Свойства энтропии

- •3. Условная энтропия

- •Лекция 4. Энтропия и информация

- •1. Объемный подход к измерению количества информации

- •2. Энтропийный подход к измерению количества информации

- •Лекция 5. Информация и алфавит

- •Лекция 6. Постановка задачи кодирования. Первая теорема Шеннона.

- •Лекция 7. Способы построения двоичных кодов. Алфавитное неравномерное двоичное кодирование сигналами равной длительности. Префиксные коды.

- •1. Постановка задачи оптимизации неравномерного кодирования

- •00100010000111010101110000110

- •2. Неравномерный код с разделителем

- •3. Коды без разделителя. Условие Фано

- •00100010000111010101110000110

- •00100010000111010101110000110

- •4. Префиксный код Шеннона–Фано

- •5. Префиксный код Хаффмана

- •Лекция 8. Способы построения двоичных кодов. Другие варианты

- •1. Равномерное алфавитное двоичное кодирование. Байтовый код

- •2. Международные системы байтового кодирования текстовых данных. Универсальная система кодирования текстовых данных

- •3. Алфавитное кодирование с неравной длительностью элементарных сигналов. Код Морзе

- •4. Блочное двоичное кодирование

- •101010111001100010000000001000000000000001

- •5. Кодирование графических данных

- •6. Кодирование звуковой информации

- •Лекция 9. Системы счисления. Представление чисел в различных системах счисления. Часть 1

- •1. Системы счисления

- •2. Десятичная система счисления

- •3. Двоичная система счисления

- •4. 8- И 16-ричная системы счисления

- •5. Смешанные системы счисления

- •6. Понятие экономичности системы счисления

- •Лекция 10. Системы счисления. Представление чисел в различных системах счисления. Часть 2.

- •1. Задача перевода числа из одной системы счисления в другую

- •2. Перевод q p целых чисел

- •3. Перевод p q целых чисел

- •4. Перевод p q дробных чисел

- •6. Перевод чисел между 2-ичной, 8-ричной и 16-ричной системами счисления

- •Лекция 11. Кодирование чисел в компьютере и действия над ними

- •1. Нормализованные числа

- •2. Преобразование числа из естественной формы в нормализованную

- •3. Преобразование нормализованных чисел

- •4. Кодирование и обработка целых чисел без знака

- •5. Кодирование и обработка целых чисел со знаком

- •6. Кодирование и обработка вещественных чисел

- •Лекция 12. Передача информации в линии связи

- •1. Общая схема передачи информации в линии связи

- •2. Характеристики канала связи

- •3. Влияние шумов на пропускную способность канала

- •Лекция 13. Обеспечение надежности передачи информации.

- •1. Постановка задачи обеспечения надежности передачи

- •2. Коды, обнаруживающие одиночную ошибку

- •3. Коды, исправляющие одиночную ошибку

- •Лекция 14. Способы передачи информации в компьютерных линиях связи

- •1. Параллельная передача данных

- •2. Последовательная передача данных

- •3. Связь компьютеров по телефонным линиям

- •Лекция 15. Классификация данных. Представление данных в памяти компьютера

- •1. Классификация данных

- •2. Представление элементарных данных в озу

- •Лекция 16. Классификация структур данных

- •1. Классификация и примеры структур данных

- •2. Понятие логической записи

- •Лекция 17. Организация структур данных в оперативной памяти и на внешних носителях

- •1. Организация структур данных в озу

- •2. Иерархия структур данных на внешних носителях

- •3. Особенности устройств хранения информации

- •Контрольные вопросы

- •Список литературы

2. Свойства энтропии

Как следует из формулы (4.4),

только в двух случаях:

только в двух случаях:

когда вероятность какого-либо исхода равна 1, поэтому вероятности остальных исходов равны 0, то есть один из исходов достоверен, поэтому общий итог опыта перестает быть случайным;

все

,

то есть никакие из рассматриваемых

исходов опыта невозможны. Во

всех остальных случаях

,

то есть никакие из рассматриваемых

исходов опыта невозможны. Во

всех остальных случаях

.

.

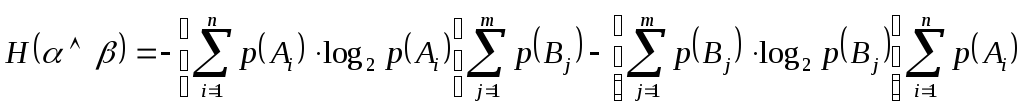

Очевидным следствием формулы (4.1) будет утверждение, что для двух независимых опытов

и

и

![]() . (4.5)

. (4.5)

Энтропия сложного опыта, состоящего из нескольких независимых опытов, равна сумме энтропий отдельных опытов.

Приведем доказательство формулы (4.5).

Пусть

опыт

![]() имеет

имеет

![]() исходов

исходов

![]() ,

,

![]() ,

…,

,

…,

![]() ,

которые реализуются с вероятностями

,

которые реализуются с вероятностями

![]() ,

,

![]() ,

…,

,

…,

![]() ,

а опыт

,

а опыт

![]() имеет

имеет

![]() исходов

исходов

![]() ,

,

![]() ,

…,

,

…,

![]() с вероятностями

с вероятностями

![]() ,

,

![]() ,

…,

,

…,

![]() .

Сложный опыт

.

Сложный опыт

![]() имеет

имеет

![]() исходов типа

исходов типа

![]() ,

где

,

где

![]() ,

,

![]() .

Поэтому (см. (4.4)):

.

Поэтому (см. (4.4)):

![]() . (4.6)

. (4.6)

Поскольку

опыты

![]() и

и![]() независимы, то независимыми окажутся

события в любой паре

независимы, то независимыми окажутся

события в любой паре![]() .

Поэтому:

.

Поэтому:

![]() ,

на основании чего

,

на основании чего

![]()

Таким образом, формулу (4.6) перепишем так:

![]() ;

;

![]() ;

;

.

.

Известно, что по условию нормировки вероятностей

![]() и

и

![]() ,

,

Из формулы (4.4) следует, что

![]() и

и

![]() .

.

Поэтому окончательно имеем:

![]() ,

,

что и требовалось доказать.

Теперь

рассмотрим ситуацию, когда имеются два

опыта с одинаковым числом исходов

![]() ,

в одном случае (

,

в одном случае (![]() )

они равновероятны, а в другом (

)

они равновероятны, а в другом (![]() )

– нет. Каково соотношение энтропий этих

опытов? Примем без доказательства

следующее утверждение:

)

– нет. Каково соотношение энтропий этих

опытов? Примем без доказательства

следующее утверждение:

![]() . (4.7)

. (4.7)

При прочих равных условиях наибольшую энтропию имеет опыт с равновероятными исходами.

Другими словами, энтропия максимальна в опытах, где все исходы равновероятны.

Кстати, результат, полученный в рассмотренном выше примере 1, иллюстрирует справедливость формулы (4.7).

Здесь усматривается аналогия (имеющая глубинную первооснову!) с понятием энтропии, используемым в физике. Впервые понятие энтропии было введено в 1865 году немецким физиком Рудольфом Клаузиусом: энтропия – это функция состояния термодинамической системы, описывающая направленность самопроизвольных процессов в системе. Клаузиус сформулировал II начало термодинамики. В частности, он показал, что энтропия достигает максимума в состоянии равновесия системы. Позднее, в 1872 году Людвиг Больцман, развивая статистическую теорию, связал энтропию системы с вероятностью ее (системы) состояния, дал статистическое (вероятностное) толкование II-му началу теормодинамики. В частности, Больцман показал, что вероятность максимальна у полностью разупорядоченной (равновесной) системы (аналогия с опытом, имеющим равновероятные исходы). Энтропия и термодинамическая вероятность тоже связаны логарифмической зависимостью. В физике энтропия мера беспорядка в системе. При этом беспорядок понимается как отсутствие знания о характеристиках объекта (например, координат и скорости молекулы газа); с ростом беспорядка в системе возрастает энтропия, то есть возрастает наше незнание о системе, другими словами, уменьшаются наши знания о системе.

3. Условная энтропия

Найдем

энтропию сложного опыта ![]() в том случае, если опыты не являются

независимыми, то есть если на исход

опыта

в том случае, если опыты не являются

независимыми, то есть если на исход

опыта ![]() оказывает влияние результат опыта

оказывает влияние результат опыта ![]() .

Например, пусть в ящике всего два

разноцветных шара и опыт

.

Например, пусть в ящике всего два

разноцветных шара и опыт ![]() состоит в извлечении первого, а опыт

состоит в извлечении первого, а опыт ![]() – в извлечении второго из них. В этом

случае результат опыта

– в извлечении второго из них. В этом

случае результат опыта ![]() полностью снимает неопределенность

сложного опыта

полностью снимает неопределенность

сложного опыта ![]() ,

то есть оказывается, что

,

то есть оказывается, что ![]() ,

но не

,

но не ![]() .

Сумма проявляется лишь для независимых

событий!

.

Сумма проявляется лишь для независимых

событий!

Связь

между зависимыми опытами ![]() и

и ![]() состоит в том, что какие-то из исходов

состоит в том, что какие-то из исходов

![]() могут оказывать влияние на исходы

могут оказывать влияние на исходы ![]() ,

то есть некоторые пары событий

,

то есть некоторые пары событий ![]() и

и

![]() не являются независимыми. Вернемся к

формуле (4.6) для энтропии сложного опыта:

не являются независимыми. Вернемся к

формуле (4.6) для энтропии сложного опыта:

![]() .

.

В

случае зависимых событий: ![]() ,

где

,

где ![]() – это вероятность наступления исхода

– это вероятность наступления исхода

![]() опыта

опыта

![]() при условии, что в опыте

при условии, что в опыте![]() имел место исход

имел место исход![]() .

.

В этом случае по свойству логарифма:

![]() .

.

После подстановки в формулу (4.6) получаем:

![]() ;

;

![]() ;

;

Устанавливаем порядок суммирования, по аналогии с интегрированием:

![]()

В этой формуле:

![]() ,

так как какое-то из событий

,

так как какое-то из событий ![]() обязательно произойдет после того, как

произошло событие

обязательно произойдет после того, как

произошло событие ![]() ,

поэтому:

,

поэтому:

![]() ;

;

![]() ,

в результате

,

в результате

![]() .

.

![]() ,

,

таким образом,

![]() ;

;

Величины

![]() (4.8)

(4.8)

имеют

смысл энтропии опыта ![]() при условии, что в опыте

при условии, что в опыте ![]() реализовался исход

реализовался исход ![]() .

Величину

.

Величину ![]() будем называть условной

энтропией.

будем называть условной

энтропией.

Величина

![]() (4.9)

(4.9)

имеет

смысл средней

условной энтропии опыта

![]() при выполнении опыта

при выполнении опыта

![]() .

Окончательно получаем для энтропии

сложного опыта при условии, что в нем

могут быть зависимые исходы:

.

Окончательно получаем для энтропии

сложного опыта при условии, что в нем

могут быть зависимые исходы:

![]() . (4.10)

. (4.10)

Полученное

выражение представляет собой общее

правило нахождения энтропии сложного

опыта. Совершенно очевидно, что выражение

(4.5) является частным случаем формулы

(4.10) при условии независимости опытов

![]() и

и ![]() .

.

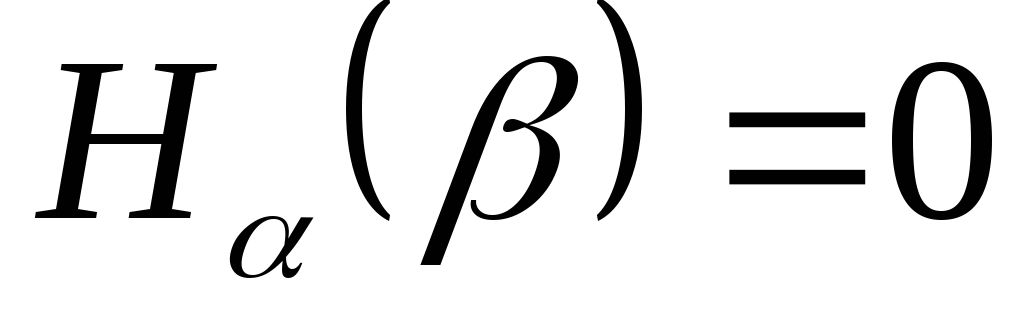

Относительно условной энтропии можно сделать следующие утверждения:

Условная энтропия является величиной неотрицательной.

только в том случае, если любой

исход опыта

только в том случае, если любой

исход опыта  полностью определяет исход опыта

полностью определяет исход опыта  (как в рассмотренном выше примере с

двумя разноцветными шарами), то есть

(как в рассмотренном выше примере с

двумя разноцветными шарами), то есть  при

при  .

В этом случае

.

В этом случае  .

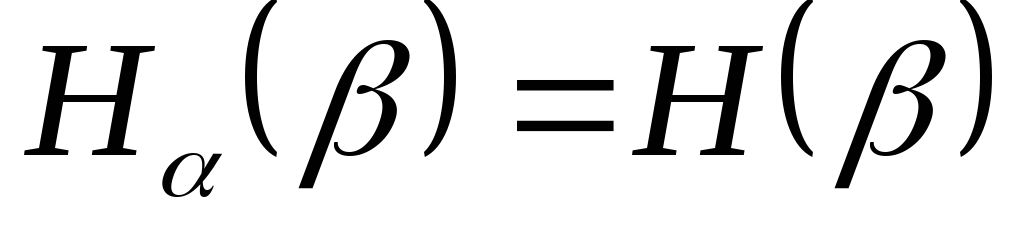

.Если опыты

и

и  независимы, то

независимы, то  ,

причем

,

причем

![]() . (4.11)

. (4.11)

Другими

словами, опыт

![]() может либо не оказывать никакого влияния

на энтропию опыта

может либо не оказывать никакого влияния

на энтропию опыта![]() (если опыты независимы), либо может

понижать энтропию опыта

(если опыты независимы), либо может

понижать энтропию опыта![]() (то есть повысить определенность,

повысить наше знание об исходах опыта

(то есть повысить определенность,

повысить наше знание об исходах опыта![]() ).

Таким образом, условная энтропия не

превосходит безусловную.

).

Таким образом, условная энтропия не

превосходит безусловную.

3. Из соотношений (4.10) и (4.11) следует, что

![]() , (4.12)

, (4.12)

причем

равенство реализуется только при

независимости опытов

![]() и

и![]() .

.

Пример. В ящике имеются 2 белых и 4 черных шара. Из ящика извлекают последовательно два шара без возврата. Найти энтропию, связанную с первым и вторым извлечениями, а также энтропию обоих извлечений.

Будем

считать опытом

![]() извлечение первого шара. Он имеет два

исхода. Первый исход

извлечение первого шара. Он имеет два

исхода. Первый исход![]() – вынут белый шар; его вероятность

– вынут белый шар; его вероятность![]() .

Второй исход –

.

Второй исход –![]() – вынут черный шар; его вероятность

– вынут черный шар; его вероятность![]() .

По формуле (4.4) сразу находим:

.

По формуле (4.4) сразу находим:

![]() .

.

Опыт

![]() – также имеет два исхода.

– также имеет два исхода.![]() – вынут белый шар,

– вынут белый шар,![]() – вынут черный шар, однако вероятности

этих исходов зависят от того, каким был

исход опыта

– вынут черный шар, однако вероятности

этих исходов зависят от того, каким был

исход опыта![]() .

Именно,

.

Именно,

При

![]() :

:![]() и

и![]() ;

;

При

![]() :

:![]() и

и![]() .

.

Итак, энтропия, связанная со вторым опытом, является условной, и, согласно, формуле (4.8), получаем:

![]() ;

;

![]() .

.

По формуле (4.9) получаем:

![]() .

.

По формуле (4.10) получаем:

![]() .

.

Ответ:

![]() ,

,![]() ,

,

![]() .

.