- •Предисловие

- •Лекция 1. Информация. Начальные понятия и определения

- •1. Информация и данные

- •2. Адекватность и формы адекватности информации

- •3. Качество информации

- •4. Понятие об информационном процессе

- •5. Формы представления информации

- •6. Преобразование сообщений

- •Лекция 2. Необходимые сведения из теории вероятностей

- •1. Понятие вероятности

- •2. Сложение вероятностей независимых несовместных событий

- •3. Умножение вероятностей независимых совместных событий

- •4. Нахождение среднего для значений случайных независимых величин

- •5. Понятие условной вероятности

- •6. Общая формула для вероятности произведения событий

- •7. Общая формула для вероятности суммы событий

- •Лекция 3. Понятие энтропии

- •1. Энтропия как мера неопределенности

- •2. Свойства энтропии

- •3. Условная энтропия

- •Лекция 4. Энтропия и информация

- •1. Объемный подход к измерению количества информации

- •2. Энтропийный подход к измерению количества информации

- •Лекция 5. Информация и алфавит

- •Лекция 6. Постановка задачи кодирования. Первая теорема Шеннона.

- •Лекция 7. Способы построения двоичных кодов. Алфавитное неравномерное двоичное кодирование сигналами равной длительности. Префиксные коды.

- •1. Постановка задачи оптимизации неравномерного кодирования

- •00100010000111010101110000110

- •2. Неравномерный код с разделителем

- •3. Коды без разделителя. Условие Фано

- •00100010000111010101110000110

- •00100010000111010101110000110

- •4. Префиксный код Шеннона–Фано

- •5. Префиксный код Хаффмана

- •Лекция 8. Способы построения двоичных кодов. Другие варианты

- •1. Равномерное алфавитное двоичное кодирование. Байтовый код

- •2. Международные системы байтового кодирования текстовых данных. Универсальная система кодирования текстовых данных

- •3. Алфавитное кодирование с неравной длительностью элементарных сигналов. Код Морзе

- •4. Блочное двоичное кодирование

- •101010111001100010000000001000000000000001

- •5. Кодирование графических данных

- •6. Кодирование звуковой информации

- •Лекция 9. Системы счисления. Представление чисел в различных системах счисления. Часть 1

- •1. Системы счисления

- •2. Десятичная система счисления

- •3. Двоичная система счисления

- •4. 8- И 16-ричная системы счисления

- •5. Смешанные системы счисления

- •6. Понятие экономичности системы счисления

- •Лекция 10. Системы счисления. Представление чисел в различных системах счисления. Часть 2.

- •1. Задача перевода числа из одной системы счисления в другую

- •2. Перевод q p целых чисел

- •3. Перевод p q целых чисел

- •4. Перевод p q дробных чисел

- •6. Перевод чисел между 2-ичной, 8-ричной и 16-ричной системами счисления

- •Лекция 11. Кодирование чисел в компьютере и действия над ними

- •1. Нормализованные числа

- •2. Преобразование числа из естественной формы в нормализованную

- •3. Преобразование нормализованных чисел

- •4. Кодирование и обработка целых чисел без знака

- •5. Кодирование и обработка целых чисел со знаком

- •6. Кодирование и обработка вещественных чисел

- •Лекция 12. Передача информации в линии связи

- •1. Общая схема передачи информации в линии связи

- •2. Характеристики канала связи

- •3. Влияние шумов на пропускную способность канала

- •Лекция 13. Обеспечение надежности передачи информации.

- •1. Постановка задачи обеспечения надежности передачи

- •2. Коды, обнаруживающие одиночную ошибку

- •3. Коды, исправляющие одиночную ошибку

- •Лекция 14. Способы передачи информации в компьютерных линиях связи

- •1. Параллельная передача данных

- •2. Последовательная передача данных

- •3. Связь компьютеров по телефонным линиям

- •Лекция 15. Классификация данных. Представление данных в памяти компьютера

- •1. Классификация данных

- •2. Представление элементарных данных в озу

- •Лекция 16. Классификация структур данных

- •1. Классификация и примеры структур данных

- •2. Понятие логической записи

- •Лекция 17. Организация структур данных в оперативной памяти и на внешних носителях

- •1. Организация структур данных в озу

- •2. Иерархия структур данных на внешних носителях

- •3. Особенности устройств хранения информации

- •Контрольные вопросы

- •Список литературы

7. Общая формула для вероятности суммы событий

Обобщим формулу для вероятности

наступления суммарного события (3.5) на

ситуацию, когда отдельные события

![]() и

и![]() могут оказаться совместными, то есть

происходить одновременно. В этом случае

получается, что

могут оказаться совместными, то есть

происходить одновременно. В этом случае

получается, что

![]() .

.

Пусть событие

![]() выполняется при

выполняется при![]() исходах из

исходах из![]() равновероятных возможных исходов опыта,

а событие

равновероятных возможных исходов опыта,

а событие![]() выполняется при

выполняется при![]() исходах из тех же

исходах из тех же![]() возможных исходов опыта. Однако из-за

того, что возможно совместное выполнение

событий

возможных исходов опыта. Однако из-за

того, что возможно совместное выполнение

событий![]() и

и![]() ,

исходы

,

исходы![]() и

и![]() могут оказаться не полностью различимыми,

то есть среди них могут быть одни и те

же исходы. Тогда суммарное количество

благоприятных исходов (когда выполняется

могут оказаться не полностью различимыми,

то есть среди них могут быть одни и те

же исходы. Тогда суммарное количество

благоприятных исходов (когда выполняется![]() или

или![]() )

)![]() .

Следовательно,

.

Следовательно,

![]() ,

,

то есть получаем

![]() .

.

Определим конкретное значение величины

![]() .

.

Пусть среди исходов

![]() и

и![]() имеются

имеются![]() общих исходов, то есть таких, когда

события

общих исходов, то есть таких, когда

события![]() и

и![]() наступают одновременно. Вероятностьсовместногособытия (одновременного

наступления

наступают одновременно. Вероятностьсовместногособытия (одновременного

наступления![]() и

и![]() )

равна

)

равна

![]() . (3.15)

. (3.15)

Общее количество различныхблагоприятных исходов равно![]() .

Тогда вероятность равна

.

Тогда вероятность равна

![]() . (3.16)

. (3.16)

Таким образом, окончательно получаем:

![]() . (3.17)

. (3.17)

В частном случае, когда события

![]() и

и![]() несовместны,

несовместны,

![]() ,

и вместо (3.16) или (3.17) мы получаем формулу

(3.5).

,

и вместо (3.16) или (3.17) мы получаем формулу

(3.5).

Пример. Какова вероятность вынуть

из колоды 36 карт козыря или туза, если

одна из мастей объявлена козырной?

Событие![]() – получение козыря – имеет вероятность

– получение козыря – имеет вероятность![]() ,

поскольку карт одной масти в колоде

имеется 9. Событие

,

поскольку карт одной масти в колоде

имеется 9. Событие![]() – получение туза – имеет вероятность

– получение туза – имеет вероятность![]() ,

поскольку тузов 4. Однако один туз

является козырным (то есть события

,

поскольку тузов 4. Однако один туз

является козырным (то есть события![]() и

и![]() реализуются одновременно, а такой

вариант по условию задачи мынерассматриваем как благоприятное

событие); вероятность его появления

равна

реализуются одновременно, а такой

вариант по условию задачи мынерассматриваем как благоприятное

событие); вероятность его появления

равна![]() .

Тогда, согласно формуле (3.17), получаем:

.

Тогда, согласно формуле (3.17), получаем:![]() .

.

С учетом формул (3.14) и (3.16) можно получить самое общее правило сложения вероятностей:

![]() . (3.18)

. (3.18)

Лекция 3. Понятие энтропии

Энтропия как мера неопределенности

Свойства энтропии

Условная энтропия

1. Энтропия как мера неопределенности

Случайные события могут быть описаны с использованием понятия «вероятность». Соотношения теории вероятностей позволяют найти (вычислить) вероятности как одиночных случайных событий, так и исходов сложных опытов, объединяющих несколько независимых или связанных между собой событий. Однако описать случайные события можно не только в термнах вероятностей.

То, что событие случайно, означает отсутствие полной уверенности в его наступлении. Это создает неопределенность в исходах опытов, в результате которых данное событие может произойти. Безусловно, степень неопределенности различна для разных ситуаций. Например, если опыт состоит в определении возраста случайно выбранного студента 1-го курса дневного отделения ВУЗа, то с большой степенью уверенности можно лишь утверждать, что он окажется менее 30 лет. При этом с меньшей уверенностью можно утверждать, что возраст произвольно выбранного студента окажется менее 17 лет. Таким образом, существует неопределенность в исходе опыта, который состоит в проверке возраста случайно выбранного студента.

Для практики важно иметь возможность произвести численную оценку неопределенности исходов разных опытов. Попробуем ввести такую количественную меру неопределенности.

Начнем

с простой ситуации, когда опыт имеет

![]() равновероятных исходов. Очевидно, что

неопределенность каждого из них зависит

от

равновероятных исходов. Очевидно, что

неопределенность каждого из них зависит

от![]() ,

то есть мера неопределенности является

функцией числа исходов

,

то есть мера неопределенности является

функцией числа исходов![]() .

.

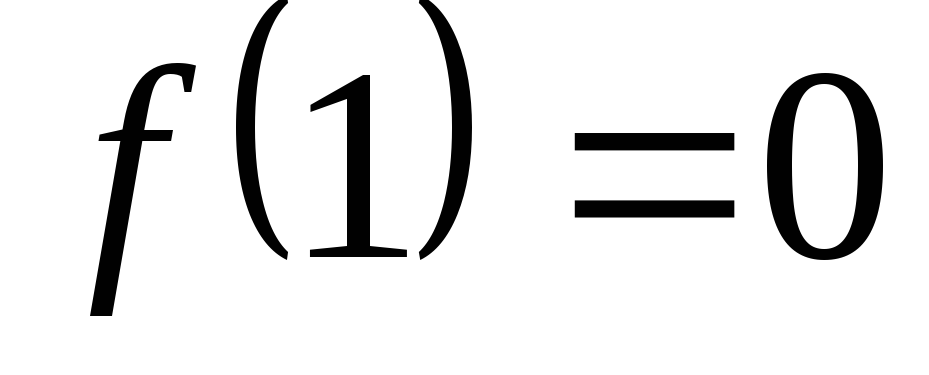

Можно сразу указать некоторые свойства этой функции:

,

поскольку при

,

поскольку при

исход опыта не является случайным и,

следовательно, неопределенность

отсутствует;

исход опыта не является случайным и,

следовательно, неопределенность

отсутствует; возрастает

с ростом

возрастает

с ростом

,

поскольку чем больше число возможных

исходов, тем более затруднительным

становится предсказание результата

опыта.

,

поскольку чем больше число возможных

исходов, тем более затруднительным

становится предсказание результата

опыта.

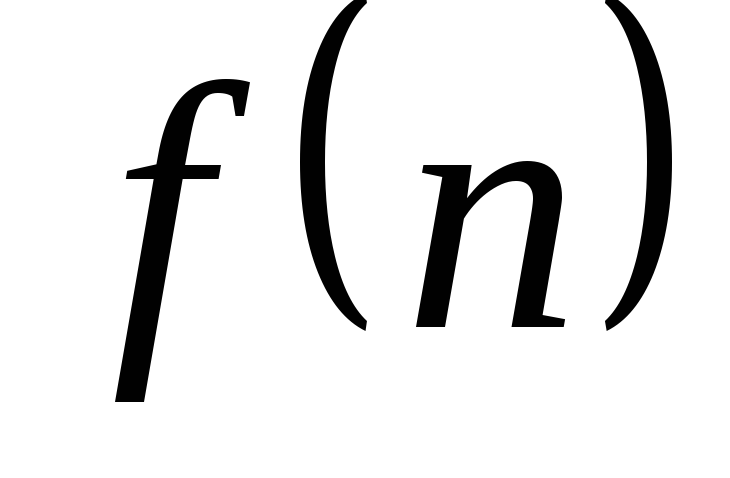

Попробуем определить явный вид функции

![]() .

Будем обозначатьопытысо случайными

исходами маленькими греческими буквами

.

Будем обозначатьопытысо случайными

исходами маленькими греческими буквами![]() ,

,![]() и так далее, а отдельныеисходыопытов (события) – латинскими заглавными

буквами

и так далее, а отдельныеисходыопытов (события) – латинскими заглавными

буквами![]() ,

,![]() и так далее

и так далее

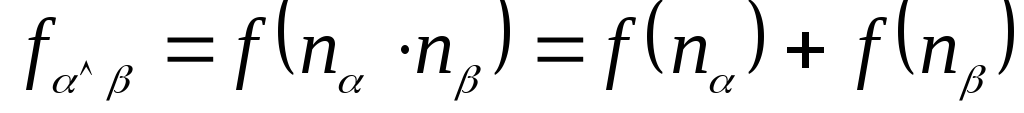

Рассмотрим два независимыхопыта![]() и

и![]() с количествами равновероятных исходов

соответственно

с количествами равновероятных исходов

соответственно![]() и

и![]() .

.

Пусть имеет место сложныйопыт,

который состоит в одновременном

выполнении опытов![]() и

и![]() .

Число возможных равновероятных его

исходов равно

.

Число возможных равновероятных его

исходов равно![]() .

Очевидно, неопределенность исхода

такого сложного опыта

.

Очевидно, неопределенность исхода

такого сложного опыта![]() будет больше неопределенности опыта

будет больше неопределенности опыта![]() ,

поскольку к ней добавляется неопределенность

опыта

,

поскольку к ней добавляется неопределенность

опыта![]() .

Естественно обозначить неопределенность

этого сложного опыта

.

Естественно обозначить неопределенность

этого сложного опыта![]() как

как![]() .

С другой стороны, меры неопределенности

отдельных опытов

.

С другой стороны, меры неопределенности

отдельных опытов![]() и

и![]() составляют соответственно

составляют соответственно![]() и

и![]() .

В случае сложного опыта

.

В случае сложного опыта![]() проявляется общая (суммарная)

неопределенность совместных событий.

Однако из независимости

проявляется общая (суммарная)

неопределенность совместных событий.

Однако из независимости![]() и

и![]() следует, что в сложном опыте неопределенности

каждого из

следует, что в сложном опыте неопределенности

каждого из![]() и

и![]() никак не могут повлиять друг на друга.

Следовательно, мера суммарной

неопределенности должна быть равна

сумме мер неопределенности каждого из

опытов, то естьмера неопределенности

аддитивна:

никак не могут повлиять друг на друга.

Следовательно, мера суммарной

неопределенности должна быть равна

сумме мер неопределенности каждого из

опытов, то естьмера неопределенности

аддитивна:

![]() . (4.1)

. (4.1)

Теперь задумаемся о том, каким может

быть явный вид функции

![]() ,

чтобы она удовлетворяла следующим

свойствам:

,

чтобы она удовлетворяла следующим

свойствам:

;

; возрастает

с ростом

возрастает

с ростом

;

; .

.

Легко увидеть, что такому набору свойств

удовлетворяет логарифмическая

функция![]() ,

причем доказано, что онаединственнаяиз всех существующих классов функций.

,

причем доказано, что онаединственнаяиз всех существующих классов функций.

Таким образом,

За меру неопределенности опыта с

![]() равновероятными исходами принимается

число

равновероятными исходами принимается

число![]() .

.

Отметим, что выбор основания логарифма в данном случае принципиального значения не имеет, так как в силу известной формулы преобразования логарифма от одного основания к другому:

![]() .

.

Изменение значения основания логарифма

связано с выбором единицы измерения

неопределенности. Удобным основанием

оказывается число 2. В этом случае за

единицу измерения неопределенности

принимается неопределенность, содержащаяся

в опыте, имеющем лишь два равновероятных

исхода:

![]() ,

поэтому

,

поэтому![]() .

.

Единица измерения неопределенности называется бит.

1 бит – это неопределенность, заключенная в опыте с двумя равновероятными исходами.

Таким образом, нами установлен явный

вид функции, описывающей меру

неопределенности исхода опыта, имеющего

![]() равновероятных исходов:

равновероятных исходов:

![]() . (4.2)

. (4.2)

Величина меры неопределенности получила название энтропия. Будем ее обозначатьH.

Вновь рассмотрим опыт с

![]() равновероятными исходами. Поскольку

каждый исход случаен, он вносит свой

вклад в неопределенность всего опыта.

Но так как все

равновероятными исходами. Поскольку

каждый исход случаен, он вносит свой

вклад в неопределенность всего опыта.

Но так как все![]() исходов равновероятны, разумно допустить,

что каждый из этих исходов вносит в опыт

одинаковую долю неопределенности. Из

свойства аддитивности неопределенности,

а также из свойства (4.2) следует, что

неопределенность, вносимая одним исходом

равна

исходов равновероятны, разумно допустить,

что каждый из этих исходов вносит в опыт

одинаковую долю неопределенности. Из

свойства аддитивности неопределенности,

а также из свойства (4.2) следует, что

неопределенность, вносимая одним исходом

равна

![]() ,

,

где

![]() – вероятность любого из отдельных

исходов.

– вероятность любого из отдельных

исходов.

Таким образом, неопределенность, вносимая каждым из равновероятных исходов, равна:

![]() . (4.3)

. (4.3)

Теперь обобщим формулу (4.3) на ситуацию,

когда исходы

![]() опыта

опыта![]() неравновероятны и имеют вероятности

неравновероятны и имеют вероятности![]() ,

где

,

где![]() .

.

Тогда неопределенность, вносимая

![]() -м

исходом равна

-м

исходом равна

![]() .

.

По свойству аддитивности неопределенности (энтропии) общая неопределенность опыта равна

![]() . (4.4)

. (4.4)

Введенная таким образом величина

(4.4), как уже было сказано, называется

энтропией опыта

![]() .

.

Энтропия является мерой неопределенности результата опыта, в котором проявляются случайные события, и равна средней неопределенности всех возможных его исходов.

Для практики формула (4.4) важна тем, что позволяет сравнить неопределенности различных опытов со случайными исходами.

Пример 1. Имеются два ящика, в каждом из которых по 12 шаров. В первом – 3 белых, 3 черных и 6 красных; во втором – каждого цвета по 4. Опыты состоят в вытаскивании по одному шару из каждого ящика. Что можно сказать относительно неопределенностей исходов этих опытов? Согласно формуле (4.4) находим энтропии обоих опытов:

![]() ;

;

![]() ;

;

Таким образом,

![]() ,

то есть неопределенность результата в

опыте

,

то есть неопределенность результата в

опыте![]() выше, и, следовательно, предсказать его

исход можно с меньшей долей уверенности,

чем результат опыта

выше, и, следовательно, предсказать его

исход можно с меньшей долей уверенности,

чем результат опыта![]() .

.