НИРС Андреев / МНИ

.pdfэтому при оценке степени адекватности проверяют гипотезу о значимости расхождения остаточных дисперсий. Проверка может быть выполнена с помощью F-критерия.

При выборе структуры регрессионной модели естественно стремиться к тому, чтобы заданная точность модели достигалась при наименьшем числе используемых входных переменных. Если входные переменные не коррелированны, процедура определения оптимальной в указанном смысле структуры регрессионной модели может сводиться, например, к тому, что рассматриваются полиномы порядка п – 1, а затем проверяется гипотеза о значимости различия остаточных дисперсий или значимости коэффициентов при переменной порядка n.

В тех случаях, когда входные переменные коррелированы между собой, т.е. их взаимосвязь высока, задача усложняется. Для определения оптимальной структуры модели применяются различные поисковые методы, в том числе регрессионный анализ с упорядоченным перебором факторов, который состоит в следующем.

Пусть имеется k входных переменных. Тогда указанная процедура будет состоять из ряда последовательных шагов. На первом шаге строятся одномерные модели и среди них выбирается та, которая соответствует минимуму остаточной дисперсии; на втором шаге строятся все двумерные модели, в каждую из которых входит фактор, выбранный на первом шаге. Поиск продолжается до тех пор, пока не будут исследованы все факторы или не будет получена модель требуемой точности.

9.4. Определение динамических характеристик объектов исследования при пассивном эксперименте

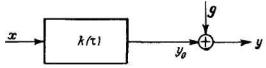

Для пояснения типичной задачи определения динамических характеристик технологических объектов управления рассмотрим систему, приведенную на блок-схеме рис. 9.4. Функция времени x(t) описывает изменение входной переменной, а функция у0(t) – изменение выходной переменной, являющейся реакцией на сигнал x(t); сигнал y(t) является суммой сигнала у0(t) и помехи g(t) Помеха g(t) может состоять из реакции на другие входные сигналы в общем случае неконтролируемые, из приборных погрешностей и т.д. Здесь свойства объекта представлены весовой функцией k(t). Для простоты рассуждения будем полагать, что все сигналы являются стационарными и центрированными. Уравнение связи, описывающее систему, может быть представлено в следующей интегральной форме:

¥ |

|

y(t) = òk(t)x(t - t)dt + g(t) |

(9.40) |

0

В задачу идентификации входит определение весовой функции по экспериментальным данным y(t) и x(t).

121

Рис. 9.4. К задаче идентификации динамических характеристик объекта

Определить оценку весовой функции из уравнений (9.40) трудно, так как значение оценок может существенно погрешностью g(t). Для определения весовой функций вычислим оценку взаимно-корреляционной функции:

|

|

|

|

|

|

|

|

|

Ryx (q) = |

1 |

T y(t)x(t - q)dt |

|

(9.41) |

||||||||

|

|

|

|

|

|

|

|

|

|

|

|||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

T |

ò |

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

0 |

|

|

|

|

|

|

|

|

Подставив в правую часть уравнения (9.41) значение y(t) из (9.40), по- |

||||||||||||||||||||

лучим: |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

|

|

1 |

T |

|

|

¥ |

|

|

|

|

|

1 |

T |

|

|

|

|

||||

Ryx(q) = |

ò |

x(t - q)dt × |

ò |

k(t)x(t - t)dt + |

ò |

x(t - q)g(t)d(t) = |

|

||||||||||||||

T |

T |

|

|||||||||||||||||||

|

|

|

|

0 |

|

|

0 |

|

|

|

|

|

|

|

0 |

|

|

|

(9.42) |

||

¥ |

|

|

|

T |

|

|

|

|

T |

|

|

|

|

|

|

¥ |

|||||

|

1 |

|

|

|

1 |

|

|

|

|

|

|

|

|||||||||

ò |

k(t)d(t) |

ò |

x(t - t)x(t - q)dt + |

ò |

x(t - q)g(t)d(t) = |

ò |

k(t)R (q - t)dt + R (q) |

||||||||||||||

|

T |

||||||||||||||||||||

|

T |

|

|

|

|

|

|

|

|

|

x |

gx |

|||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

0 |

|

|

|

|

0 |

|

|

|

|

0 |

|

|

|

|

|

|

0 |

|

|

||

ЕСЛИ сигналы x(t) и g(t) независимы, то Rgx(q) » 0 и равенство (9.42) сводится к виду:

Ryx (q) = ¥ò Rx (q - t)k(t)dt |

(9.53) |

0

Рассмотрим частный случай. Предположим, что сигналом на входе является последовательность независимых импульсов, подчиняющаяся нормальному распределению с нулевым средним и дисперсией R(0). Такая последовательность импульсов называется белым шумом. Ее корреляционная функция представляет собой единичный импульс R(θ) =δ(θ) и обладает следующими свойствами:

1) d(q)= íì¥ при q = 0; |

2) |

¥òd(q)dq =1. |

(9.54) |

î0 при q ¹ 0. |

|

-¥ |

|

В статической динамике показывается, что в этом случае вместо (9.53) можно написать:

Ryx (q) = ¥òd(q - t)k(t)dt = k(q). |

(9.55) |

0

Формула показывает, что если на вход исследуемой системы подать воздействие, которое может рассматриваться как белый шум, то взаимнокорреляционная функция будет эквивалентна весовой функции объекта.

122

В тех случаях, когда сигнал х(t) не является белым шумом, оценки весовой функции могут быть вычислены путем решения интегрального уравнения (9.50). При этом могут применяться аналитические и численные методы. Аналитический метод решения состоит в предварительной аппроксима-

ции корреляционной Rx(θ) и взаимно-корреляционной Rxу(θ) функции известными аналитическими зависимостями. Затем, решая интегральное уравнение (9.50), находят искомую весовую функцию.

Наиболее просто получить решение интегрального уравнения в частотной области.

Вводя спектральные плотности

S xy ( jw)= ¥òRxy (q)exp(- jwq)dq,

-¥ |

(9.56) |

|

S x (w)= ¥òRx (q)exp(- jwq)dq; |

||

|

||

-¥ |

|

и учитывая, что частотная характеристика есть обратное преобразование Фурье от весовой функции

F(jw) = ¥òk(q)exp(- jwq)dq . |

(9.57) |

0 |

|

Получим:

F( jw) = S xy ( jw)/ S x (w) |

(9.58) |

Среди численных методов приближенного решения интегрального уравнения (9.57) наибольшее распространение получил метод, основанный на сведении интегрального уравнения к системе линейных алгебраических уравнений. При использовании этого метода бесконечный верхний предел заменяется конечным числом:

Rxy (q) = Tòk(t)Rx (q - t)dt . |

(9.59) |

0 |

|

Затем интервал интегрирования разбивается на n – 1 интервалов шириной ∆ = T/(n-1) и интеграл (9.59) заменяется конечной суммой:

n-1 |

|

Rxy (q)= åk(iDt )Rx (q - Dt)Dt. |

(9.60) |

i =1

123

Полагая θ = 0θ, ∆θ, 2∆θ,…, (n-1)∆θ получаем n уравнений с n неизвестными. В векторно-матричном обозначении система примет вид:

|

А×k = с |

|

|

(9.61) |

|

|

Rx (0) .......Rx [(n -1)Dq] |

|

|

Ryx (0) |

|

|

|

|

|

||

|

|

|

|||

|

. |

|

|

. |

|

A = |

. |

|

;с = |

. |

. |

|

. |

|

|

. |

|

|

Rx [(n -1)Dq] .......Rx (0) |

|

|

Ryx [(n -1)Dq] |

|

|

|

|

|

|

|

Здесь k - вектор коэффициентов весовой функции

Решение системы представляет значение весовой функции в точках

θ = 0, 2∆θ, …, (n-1)∆θ = T.

Несмотря на формальную простоту, определение весовой функции численными методами сопряжено с некоторыми трудностями. Эти трудности обусловлены тем, что малые ошибки в исходных автокорреляционной и вза- имно-корреляционной функциях приводят к большим погрешностям в определении; весовой функции. Для того чтобы решать задачи идентификации численными методами с приемлемой точностью, были развиты так называемые методы регуляризации, использующие априорную информацию о характере искомого решения.

При определении динамических моделей объектов, так же как и при определении статических моделей, исходные данные могут быть получены в результате как пассивного эксперимента, так и специально организованных воздействий. В процессе пассивного эксперимента переменные x(t) являются естественными возмущениями, контролируемыми на входе объекта или отдельных его участков. В процессе активного эксперимента x(t) носит характер специально организованного управляющего воздействия. Эти воздействия могут иметь характер периодического входного сигнала синусоидальной и прямоугольной формы или псевдослучайного пробного сигнала. Выбирая характер воздействия, необходимо учитывать, в какой области целесообразно изучать поведение динамической системы – частотной или временной. Псевдослучайные сигналы пригодны для изучения объекта во временной области по временным характеристикам, так как позволяют непосредственно определять его весовую функцию. Синусоидальные и прямоугольные колебания пригодны для получения частотной и передаточной функций объекта. Хотя временное и частотное представления взаимосвязаны посредством преобразования Фурье, некоторые виды информации, например временные сдвиги и запаздывания, удобно определять по временным представлениям, тогда как информацию о колебательных свойствах объекта и резонансах удобно получать по представлениям в частотной области.

124

Контрольные вопросы

1.Какие методы идентификации объектов исследования по результатам пассивного эксперимента вы знаете?

2.Как определяются характеристики случайных процессов по данным эксперимента?

3.Поясните методы определения статических и динамических характеристик объекта при пассивном эксперименте.

4.Охарактеризуйте основные положения определения статических моделей по данным пассивного эксперимента.

5.Поясните определение динамических характеристик технологических объектов управления при пассивном эксперименте.

10.НЕЙРОСЕТЕВЫЕ ТЕХНОЛОГИИ В НАУЧНЫХ ИССЛЕДОВАНИЯХ

Воснове нейросетевых технологий лежат технологии искусственного интеллекта, имитирующие природные процессы (муравейник, пчелиный улей

ит.д.), такие как деятельность нейронов мозга, а также генетические процессы естественного отбора в живой природе. Все большее распространение в прикладных задачах находят искусственные нейронные сети (ИНС).

Всфере научных исследований ИНС находят применение в задачах идентификации объектов, в алгоритмах прогнозирования и диагностики, а также для синтеза оптимальных систем управления.

Вопределенном смысле ИНС является имитатором мозга, обладающего способностью к обучению и ориентации в условиях неопределенности. Она сходна с мозгом в двух аспектах. Сеть приобретает знания в процессе обучения и сохраняет знания в виде своего состояния (значений коэффициентов межнейронных связей, называемых синаптическими весами и т.д.).

Вконкретном случае процедура обучения ИНС может состоять в определении (идентификации) синаптических весов, обеспечивающих ей необходимые преобразующие свойства. Особенностью ИНС является её способность к модификации параметров и структуры в процессе обучения.

10.1. Общие сведения о нейронных сетях

Функционирование нейронной сети состоит из двух этапов обучения сети «правильному» или адекватному реагированию на входную информацию (входной вектор) и использования обученной сети для распознавания входных векторов. Последний этап часто называют тестированием. Другими словами, сеть учится распознаванию входных векторов, т.е. формированию выходных векторов, соответствующих распознанному классу входных векторов. При этом знания о соответствии входных векторов выходным сохраняются в весах синапсов.

Функционирование нейронной сети часто описывают в терминах задач оптимизации. Ее обучение можно представить как формирование n-мерной

125

гиперповерхности (где n - размерность входного вектора) определенной целевой функции, обычно называемой энергией сети. Описание этой гиперповерхности хранится в карте весов синапсов и в порогах нейронов. Например, в случае модели Хопфилда энергетическая функция описывается формулой

1 N N

E = - 2 å åwij xi x j ,

i =1 j =1

где N - количество нейронов (размерность входного вектора), wij - вес связи

между i-м и j-м нейронами, xi- - состояние i-го нейрона.

При тестировании (использовании) обученной нейронной сети происходит процесс поиска ближайшего минимума целевой функции. При этом происходит восстановление искаженных разрядов входного вектора или «вспоминание» неизвестных разрядов, ассоциативно связанных с заданными (известными) разрядами.

Существует большое разнообразие моделей нейронных сетей. Их различают по структуре сети (связей между нейронами), особенностям модели нейрона, особенностям обучения сети.

По структуре нейронные сети можно разделить на неполно-связные (или слоистые) и полносвязные, со случайными и регулярными связями, с симметричными и несимметричными связями.

Неполносвязные нейронные сети описываются неполносвязным ориентированным графом. Наиболее распространенным типом таких нейронных сетей являются перцептроны: однослойные (простейшие перцептроны) и многослойные, с прямыми, перекрестными и обратными связями. В нейронных сетях с прямыми связями нейроны j-го слоя по входам могут соединяться только с нейронами i-x слоев, где j > i, т.е. с нейронами нижележащих слоев. В нейронных сетях с перекрестными связями допускаются связи внутри одного слоя, т.е. выше приведенное неравенство заменяется на j ³ i. В нейронных сетях с обратными связями используются и связи j -го слоя по входам с i-м при j < i. Кроме того, по виду связей различают перцептроны с регулярными и случайными связями.

По используемым на входах и выходах сигналам нейронные сети можно разделить на аналоговые и бинарные.

По моделированию времени нейронные сети подразделяются на сети с непрерывным и дискретным временем. Для программной реализации применяется, как правило, дискретное время.

По способу подачи информации на входы нейронной сети различают:

·подачу сигналов на синапсы входных нейронов,

·подачу сигналов на выходы входных нейронов,

·подачу сигналов в виде весов синапсов входных нейронов,

·аддитивную подачу на синапсы входных нейронов.

·По способу съема информации с выходов нейронной сети разделяют:

·съем с выходов выходных нейронов,

·съем с синапсов выходных нейронов,

126

·съем в виде значений весов синапсов выходных нейронов,

·аддитивный съем с синапсов выходных нейронов.

По организации обучения разделяют обучение нейронных сетей с учи-

телем (supervised neural networks) и без учителя (nonsupervised). При обуче-

нии с учителем предполагается, что имеется внешняя среда, которая предоставляет обучающие примеры (значения входов и соответствующие им значения выходов) на этапе обучения или оценивает правильность функционирования нейронной сети и в соответствии со своими критериями меняет состояние нейронной сети, поощряет или наказывает нейронную сеть, запуская тем самым механизм изменения ее состояния. Под состоянием нейронной сети, которое может изменяться, обычно понимаются:

· веса синапсов нейронов (карта весов - map) (коннекционистский под-

ход);

·веса синапсов и пороги нейронов (обычно в этом случае порог является более легко изменяемым параметром, чем веса синапсов);

·установление новых связей между нейронами (свойство биологических нейронов устанавливать новые связи и ликвидировать старые называется пластичностью).

По способу обучения разделяют обучение по входам и выходам. При обучении по входам обучающий пример представляет собой только вектор входных сигналов, а при обучении по выходам в него входит и вектор выходных сигналов, соответствующий входному вектору.

По способу предъявления примеров различают предъявление одиночных примеров и «страницы» примеров. В первом случае изменение состояния нейронной сети (обучение) происходит после предъявления каждого примера. Во втором - после предъявления «страницы» (множества) примеров на основе анализа сразу их всех.

Если рассматривать нейронную сеть как способ представления знаний, то в ней хранятся знания об ассоциативных связях между стимулами (входными векторами) и откликами (выходными векторами).

Знания хранятся (формируются в процессе обучения) обычно в форме весов связей между нейронами.

Недостатками нейронных сетей в качестве метода представления знаний являются:

·трудности вербализации результатов работы нейронной сети и объяснений, почему она приняла то или иное решение,

·невозможность гарантировать повторяемость и однозначность получения результатов

Преимущества нейронных сетей в качестве метода представления зна-

ний:

·отсутствие необходимости формализации знаний, формализация заменяется обучением на примерах;

·естественное представление и обработка нечетких знаний примерно так, как это осуществляется в естественной интеллектуальной системе - моз-

127

ге;

·ориентация на параллельную обработку, что при соответствующей аппаратной поддержке обеспечивает возможность работы в реальном времени;

·отказоустойчивость и живучесть при аппаратной реализации нейронной сети;

·возможность обработки многомерных (размерности больше трех) данных и знаний, так же (без увеличения трудоемкости) как и небольшой размерности (но в этом случае затруднено объяснение результатов, так как человек с трудом воспринимает многомерность).

10.2. Принцип работы непрерывной модели нейрона.

Элементарным функциональным звеном, из множества которых состоит ИНС, является нейрон. В смысле реализуемых им преобразований он является моделью нейрона живого мозга.

Различают непрерывные и импульсные модели искусственных нейронов. В прикладных задачах управления находят применение модели непрерывных нейронов.

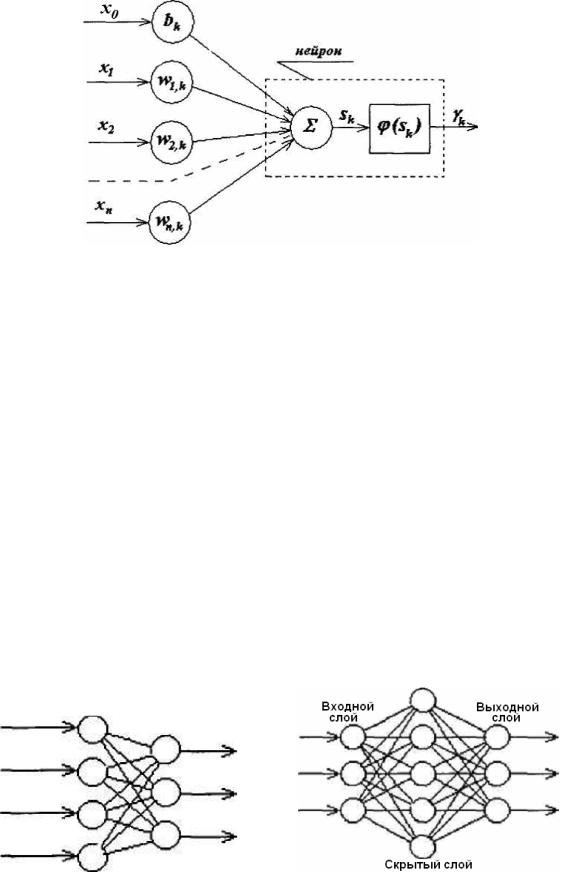

Непрерывная модель нейрона работает следующим образом. Входные сигналы, каждый со своим коэффициентом (синаптическим весом) поступают на вход линейного сумматора. Выходной сигнал сумматора поступает на вход активационного нелинейного блока. Обычно активационные блоки ограничивают выходной сигнал нейрона в заданном диапазоне, например

[0;1]или [-1;1].

Математической формализацией искусственного нейрона являются уравнение сумматора

n |

|

|

sk = åw j,k × x j |

+ bk |

(10.1) |

j=1 |

|

|

и уравнение активационного блока |

|

|

gk = j(sk ) , |

|

(10.2) |

где - для k-то нейрона, х1, х2, ..., хn - входные сигналы; w1,k, w2,k,... wn,k – синаптические веса; bk - уровень опорного сигнала; sk- сигнал на выходе линейного сумматора; j(sk ) - функция преобразования активационного блока; gk -

выходной сигнал.

На рис. 10.1 представлена функциональная схема модели искусственного нейрона.

128

Рис. 10.1. Функциональная схема модели искусственного нейрона

Множество связанных по входам и выходам нейронов составляет ИНС. Для описания ИНС используют символьные выражения вида:

NN g-h1-h2-h3-hn-q, |

(10.3) |

где g - число нейронов трансляторов в первом слое ИНС; h1-h2-h3-hn - число нейронов n внутренних последующих слоях ИНС; q - число нейронов на выходе ИНС.

Первый слой предназначен для ретрансляции (распределения) информации входных сигналов между нейронами. Каждый нейрон получает информацию с определенным синаптическим весом. Для непрерывных нейронов синаптические веса могут быть положительными или отрицательными.

Преобразование сигналов в ИНС начинается со второго слоя нейронов. Поэтому размерность сети исчисляется от второго слоя. На рис. 10.2 представлены структурные схемы однослойной и двухслойной ИНС, где нейроны представлены одним кружочком, содержащим сумматор и активационный блок, и связаны между собой информационными каналами. Каждой стрелке соответствует свой синаптический вес. Многослойные ИНС содержат внутренние скрытые слои.

а) б)

Рис. 10.2. Виды ИНС с прямыми связями: а) однослойная ИНС; б) многослойная ИНС

129

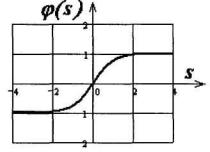

Формально не существует ограничений на типы активационных функций. Они могут быть одинаковыми для всех слоев и нейронов или различными. В задачах управления используют сигмоидальные функции (рис. 10.3).

Рис. 10.3. Сигмоидальная функция активационного блока

Аналитическим выражением для сигмоидальной функции является гиперболический тангенс

j(s) = |

es - e |

-s |

. |

(10.4) |

|

es + e |

-s |

||||

|

|

|

Таким образом, ИНС предназначена для преобразования вектора входных переменных Х{х1, х2, ..., хn} в вектор выходных переменных G{g1, g2, ..., gk}. Преобразование осуществляется в соответствии с матрицами синаптических весов W{w1,k, w2,k,... wn,k} и функциями активационных блоков j(sk ) .

Подробности и характер преобразования зависят от числа скрытых промежуточных слоев и числа нейронов в них. Из-за нелинейных свойств активационных блоков в сети создаются условия, в которых один или несколько нейронов могут отключаться, обеспечивая изменения в топологии ИНС. Это существенно расширяет спектр преобразующих свойств сети.

10.3. Обучение искусственных нейронных сетей.

Для получения требуемых преобразовательных характеристик нейронная сеть должна быть настроена. Процедура настройки заключается в подборе значений синаптических весов для заданной топологии сети. Такая настройка называется процедурой обучения или тренировкой ИНС.

Различают два метода обучения: с учителем и стимулируемое самообучение (рис. 10.4).

130