- •2.1.2. Определение количества информации

- •2.2. Основы теории измерений

- •2.3. Основы теории надежности

- •2.3.1. Определение количественных характеристикнадежности элементов

- •Дисперсия времени отказа

- •2.3.2. Определение надежности системы

- •2.4. Системы массового обслуживания

- •2.4.1. Основные понятия, используемые в системахмассового обслуживания

- •2.4.2. Расчет системы массового обслуживания

- •2.5. Основы теории кодирования и передачи

- •2.5.1. Формирование экономичного кода алфавита

- •2.5.2. Определение характеристик канала

- •К р

- •106 107

При этом

|

|

(2.2) |

|

|

(2.3) |

Из (2.2) и (2.3) следует,

что неопределенность отсутствует в

том и только том случае, когда одно из

![]() равно 1. Максимальная неопределенность

достигается при

равно 1. Максимальная неопределенность

достигается при![]() ,

т.е. когда существует равномерное

распределение случайных событий,

отражающих состояние случайного объекта

или явления. В то же время для равносильного,

например равновероятного, распределения

неопределенность возрастает с возрастаниемn.

Последнее свидетельствует о том, что

энтропия (2.1) является как мерой

неопределенности,

так и мерой

разнообразия.

Это означает, что чем сложнее, чем

разнообразнее объект или явление, тем

большей неопределенностью он обладает

или, другими словами, тем менее

прогнозируемыми

становятся объекты или явления.

,

т.е. когда существует равномерное

распределение случайных событий,

отражающих состояние случайного объекта

или явления. В то же время для равносильного,

например равновероятного, распределения

неопределенность возрастает с возрастаниемn.

Последнее свидетельствует о том, что

энтропия (2.1) является как мерой

неопределенности,

так и мерой

разнообразия.

Это означает, что чем сложнее, чем

разнообразнее объект или явление, тем

большей неопределенностью он обладает

или, другими словами, тем менее

прогнозируемыми

становятся объекты или явления.

В случае, когда представляется как континуум, например, для случайной величины Х, принимающей бесконечное несчетное множество значений, где x X, энтропия вычисляется по формуле

|

|

(2.4) |

|

при

|

|

Основание логарифма в формулах (2.1) и (2.4) не оказывает качественного влияния на оценку энтропии, а лишь определяет ее размерность. Для непрерывных случайных величин, непрерывных случайных процессов при теоретическом анализе, включающем интегрирование или дифференцирование математических выражений, наиболее удобно использовать натуральные логарифмы, при этом энтропия определяется в натуральных единицах нитах (или хартли). При анализе цифровых машин и других устройств, работающих в двоичном коде, как правило, используются двоичные логарифмы и соответственно двоичные единицы биты. При анализе измерительных устройств, работающих в десятичном коде, удобнее применять десятичные логарифмы и десятичные единицы диты. Между этими единицами существуют определенные соотношения: 1 дит = 2,3 нит = 3,3 бит, 1 нит = 1,45 бит = 0,43 дит, 1 бит = 0,69 нит = 0,3 дит. Указанное в полной мере относится к единице измерения количества информации. Например, для такого объекта (явления), как монета (подбрасывание монеты), характерны два равновероятных случайных состояния (события): выпадение решки или орла. Энтропия этого явления

![]()

![]()

Для бутерброда

также возможны два состояния: хлеб и

масло. На основании известного в народе

«закона» о том, что бутерброд всегда

падает маслом вниз,

![]()

При n = 2 неопределенность (непредсказуемость) исхода в подбрасывании максимальна в случае с монетой; для бутерброда неопределенность отсутствует.

При увеличении n, например n = 6 для игрального кубика, с учетом равновероятного распределения возможных состояний

![]() бит.

бит.

Для двух и более случайных объектов или явлений энтропия определяется аналогично вероятности, т.е. с увеличением n энтропия возрастает.

Если и независимые случайные объекты или явления, то

|

|

(2.5) |

т.е. энтропия двух или нескольких независимых объектов или явлений равна сумме энтропий этих объектов или явлений. Это свойство аддитивности энтропии.

Если и – зависимые случайные объекты или явления, то

|

|

(2.6) |

где H( /) или H(/) определяются как математическое ожидание энтропии условного распределения.

Для всех случайных

объектов или явлений имеет место

неравенство

![]() ,

это согласуется с интуитивным

представлением о том, что знание состояния

может только

уменьшить неопределенность ,

а если они независимы, т.е.

,

это согласуется с интуитивным

представлением о том, что знание состояния

может только

уменьшить неопределенность ,

а если они независимы, т.е.

![]() ,

то оставить ее неизменной.

,

то оставить ее неизменной.

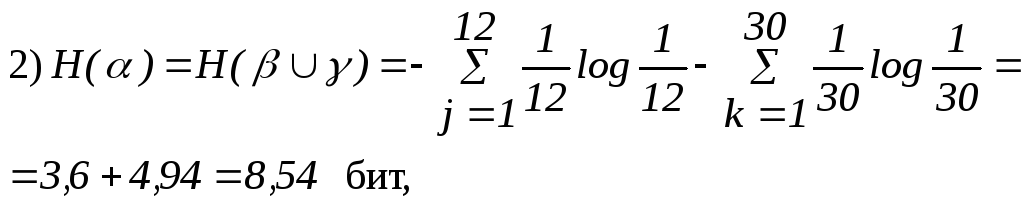

Пример 2.1. Неопределенность даты проведения ежегодного мероприятия можно определить двумя путями:

![]()

где 365 – число дней в году;

где 12 – число месяцев в году; 30 – число дней в месяце.

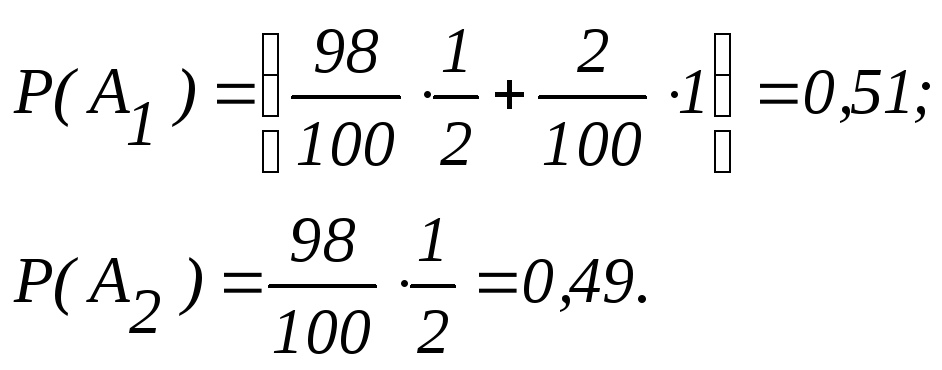

Пример 2.2. Специалист, занимающийся проблемой В, для информационного обеспечения своей интеллектуальной деятельности воспользовался автоматизированной информационно-поисковой системой (АИПС). В базе АИПС содержится 2 % статей, непосредственно относящихся к данной проблеме. Система поиска в АИПС точно обнаруживает эти статьи по запросу. В то же время ввиду некоторой близости тематики других статей к проблеме В эта система с равной вероятностью может представить или не представить специалисту статьи, не относящиеся непосредственно к проблеме В. Определить эффект системы поиска, используя меру снятия неопределенности по отношению к проблеме В.

Решение. Формализуем представленную ситуацию. Определение отношения той или иной статьи к проблеме В представим как опыт , имеющий два возможных исхода:

В1 «не относится»;

В2 «относится».

Определение эффективности системы поиска представим как опыт , также имеющий два возможных исхода:

А1 «определен признак В»;

А2 «не определен признак В».

Вероятности определения и неопределения признака В соответственно равны:

Неопределенность отношения той или иной статьи к проблеме В

![]() бит.

бит.

Это есть

неопределенность базы АИПС по отношению

к проблеме В.

В целом, с учетом эффективности работы

системы поиска, т.е. опыта ,

неопределенность АИПС можно вычислить

через условную энтропию

![]() .

Для этого определим:

.

Для этого определим:

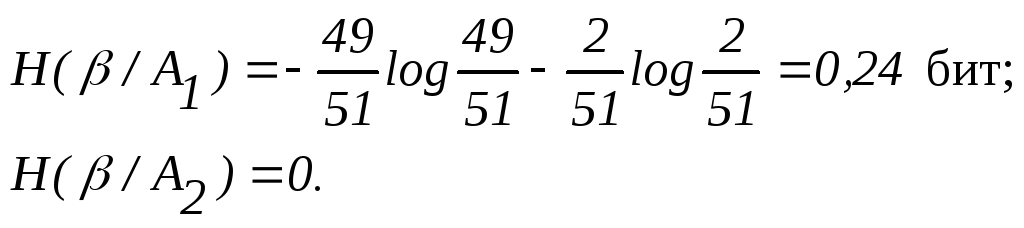

условные вероятности исходов В1 и В2опыта при условии исходов А1 и А2 опыта :

![]() ,

,

т.к. из 51 случая, когда система поиска давала положительный ответ, 49 статей не относились к проблеме В, а 2 статьи относилась,

![]()

что вполне очевидно;

условные энтропии АИПС (при условиях А1 и А2):

Тогда средняя условная энтропия опыта (неопределенность АИПС) при условии существования системы поиска (опыт ) будет равна математическому ожиданию энтропии условного распределения:

![]()

Если сравнить значение H(/) с ранее полученным значением неопределенности базы АИПС Н(), то можно констатировать, что система поиска в данном случае недостаточно эффективна, поскольку снимает неопределенность АИПС всего на 14 %.

Задания для самостоятельной работы

1. Определите энтропию русского алфавита в случае равновероятного распределения букв. Возьмите текст любой книги (1–2 страницы). Определите вероятности появления букв в том тексте и вычислите энтропию. Сравните ее с предыдущей и объясните причину появления разницы.

2. Проведите в вашей группе следующий эксперимент. Выберите два различных предмета (например, кусок мела и стул). Каждый студент должен написать прилагательные, которые могут охарактеризовать сначала первый, а затем второй предмет. Для выполнения этой процедуры выделите одинаковое время на описание каждого предмета (например, 2 мин). Затем выпишите на доске все прилагательные, которые встречаются в записках по каждому предмету. Вычислите частоту (апостериорную вероятность) появления каждого прилагательного. На основании статистических данных определите энтропии двух предметов по формуле (2.1). Используя энтропию как меру неопределенности и меру разнообразия, дайте информационную характеристику рассматриваемых предметов.

Отбросьте прилагательные, которые упоминаются только один раз. Определите энтропии предметов на основании вновь образованных множеств прилагательных и их вероятностей. Сделайте выводы.

Используя полученные распределения вероятностей, определите 3 – 4 наиболее характерные особенности (прилагательных) рассматриваемых предметов. Предложите группе, не знакомой с данным экспериментом, на основании этих 3 4 прилагательных определить, о каком предмете идет речь. Пусть попробуют сделать то же самое на основании 3 4 прилагательных, находящихся в противоположном конце распределения вероятностей. Найдите вероятность распознавания предмета в том и другом случае.

3. Из 100 обследованных пациентов 5 имели болезнь А. Система диагностики заболевания обнаружила признаки болезни А у 25 пациентов. Какова эффективность системы диагностики?

2.1.2. Определение количества информации

Пусть случайный объект или явление имеет неопределенность Н(). Любой целенаправленный опыт , имеющий определенное количество исходов (сообщений, результатов, измерений), уменьшает степень неопределенности . Разность

|

|

(2.7) |

где Н() – априорная, а Н( /) – апостериорная энтропии (неопределенности) объекта или явления есть количество информации (или числовое значение количества информации в битах) об объекте или явлении , полученной в результате опыта . В этом случае I(,) представляется как мера снятия неопределенности, а процесс получения информации об объекте или явлении – как процесс снятия неопределенности.

Если результат (исходы) опыта полностью определяет все сведения, которыми обладает , то Н( /) становится равным 0, а

|

|

(2.8) |

В этом случае можно считать, что получена полная информация об объекте или явлении , отражающая все его свойства и являющаяся мерой разнообразия объектов или явлений. Так раскрывается атрибутивная концепция информации, которая определяет информацию как объективный атрибут материи.

Если Н( /) = Н(), то следует, что в результате опыта (а фактически любой информационной деятельности) не получено никакой информации об объекте или явлении , т.е. I(,) = 0.

Из приведенных утверждений следуют важные практические выводы, определяющие эффективность информационной деятельности:

информационная деятельность считается эффективной, если она приводит к снятию неопределенности (2.7);

эффективность информационной деятельности может быть оценена количественно; предел, к которому стремится эта оценка, определяется выражением (2.8).

Значение I(, ) определяется выражением (2.7) как количество информации относительно объекта или явления , содержащейся в опыте , а выражением (2.8) как количество информации о , полученной объектом . Последнее свидетельствуют о том, что I(,) есть мера сравнения двух объектов.

В результате сравнения объекта с объектами и получим следующие количества информации:

|

|

(2.9) |

и

|

|

(2.10) |

Очевидно, при

![]() будет справедливо неравенство

будет справедливо неравенство![]() ,

а следовательно,

,

а следовательно,![]() .

Это означает, что различные субъекты

(

или ),

обладающие различной энтропией или

информацией, при исследовании одного

и того же объекта ()

могут получить различное количество

информации. Разность

.

Это означает, что различные субъекты

(

или ),

обладающие различной энтропией или

информацией, при исследовании одного

и того же объекта ()

могут получить различное количество

информации. Разность

|

|

(2.11) |

можно рассматривать как меру сравнения информированности объектов (или субъектов) и об объекте или явлении . Это обстоятельство является важной предпосылкой семантической теории информации.

Пример 2.3. В качестве объекта возьмем русскую письменную речь. В русском алфавите 32 буквы (без различия е и ё). C первого взгляда для нас как субъектов наблюдения неопределенность русской письменной речи .

Решение. Неопределенность в случае равномерного распределения букв алфавита:

![]() бит.

бит.

Проведем опыт

![]() в целях определения истинного (а не

равновероятного) распределения

вероятностей появления отдельных букв

в русской речи. В результате опыта

в целях определения истинного (а не

равновероятного) распределения

вероятностей появления отдельных букв

в русской речи. В результате опыта![]() получим данные, приведенные в табл.1.1.

На основании этих данных (этой информации)

получим

получим данные, приведенные в табл.1.1.

На основании этих данных (этой информации)

получим

![]()

Тогда

![]() бит.

бит.

Такое количество

информации содержится в таблице или

получено в результате опыта

![]() .

Далее проведем опыт

.

Далее проведем опыт![]() ,

определяющий возможные связи между

парами отдельных букв русского алфавита

в письменной речи. В результате получим

,

определяющий возможные связи между

парами отдельных букв русского алфавита

в письменной речи. В результате получим

Тогда

![]()

Такое количество

информации получено в результате опыта

![]() ,

проведенного после опыта

,

проведенного после опыта![]() .

.

Задания для самостоятельной работы

1. Определите, какое количество информации можно получить:

от системы поиска АИПС (для примера 2.2);

системы диагностики заболевания (задание 3 на стр. 68).

2. В учебном корпусе

150 аудиторий:

![]() .

Студент, получив дополнительную

информацию, пришел к выводу, что его

группа с вероятностью 0,8 находится в

аудитории

.

Студент, получив дополнительную

информацию, пришел к выводу, что его

группа с вероятностью 0,8 находится в

аудитории![]() .

Определите количество дополнительной

информации.

.

Определите количество дополнительной

информации.

3. Спланируйте опыт

,

который позволил бы определить

информированность субъектов

![]() и

и![]() об объекте.

об объекте.