- •Формирование и передача сигналов

- •Сигналы и их классификация

- •Виды сигналов:

- •Основные этапы формирования сигнала в цифровой системе связи

- •1. Кодирование источника (форматирование)

- •Сжатие данных (этап кодирования источника):

- •2. Кодирование канала:

- •3. Цифровая модуляция (манипуляция)

- •Математические модели детерминированного сигнала

- •Математическое описание гармонического сигнала

- •Амплитудно-фазовая, квадратурная, комплексная

- •Геометрическая

- •Спектр периодического сигнала

- •Спектр периодической последовательности прямоугольных импульсов (сигнал типа «меандр»)

- •Спектр непериодического сигнала конечной длительности

- •Преобразование Фурье:

- •Спектральные функции видеоимпульсов

- •Динамические характеристики линейного элемента

- •Определение реакции элемента на входной сигнал

- •Передаточная (системная) функция элемента

- •H(s) - передаточная функция элемента,

- •Следствия преобразования Фурье

- •Понятие идеального канала

- •Спектр дискретного сигнала

- •«Естественная» дискретизация (отсчет - прямоугольный импульс)

- •Теорема Котельникова

- •Синусоида как сумма функций Котельникова при двух отсчетах на периоде:

- •Канал Найквиста

- •Характеристики канала Найквиста

- •Требования к частотной характеристике цифрового канала связи

- •Автокорреляционная функция

- •Примеры плотностей распределения вероятностей

- •Понятие белого шума

- •Примеры осциллограмм сигналов и их автокорреляционных функций

- •Импульсная модуляция

- •Импульсно-кодовая модуляция (икм)

- •Примеры кодов канала

- •Коды 4, 5, 6 с возвратом к нулю (rz).

- •Аналоговая амплитудная модуляция

- •Пример реализации квадратурного фильтра

- •Характеристики квадратурного фильтра

- •Угловая модуляция

- •Примеры сигналов с угловой модуляцией

- •Примеры частотных детекторов

- •Квадратурный детектор сигналов с угловой модуляцией

- •Примеры противоположных и ортогональных сигналов

- •Понятие согласованного фильтра

- •Фильтр, согласованный с прямоугольным импульсом

- •Относительное (дифференциальное) кодирование

- •Некогерентная демодуляция в системе с двоичной частотной манипуляцией

- •Частотная манипуляция с минимальным частотным сдвигом

- •Модулятор системы с минимальным частотным сдвигом

- •Когерентная демодуляция сигналов с мчс

- •Оценка частотной полосы сигнала в системах bpsk, qpsk, msk, fsk по ширине первого лепестка спектра

- •Модуляция с минимальным частотным сдвигом и гауссовой фильтрацией (gmsk)

- •Модуляция ofdm (Orthogonal frequency division multiplex –

- •Основные показатели эффективности цифровой системы связи

- •Вероятность битовой ошибки рb

- •Максимальная пропускная способность канала

- •Расширение спектра прямой последовательностью

- •Пример вычисления корреляционных функций псп

- •Методы формирования псп

- •Примеры корреляционных функций m-последовательностей

- •Оценка корректирующей способности кода

- •Перемешивание символов

- •Пример блочного перемешивания

- •Принцип построения кодов Хемминга (с исправлением одиночной ошибки)

- •Порождающая и проверочная матрицы

- •Представление двоичного слова многочленом

- •Порождающая матрица циклического кода:

- •Принципы многоканальной связи

- •Принцип временного уплотнения

- •Временное разделение каналов в проводной системе связи

- •Принципы построения систем связи с подвижными объектами

- •Структура системы

- •Разделение каналов в системе сотовой связи gsm

- •Логические каналы сотовой системы связи gsm

- •Основные типы окон системы сотовой связи gsm

- •Понятие количества информации

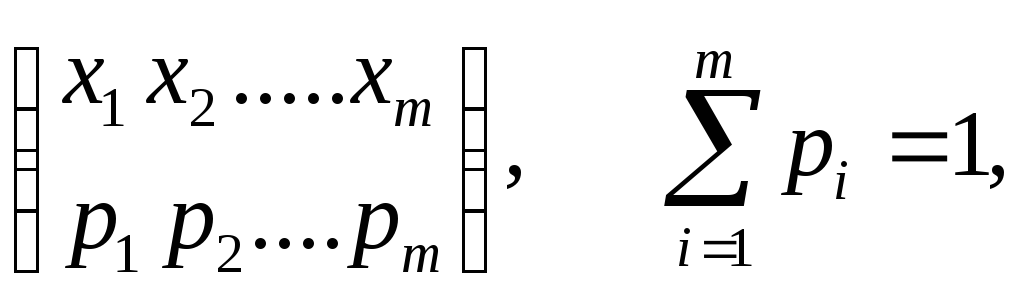

- •X1, x2,…, xm – набор знаков (алфавит х объема m),

- •Эффективное кодирование

- •Кодируем блоки из трех знаков

- •Форматирование аналогового сигнала в цифровой системе

- •Компандирование

- •Кодирование звуковых сигналов

- •Кодирование параметров источника сигнала

- •Кодирование спектра сигнала

- •Характеристики каналов связи

- •Основные типы моделей канала

- •Основные проявления замираний

- •Временное рассеяние

- •Временное рассеяние делает ачх неравномерной:

- •Характеристики замираний

- •Средства борьбы с замираниями

- •Выравнивание характеристики многолучевого канала

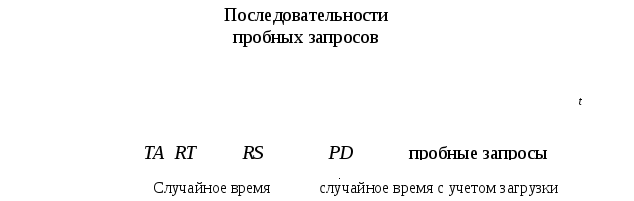

- •Идентификация характеристик канала

- •Эквалайзер с обратной характеристикой канала

- •Принцип работы эквалайзера Витерби

- •Оптимальная фильтрация случайного сигнала

- •Определение частотной характеристики оптимального фильтра

- •Определение импульсной характеристики оптимального фильтра

- •Выделение полезного сигнала с использованием модели источника сигнала

- •Аналоговые фильтры

- •Математическое описание дискретного сигнала

- •Математическое описание дискретного фильтра

- •Структуры линейных цифровых фильтров

- •Формирование сигналов по стандарту iеее-802.11

- •Историческая справка

- •Перечень слайдов

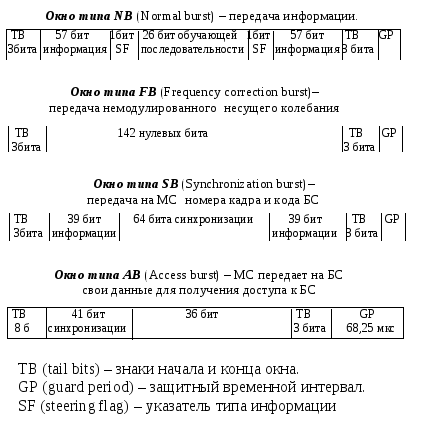

Основные типы окон системы сотовой связи gsm

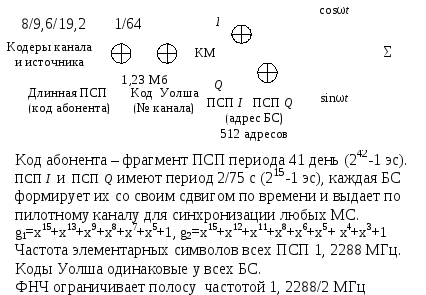

Кодовое разделение каналов системы связи стандарта IS-95

Прямой канал (БС– МС)

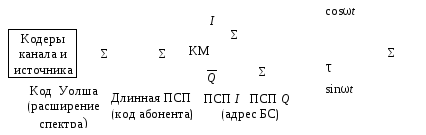

Обратный канал (МС– БС)

Сигналы обратного канала трафика системы связи стандарта IS-95

Управление доступом к каналу связи

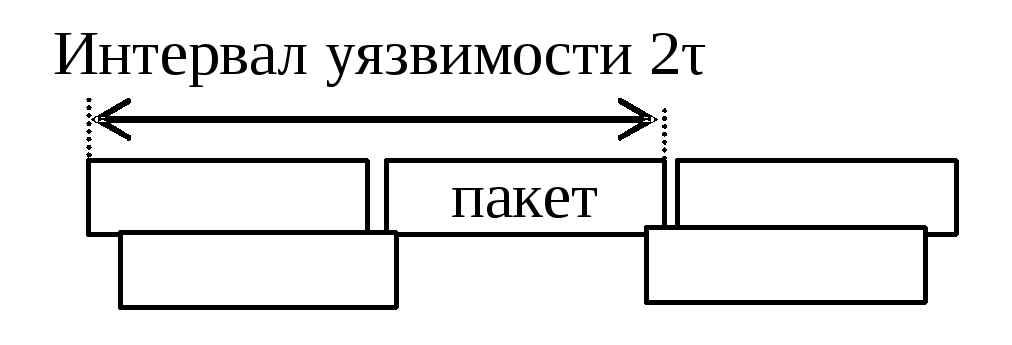

В системах с предоставлением канала по требованию возникает конфликтная ситуация при одновременном обращении нескольких абонентов к каналу связи. Сигналы, поступающие от разных источников, искажаются вследствие взаимного наложения.

Оценка эффективности системы АЛОХА (доступ не контролируется)

Предполагается, что сообщения передаются пакетами

Вероятность появления k пакетов за интервал времени τ

![]()

λ– средняя частота поступления пакетов.

Пакет будет успешно передан, если на периоде уязвимости 2 τ не будет других обращений к каналу. Вероятность успешной передачи,

![]() где

где

G = λτ – среднее число пакетов, поступающих за интервал времени τ,

S

– среднее число успешных передач за τ.

![]()

maxS

= 1/(2e)

≈ 0,187 при

![]() т.е. приG

= 0,5.

т.е. приG

= 0,5.

Пропускная способность систем с управляемым доступом

Управление доступом в системе IS-95

Передачу начинают: в синхронной системае сразу после синхросигнала, в синхронной с контролем несущей–при свободном эфире, в ненастойчивой – через случайное время.

Двоичное кодирование как наиболее экономное

Сообщение – это последовательность длиной в N символов, выбираемых из алфавита в m символов.

Количество разных сообщений Q = mN (lnQ = N lnm).

Аппаратурные и временные затраты «А» пропорциональны объему алфавита m и числу символов в последовательности:

A = mN = m lnQ/lnm.

Минимум затрат, при Q = const, достигается при условии

![]()

т.е. при m = e.

Ближайшие целые значения m = 2 и m = 3.

Разные способы двоичного кодирования требуют разного количества бит для представления сообщения. Например:

двоично-десятичный код: 99 = 10011001 (8 бит),

двоичный код: 99 = 26 + 25 + 21 + 20 = 1100011 (7 бит)

Понятие количества информации

Характеристика источника информации

X1, x2,…, xm – набор знаков (алфавит х объема m),

pi – вероятности появления знаков (i =1,..., m).

Количество информации, приходящейся в среднем на один знак алфавита источника:

![]() .

.

Единицей информации считается «бит» – энтропия источника с двумя равновероятными знаками x1, x2 :

![]() (бит).

(бит).

При равных вероятностях знаков энтропия источника максимальна

![]()

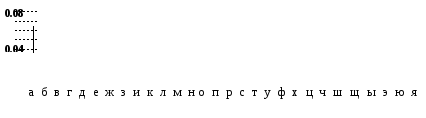

Если 32 буквы русского алфавита считать равновероятными, Н = log232= 5.

Если учесть частоту появления букв в тексте, Н » 4,42.

Если учесть корреляцию соседних букв, Н » 3,53.

Если учесть дальние связи букв между словами, Н » 1,5.

Производительность источника, выдающего знаки со скоростью Vи= 1/τи (τи – длительность одного знака) – это количество информации, выдаваемое в единицу времени:

![]()