- •От автора

- •Раздел 1. Проблема измерения в психологии

- •1. 1. Понятие об измерении

- •1. 2. Особенности измерения в психологии

- •1. 3. Шкалы измерений

- •Раздел 2. Основные статистические понятия

- •2. 1. Генеральная и выборочная совокупности

- •2. 2. Переменная величина

- •2. 3. Уровни значимости

- •2. 4. Достоверность результатов исследования

- •Раздел 3. Подготовка данных к математической обработке

- •3. 1. Протоколирование данных

- •3. 2. Составление сводных таблиц (табулирование данных)

- •3. 3. Определение квантилей

- •3. 4. Графическое представление результатов

- •Раздел4. Меры центральной тенденции

- •4. 1. Мода

- •4. 2. Медиана

- •4. 3. Среднее арифметическое значение

- •4. 4. Среднее геометрическое значение

- •Задачи по теме Задача 4.1

- •Задача 4.2

- •Задача 4. 3

- •Раздел 5. Меры изменчивости (разнообразия, вариативности) исследуемого признака

- •5. 1. Лимиты (пределы) разнообразия

- •5. 2. Размах вариаций

- •5. 3. Среднее отклонение

- •5. 4. Дисперсия

- •5. 5. Среднеквадратичное (стандартное) отклонение

- •5. 6. Коэффициент вариации

- •Задачи по теме Задача 5. 1

- •Задача 5.2

- •Раздел 6. Распределения переменных величин

- •6.1. Нормальное распределение

- •6. 1. 1. Основные понятия

- •6. 1. 2. Коэффициент асимметрии

- •6. 1. 3. Коэффициент эксцесса

- •6. 1. 4. Критерий хи-квадрат (c2)

- •6. 1. 5. Критерий Колмогорова – Смирнова (l)

- •6. 2. Равномерное распределение

- •6. 3. Биномиальное распределение

- •6. 4. Распределение Пуассона

- •Задачи по теме Задача 6. 1

- •Задача 6. 2

- •Задача 6. 3

- •Задача 6. 4

- •Раздел 7. Меры различий

- •7. 1. Постановка проблемы

- •7. 2. Непараметрический критерий qРозенбаума

- •7. 4. Критерий Стьюдента

- •7.5. Критерий Фишера

- •7. 6. Критерий j*-угловое преобразование Фишера

- •7.7. Использование критерия χ2 Пирсона и критерия λ Колмогорова для оценки различий между двумя выборками

- •Задачи по теме Задача 7. 1

- •Задача 7. 2

- •Задача 7.3

- •Задача 7.4

- •Задача 7.5

- •Задача 7.7

- •Раздел 8. Меры связи

- •8. 1. Постановка проблемы

- •8. 2. Представление данных

- •8. 3. Коэффициент корреляции Фехнера

- •8. 4. Коэффициент корреляции Пирсона

- •8. 5. Коэффициент ранговой корреляции Спирмена

- •8.6. Коэффициент ранговой корреляции Кендалла (тау Кендалла, t)

- •8.7. Дихотомический коэффициент корреляции (j)

- •8. 8. Точечный бисериальный коэффициент корреляции (rpb)

- •8. 9. Рангово-бисериальный коэффициент корреляции (rrb)

- •8. 11. Матрицы корреляций

- •Задачи по теме Задача 8.1

- •Задача 8. 2

- •Задача 8. 3

- •Задача 8. 4

- •Задача 8. 5

- •Задача 8. 6

- •Задача 8. 7

- •Задача 8. 8

- •Задача 8. 9

- •Задача 8. 10

- •Задача 8.16

- •Задача 8.18

- •Раздел 9. Меры зависимости

- •9.1. Основные понятия

- •9.2. Анализ линейной зависимости методом наименьших квадратов

- •9.4. Множественная регрессия

- •Задачи по теме Задача 9. 1

- •Задача 9. 2

- •Раздел 10. Меры влияния

- •10. 1. Сущность проблемы

- •10. 2. Непараметрические меры влияния

- •10.2.1. Критерий знаков

- •10.2.2. Критерий Вилкоксона

- •10.3. Однофакторный дисперсионный анализ

- •10. 4. Двухфакторный дисперсионный анализ

- •Задачи по теме Задача 10. 1

- •Задача 10. 2

- •Раздел 11. Элементы многомерной статистики

- •11.1. Основные понятия

- •11.2. Кластерный анализ

- •11.2.1. Функции расстояния

- •11.2.2. Меры сходства

- •11.2.3. Выбор числа кластеров

- •Динамическое программирование

- •Целочисленное программирование

- •11.2.4. Методы кластеризации

- •11.2.5. Представление данных

- •11.3. Факторный анализ

- •11.3.1. Основные принципы факторного анализа

- •11.3.2. Основные методы, используемые в факторном анализе

- •Метод главных факторов

- •Центроидный метод

- •Метод минимальных остатков

- •Метод максимума правдоподобия

- •Групповой метод

- •11.3.3. Выбор числа факторов и оценка их значений

- •11.3. 4. Представление результатов факторного анализа

- •Ответы на задачи

- •Список рекомендуемой литературы

- •Дополнительная

- •Приложение статистические таблицы

- •Критические значения коэффициента асимметрии (As), используемого для проверки гипотезы о нормальности распределения

- •Критические значения показателя эксцесса (Ex), используемого для проверки нормальности распределения

- •Теоретические частоты 8-классового нормального распределения ("шаг" 1 s)

- •Теоретические частоты 16-классового нормального распределения ("шаг" 0,5 s)

- •Значения z Пирсона и соответствующие им теоретические накопленные частоты

- •Стандартные значения хи-квадрат

- •Уровень значимости различий между экспериментальным и теоретическим распределениями по критерию λ Колмогорова – Смирнова

- •Критические значения критерия q Розенбаума

- •Критические значения критерия u Манна-Уитни для уровня значимости 0,95

- •Стандартные значения критерия Стьюдента

- •Стандартные значения критерия Фишера, используемые для оценки достоверности различий между двумя выборками

- •Величины угла j в радианах для разных процентных долей (угловое преобразование Фишера)

- •Критические значения коэффициентов корреляции Пирсона и Спирмена

- •Критические значения коэффициента t Кендалла

- •Число пар значений, достаточное для статистической значимости коэффицентов корреляции Пирсона и Спирмена

- •Критические значения дихотомического коэффициента корреляции j

- •Границы критической области для критерия знаков

- •Критические значения критерия т Вилкоксона

11.2.1. Функции расстояния

Для решения задачи кластерного анализа необходимо количественно определить понятия сходства и разнородности. Для этого вводится понятие расстояния (отдаленности) между соответствующими точками xi и xj. Если это расстояние достаточно мало, объекты i и j попадают в один кластер, если оно велико – в разные.

Используются следующие наиболее употребимые меры расстояния:

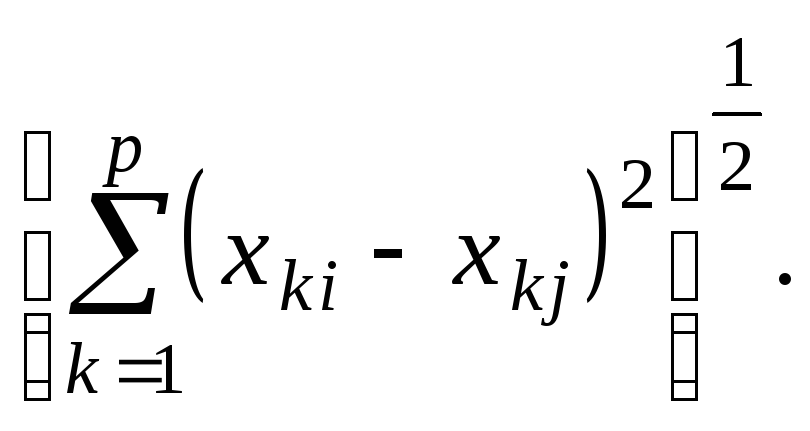

Евклидово расстояние:

d2(Xi,

Xj)

= (11.2)

(11.2)

l1

- норма:

d1(Xi

, Xj)

=![]() (11.3)

(11.3)

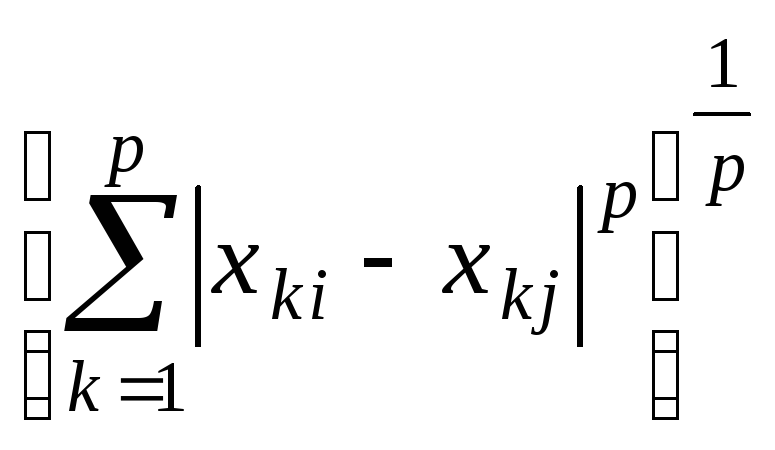

lр

- норма:

dp(Xi,

Xj)

= (11.4)

(11.4)

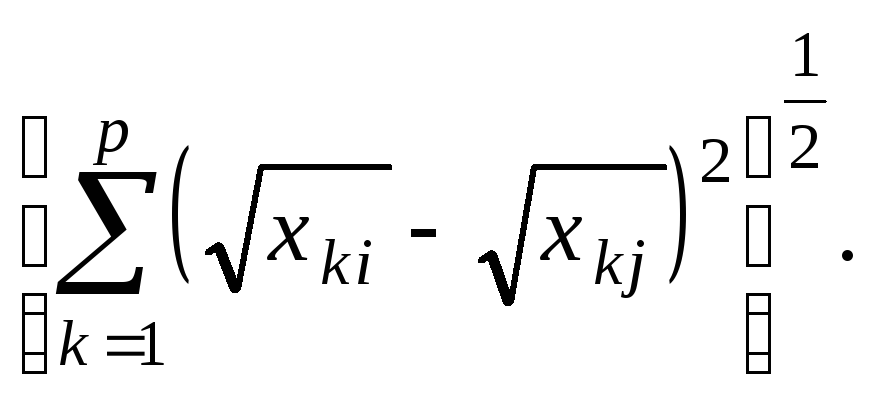

Мера

Джеффриса-Матуситы: M= (11.5)

(11.5)

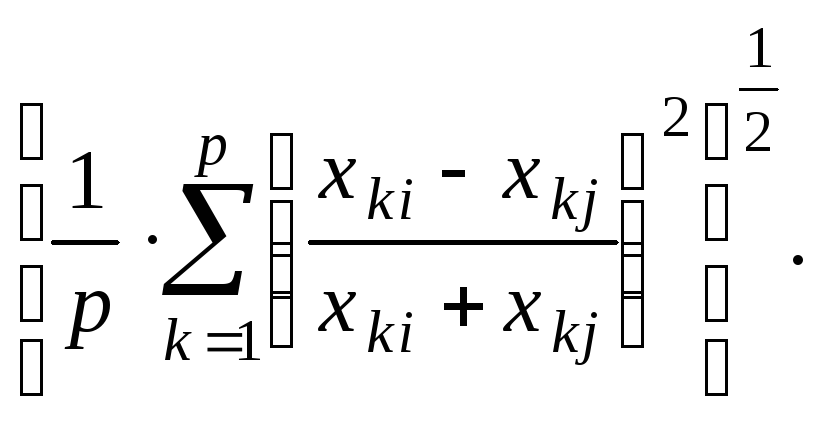

Коэффициент

дивергенции Кларка: СD = (11.6)

(11.6)

Существуют и другие, более сложные меры расстояния, выбор которых определяется как субъективным предпочтением исследователя, так и естественным стремлением к упрощению процедуры эксперимента.

11.2.2. Меры сходства

Как правило, в качестве меры сходства используется корреляция между рядами признаков (переменных). Объекты (признаки) считаются сходными, если коэффициент корреляции близок к +1 (положительное сходство) или к –1 (отрицательное сходство), и не сходны, если rij близок к нулю. В качестве граничного значения для объединения переменных в один кластер используется критическое значение коэффициента корреляции, которое находится по соответствующим таблицам.

При построении векторных моделей необходимо подчеркнуть следующее: если Xi и Xj рассматривать как координаты двух точек в многомерном пространстве, то rij = cos q, где q - угол между двумя векторами.

11.2.3. Выбор числа кластеров

Кластеризация полным перебором

Является наиболее прямым способом решения проблемы и заключается в полном переборе всех возможных разбиений на кластеры и отыскании такого разбиения, которое ведет к оптимальному (минимальному) значению целевой функции. Такая процедура выполнима лишь в тех случаях, когда n (число объектов) и m (число кластеров) невелико, поскольку число разбиений (W) прогрессивно возрастает с увеличением n и m (напомним, что n ³ m). Число возможных разбиений при ограниченном числе объектов и кластеров приведено в табл. 11.1.

Таблица 11.1

|

|

n = 4 |

n = 5 |

n = 6 |

n = 7 |

n = 8 |

|

m =1 |

1 |

1 |

1 |

1 |

1 |

|

m =2 |

7 |

15 |

31 |

63 |

127 |

|

m =3 |

6 |

25 |

90 |

301 |

966 |

|

m =4 |

1 |

10 |

65 |

350 |

1701 |

Динамическое программирование

Суть методов динамического программирования состоит в целенаправленном поиске разбиения, дающего минимальное значение величины W. При этом все разбиения, которые приводят к большему значению W, отбрасываются.

Пример:

При n = 6 и m = 3, W = 90. При этом 90 альтернатив кластеризации дают 3 формы распределения:

1: {4}, {1}, {1} – 15 возможных вариантов;

2: {3}, {2}, {1} – 60 " "

3: {2}, {2}, {2} – 15 " "

Оптимальное распределение соответствует форме 3, которая и служит основой для дальнейшего перебора вариантов:

(1, 2) (3, 4) (5, 6)

(1, 3) (2, 4) (5, 6)

(1, 4) (2, 3) (5, 6) и т. д.

В процедуре динамического программирования имеются повторения сочетаний признаков в одном и том же кластере (в нашем примере (5, 6)), что в значительной мере сокращает число вычислений.

Естественно, что такой подход несколько произволен, так как минимизация числа разбиений, по сути, не означает, что именно эти распределения являются оптимальными.