- •Теория электрической связи

- •Оглавление

- •Сообщения, сигналы и помехи

- •1. Общие сведения о системах электрической связи

- •1.1. Информация, сообщения, сигналы и помехи

- •1.2. Общие принципы построения систем связи

- •1.3. Классификация систем связи

- •2. Математическая модель сигналов

- •2.1. Математическое описание сигнала

- •2.2. Математическое представление сигналов

- •2.3. Геометрическое представление сигналов

- •2.4. Представление сигналов в виде рядов ортогональных функций

- •3. Спектральные характеристики сигналов

- •3.1. Спектральное представление периодических сигналов

- •3.2. Спектральное представление непериодических сигналов

- •3.3. Основные свойства преобразования Фурье:

- •10. Спектры мощности.

- •4. Сигналы с ограниченным спектром. Теорема Котельникова

- •4.1. Разложение непрерывных сигналов в ряд Котельникова

- •Спектр периодической последовательности дельта-импульсов в соответствии с формулой для u(t) имеет следующий вид:

- •4.2. Спектр дискретизированного сигнала

- •4.3. Спектр сигнала дискретизированного импульсами конечной длительности (амплитудно-импульсно модулированный (аим) сигнал)

- •4.4. Восстановление непрерывного сигнала из отсчётов

- •4.5. Погрешности дискретизации и восстановления непрерывных сигналов

- •5. Случайные процессы

- •5.1. Характеристики случайных процессов

- •Функция распределения вероятностей сп (фрв).

- •Двумерная фрв.

- •Функция плотности вероятностей случайного процесса (фпв)

- •5.2. Нормальный случайный процесс (гауссов процесс)

- •5.3. Фпв и фрв для гармонического колебания со случайной начальной фазой

- •5.4. Фпв для суммы нормального случайного процесса и гармонического колебания со случайной начальной фазой

- •5.5. Огибающая и фаза узкополосного случайного процесса

- •5.6. Флуктуационный шум

- •6. Комплексное представление сигналов и помех

- •6.1. Понятие аналитического сигнала

- •6.2. Огибающая, мгновенная фаза и мгновенная частота узкополосного случайного процесса

- •7. Корреляционная функция детерминированных сигналов

- •7.1. Автокорреляция вещественного сигнала

- •Свойства автокорреляционной функции вещественного сигнала:

- •7.2. Автокорреляция дискретного сигнала

- •7.3. Связь корреляционной функции с энергетическим спектром

- •7.4. Практическое применение корреляционной функции

- •Методы формирования и преобразования сигналов

- •8. Модуляция сигналов

- •8.1. Общие положения

- •8.2. Амплитудная модуляция гармонического колебания

- •8.3. Балансная и однополосная модуляция гармонической несущей

- •9. Методы угловой модуляции

- •9.1. Принципы частотной и фазовой (угловой) модуляции

- •9.2. Спектр сигналов угловой модуляции

- •9.3. Формирование и детектирование сигналов амплитудной и однополосной амплитудной модуляции

- •9.4. Формирование и детектирование сигналов угловой модуляции

- •10. Манипуляция сигналов

- •10.1. Временные и спектральные характеристики амплитудно-манипулированных сигналов

- •10.2. Временные и спектральные характеристики частотно-манипулированных сигналов

- •10.3. Фазовая (относительно-фазовая) манипуляция сигналов

- •Алгоритмы цифровой обработки сигналов

- •11. Основы цифровой обработки сигналов

- •11.1. Общие понятия о цифровой обработке

- •11.2. Квантование сигнала

- •11.3. Кодирование сигнала

- •11.4. Декодирование сигнала

- •12. Обработка дискретных сигналов

- •12.1. Алгоритмы дискретного и быстрого преобразований Фурье

- •12.2. Стационарные линейные дискретные цепи

- •12.3. Цепи с конечной импульсной характеристикой (ких-цепи)

- •12.4. Рекурсивные цепи

- •12.5. Устойчивость лис-цепей

- •13. Цифровые фильтры

- •13.1. Методы синтеза ких-фильтров

- •13.2. Синтез бих-фильтров на основе аналого-цифровой трансформации

- •Каналы связи

- •14. Каналы электрической связи

- •14.1. Основные определения

- •14.2. Модели непрерывных каналов

- •14.3. Модели дискретных каналов

- •Теория передачи и кодирования сообщений

- •15. Теория передачи информации

- •15.1. Количество информации переданной по дискретному каналу

- •15.2. Пропускная способность дискретного канала

- •15.3. Пропускная способность симметричного дискретного канала без памяти

- •15.4. Методы сжатия дискретных сообщений

- •Построение кода Шеннона-Фано

- •Построение кода Хаффмена

- •15.5. Количество информации, переданной по непрерывному каналу

- •15.6. Пропускная способность непрерывного канала

- •Характеристики типовых каналов многоканальной связи

- •16. Теория кодирования сообщений

- •16.1. Основные понятия

- •16.2. Коды с обнаружением ошибок

- •16.3. Корректирующие коды

- •Соответствие синдромов конфигурациям ошибок

- •Зависимость между n, m и k

- •Неприводимые полиномы p(X)

- •Помехоустойчивость

- •17. Помехоустойчивость систем передачи дискретных сообщений

- •17.1. Основные понятия и термины

- •17.2. Бинарная задача проверки простых гипотез

- •17.3. Приём полностью известного сигнала (когерентный приём)

- •17.4. Согласованная фильтрация

- •17.5. Потенциальная помехоустойчивость когерентного приёма

- •17.6. Некогерентный приём

- •17.7. Потенциальная помехоустойчивость некогерентного приёма

- •18. Помехоустойчивость систем передачи непрерывных сообщений

- •18.1. Оптимальное оценивание сигнала

- •18.2. Оптимальная фильтрация случайного сигнала

- •18.3. Потенциальная помехоустойчивость передачи непрерывных сообщений

- •19. Адаптивные устройства подавления помех

- •19.1. Основы адаптивного подавления помех

- •19.2. Подавление стационарных помех

- •19.3. Адаптивный режекторный фильтр

- •19.4. Адаптивный высокочастотный фильтр

- •19.5. Подавление периодической помехи с помощью адаптивного устройства предсказания

- •19.6. Адаптивный следящий фильтр

- •19.7. Адаптивный накопитель

- •Многоканальная связь и распределение информации

- •20. Принципы многоканальной связи и распределения информации

- •20.1. Общие положения

- •20.2. Частотное разделение каналов

- •20.3. Временное разделение каналов

- •20.3. Кодовое разделение каналов

- •20.4. Синхронизация в спи с многостанционным доступом

- •20.5. Коммутация в сетях связи

- •Эффективность систем связи

- •21. Оценка эффективности и оптимизация параметров телекоммуникационных систем (ткс)

- •21.1. Критерии эффективности

- •21.2. Эффективность аналоговых и цифровых систем

- •Формулы для приближенных расчетов частотной эффективности некоторых ансамблей сигналов

- •Значения выигрыша и информационной эффективности некоторых систем передачи непрерывных сообщений

- •21.3. Выбор сигналов и помехоустойчивых кодов

- •22. Оценка эффективности радиотехнической системы связи

- •22. 1. Тактико-технические параметры радиотехнической системы связи

- •22.2. Оценка отношения сигнал/помеха на входе радиоприемники радиотехнической системы связи

- •22.3. Оптимальная фильтрация непрерывных сигналов

- •22.4. Количество информации при приёме дискретных сигналов радиотехнической системы связи

- •Вероятность ошибок для различных видов сигналов и приёма

- •Количество информации для различных видов сигналов и приёма

- •22.5. Количество информации при оптимальном приёме непрерывных сигналов

- •22.6. Выигрыш в отношении сигнал/помеха

- •Расчетные формулы выигрыша оптимального демодулятора при различных видах модуляции

- •22.7. Пропускная способность каналов радиотехнической системы связи

- •Теоретико-информационная концепция криптозащиты сообщений в телекоммуникационных системах

- •23. Основы криптозащиты сообщений в системах связи

- •23.1. Основные понятия криптографии

- •23.2. Метод замены

- •23.3. Методы шифрования на основе датчика псевдослучайных чисел

- •23.4. Методы перемешивания

- •23.5. Криптосистемы с открытым ключом

- •13.6. Цифровая подпись

- •Заключение

- •Список сокращений

- •Основные обозначения

- •Литература

- •Теория электрической связи

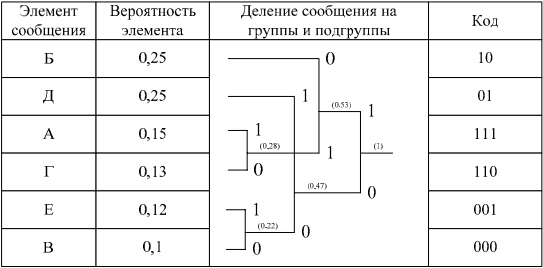

Построение кода Шеннона-Фано

При использовании простейшего равномерного кода для кодирования шести элементов алфавита источника потребуется по три двоичных символа на каждую букву сообщения. Если же используется код Шеннона-Фано, то среднее число символов на одну букву

![]() ,

,

что меньше, чем при простейшем равномерном коде и незначительно отличается от энтропии источника.

Кодирование источника дискретных сообщений методом Хаффмена. Рассмотрим еще один подход к кодированию, предложенный Хаффменом, на примере источника сообщений, заданного в таблице 15.2.

Таблица 15.2

Построение кода Хаффмена

Алгоритм построения сжимающего кода Хаффмена включает в себя следующие действия.

1. Все m символов дискретного источника располагаются в таблице в порядке убывания вероятностей.

2. Два символа, имеющих наименьшие вероятности, объединяются в один блок, а их вероятности суммируются.

3. Ветви скобки, идущей к большей вероятности, присваивается символ «1», а идущей к меньшей – символ «0».

4. Операции 2 и 3 повторяются до тех пор, пока не сформируется один блок с вероятностью единица.

5. Записывается код для каждого символа источника; при этом считывание кода осуществляется справа налево.

Среднее число символов на одну букву для полученного кода

![]() .

.

Таким образом, для данного примера кодирование методами Хаффмена и Шеннона-Фано одинаково эффективно. Однако опыт кодирования показывает, что код Хаффмена часто оказывается экономичнее кода Шеннона-Фано.

Длина кодовой комбинации таких кодов зависит от вероятности выбора соответствующей буквы алфавита: наиболее вероятным буквам сопоставляются короткие кодовые комбинации, а менее вероятным – более длинные.

15.5. Количество информации, переданной по непрерывному каналу

Вместо последовательностей символов для дискретного канала, в непрерывном канале осуществляется передача последовательности непрерывных величин с дискретным или непрерывным временем (в первом случае эти последовательности можно представить в виде импульсов различной величины, появляющихся в определенные моменты времени, а во втором случае как непрерывные функции времени).

Количество передаваемой информации:

![]() ,

(15.6)

,

(15.6)

где w(y) – плотность распределения вероятности выходных случайных величин;

w(n) – плотность распределения вероятности помехи (аддитивной);

h(Y) – дифференциальная энтропия сигнала y;

h(Y/X) – условная дифференциальная энтропия сигнала y при известном сигнале x;

Отметим следующие свойства количества информации, передаваемой в непрерывном канале:

I(Y,X) ≥ 0, причём I(Y,X) = 0 тогда, и только тогда, когда вход и выход канала статистически независимы, т.е. w(y / х) = w(y);

I(Y,X) = I(X,Y) – свойство симметрии;

I(Y,X) = ∞, если помехи в канале отсутствуют, т.е. y = x, n = 0

Дифференциальная энтропия h(Y) уже не представляет собой среднее количество информации, выдаваемое источником сигнала (для непрерывного сигнала оно бесконечно). Аналогично h(Y/X) не представляет собой количество информации, потерянной в канале, поскольку эта величина тоже бесконечна. Поэтому дифференциальную энтропию следует понимать лишь формально, как некоторую вспомогательную величину полезную при расчетах.

Если помеха аддитивная y = x + n , то нетрудно показать, что

![]() ,

(15.7)

,

(15.7)

где w(n) – плотность распределения вероятности помехи, а h(N) – дифференциальная энтропия помехи.

Выражение для определения количества информации, переданной по непрерывному гауссовскому каналу (нормальный закон распределения вероятностей сигнала и помехи):

.

(15.8)

.

(15.8)

где

(15.9)

(15.9)

Полученное выражение показывает, что пропускная способность гауссовского канала с дискретным временем определяется отношением дисперсии сигнала σс2 к дисперсии помехи σ2. Нередко величину σс2 / σ2 = h2 называют отношением сигнал/шум. Чем больше это отношение, тем выше пропускная способность.